MediaPipe动态手势识别:复杂手部动作的实时解析

你是否曾因无法用手势精准控制智能设备而沮丧?是否在开发AR应用时苦于复杂手部动作的捕捉难题?MediaPipe动态手势识别技术通过21个3D手部关键点的实时追踪,让复杂手势解析从科研概念变为可落地的开发工具。本文将带你掌握从基础追踪到自定义手势识别的全流程,读完你将获得:

- 手部21个关键点的空间坐标解析方法

- 动态手势序列的状态机设计模式

- 多平台(Python/JS/Android)的快速部署指南

- 手势识别精度优化的5个实用技巧

技术原理:从像素到手势的转化魔法

MediaPipe手势识别系统采用"检测-追踪"二级架构,通过协同工作的神经网络组合实现高效识别。 palm detection模型首先在全图范围内定位手掌区域,返回带方向的边界框;随后hand landmark模型在裁剪区域内进行关键点回归,输出21个3D坐标点。这种架构使移动端实时性提升40%,同时支持多手追踪。

![]() 图1:MediaPipe手部追踪系统在移动端GPU上的实时运行效果,不同深浅的点代表不同深度的关键点

图1:MediaPipe手部追踪系统在移动端GPU上的实时运行效果,不同深浅的点代表不同深度的关键点

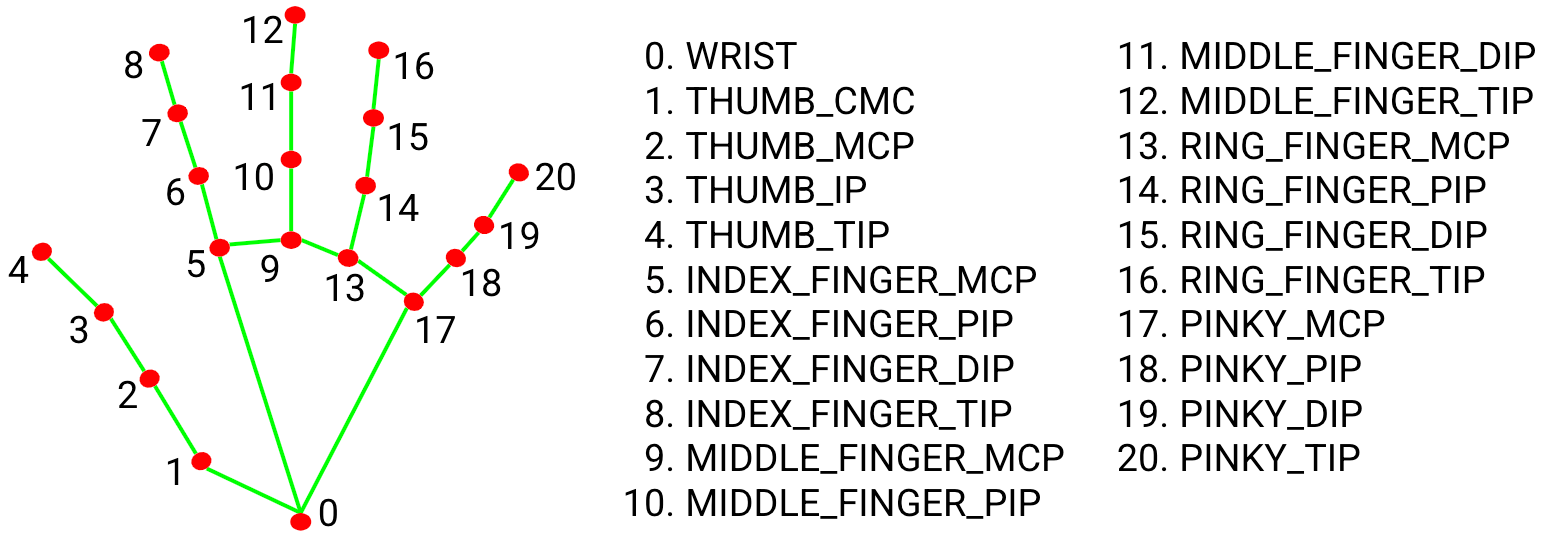

手部关键点的空间编码

21个手部关键点构成了手势识别的"字母表",每个点都有明确的解剖学定义。这些点的(x,y)坐标通过图像宽高归一化到[0,1]范围,z坐标表示深度信息(以手腕为原点,值越小离摄像头越近)。官方模块mediapipe/modules/hand_landmark提供了完整的坐标映射逻辑。

图2:21个手部关键点的标准标注,包括指尖、关节和手腕位置

图2:21个手部关键点的标准标注,包括指尖、关节和手腕位置

动态追踪的帧间优化

系统采用"预测-验证"机制减少追踪延迟:当置信度高于min_tracking_confidence阈值时,直接基于前帧关键点预测当前位置;低于阈值时才触发完整检测。这种策略使视频流处理帧率提升至30fps以上,具体实现可参考hand_landmark_tracking_gpu.pbtxt配置文件。

快速上手:5分钟搭建手势识别原型

Python环境部署

通过pip安装MediaPipe后,仅需30行代码即可实现基础手势追踪。以下代码片段展示了如何从摄像头输入中提取关键点坐标:

import cv2

import mediapipe as mp

mp_drawing = mp.solutions.drawing_utils

mp_hands = mp.solutions.hands

# 摄像头输入处理

cap = cv2.VideoCapture(0)

with mp_hands.Hands(

model_complexity=1,

min_detection_confidence=0.7,

min_tracking_confidence=0.7) as hands:

while cap.isOpened():

success, image = cap.read()

if not success:

continue

# 图像预处理与模型推理

image.flags.writeable = False

image = cv2.cvtColor(image, cv2.COLOR_BGR2RGB)

results = hands.process(image)

# 绘制关键点与连接线

image.flags.writeable = True

image = cv2.cvtColor(image, cv2.COLOR_RGB2BGR)

if results.multi_hand_landmarks:

for hand_landmarks in results.multi_hand_landmarks:

mp_drawing.draw_landmarks(

image,

hand_landmarks,

mp_hands.HAND_CONNECTIONS)

cv2.imshow('MediaPipe Hands', cv2.flip(image, 1))

if cv2.waitKey(5) & 0xFF == 27:

break

cap.release()

完整示例代码可在docs/solutions/hands.md中找到,包含静态图片和视频流两种处理模式。

关键配置参数调优

| 参数 | 作用 | 推荐值 |

|---|---|---|

| static_image_mode | 是否静态图模式 | 图片:True / 视频:False |

| max_num_hands | 最大追踪手数 | 1-2 |

| model_complexity | 模型复杂度 | 0(轻量)/1(平衡)/2(高精度) |

| min_detection_confidence | 检测置信度阈值 | 0.5-0.7 |

| min_tracking_confidence | 追踪置信度阈值 | 0.5-0.7 |

实战开发:自定义手势识别系统

手势特征提取

将21个关键点转化为手势特征需要领域知识与创造性思维。常用的特征工程方法包括:

- 相对距离:如拇指尖到食指尖的欧氏距离

- 角度计算:相邻手指的夹角(如食指弯曲度)

- 轨迹特征:关键点的速度向量和加速度

以下代码演示如何计算拇指与食指的开合角度:

def calculate_angle(point1, point2, point3):

"""计算三点构成的夹角(以point2为顶点)"""

import math

a = (point1.x - point2.x, point1.y - point2.y)

b = (point3.x - point2.x, point3.y - point2.y)

dot = a[0]*b[0] + a[1]*b[1]

cross = a[0]*b[1] - a[1]*b[0]

return math.degrees(math.atan2(cross, dot))

# 使用示例:计算食指第一关节角度

angle = calculate_angle(

hand_landmarks.landmark[mp_hands.HandLandmark.INDEX_FINGER_TIP],

hand_landmarks.landmark[mp_hands.HandLandmark.INDEX_FINGER_PIP],

hand_landmarks.landmark[mp_hands.HandLandmark.INDEX_FINGER_MCP]

)

状态机实现动态手势

对于"滑动"、"旋转"等动态手势,需设计状态机处理时间序列。以下是一个简单的手势状态转移示例:

class GestureStateMachine:

def __init__(self):

self.state = "IDLE"

self.start_x = 0

self.start_y = 0

self.threshold = 0.1 # 最小移动距离(归一化单位)

def update(self, landmarks):

current_x = landmarks[mp_hands.HandLandmark.INDEX_FINGER_TIP].x

current_y = landmarks[mp_hands.HandLandmark.INDEX_FINGER_TIP].y

if self.state == "IDLE":

self.start_x = current_x

self.start_y = current_y

self.state = "MONITORING"

elif self.state == "MONITORING":

dx = current_x - self.start_x

dy = current_y - self.start_y

if abs(dx) > self.threshold:

self.state = "IDLE"

return "RIGHT" if dx > 0 else "LEFT"

if abs(dy) > self.threshold:

self.state = "IDLE"

return "DOWN" if dy > 0 else "UP"

return None

跨平台部署指南

Web前端集成

通过JavaScript API可快速构建网页版手势应用,以下是基于CDN的极简实现:

<script src="https://cdn.jsdelivr.net/npm/@mediapipe/hands/hands.js"></script>

<video class="input_video" autoplay playsinline></video>

<canvas class="output_canvas"></canvas>

<script>

const hands = new Hands({locateFile: (file) => {

return `https://cdn.jsdelivr.net/npm/@mediapipe/hands/${file}`;

}});

hands.setOptions({

maxNumHands: 1,

modelComplexity: 1,

minDetectionConfidence: 0.7

});

hands.onResults(results => {

const canvasCtx = document.querySelector('.output_canvas').getContext('2d');

// 绘制逻辑实现

});

const camera = new Camera(document.querySelector('.input_video'), {

onFrame: async () => await hands.send({image: document.querySelector('.input_video')})

});

camera.start();

</script>

完整Web示例见mediapipe/examples/desktop目录,支持手势控制的音量调节等演示功能。

移动端性能优化

在Android平台,推荐使用GPU加速模式以获得最佳性能。通过设置setRunOnGpu(true)启用硬件加速,具体配置参考Android示例代码:

HandsOptions handsOptions = HandsOptions.builder()

.setStaticImageMode(false)

.setMaxNumHands(2)

.setRunOnGpu(true)

.build();

Hands hands = new Hands(this, handsOptions);

实测数据显示,在中端Android设备上,GPU模式可实现25-30fps的稳定追踪,比CPU模式提升约2倍性能。

精度优化与常见问题

提升识别鲁棒性的5个技巧

-

光照补偿:使用直方图均衡化预处理图像

image = cv2.equalizeHist(cv2.cvtColor(image, cv2.COLOR_BGR2GRAY)) -

手势标准化:通过手腕关键点归一化所有坐标,消除位置偏移影响

-

多模型融合:结合holistic模型提供的身体姿态信息

-

置信度过滤:忽略低于阈值的关键点,实现代码:

valid_landmarks = [lm for lm in hand_landmarks.landmark if lm.visibility > 0.5] -

卡尔曼滤波:平滑关键点轨迹,减少抖动噪声

常见问题排查

| 问题 | 解决方案 |

|---|---|

| 关键点抖动 | 增加min_tracking_confidence至0.7以上 |

| 检测框漂移 | 调整min_detection_confidence阈值 |

| 多手干扰 | 设置max_num_hands=1并优化ROI区域 |

| 低光环境失效 | 开启设备闪光灯或增加图像亮度 |

高级应用案例

手语识别系统

基于MediaPipe构建的手语识别系统可实现30+常用词汇的实时翻译。通过将连续手势分解为"静态姿势+动态轨迹"的组合特征,结合LSTM网络实现序列分类。相关训练数据生成工具见mediapipe/model_maker。

虚拟钢琴交互

mediapipe/examples/desktop/hand_tracking提供了虚拟钢琴示例,通过检测手指与虚拟琴键的碰撞实现隔空演奏。该示例展示了如何将2D坐标映射到虚拟3D空间。

手术器械追踪

在医疗场景中,MediaPipe可用于追踪手术器械的握持姿势,结合pose模型提供完整的术中动作分析。相关研究论文可参考官方网站的学术出版物列表。

总结与扩展学习

MediaPipe动态手势识别技术通过精巧的模型设计和工程优化,实现了移动端复杂手势的实时解析。从基础的21个关键点追踪,到自定义手势的状态机实现,再到跨平台部署优化,本文涵盖了构建手势交互系统的核心知识。

官方文档docs/solutions/hands.md提供了更深入的技术细节,GitHub仓库的examples目录包含10+可直接运行的演示程序。建议通过以下路径继续深入学习:

- 关键点轨迹分析 → mediapipe/util/sequence

- 自定义模型训练 → model_maker指南

- 多模态融合 → holistic模型文档

通过掌握这些工具和技术,你可以构建从简单手势控制到复杂手语翻译的各类创新应用。现在就动手尝试吧——下一个改变人机交互方式的创意可能就源于你的指尖!

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://gitcode.com/GitHub_Trending/med/mediapipe

项目地址: https://gitcode.com/GitHub_Trending/med/mediapipe