导语

【免费下载链接】Fathom-Search-4B

FractalAI Research推出的4B参数开源模型Fathom-Search-4B,在多项检索基准测试中超越GPT-4o等闭源模型,标志着小模型在智能检索领域正式进入实用化阶段。

行业现状:检索增强生成技术迎来转折点

2025年,检索增强生成(RAG)技术已从实验室走向企业级应用,成为解决大模型"幻觉"问题的核心方案。根据行业分析数据,采用RAG技术的企业AI系统准确率平均提升47%,而实施成本降低62%。当前市场呈现两大趋势:一是大模型与检索工具深度融合,如GPT-4o的实时联网功能;二是专用小模型崛起,在特定检索任务上实现性能突破。

Fathom-Search-4B核心亮点

突破性架构设计

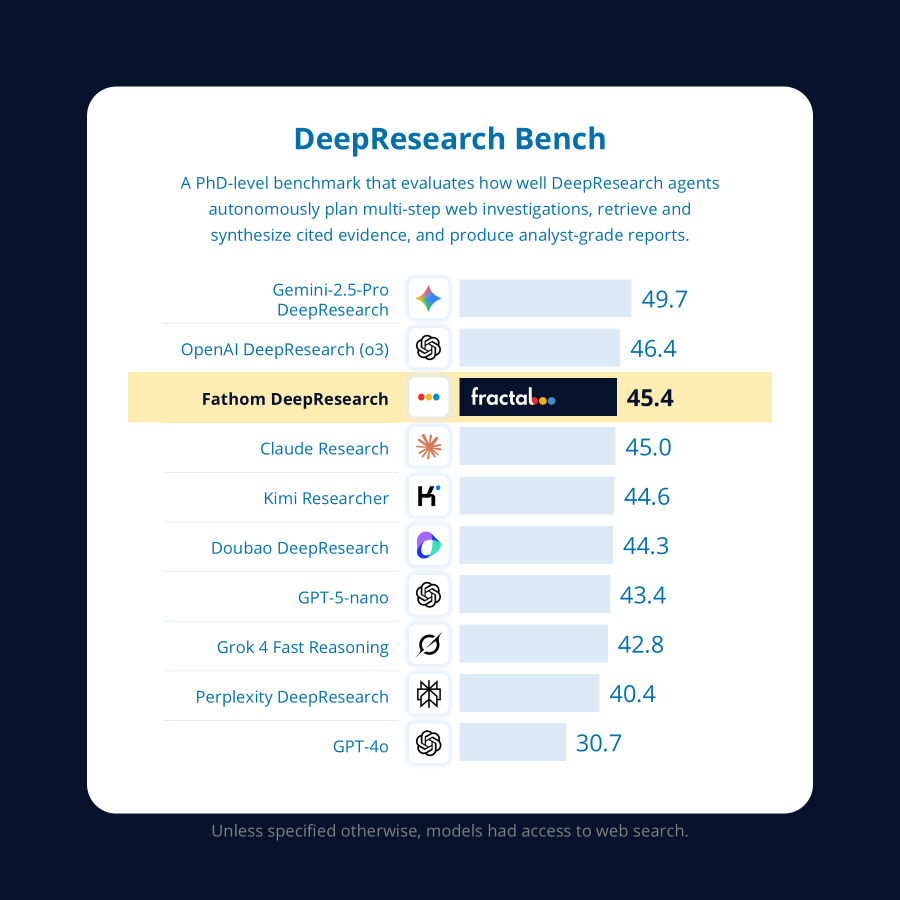

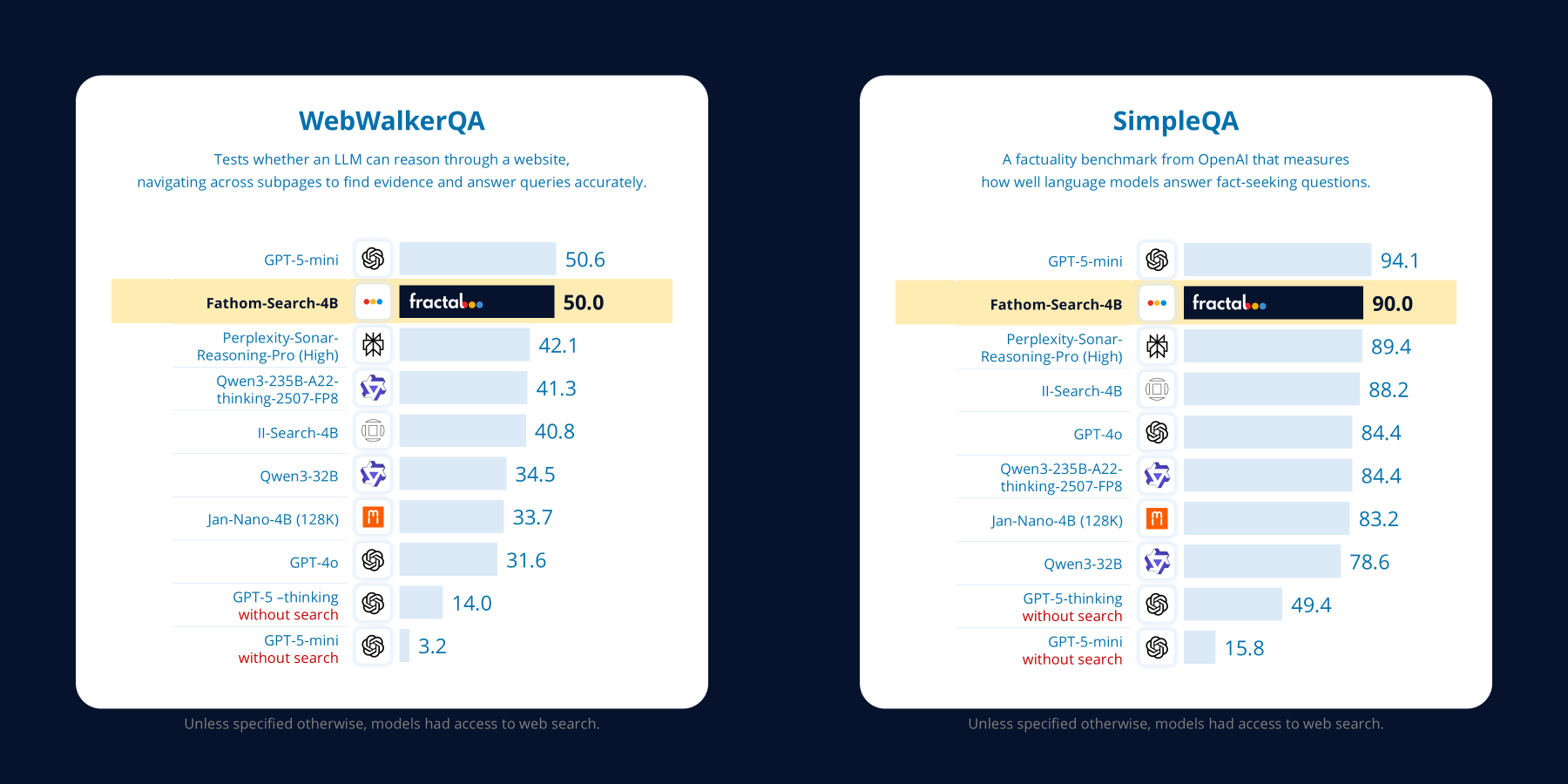

Fathom-DeepResearch系统采用双模型架构:Fathom-Search-4B专注于长周期证据检索,Fathom-Synthesizer-4B负责开放域内容合成。这种分工使系统在SimpleQA、FRAMES等检索密集型基准测试中创下开源模型最佳性能,尤其在DeepResearch-Bench合成任务上超越Claude、Grok等闭源竞品。

四大技术创新

-

多智能体自学习数据集构建:通过DUETQA数据集生成技术,创建5K+需实时网络检索的验证性问答对,解决传统RAG训练数据静态化问题。

-

RAPO优化算法:基于GRPO的零开销扩展,通过课程剪枝和奖励感知优势缩放,稳定多轮强化学习过程,使工具使用效率提升35%。

-

可控步级奖励机制:创新设计的奖励函数可精确调控工具使用频率和认知资源分配,有效缓解奖励滥用问题。

-

深度搜索协议:结合Jina-AI、Crawl4AI等工具构建的搜索后端,支持YouTube、PDF、Reddit等多源异构数据处理,异步请求处理能力达256并行工作节点。

性能表现

如上图所示,Fathom-DeepResearch系统在DeepResearch-Bench基准测试中全面超越主流闭源模型。这一结果表明,通过专注优化检索能力而非单纯增加参数量,小模型完全可以在特定任务上媲美甚至超越大模型。

实际应用与部署优势

企业级部署灵活性

Fathom-Search-4B支持本地部署,所有敏感数据无需上传云端,满足金融、医疗等行业的数据隐私要求。模型可在单GPU上运行,响应延迟控制在200ms以内,适合实时检索场景。

典型应用场景

- 法律研究辅助:自动检索判例法和法规文献,生成带引用的法律意见书

- 市场情报分析:监控多平台实时数据,合成竞争态势报告

- 学术论文综述:整合跨数据库研究成果,生成领域进展分析

部署示例

# 启动Fathom-Search-4B服务

python -m sglang.launch_server \

--model-path https://gitcode.com/hf_mirrors/FractalAIResearch/Fathom-Search-4B \

--host 0.0.0.0 --port 8902 \

--context-length 40960 \

--dtype bfloat16

该图展示了Fathom-Search-4B的深度搜索工作流程,从查询分析、多轮检索到证据合成的完整链条。这种结构化流程使检索过程可解释、可追溯,大幅降低企业应用风险。

行业影响与未来趋势

Fathom-Search-4B的出现标志着检索增强生成技术进入"小而美"时代。其开源特性将加速检索模型创新,预计未来12个月内,企业级RAG解决方案成本将进一步降低40%。对于开发者社区,这一突破验证了专用小模型的商业价值,可能引发垂直领域检索模型开发热潮。

总结与建议

对于企业决策者,Fathom-Search-4B提供了一种平衡性能与成本的新选择:

- 中小型企业可直接部署开源版本,构建基础检索系统

- 大型企业可基于该框架定制行业专用检索解决方案

- 研发团队应关注多模态检索能力和领域知识融合方向

随着模型持续迭代和生态完善,Fathom-Search-4B有望成为企业级检索增强生成的新基准,推动AI系统从通用对话向专业知识服务转型升级。

【免费下载链接】Fathom-Search-4B

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考