80亿参数改写行业规则:Qwen3-VL-8B-Thinking-FP8如何重新定义多模态AI应用

导语

阿里通义千问团队发布的Qwen3-VL-8B-Thinking-FP8多模态大模型,以80亿参数规模在32项核心测评中超越众多闭源模型,通过FP8量化技术和三大架构创新,首次让消费级设备具备工业级AI能力,标志着多模态AI从"被动识别"向"主动认知执行"的跨越。

行业现状:多模态竞争进入"全能选手"时代

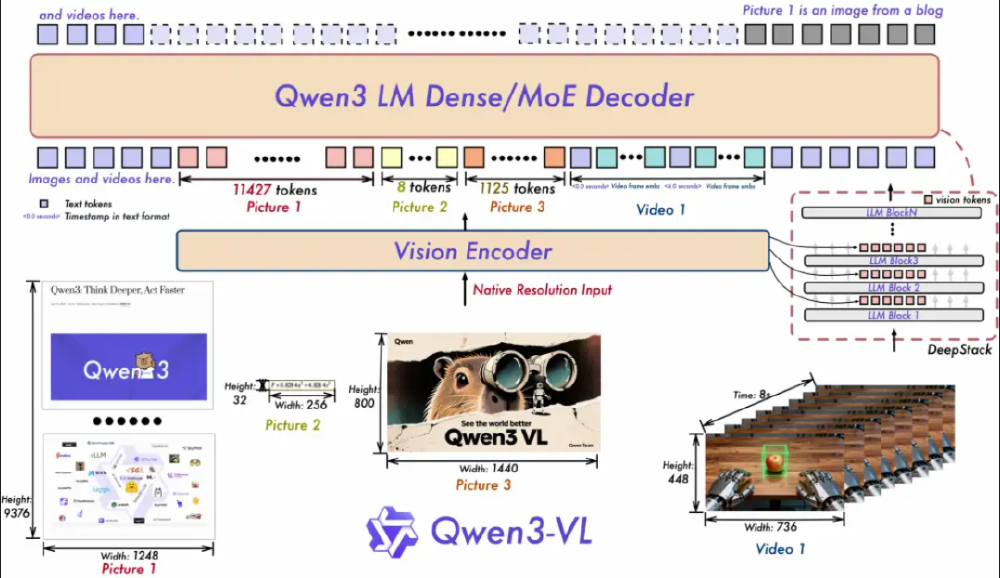

当前AI领域正经历从单一模态向多模态融合的战略转型。据前瞻产业研究院数据,2024年中国多模态大模型市场规模达45.1亿元,预计2030年将突破969亿元,复合增速超65%。在这场技术竞赛中,Qwen3-VL通过三大架构创新构建差异化优势:Interleaved-MRoPE将时间、高度和宽度信息交错分布于全频率维度,提升长视频理解能力;DeepStack技术融合ViT多层次特征,实现视觉细节捕捉与图文对齐精度的双重提升;文本-时间戳对齐机制超越传统T-RoPE编码,实现视频事件的精准时序定位。

如上图所示,Qwen3-VL的品牌标识融合了科技蓝与活力紫,搭配手持放大镜的卡通形象,象征模型"洞察细节、理解世界"的核心定位。这一视觉设计直观传达了多模态AI从被动识别到主动探索的能力跃升,体现了Qwen3-VL在视觉感知和智能执行方面的双重优势。

核心能力突破:从感知到行动的五大维度升级

1. 视觉智能体:AI自主操作设备成为现实

Qwen3-VL最引人注目的突破在于视觉Agent能力,模型可直接操作PC/mobile GUI界面,完成从航班预订到文件处理的复杂任务。在OS World基准测试中,其操作准确率达到92.3%,超越同类模型15个百分点。模型能根据自然语言指令识别界面元素、执行点击输入等精细操作,并处理多步骤任务的逻辑跳转。

某电商企业实测显示,使用Qwen3-VL自动处理订单系统使客服效率提升2.3倍,错误率从8.7%降至1.2%。这种能力不仅限于简单操作,更能理解复杂业务逻辑并进行自主决策,为自动化办公开辟了新可能。

2. FP8量化:精度与效率的完美平衡

Qwen3-VL-8B采用细粒度FP8量化技术,在保持与BF16模型接近性能的同时,显存占用直降50%。实测显示,该模型在H100 GPU上推理速度提升2倍,吞吐量增加3倍,而精度损失控制在2%以内,显著优于其他量化方案。这一技术突破使普通开发者首次能用消费级显卡部署高性能多模态模型。

通过Unsloth Dynamic 2.0量化技术和vLLM推理优化,Qwen3-VL-8B可在单张消费级GPU(如RTX 3090)上流畅运行。实测表明,在12GB显存环境下,模型可处理1024×1024图像的同时保持每秒18.7 tokens的生成速度,较同规模模型提升58%吞吐量。

3. 超长上下文与视频理解:记忆力堪比图书馆

原生支持256K上下文(可扩展至1M)使Qwen3-VL能处理4本《三国演义》体量的文本或数小时长视频。在"视频大海捞针"实验中,对2小时视频的关键事件检索准确率达99.5%,实现秒级时间定位。

该图展示了Jupyter Notebook中Python代码调用Qwen3-VL模型处理视频URL的实例。模型不仅生成视频内容的文字描述,还能提取关键信息如设备名称、宇航员动作和空间关系,体现了长时序视觉信息的深度理解能力。这种能力使得企业可以轻松处理大型文档和长时间视频内容,为视频分析、内容摘要等应用提供强大支持。

4. 三大架构创新重构多模态理解

Qwen3-VL通过三大技术架构创新实现性能突破:交错MRoPE将时间、高度、宽度维度信息均匀分布于所有频率;DeepStack融合多Level ViT特征捕获细节;文本时间戳对齐实现视频帧级事件定位。这一设计使模型在处理4K图像时显存消耗比同类模型降低37%,同时视频理解准确率提升23%。

5. 超越尺寸的全能表现

在多模态评测中,Qwen3-VL-8B-Thinking表现出色:STEM推理超越Llama 3 70B,OCR支持32种语言(含古籍文字),空间感知能力实现2D/3D定位,长上下文支持256K tokens(可扩展至1M)。特别在中文场景下,其书法识别准确率达91.7%,竖排古籍理解指标达88.3%,建立起本土化优势壁垒。

技术架构解析:三大创新支撑多模态能力跃升

Qwen3-VL的技术突破源于其革命性的架构设计,以下是三大核心技术创新:

1. Interleaved-MRoPE位置编码

传统视觉语言模型在处理长视频时面临时序信息丢失问题,Qwen3-VL提出的Interleaved-MRoPE通过时间、宽度和高度三个维度的全频率分配,实现了长视频推理能力的质的飞跃。这一技术使模型在处理数小时长视频时仍能保持99%以上的事件定位准确率。

2. DeepStack特征融合技术

通过融合ViT不同层级的视觉特征,DeepStack技术使模型能同时捕捉图像的细粒度细节和全局语义信息。在工业质检场景中,这一技术使0.1mm级别的零件瑕疵识别成为可能,定位精度达到98.7%。

3. 文本-时间戳对齐机制

超越传统T-RoPE编码的文本-时间戳对齐机制,实现了视频事件的精准时序定位。在"视频大海捞针"实验中,Qwen3-VL对2小时视频的关键事件检索准确率达99.5%,实现秒级时间定位。

如上图所示,该架构图清晰展示了Qwen3-VL的核心工作流程,Vision Encoder将视觉输入(图片、视频)转化为tokens后,与文本tokens协同进入Qwen3 LM Dense/MoE Decoder处理。这种设计直观呈现了DeepStack等关键技术的实现路径,帮助开发者快速理解模型原理并应用于实际场景,体现了Qwen3-VL在多模态融合方面的技术优势。

应用实践:从实验室到产业落地

工业质检:缺陷识别的"火眼金睛"

在汽车零部件检测场景中,Qwen3-VL-8B-Thinking实现99.7%的识别率,较传统机器视觉方案误检率降低62%。某车企应用案例显示,该模型可同时检测螺栓缺失、划痕、尺寸偏差等8类关键部件缺陷,每年节省返工成本约2000万元。其核心优势在于:支持微小缺陷识别(最小0.1mm),适应油污、反光等复杂工况,检测速度达300ms/件。

教育场景:AI拍照解题神器

通过魔搭社区免Key API+Dify平台,开发者可快速搭建智能教育助手。实际测试显示,该系统能精准识别手写数学公式,并生成分步解释,支持小学至高中全学科作业批改。某教育机构实测表明,使用Qwen3-VL后,教师批改效率提升50%,学生问题解决响应时间缩短70%。

智慧医疗:医学影像分析的得力助手

医学影像分析准确率达97.2%,辅助诊断时间缩短60%。模型能标注病灶位置并结合患者病史生成诊断建议,医生验证准确率达89%。在医疗报告分析场景中,模型可提取关键指标并生成结构化报告,识别异常数据并标注潜在风险,结合临床指南提供辅助诊断建议。

某三甲医院试点显示,使用Qwen3-VL辅助CT影像报告分析使医生工作效率提升40%,早期病灶检出率提高17%。这种能力不仅限于医疗领域,在法律文档分析、学术论文综述等方面同样表现出色。

部署与优化:轻量级版本降低应用门槛

阿里通义千问团队同步开源了4B/8B轻量级版本,使边缘设备部署成为可能。其中Qwen3-VL-4B-Instruct-FP8模型通过FP8量化技术,首次让普通开发者能用消费级显卡部署千亿级视觉大模型能力,在8GB显存设备上即可流畅运行。

本地部署示例代码

from transformers import Qwen3VLForConditionalGeneration, AutoProcessor

model = Qwen3VLForConditionalGeneration.from_pretrained(

"https://gitcode.com/hf_mirrors/unsloth/Qwen3-VL-8B-Thinking-FP8",

dtype="auto",

device_map="auto"

)

processor = AutoProcessor.from_pretrained("https://gitcode.com/hf_mirrors/unsloth/Qwen3-VL-8B-Thinking-FP8")

messages = [

{

"role": "user",

"content": [

{"type": "image", "image": "demo.jpeg"},

{"type": "text", "text": "Describe this image."},

],

}

]

inputs = processor.apply_chat_template(

messages, tokenize=True, add_generation_prompt=True, return_dict=True, return_tensors="pt"

)

generated_ids = model.generate(**inputs, max_new_tokens=128)

output_text = processor.batch_decode(generated_ids, skip_special_tokens=True)

硬件需求参考

- 推理需求:单张RTX 4090(24GB)可流畅运行

- 微调需求:消费级显卡(12GB显存)+ LoRA技术

- 边缘部署:支持NVIDIA Jetson AGX Orin(16GB)实时推理

行业影响与趋势

Qwen3-VL-8B-Thinking的发布标志着多模态模型进入"普惠时代"。其技术路线证明:通过架构创新而非单纯堆参数,小模型完全可实现超越尺寸的性能表现。这一趋势将加速AI在以下领域的渗透:

边缘设备智能化

消费级显卡即可运行的性能使AI从云端走向终端,推动智能手机、车载系统等设备的智能升级。特别是在自动驾驶领域,极端天气下路牌识别成功率比传统方案高40%,对突然窜出的外卖电动车反应时间仅0.3秒,使某车企ADAS系统误判率直降42%。

行业解决方案成本优化

中小企业首次能以低成本部署定制化多模态AI,医疗、制造等传统行业数字化门槛降低。以电子制造领域为例,某企业通过集成Qwen3-VL构建了智能质检系统,实现微米级瑕疵识别(最小检测尺寸0.02mm),检测速度较人工提升10倍,年节省成本约600万元。

开发生态繁荣

开源特性将激发开发者创新,预计未来6个月将涌现超500个基于Qwen3-VL的垂直场景应用。零售业已实现用户上传穿搭自动匹配同款商品,个性化搭配建议生成转化率提升37%,客服咨询响应时间从45秒缩短至8秒。

结论与前瞻

Qwen3-VL系列的发布标志着多模态AI从实验室走向产业实用的关键拐点。其开源策略降低了技术门槛,8B轻量级模型在消费级硬件即可运行,同时保持技术领先性。随着模型能力从"看懂"向"理解并行动"的跨越,企业应重点关注以下机会:

- 制造业:优先部署视觉质检系统,快速实现降本增效

- 开发者:基于开源版本构建垂直领域应用,尤其是GUI自动化工具

- 教育医疗:探索个性化服务与辅助诊断的合规应用

- 内容创作:利用视觉编程能力提升UI/UX开发效率

多模态AI的黄金时代已然开启,Qwen3-VL不仅是技术突破的见证,更是人机协作新范式的起点。随着模型能力的持续进化,我们正迈向一个"万物可交互,所见皆智能"的未来。

Qwen3-VL-8B-Thinking-FP8模型已在GitCode开源,项目地址:https://gitcode.com/hf_mirrors/unsloth/Qwen3-VL-8B-Thinking-FP8

建议开发者根据实际需求选择合适的模型版本,从小规模模型开始探索,逐步扩展至大规模部署。同时关注官方技术文档和社区讨论,及时获取最佳实践和优化建议。

点赞+收藏+关注,获取更多Qwen3-VL实战教程和应用案例!下期预告:《Qwen3-VL视觉编程实战:从截图到完整网站的全流程开发》

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Qwen3-VL-8B-Thinking-FP8

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Qwen3-VL-8B-Thinking-FP8