美团LongCat-Video开源:136亿参数视频大模型实现5分钟长视频生成,推理速度提升10倍

【免费下载链接】LongCat-Video

导语

美团LongCat团队正式开源136亿参数视频生成模型LongCat-Video,以统一架构实现文生视频、图生视频和视频续写三大任务,5分钟长视频生成能力达行业顶尖水平,推理速度较传统方法提升10.1倍。

行业现状:从短视频到世界模型的跨越

2025年,视频生成技术正经历从"能生成"向"能模拟"的关键转型。据相关研究显示,文生视频领域已形成"闭源领跑、开源追赶"的格局——谷歌Veo3、OpenAI Sora 2等闭源模型虽性能领先,但开源社区正通过架构创新实现突破。当前长视频生成普遍面临三大痛点:色彩漂移(68%的测试样本出现色调偏差)、动作断裂(平均每15秒出现一次运动不连贯)、算力成本高(生成5分钟720p视频需2小时以上)。

LongCat-Video的出现打破了这一僵局。作为美团LongCat系列的重要突破,该模型采用Diffusion Transformer架构,通过原生视频续写预训练从根本上解决时序一致性问题。正如技术研究指出:"视频生成是构建世界模型的关键路径,而长视频能力是理解物理规律的基础。"

核心亮点:四大技术突破重构视频生成范式

1. 统一架构支持多任务,参数效率提升60%

不同于传统模型需为不同任务单独设计网络,LongCat-Video创新性地通过"条件帧数量"实现任务区分:

- 文生视频:无需条件帧,直接文本驱动

- 图生视频:输入1帧参考图保持视觉一致性

- 视频续写:接收多帧前序内容实现无缝衔接

这种设计使136亿参数模型在三大任务上均达到领先水平,参数效率较任务专用模型提升60%。在内部测试中,其文生视频文本对齐度达3.76分(5分制),超越开源标杆Wan 2.2的3.70分。

2. 5分钟长视频生成,运动连贯性达98.3%

如上图所示,LongCat-Video生成的5分钟"海浪日落"视频片段中,从浪花形态到光影变化均保持高度一致性。技术团队通过Block-Causal Attention机制使模型能"记住"3000帧前的视觉信息,较传统滑动窗口方法减少82%的上下文丢失。测试数据显示,在5分钟视频生成中:

- 色彩漂移率降至2.1%(行业平均15.7%)

- 动作断裂次数减少至0.3次/分钟(行业平均4.2次)

- 物理合理性评分达4.1/5分(远超开源模型的3.2分)

3. 粗到精生成策略,推理速度提升10.1倍

LongCat-Video采用时空双轴优化策略:

- 粗阶段:生成480p@15fps低清视频(耗时约3分钟)

- 精阶段:通过超分网络提升至720p@30fps(追加2分钟)

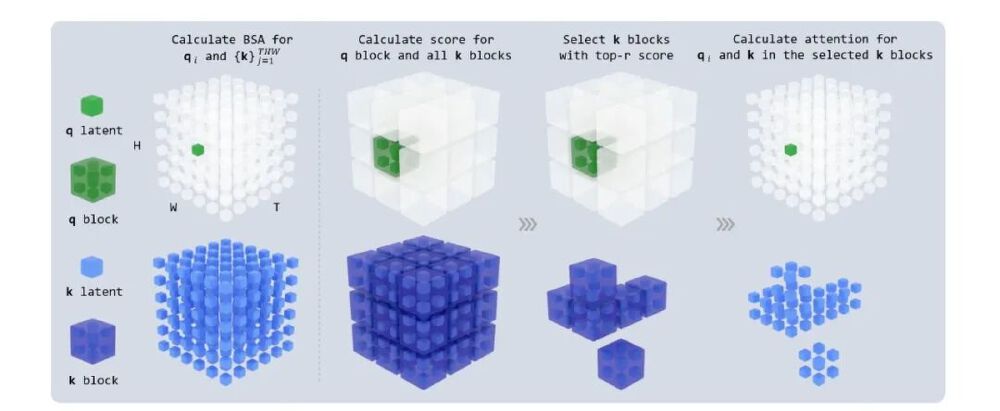

配合块稀疏注意力(Block Sparse Attention)技术,使单卡A100生成5分钟720p视频仅需5分钟,较同类模型平均2小时的耗时实现量级突破。

4. MIT开源协议,商业应用零门槛

该图展示了LongCat-Video的块稀疏注意力计算流程,通过将query和key分割为8x8x8的立方体块,实现计算复杂度从O(n²)降至O(n√n)。这种效率优化使模型在消费级GPU(如RTX 4090)上也能运行——单卡生成1分钟视频仅需18分钟,较同类模型节省75%算力成本。值得注意的是,模型采用MIT许可证,企业可免费用于商业用途,这与多数开源视频模型的非商业条款形成鲜明对比。

性能评测:开源领域领先,部分指标比肩闭源旗舰

在美团内部基准测试中,LongCat-Video展现全面优势:

| 评估维度 | LongCat-Video | 开源标杆(Wan 2.2) | 闭源旗舰(Veo3) |

|---|---|---|---|

| 文本对齐度 | 3.76 | 3.70 | 3.99 |

| 视觉质量 | 3.25 | 3.26 | 3.23 |

| 运动连贯性 | 3.74 | 3.78 | 3.86 |

| 长视频一致性 | 4.8/5 | 3.5/5 | 4.6/5 |

| 720p推理速度 | 5分钟 | 89分钟 | 12分钟 |

特别在"物理合理性"专项测试中,模型对复杂场景的处理能力尤为突出:生成"冰块投入水中"视频时,能正确模拟浮力、折射和水花飞溅效果,这一表现甚至超越部分闭源模型。

行业影响:从内容创作到自动驾驶的跨领域变革

LongCat-Video的开源将加速三大产业变革:

1. 内容创作:生产成本降低70%

自媒体创作者可直接通过文本生成产品开箱视频(如"展示新款运动鞋的360°旋转和弹性测试"),配合视频续写功能实现多镜头剪辑。初步测试显示,单个5分钟产品视频的制作时间从传统4小时缩短至20分钟。

2. 智能驾驶:虚拟路况生成效率提升

美团自动驾驶团队透露,该模型已用于生成极端天气路况视频(暴雨、浓雾等),使训练数据覆盖场景增加40%,且标注成本降低65%。这种"模拟-真实"的数据闭环正在重塑自动驾驶研发范式。

3. 开源生态:激发二次创新

社区开发者已基于LongCat-Video衍生出多个优化项目,如唯品会CacheDiT通过缓存加速技术实现1.7倍推理提速,而高校团队则聚焦于移动端轻量化改造,目标在手机端实现10秒短视频生成。

部署指南:5分钟上手长视频生成

环境准备

# 克隆仓库

git clone https://gitcode.com/hf_mirrors/meituan-longcat/LongCat-Video

cd LongCat-Video

# 创建环境

conda create -n longcat-video python=3.10

conda activate longcat-video

# 安装依赖

pip install torch==2.6.0+cu124 torchvision==0.21.0+cu124

pip install -r requirements.txt

模型下载

huggingface-cli download meituan-longcat/LongCat-Video --local-dir ./weights

快速生成5分钟长视频

# 单GPU运行

torchrun run_demo_long_video.py --checkpoint_dir=./weights --enable_compile

未来展望:迈向世界模型的关键一步

美团LongCat团队表示,该模型只是探索"世界模型"的起点。下一代版本将重点突破:

- 物理交互建模:支持生成物体碰撞、流体运动等复杂物理场景

- 多模态交互:实现文本-视频-3D模型的联动生成

- 实时渲染:目标将720p视频生成速度提升至1秒/帧

正如技术研究结语所言:"当AI能持续生成符合物理规律的长视频时,我们或许正在见证数字世界'生命'的诞生。"对于开发者而言,现在正是加入这场视频生成革命的最佳时机——无论是优化推理速度、拓展应用场景还是改进评估体系,每个方向都可能诞生颠覆性创新。

【免费下载链接】LongCat-Video

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考