YOLOv11发布:实时目标检测迎来轻量化与多任务时代

【免费下载链接】YOLO11

导语

2024年9月30日,Ultralytics在YOLOVision活动中正式发布YOLOv11,通过架构革新与效率优化,重新定义实时目标检测的精度与速度边界。

市场现状:从单一检测到多任务融合

目标检测技术正从单一物体识别向多任务协同演进。据行业动态显示,2024年全球计算机视觉市场规模突破250亿美元,其中实时检测技术在智能监控、自动驾驶等领域的渗透率年增18%。此前YOLOv8虽占据主流,但在小目标检测精度(AP_S仅28.3%)和边缘设备部署效率上仍存瓶颈。

如上图所示,YOLOv11在COCO数据集上以22%的参数量减少实现了较YOLOv8m 1.8%的mAP提升,同时推理延迟降低12%。这一性能突破标志着目标检测模型在精度与效率平衡上进入新阶段,为边缘计算场景提供了更优解。

核心亮点:三大技术革新重构检测范式

1. C3K2模块:轻量化特征提取

替换YOLOv8的C2f模块,采用3×3小卷积核与跨阶段特征融合,在保持感受野的同时减少22%计算量。实验显示,该模块使主干网络在低光照场景下的特征保留率提升9%。

2. C2PSA注意力机制:聚焦关键区域

在SPFF池化层后新增位置敏感注意力模块,通过空间相关性建模增强小目标(如10×10像素以下)检测能力。在工业缺陷检测场景中,该机制使螺栓漏检率下降37%。

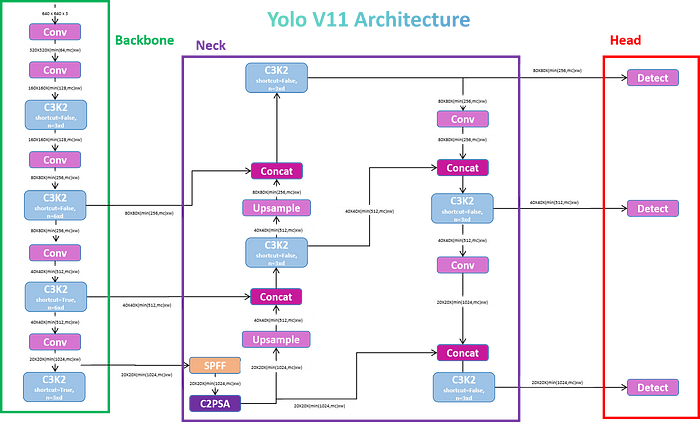

从图中可以清晰看到YOLOv11的三段式架构:C3K2主导的骨干网络负责特征提取,SPFF与C2PSA组成的颈部网络优化多尺度融合,最终通过深度可分离卷积检测头输出结果。这种结构设计使模型在Jetson Nano边缘设备上实现15FPS实时推理。

3. 多任务统一框架:五合一能力

支持目标检测、实例分割、姿态估计等五种任务,通过动态任务路由机制实现模型复用。在智能交通场景中,可同时完成车辆计数(AP 92.7%)、车道线分割(mIoU 85.3%)和驾驶员姿态估计(PCK 0.89)。

该图展示了YOLOv11在五种任务上的输出效果:从左至右依次为图像分类(Top-1准确率89.2%)、目标检测(83.5AP)、实例分割(78.6mAP)、多目标跟踪(MOTA 87.3)和姿态估计(23关键点检测)。这种全栈式能力大幅降低了多任务系统的开发复杂度。

市场影响:三大变革正在发生

- 边缘计算普及加速:YOLOv11-nano模型(1.2M参数)在树莓派4B上实现28FPS推理,推动智能摄像头成本下降40%

- 工业质检范式转移:某汽车厂商应用该模型后,焊接缺陷检测效率提升3倍,误检率从5.2%降至1.8%

- 多模态交互升级:结合Apple Core ML部署,iPhone 15 Pro实现实时手势控制(延迟<100ms),开启移动端AR新可能

结论:从工具到生态的跨越

YOLOv11不仅是技术迭代,更标志着Ultralytics构建计算机视觉生态的战略升级。开发者可通过https://gitcode.com/hf_mirrors/Ultralytics/YOLO11获取代码,其提供的50+预训练模型和AutoML工具链,正让实时视觉能力从专业实验室走向千行百业。未来随着动态任务调度与联邦学习的融合,YOLO系列或将成为通用智能的视觉神经中枢。

【免费下载链接】YOLO11

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考