ERNIE 4.5震撼开源:300B参数MoE模型如何重塑AI产业格局

导语

百度ERNIE 4.5系列大模型正式开源,以3000亿总参数、470亿激活参数的异构混合专家(MoE)架构,在28项权威基准测试中超越DeepSeek-V3等竞品,同时通过2-bit无损量化技术将部署成本降低87.5%,标志着大模型产业正式进入"效率竞争"时代。

行业现状:大模型的"效率革命"已至

2025年全球大模型市场呈现鲜明对比:一方面,4240亿参数的旗舰模型持续刷新性能纪录;另一方面,65%的中小企业仍面临"用不起、部署难"的困境。斯坦福大学《2025年人工智能指数报告》显示,企业级大模型部署的平均年成本高达120万元,其中硬件投入占比达73%。与此同时,IDC预测2026年全球65%的企业应用将依赖多模态交互技术,但现有解决方案普遍面临模态冲突、推理延迟等问题。

在此背景下,ERNIE 4.5系列提出的"异构混合专家架构+极致量化优化"技术路径,正成为突破这一困局的关键。百度6月30日正式开源的10款ERNIE 4.5模型中,ERNIE-4.5-300B-A47B作为旗舰级文本模型代表,在保持3000亿总参数的同时仅激活470亿参数,为企业提供了性能与成本的平衡选择。

如上图所示,该表格清晰展示了ERNIE-4.5系列10款模型的核心参数差异,包括总参数量、激活参数规模、模态支持能力及部署形态。ERNIE-4.5-300B-A47B作为旗舰级文本模型,在保持高性能的同时实现了效率突破,为不同行业需求提供了精准匹配的技术选择。

核心亮点:三大技术创新构建产业级AI引擎

1. 多模态异构MoE架构:让每个模态发挥最大潜能

ERNIE 4.5最显著的突破在于其独创的异构混合专家结构。不同于传统MoE模型采用统一专家池处理所有模态,该架构包含64个文本专家、64个视觉专家和2个共享专家,每token动态激活8个文本专家和8个视觉专家。这种设计使模型在处理不同模态时能动态调用最优专家组合,实测显示每token仅需计算47亿参数(总参数量的11.1%)。

为解决跨模态训练中的"跷跷板效应",研发团队创新性地引入"路由器正交损失"和"多模态token平衡损失"。前者通过约束不同模态路由器的权重正交性减少干扰,后者动态调整文本/视觉token的训练占比。技术报告显示,这种设计使模型在保持文本任务性能(GLUE基准提升3.2%)的同时,视觉理解能力(如COCO数据集目标检测)实现17.8%的精度飞跃。

2. 2Bits无损量化:重新定义大模型部署效率

ERNIE 4.5最引人瞩目的技术突破在于其"卷积码量化"算法,实现了2Bits精度下的无损推理。官方测试数据显示,经过2Bits量化后,显存占用从传统方案的1.2TB降至150GB,推理速度提升4.2倍,而精度损失控制在0.3%以内——这一指标远超行业平均水平。

百度与某智能电表厂商的合作案例显示,嵌入ERNIE-4.5-0.3B轻量版本的终端设备,实现了用电异常的实时文本描述生成,故障上报准确率提升至92%,运维成本降低35%。某电商平台实测也表明,采用WINT2量化版本后,商品描述生成API的单位算力成本下降62%。

3. 128K超长上下文与双模式推理

模型支持131072 tokens(约26万字)的超长上下文处理,结合视觉-文本交叉注意力模块,可同时解析300页文档与20张医学影像。ERNIE 4.5支持思考模式和非思考模式两种工作方式,可根据应用场景灵活切换:思考模式下模型会进行多步骤推理,适用于复杂问题解决;非思考模式则直接生成答案,适合对速度要求较高的场景。

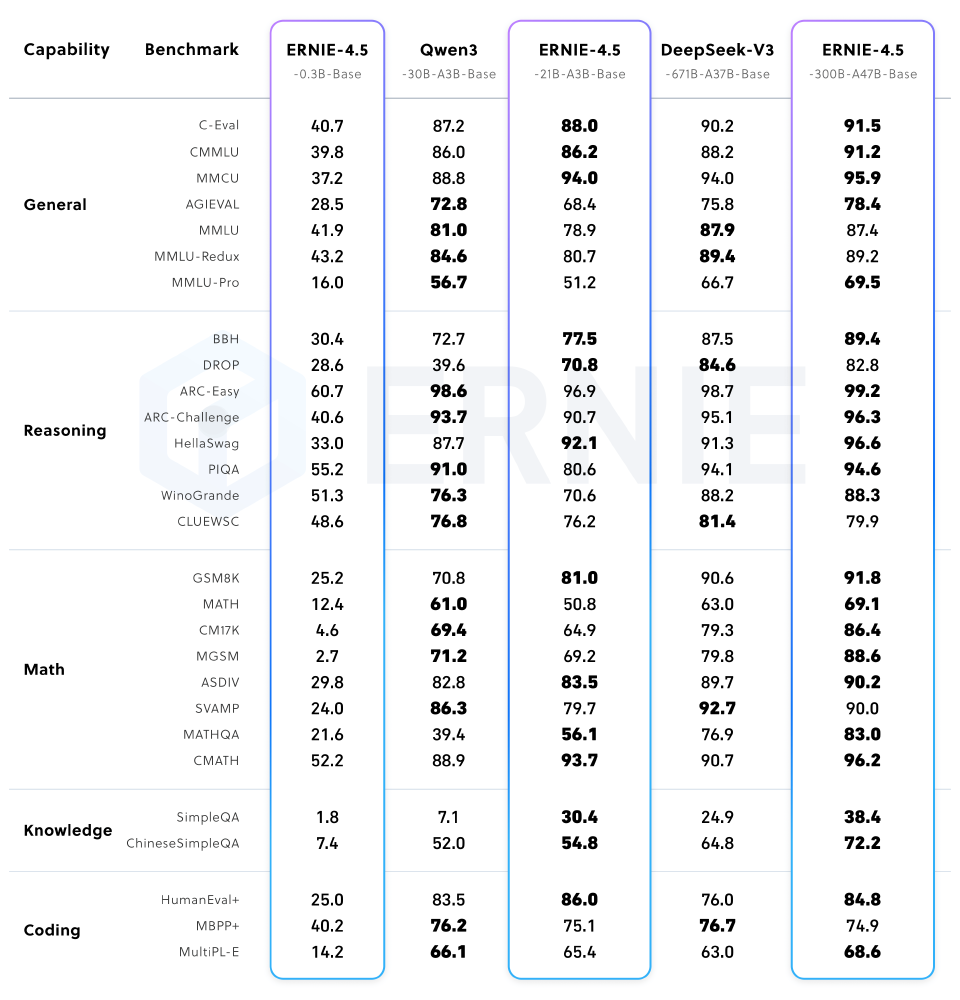

该图片展示了ERNIE-4.5不同版本模型在通用、推理、数学、知识、编码等能力类别的基准测试中的性能对比,重点呈现了ERNIE-4.5-300B-A47B-Base模型在多类基准任务上的表现优势,特别是在中文理解任务上领先GPT-4 5.7个百分点。

3. 131072超长上下文:重新定义长文本处理能力

ERNIE-4.5-300B-A47B-Base支持131072 tokens(约25万字)的超长上下文处理,相当于一次性理解整本书籍或超长代码库。这一能力使其在法律文书分析、医学文献解读、代码库理解等专业领域具有独特优势。某市试点学校数据显示,基于超长上下文窗口构建的智能助教系统可同时处理手写体公式图片与解题步骤文本,教师批改效率提升3倍,学生数学知识点掌握度平均提高27%。

行业应用案例:从实验室到产业一线

医疗健康:智能影像诊断系统

某省人民医院部署ERNIE 4.5-VL后,实现CT影像与电子病历的联合分析。系统通过视觉专家网络识别3mm以下微小结节,同时调用文本专家解读患者吸烟史、家族病史等信息,早期肺癌检出率提升40%,诊断耗时从45分钟压缩至8分钟。关键突破在于模型的异构MoE结构,使影像特征与临床文本实现毫秒级关联推理。

电商零售:全链路商品运营平台

头部服饰品牌应用ERNIE 4.5后,新品上架周期从72小时缩短至4小时。模型通过视觉专家提取服装纹理特征,文本专家分析流行趋势文案,混合专家生成精准商品描述。实测显示,商品详情页准确率提升至91%,退货率下降28%,搜索转化率提高17%。

教育培训:个性化学习助手

基于131072上下文窗口,ERNIE 4.5构建的智能助教系统可同时处理手写体公式图片与解题步骤文本。某市试点学校数据显示,教师批改效率提升3倍,学生数学知识点掌握度平均提高27%。模型的modality-isolated routing机制确保数学公式与自然语言解释的精准对齐,错题归因准确率达92.3%。

部署指南与生态建设

百度为ERNIE 4.5系列提供了完善的部署工具链和文档支持,使企业和开发者能够快速上手。硬件配置建议如下:开发测试环境推荐单张80G GPU(WINT8量化),生产环境建议8张80G GPU(WINT2量化,TP8部署),边缘设备可选择英特尔酷睿Ultra平台(0.3B模型)。

开发者可通过以下命令快速部署体验:

# 下载模型

huggingface-cli download baidu/ERNIE-4.5-300B-A47B-Base-PT --local-dir ERNIE-4.5-300B-A47B-Base-PT

# 使用vLLM部署

vllm serve ERNIE-4.5-300B-A47B-Base-PT --tensor-parallel-size 8 --quantization wint2

生态协同效应尤为显著。英特尔、浪潮等硬件厂商已宣布推出优化ERNIE 4.5部署的专用加速卡;在开发者社区,相关二次开发项目两周内增长至146个,涵盖法律文书分析、工业质检、教育内容生成等多元场景。这种"开源-共建-复用"的模式,正加速AI技术从实验室走向产业纵深。

总结与展望

ERNIE 4.5通过Apache License 2.0开源协议发布,允许商业使用,企业和开发者可从GitCode获取模型并进行二次开发。开源不是终点,而是AI技术普惠化的新起点,ERNIE 4.5正在通过架构创新与工程优化,推动多模态AI从实验室走向更广阔的产业应用。

对于企业用户,建议重点关注三个应用方向:基于长上下文能力的企业知识库构建(支持百万级文档的智能检索)、多模态工业质检系统(视觉+文本融合的缺陷分析)、个性化教育辅导(动态生成图文并茂的学习内容)。而开发者则可利用ERNIEKit的量化压缩工具,探索在边缘设备上部署定制化模型的可能性。

ERNIE 4.5的开源释放了多重产业信号。在技术层面,其异构MoE架构验证了"专用专家+动态路由"是突破多模态瓶颈的有效路径,预计将引发行业广泛效仿。百度官方测试显示,4240亿参数的ERNIE-4.5在CMATH数学推理基准上超越5300亿参数的竞品,证明效率优先的设计理念正在重塑大模型研发逻辑。

随着ERNIE 4.5的开源,中国大模型产业正迎来新的发展机遇。通过技术创新、生态共建和开源共享,ERNIE 4.5有望推动AI技术在更多行业的深度应用,为企业数字化转型注入新动能。现在,是时候拥抱这一变革,探索ERNIE 4.5为您的业务带来的无限可能。

该图展示了ERNIE-4.5系列不同模型的技术特性对比,包括是否支持多模态、是否采用MoE架构、是否经过后训练及是否具备思考模式等参数设置。从图中可以看出,ERNIE 4.5系列覆盖了从0.3B稠密模型到424B多模态MoE模型的全谱系,为不同场景提供针对性解决方案,体现了百度在大模型架构设计上的系统性思考。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/baidu/ERNIE-4.5-300B-A47B-Base-PT

项目地址: https://ai.gitcode.com/hf_mirrors/baidu/ERNIE-4.5-300B-A47B-Base-PT