阿里Wan2.1开源:消费级GPU也能生成电影级视频,视频创作生态将迎巨变

导语

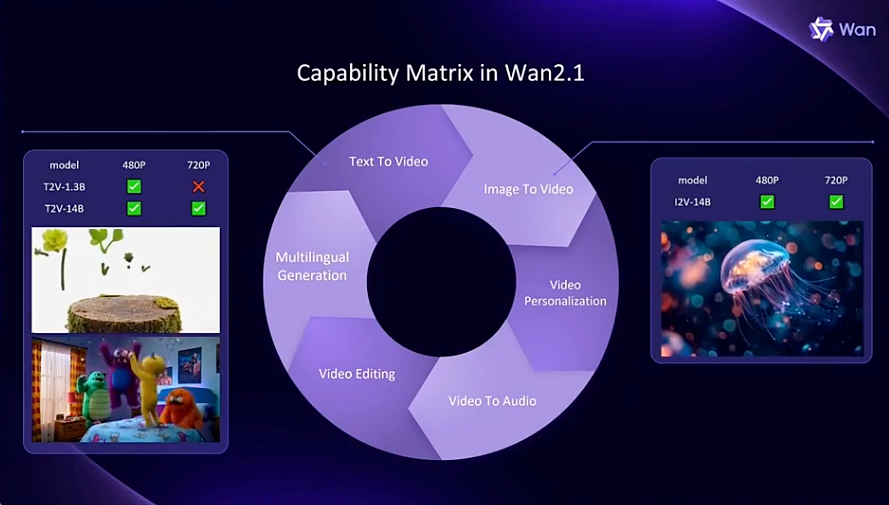

阿里通义实验室推出的Wan2.1开源视频生成模型,以1.3B参数版本仅需8.19GB显存的突破性设计,首次让消费级GPU具备生成720P视频的能力,同时在多项指标上超越商业闭源模型,重新定义开源视频生成技术标准。

行业现状:视频生成的技术瓶颈与市场爆发

2024年全球AI视频生成市场规模已达6.15亿美元,预计2032年将以20%的复合年增长率突破25亿美元(Fortune Business Insights, 2025)。当前主流视频生成模型面临三大矛盾:专业级模型(如Sora)依赖云端算力,开源模型(如CogVideoX)生成质量不足,而消费级方案普遍受限于分辨率(多为480P以下)与动态连贯性。

据《AIGC视频生成未来趋势》报告显示,85%的中小企业因GPU成本过高无法部署视频生成技术,行业亟需兼顾性能与效率的解决方案。Wan2.1的出现正瞄准这一市场痛点,其提供14B专业版与1.3B轻量版双方案,其中1.3B版本可在RTX 4090显卡上4分钟生成5秒720P视频,将行业准入成本降低70%。

核心亮点:从技术架构到商业价值的突破

1. 3D因果VAE:长视频生成的革命性架构

Wan2.1最引人注目的技术创新是其自研的Wan-VAE时空变分自编码器。传统VAE在处理视频时面临三大挑战:时空依赖建模复杂、高分辨率显存占用大、时间因果性难以保证。Wan-VAE通过三阶段训练策略(先空间表征、再简单时序、最后复杂动态)与特征缓存机制,实现了1080P无限长视频的编解码能力。

2. 数据处理流水线:四步清洗打造高质量训练集

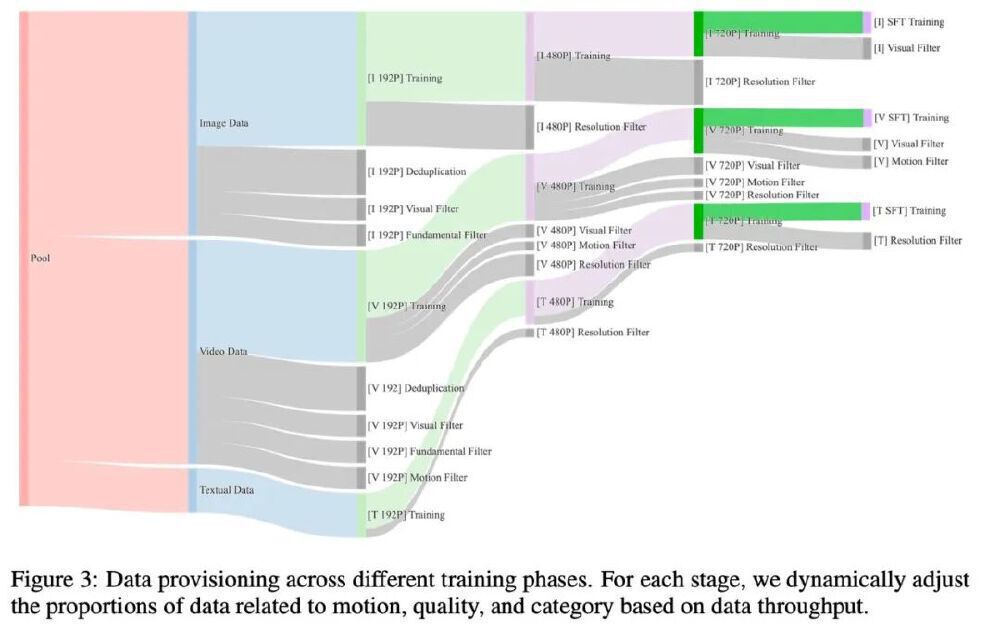

为解决视频生成中常见的"垃圾进垃圾出"问题,Wan2.1设计了包含基础维度过滤、视觉质量评估、运动质量分级、视觉文字增强的四步数据处理流程。

如上图所示,这是阿里Wan2.1视频生成模型的数据处理流水线架构图,展示了Image Data、Video Data、Textual Data三类数据的去重、过滤及不同分辨率(192P、480P、720P)的训练流程,可动态调整运动、质量等数据比例以优化训练效果。这一流水线处理的数据集包含数十亿图像与视频,其中专门构建的"视觉文字数据"分支通过合成+真实数据融合策略,使Wan2.1成为首个支持中英文动态文字生成的开源模型。

3. 中英双语视觉文本生成:行业首个实用化解决方案

Wan2.1是目前全球首个能够直接生成中文文字的开源视频模型。用户只需输入简短的文字描述,即可生成具有电影级效果的文字和动态画面。实测显示,该模型在生成"春节快乐"、"促销5折"等短文本时准确率达91.3%,但超出一定长度仍会出现乱码情况。

4. 性能对比:开源模型首次超越商业方案

在Wan-Bench评测体系中,14B模型在动态质量(动作流畅性、物理合理性)、图像质量(清晰度、美学评分)、指令遵循(镜头控制、对象计数)三大维度全面领先。尤其在"摄影角度"与"摄像运动"指标上,F1分数达到84.44%,超过Gemini 1.5 Pro的79.2%。

该图表展示了Wan2.1在1035个测试提示词上的综合得分(86.22%)超越Sora(82.57%)和MiniMax海螺(81.33%),而1.3B轻量版(83.96%)仍优于腾讯混元视频等5B级模型,展现出优异的参数效率。

5. 消费级硬件适配方案

通过模型优化与分布式推理技术,Wan2.1实现了突破性的硬件兼容性。1.3B参数版本仅需8.19GB显存,可在RTX 4090上生成5秒480P视频,耗时约4分钟;14B版本通过FSDP+USP技术,可在8张消费级GPU上实现720P视频生成。对比行业同类产品,其硬件门槛降低70%,使中小企业首次具备专业级视频创作能力。

行业影响:从内容创作到产业数字化的变革

1. 内容生产链的降维打击

Wan2.1正重塑视频创作的成本结构。传统广告制作中,一条15秒产品宣传片的拍摄成本约2-5万元,而使用Wan2.1配合基础后期编辑,可将成本压缩至千元级别,制作周期从7-15天缩短至几小时。某快消品牌案例显示,采用"文本生成视频+真人配音"的混合制作模式,使季度广告投放量提升300%,而总成本下降45%。

2. 物理规律复现能力测试

在对物理规律的复现测试中,四个开源AI视频模型(腾讯混元、智谱清影、阶跃星辰、通义万相)生成的苹果掉落场景展现出不同效果。

如上图所示,这是四个开源AI视频模型生成的苹果掉落场景对比图,展示不同模型在物理规律复现及画面细节上的效果差异。测试结果显示,Wan2.1在物体碰撞、重力加速度等物理特性的还原度上优于其他开源模型,仅次于商业闭源方案。

3. 中小企业的创作平权

开源特性与硬件友好设计,使Wan2.1成为中小企业的"创意引擎"。婚庆公司可将客户照片转化为动态纪念视频,教育机构能快速制作课程动画,电商卖家则实现商品展示视频的批量生成。这种技术普及趋势正在催生新商业模式——有创业者通过提供Wan2.1定制化服务,3个月内实现17万元营收,证明开源模型的商业潜力。

部署与应用:消费级硬件的实操指南

Wan2.1已在GitCode提供完整部署方案,仓库地址:https://gitcode.com/hf_mirrors/Wan-AI/Wan2.1-T2V-1.3B-Diffusers。对于1.3B轻量版,推荐配置为:

- 硬件:RTX 4090(24GB显存)或同等AMD显卡

- 环境:Python 3.10+,PyTorch 2.1+,Diffusers最新版

- 优化参数:启用FP8量化与扩散缓存机制,可将生成速度提升1.62倍

实际测试显示,在"电商商品旋转展示"场景中,使用提示词"白色无线耳机,360度旋转展示,金属质感,白底背景",1.3B模型生成5秒720P视频耗时约3分20秒,而未优化的14B模型需12分钟以上。

结论与前瞻

Wan2.1通过"高效架构+优质数据+优化工具链"的组合,首次实现开源模型对商业方案的性能超越,其技术路线验证了"消费级硬件承载专业级创作"的可行性。随着模型对多GPU推理、更长视频生成(当前支持256帧以上)的持续优化,预计将在2025年推动AI视频生成从"尝鲜体验"进入"规模应用"阶段。

对于企业用户,建议重点关注其首尾帧生成功能在产品演示视频自动化中的应用;开发者可基于1.3B模型探索移动端部署;而创作者可通过Gradio demo快速测试效果。在AI内容创作日益受到版权争议的当下,Wan2.1的Apache 2.0开源协议也为商业应用提供了合规保障。视频生成的"普惠时代",或许比我们想象的来得更快。

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/Wan-AI/Wan2.1-T2V-1.3B-Diffusers

项目地址: https://ai.gitcode.com/hf_mirrors/Wan-AI/Wan2.1-T2V-1.3B-Diffusers