2025年,人工智能领域正经历着一场静悄悄的变革。当行业目光聚焦于千亿参数模型的性能突破时,阿里通义千问团队推出的Qwen3-VL-4B-Thinking模型,以44亿参数的精巧架构实现了视觉代理、空间推理与代码生成的多模态融合,为边缘计算场景带来了前所未有的智能体验。这款轻量级模型不仅重新定义了小参数模型的能力边界,更为AI技术的规模化落地提供了全新范式。

【免费下载链接】Qwen3-VL-4B-Thinking

当前,多模态人工智能已从实验室走向产业应用的深水区。Gartner最新发布的技术成熟度曲线显示,多模态AI技术已跨越创新触发期,正式进入生产力爆发阶段。全球科技企业研发投入数据显示,2025年多模态技术研发占比已攀升至42.3%,成为AI领域增长最快的细分赛道。市场反馈数据更印证了这一趋势——采用多模态技术的企业平均工作效率提升40%,其中金融风控、智能制造和远程医疗等领域的应用价值尤为突出。

在这场技术演进中,行业呈现出鲜明的"双向突破"特征:一方面,参数规模竞赛持续白热化,千亿级模型不断刷新性能纪录;另一方面,轻量化技术路线取得重大突破,通过架构创新与量化压缩,中小参数模型开始具备原本只有云端大模型才能实现的复杂能力。Qwen3-VL-4B-Thinking正是后一条技术路线的典范之作,其44亿参数规模却实现了视觉代理、空间感知与长视频理解等高端功能,为资源受限环境下的智能应用开辟了新路径。

Qwen3-VL-4B-Thinking最具革命性的突破在于其首创的视觉代理(Visual Agent)系统,实现了从被动感知到主动行动的关键跨越。该系统能够直接解析图形用户界面(GUI),自主识别界面元素、理解功能逻辑并执行操作指令,形成完整的任务闭环。在企业办公场景测试中,该模型展现出惊人的自动化能力:通过分析屏幕截图即可完成文件分类、数据录入和报表生成等复杂任务,将传统需要人工操作的流程转化为智能化处理,为企业数字化转型提供了全新工具。

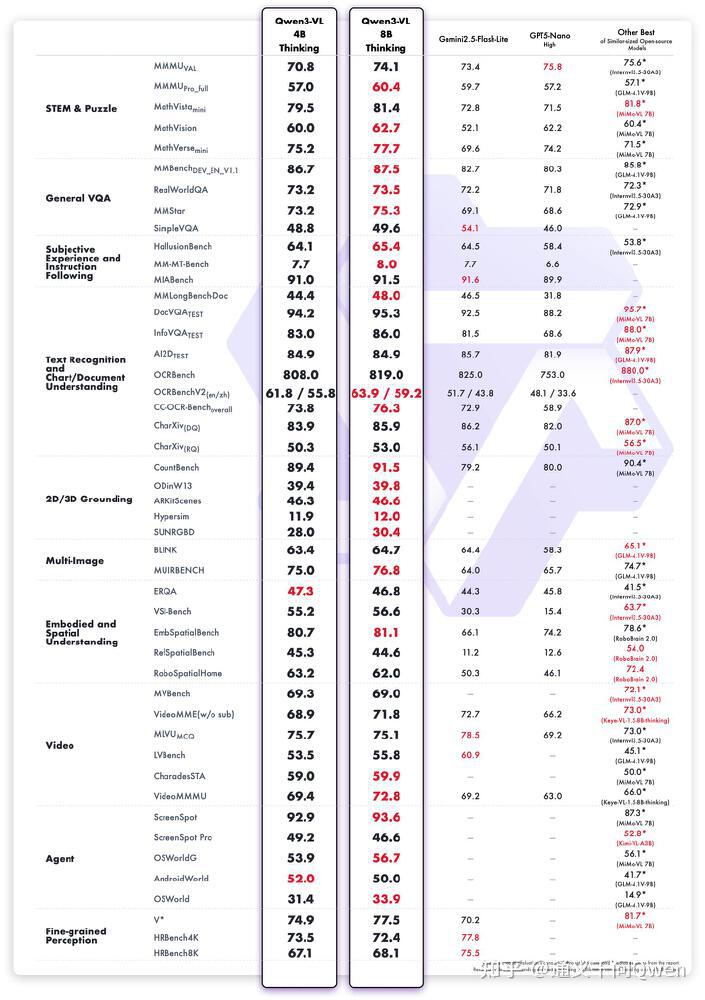

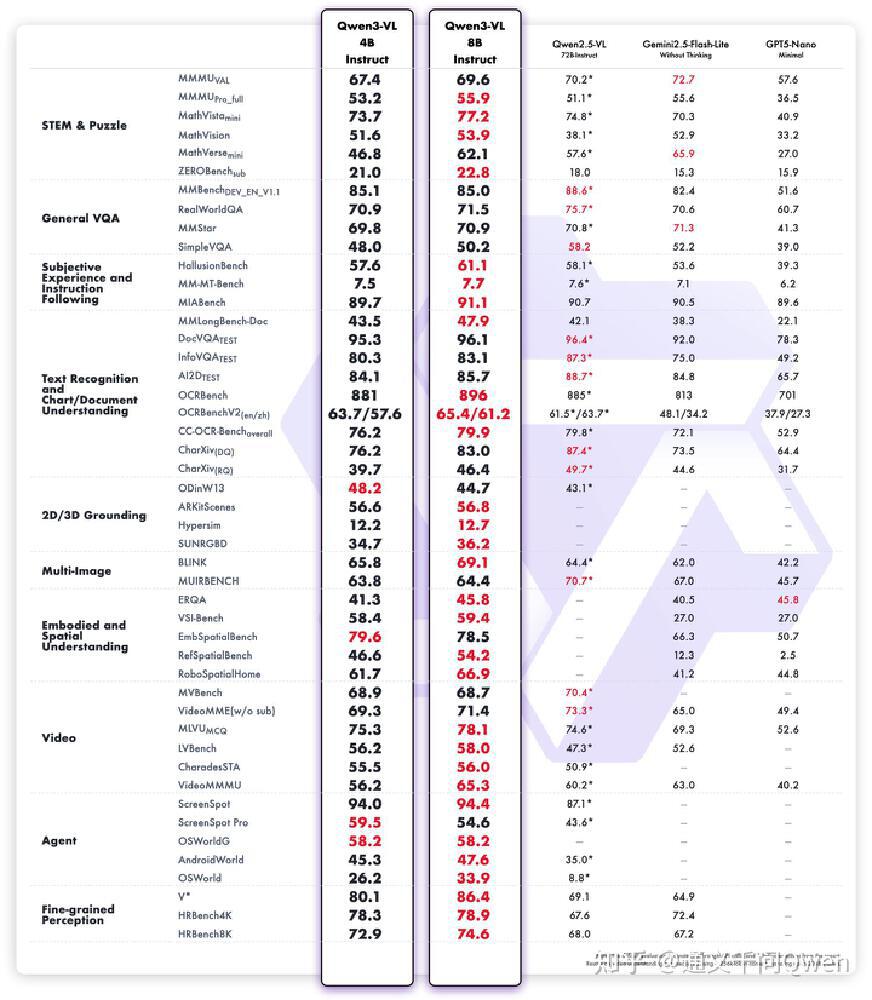

尽管体型精巧,Qwen3-VL-4B-Thinking在核心性能指标上却展现出"以小博大"的实力。官方公布的多模态基准测试数据显示,该模型以70.9分的综合成绩领先第二名InternVL3.5-4B达3.2分,尤其在STEM领域推理、视觉问答(VQA)和光学字符识别(OCR)等关键任务上表现突出。

如上图所示,该对比表格清晰展示了Qwen3-VL-4B-Thinking在STEM推理、VQA问答和OCR识别等核心任务上的性能得分。数据表明,这款44亿参数模型不仅超越了同量级的Gemini2.5 Flash Lite,甚至在部分指标上逼近上一代72B参数大模型,完美诠释了"小而精"的设计理念,为算力受限环境下部署高级AI应用提供了可行性方案。

特别值得关注的是,Qwen3-VL-4B-Thinking成功克服了传统小模型的"能力跷跷板"困境——在提升视觉处理能力的同时保持了卓越的文本理解性能。该模型通过创新的DeepStack架构实现多层视觉特征融合,同时采用Interleaved-MRoPE技术优化位置编码机制,使多模态融合后的文本理解能力达到了纯语言模型的水平,这一突破为多模态模型的均衡发展提供了新的技术范式。

部署灵活性是Qwen3-VL-4B-Thinking的另一核心竞争力。该模型仅需8GB显存即可流畅运行,普通消费级显卡甚至高端笔记本电脑都能提供足够支持。最新发布的FP8量化版本更是将模型体积压缩50%,同时保持与BF16精度版本99%的性能一致性,为移动端和边缘设备部署扫清了算力障碍,使AI能力真正下沉到终端设备成为可能。

在制造业领域,Qwen3-VL-4B-Thinking正在引发质检流程的颠覆性变革。某汽车零部件龙头企业引入该模型后,产品缺陷检测准确率提升至98.7%,同时检测速度提高3倍。与传统人工对比标准图像的质检方式不同,该模型能够直接分析生产线上的实时图像流,精准识别微米级缺陷并自动生成检测报告,不仅大幅降低人工成本,更实现了质量控制的全流程数字化。

对开发者而言,Qwen3-VL-4B-Thinking的"视觉编码增强"功能成为提升生产力的利器。该模型能够将UI设计截图直接转换为可编辑的Draw.io流程图或HTML/CSS/JS代码框架,实测数据显示可减少约40%的前端开发时间。一位拥有10年经验的资深开发者分享道:"过去需要2小时手动编写的数据分析仪表板界面,现在模型15分钟就能生成基础代码架构,让我能够专注于功能优化和用户体验提升这些更有价值的工作。"

随着FP8量化技术的成熟应用,Qwen3-VL-4B-Thinking正在重塑智能终端的用户体验。最新测试数据显示,搭载该模型的智能手机和平板设备可在完全离线状态下实现多模态交互,支持实时翻译、文档扫描、AR空间导航等复杂功能,响应延迟控制在200毫秒以内,功耗较传统云端处理方案降低65%,彻底改变了移动设备对网络连接的依赖,为物联网时代的智能交互开辟了新路径。

Qwen3-VL-4B-Thinking的卓越性能源于三项突破性技术创新:首先是Interleaved-MRoPE位置编码技术,通过在时间、宽度和高度三个维度进行全频率参数分配,显著增强了模型对长视频内容的理解能力和空间推理精度,使其能够处理长达256K上下文的视觉序列;其次是DeepStack视觉特征融合架构,通过多层次视觉Transformer特征的深度整合,既保留图像的细粒度细节信息,又强化了跨模态对齐精度;最后是文本-时间戳对齐技术,超越传统T-RoPE方法,实现视频中事件的精确时间定位,为动态场景分析提供了技术支撑。

如上图所示,该对比表格详细呈现了Qwen3-VL-4B-Thinking与同类模型在STEM推理、视觉问答和光学字符识别等多模态任务上的得分情况。这一性能对比直观展示了小参数模型通过架构创新实现的能力跃升,为行业选择适合边缘部署的AI方案提供了重要参考依据。

Qwen3-VL-4B-Thinking的问世标志着多模态AI正式进入"普惠智能"时代。展望未来,我们可以预见三个明确的发展方向:首先是行业应用的全面渗透,预计到2026年,轻量级多模态模型将在零售智能导购、物流智能分拣和教育个性化辅导等领域实现规模化应用,创造超过200亿美元的新增市场价值;其次是端云协同架构的成熟,边缘设备上的轻量级模型与云端大模型将形成高效协同,通过"本地处理+云端增强"的混合模式,在保护数据隐私的同时确保服务质量;最后是定制化能力的普及,借助低代码工具和迁移学习技术,企业和个人开发者将能够快速构建专属多模态模型,满足特定场景的个性化需求。

对于企业而言,当前正是布局多模态AI的战略机遇期。建议从三个维度推进:全面梳理业务流程中的视觉-文本交互场景,识别智能化改造机会;选择典型应用场景进行试点部署,验证技术价值并积累实施经验;建立数据采集-模型训练-效果反馈的闭环体系,持续优化模型性能。

Qwen3-VL-4B-Thinking的开源特性为这一探索提供了理想起点,开发者可通过以下命令快速获取模型并开始测试:

git clone https://gitcode.com/hf_mirrors/Qwen/Qwen3-VL-4B-Thinking

在AI技术日益普及的今天,真正的竞争优势不在于拥有技术本身,而在于如何创造性地应用技术解决实际问题。Qwen3-VL-4B-Thinking不仅是一个技术突破,更代表着一种新的智能范式——让强大的AI能力摆脱对昂贵硬件的依赖,以轻盈姿态融入千行百业,最终实现"普惠智能"的科技愿景。

【免费下载链接】Qwen3-VL-4B-Thinking

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考