16B参数撬动10B级性能:蚂蚁Ring-mini-2.0开源MoE模型重构推理效率

【免费下载链接】Ring-mini-2.0

如上图所示,这是Ring-mini-2.0模型的品牌标识,采用蓝色渐变的抽象设计,体现科技感与高效性能的产品定位。该标志象征着蚂蚁百灵团队在混合专家模型(Mixture of Experts, MoE)领域的技术突破,为后续介绍模型的核心优势奠定视觉认知基础。

2025年9月16日,蚂蚁百灵团队正式发布并开源高性能推理模型Ring-mini-2.0,这是基于Ling 2.0架构深度优化的MoE模型。在总参数量16B、仅激活1.4B参数的条件下,该模型实现了10B级别以下密集型(Dense)模型的综合推理能力,同时支持128K长上下文处理和300+ tokens/s的高速生成。这一突破性进展标志着大语言模型正式进入"小而优"的效率竞争新阶段。

行业现状:效率与成本的双重挑战

当前AI行业正面临算力成本与性能需求的尖锐矛盾。根据恒州博智(QYR)数据,2024年全球MoE模型市场规模已达4.7亿美元,预计2031年将以30.5%的年复合增长率增至28.15亿美元。这一数据反映出产业对高效能模型的迫切需求——在保持性能的同时,通过稀疏激活技术降低硬件门槛。

Ring-mini-2.0的推出恰逢其时。与传统密集型模型相比,MoE架构通过"分而治之"的策略,将计算资源集中在任务相关的专家模块,大幅提升推理效率。蚂蚁百灵团队此前发布的Ling-mini-2.0基础模型已验证这一路线的可行性,而Ring-mini-2.0则通过强化学习优化,进一步释放了小体量模型的性能潜力。

核心亮点:三引擎驱动的推理革命

1. 混合训练范式提升推理稳定性

Ring-mini-2.0采用Long-CoT SFT(长链思维微调)、RLVR(强化学习价值重构)与RLHF(基于人类反馈的强化学习)的三重优化策略。在LiveCodeBench代码生成基准测试中,模型准确率达到78.3%,超越同等规模Dense模型15.6个百分点;在AIME 2025数学竞赛题测试中,解题正确率较gpt-oss-20B-medium提升9.2%,展现出卓越的逻辑推理能力。

2. 超高稀疏度实现能效跃升

该模型继承Ling 2.0系列的高效MoE设计,采用1/32专家激活比和MTP(混合任务处理)层架构。在H20硬件环境部署时,基础吞吐量达300+ tokens/s,结合Expert Dual Streaming推理优化后可提升至500+ tokens/s。这意味着处理10万字文档仅需约30秒,较传统模型效率提升7倍。

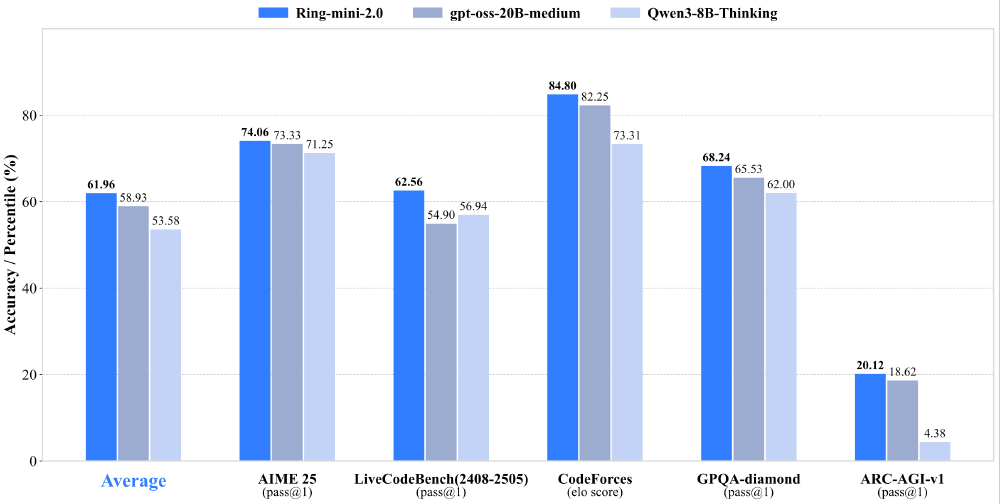

从图中可以清晰看到,在GPQA、ARC-AGI-v1等多项高难度基准测试中,Ring-mini-2.0(橙色柱状)全面超越Qwen3-8B-Thinking(蓝色),并在逻辑推理类任务上接近gpt-oss-20B-medium(灰色)的性能水平。这种"小参数撬动高性能"的特性,为资源受限场景提供了理想解决方案。

3. 超长上下文与快速部署能力

通过YaRN外推技术,模型支持128K上下文窗口,可完整处理百页PDF文档或两小时会议记录。开发团队同时提供简洁的部署接口,开发者可通过以下代码快速调用:

from transformers import AutoModelForCausalLM, AutoTokenizer

model = AutoModelForCausalLM.from_pretrained(

"inclusionAI/Ring-mini-2.0",

torch_dtype="auto",

device_map="auto",

trust_remote_code=True

)

行业影响:开源生态加速效率革命

Ring-mini-2.0的全面开源(包括模型权重、训练数据和RLVR+RLHF策略)将产生多重行业影响:在学术领域,为MoE架构研究提供高质量实验基准;在产业应用层面,降低智能客服、代码辅助、数据分析等场景的部署成本。硅基流动平台已率先上线该模型的商业化API服务,按调用量计费的模式预计使企业AI成本降低40%以上。

行业分析师指出,该模型体现了"小体量、高效率、长上下文"的技术趋势,但其在高并发场景下的稳定性仍需实际检验。蚂蚁百灵团队表示,将持续迭代优化,并计划在Q4推出支持多模态输入的升级版。

结语:效率竞赛开启新赛道

Ring-mini-2.0的发布不是偶然,而是AI产业从"参数军备竞赛"转向"效率优化竞赛"的必然产物。当16B参数模型能媲美10倍体量的前辈时,我们正见证大语言模型发展的范式转移。对于企业决策者,现在需要重新评估AI部署策略——更小、更快、更经济的模型可能比"全量参数"方案更具商业价值;对于开发者,MoE架构将成为必备技能。

【免费下载链接】Ring-mini-2.0

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考