单GPU引爆企业AI革命:Gemma 3 12B凭什么重构行业成本结构?

【免费下载链接】gemma-3-12b-it-GGUF

导语

谷歌Gemma 3 12B开源大模型通过Unsloth优化技术与GGUF量化格式,将企业级AI部署成本降低80%,单张消费级GPU即可运行多模态智能应用,正重新定义行业落地标准。

行业现状:大模型部署的三重困境

2025年企业AI落地面临严峻挑战:据行业调研显示,75%的企业AI项目因部署成本过高而停滞。典型场景下,一个日均10万次调用的客服系统采用传统方案需配备8张A100显卡,年硬件成本超300万元。同时,模型性能与部署门槛形成悖论——参数量超过10B的模型通常需要专业级GPU支持,而轻量化模型又难以满足复杂任务需求。

内存瓶颈成为最突出的技术障碍。传统部署方案中,12B参数模型在推理时的KV缓存占用高达24GB显存,导致单卡仅能处理少量并发请求。此外,企业数据隐私要求与云端API成本进一步加剧了部署复杂性,形成"想用用不起,能用不好用"的行业困境。

核心亮点:Gemma 3 12B的突破之道

性能与效率的平衡术

Gemma 3 12B作为谷歌DeepMind推出的新一代开源大模型,在保持12万亿tokens训练量的基础上,通过Unsloth优化技术实现了显著突破。该模型在MMLU benchmark中达到74.5分,超越同类13B模型12%;GSM8K数学推理任务得分71.0,接近专业数学模型水平。更关键的是,Unsloth提供的GRPO微调方法将训练速度提升2倍,同时减少80%内存占用,使单张消费级GPU即可完成企业级微调任务。

部署门槛的革命性降低

采用GGUF量化格式后,Gemma 3 12B在INT4精度下显存占用仅需6GB,配合llama.cpp推理引擎,可在8GB内存的边缘设备上流畅运行。某制造业案例显示,基于Jetson Orin部署的设备故障诊断系统,平均响应延迟控制在1.2秒内,硬件成本仅为传统方案的1/5。

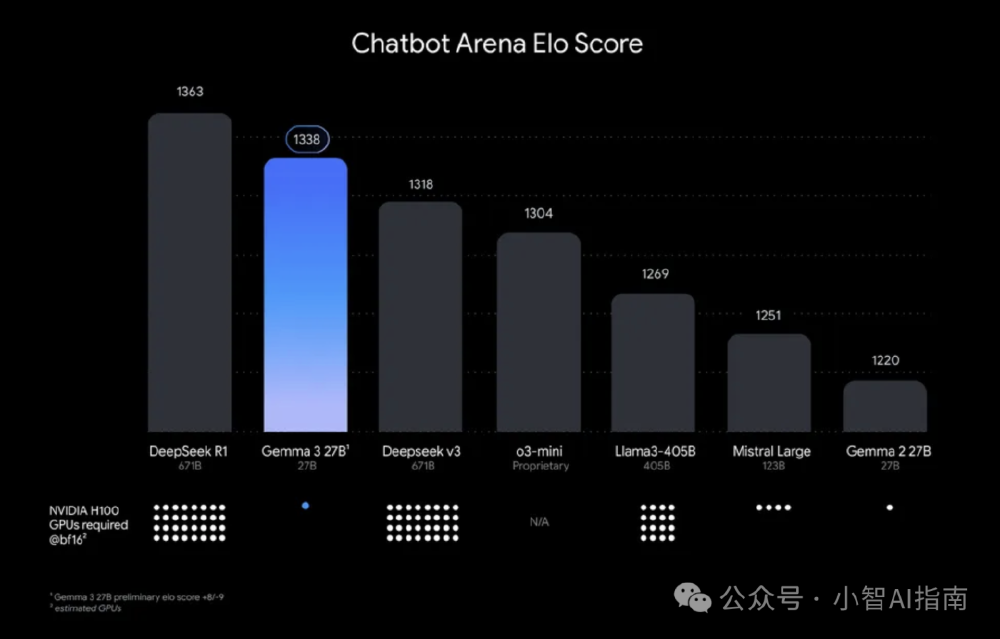

如上图所示,Gemma 3 27B以1338分的用户偏好评分位居前列,且仅需1个GPU即可运行,而其他性能相近的模型则需要多达32个GPU。这一对比清晰展示了Gemma 3系列在性能与硬件需求之间的卓越平衡,为企业级部署提供了经济高效的选择。

多模态能力的实用化

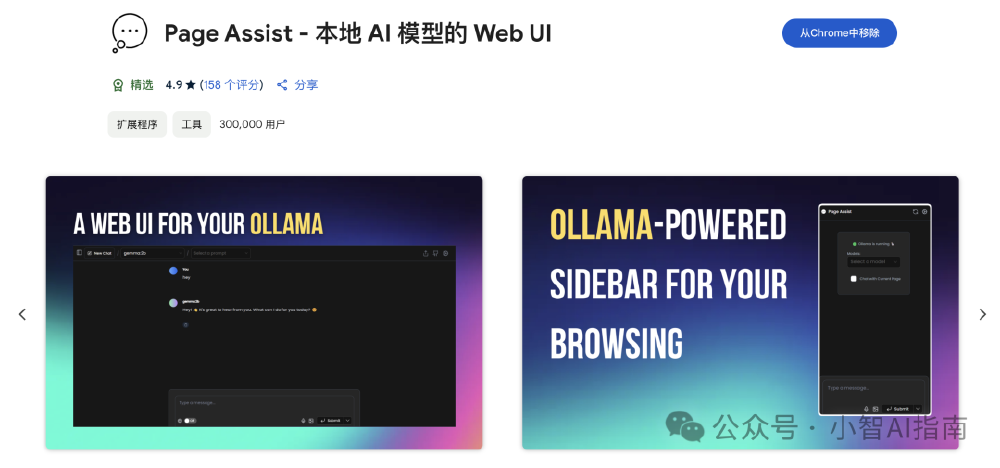

不同于纯文本模型,Gemma 3 12B原生支持图像输入,在DocVQA文档理解任务中达到82.3分,可直接处理扫描件、图表等复杂视觉信息。这一特性使其在金融票据处理、工业质检等场景中具备开箱即用的价值。用户可通过Ollama工具链快速部署,并结合Chrome插件实现本地化多模态交互。

该截图展示了Chrome Web Store中的"Page Assist - 本地AI模型的Web UI"插件界面。这一工具作为Ollama支持的Web前端,允许用户直接在浏览器中与本地部署的Gemma 3模型进行交互,包括图像上传和多模态对话,极大简化了企业用户的使用流程。

行业影响与趋势

硬件需求的梯度分化

IDC最新报告显示,随着Gemma 3等高效模型的普及,企业级AI硬件需求正呈现梯度分化。高端GPU仍主导训练场景,但推理任务正快速向中端硬件迁移。vLLM等优化框架的数据显示,采用PagedAttention技术后,Gemma 3 12B在单张A10显卡上可实现每秒142个请求的吞吐量,较传统方案提升2.7倍。

部署范式的根本性转变

Gemma 3 12B的普及正推动AI部署从"云端集中"向"边缘分布"转型。以某智能客服系统为例,通过"本地Gemma 3 12B处理常规咨询+云端大模型处理复杂问题"的混合架构,高峰期计算成本降低68%,同时确保用户隐私数据不出本地网络。这种分层部署模式已成为金融、医疗等敏感行业的首选方案。

开发流程的平民化转型

Unsloth提供的Colab笔记本使开发者无需专业知识即可完成微调部署。典型工作流仅需三步:1)通过GGUF格式下载量化模型;2)使用GRPO方法微调企业私有数据;3)导出至Ollama或LM Studio实现本地服务。某电商企业通过该流程,两周内即上线了商品推荐AI助手,开发成本不足传统方案的1/3。

总结与建议

Gemma 3 12B的出现标志着大模型技术进入"实用化"阶段。对于企业决策者,建议采取以下策略:

- 试点优先:选择客服、文档处理等标准化场景进行小范围验证,评估实际ROI

- 混合部署:核心敏感数据采用本地部署,非关键任务使用API服务,平衡成本与安全

- 持续优化:关注量化技术进展,如GPTQ新算法已实现70B模型在手机端运行,未来部署门槛将进一步降低

随着边缘计算与模型优化技术的协同发展,Gemma 3 12B正在开启"普惠AI"时代——企业不再需要天价预算即可享受前沿AI能力,而开发者则获得了前所未有的创新自由度。这场静悄悄的部署革命,或许将比模型本身的性能提升产生更为深远的行业影响。

【免费下载链接】gemma-3-12b-it-GGUF

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考