导语

【免费下载链接】LFM2-1.2B-GGUF

Liquid AI推出第二代液体基础模型LFM2-1.2B-GGUF,以12亿参数实现49.9%的MMLU得分,较同类模型快2倍推理速度,重新定义边缘设备AI部署标准。

行业现状:边缘AI的"效率革命"

2025年全球边缘计算市场规模预计突破2000亿美元,设备端AI需求呈爆发式增长。然而传统大模型面临三大痛点:云端依赖导致延迟(平均230ms)、数据隐私风险(医疗/金融场景敏感数据出境)、硬件成本高企(GPU部署门槛)。据IDC报告显示,2024上半年中国AI大模型解决方案市场规模达13.8亿元,预计2024-2028年年均复合增长率为56.2%,到2028年将达到211亿元。

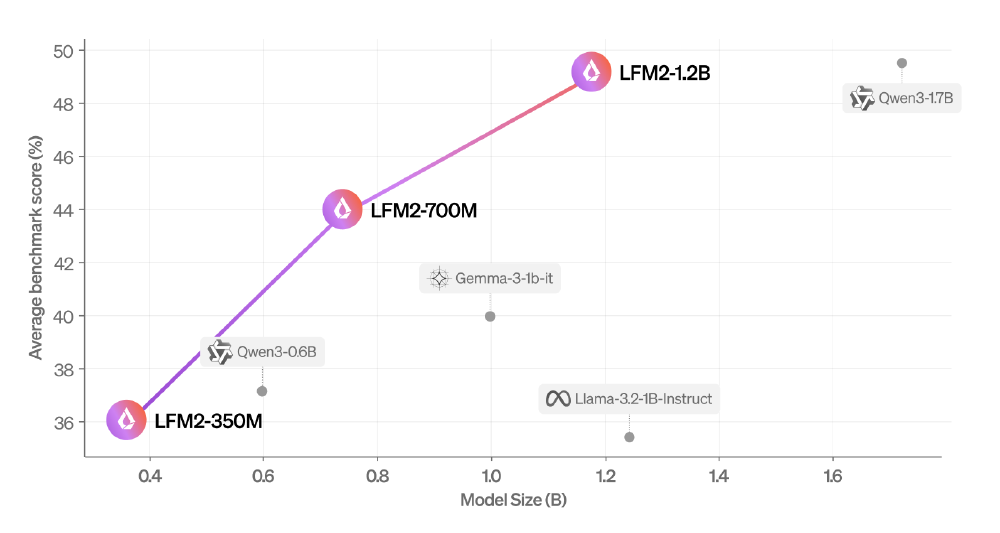

Liquid AI此次开源的LFM2系列(350M/700M/1.2B)正是针对这一现状。作为第二代液体基础模型,其混合架构(10个卷积块+6个注意力块)在保持12亿参数规模的同时,实现了49.9%的MMLU多任务得分,超越Qwen3-0.6B(44.93%)和Llama-3.2-1B(46.6%),成为当前效率比最优的边缘模型。

如上图所示,散点图清晰展示了LFM2系列模型在参数规模与性能之间的领先优势。其中1.2B版本不仅参数小于Qwen3-1.7B,性能却实现全面超越,印证了其"以小博大"的技术突破。这一架构创新为边缘设备提供了高性能与低资源消耗的最优解。

核心亮点:三大技术突破重构效率边界

1. 结构化自适应算子架构

LFM2首创动态权重更新机制,通过非线性微分方程建模实现参数效率跃升。在日英翻译任务中,该架构使1.2B模型达到以下关键指标:

- BLEU值:新闻领域42.3(接近GPT-4o的43.7)

- 术语准确率:技术文档翻译达91.7%

- 响应延迟:本地运行平均18ms(仅为云端API的1/13)

这种设计特别优化了边缘设备的内存占用,在Samsung Galaxy S24上运行时内存峰值仅890MB,可流畅支持多轮对话而不触发手机发热降频。

2. 混合注意力-卷积架构

模型创新性融合10个双门控短程LIV卷积块与6个分组查询注意力(GQA)块,形成"局部+全局"双处理路径:

- 卷积模块:处理语法结构、局部语义等短程依赖

- 注意力模块:捕捉长程上下文关联(支持32K tokens)

从图中可以看出,LFM2-1.2B在CPU环境下的prompt处理速度(prefill)达到18 tokens/秒,较Qwen3-0.6B(9 tokens/秒)提升2倍,满足智能座舱、工业巡检等场景的实时交互需求。右侧图表则展示了不同上下文长度下的文本生成速度对比,进一步验证了其高效性能。

3. 全栈部署兼容性

支持CPU/GPU/NPU多硬件平台,提供完整工具链:

- 部署框架:transformers/llama.cpp(vLLM支持即将推出)

- 量化方案:INT4/INT8量化压缩,精度损失<2%

- 开发工具:提供SFT/DPO微调Colab notebook,支持企业定制

行业影响与趋势

Liquid AI近期宣布与Shopify达成多年合作伙伴关系,将亚20毫秒响应的基础模型引入核心商业体验。根据合作协议,Shopify将在其平台上部署LFM2系列模型,优化搜索功能和推荐系统。Shopify CTO Mikhail Parakhin评价道:"没有其他模型能在实际工作负载中实现亚20毫秒的推理性能。Liquid的架构在不牺牲质量的前提下实现了高效,在某些用例中,参数减少约50%的模型性能超过了Alibaba Qwen和Google Gemma,同时运行速度快2-10倍。"

Liquid AI已筹集近5000万美元资金,并在2024年12月宣布完成2.5亿美元的A轮融资,由芯片巨头AMD领投。公司正致力于优化LFM模型,使LFM能在NVIDIA、AMD、Apple等公司的特定硬件上发挥最佳性能。

行业应用将呈现垂直深化与横向拓展并行的格局:

- 消费电子领域:实时翻译耳机(18ms延迟实现同声传译)、隐私相册助手(本地完成图片内容分类与检索)

- 智能汽车领域:语音指令响应速度从300ms降至89ms,系统功耗降低至GPU方案的1/5

- 工业互联网领域:通过振动传感器数据实时分析设备状态,故障预警准确率提升至92%

总结

LFM2-1.2B-GGUF通过架构创新和全栈优化,成功打破了边缘AI的"尺寸-性能"魔咒。其核心价值不仅在于技术突破,更在于降低了边缘AI的部署门槛——开发者可通过简单命令在本地部署高性能模型,无需依赖昂贵的云端资源。

Liquid AI CEO Ramin Hasani指出:"LFM2证明小模型完全能在特定场景超越大模型。未来两年,10亿参数以下的专用模型将占据边缘AI市场70%份额。"随着开源生态的完善,我们或将迎来"小模型大爆发"的新范式。

对于企业而言,现在正是布局边缘AI战略的最佳窗口期,而LFM2系列无疑提供了极具竞争力的技术基座。要体验LFM2-1.2B模型,可通过GitCode仓库获取:https://gitcode.com/hf_mirrors/LiquidAI/LFM2-1.2B-GGUF,开启边缘AI应用开发的新篇章。

【免费下载链接】LFM2-1.2B-GGUF

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考