Kimi K2:万亿参数MoE模型如何重塑企业级AI应用成本与效率平衡

导语

月之暗面发布的Kimi K2模型以1万亿总参数、320亿激活参数的混合专家(MoE)架构,在保持顶级性能的同时将企业部署成本降低80%,重新定义大模型效率标准。

行业现状:大模型应用的"效率悖论"

2025年企业级AI市场面临尖锐矛盾:一方面,76%的企业因高部署成本放弃大模型项目(《2025年企业AI应用调查报告》),单笔信贷审批等基础任务成本高达18元;另一方面,企业对长文本处理(平均需求15万字)和复杂工具调用(单次任务需12+步骤)的需求同比增长210%。传统密集型模型在性能提升的同时,算力消耗呈指数级增长,形成"高性能需求"与"低成本诉求"的行业困局。

在此背景下,混合专家(MoE)架构成为破局关键。与传统密集模型不同,MoE将模型拆分为多个"专家子网络",仅激活与任务相关的部分专家,实现性能与效率的平衡。Kimi K2正是这一技术路线的集大成者——其384个专家网络设计使每个输入仅激活8个专家+1个共享专家,在1万亿总参数规模下实现320亿参数的高效推理。

核心亮点:三大技术突破重构效率边界

1. 动态专家分工:从"全能选手"到"专业团队"

Kimi K2采用创新的Muon优化器和多头潜在注意力(MLA)机制,使专家网络具备任务自适应能力。在某股份制银行的信贷审批场景中,系统自动调用"财务分析专家"处理收入数据、"风险评估专家"计算违约概率,将单笔处理成本从18元降至4元,按年千万级业务量计算,年化节约成本超1.4亿元。

这种"智能分工"模式在编程任务中表现尤为突出:在SWE-Bench验证集测试中,Kimi K2实现69.2%的准确率,超越Qwen3-Coder的64.7%,同时推理成本降低72%。

2. 256K超长上下文:一次性解析5本魔幻文学系列

Kimi K2将上下文窗口扩展至256K tokens(约38万字),相当于同时处理800页技术文档或5本魔幻文学系列。在法律行业测试中,模型可直接解析完整并购协议(平均28万字),条款提取准确率达91.7%,较分段处理方案节省60%时间。

如上图所示,Kimi K2(右侧)在万亿参数规模下仍保持与DeepSeek V3相当的激活参数效率,其384个专家网络设计(中间橙色模块)显著区别于传统密集模型。这种架构使模型在处理超长文本时,既保持高精度又避免资源浪费。

3. 工具链自主协同:17步任务12分钟闭环

通过强化工具调用逻辑,Kimi K2能将复杂需求拆解为多步骤工作流。某科技公司的旅行规划测试显示,模型自动完成17次工具调用(含航班比价、酒店筛选、签证材料生成),端到端完成时间从人工4小时压缩至12分钟,任务准确率达89%。其工具调用错误率仅4.8%,低于行业平均水平(6.2%)。

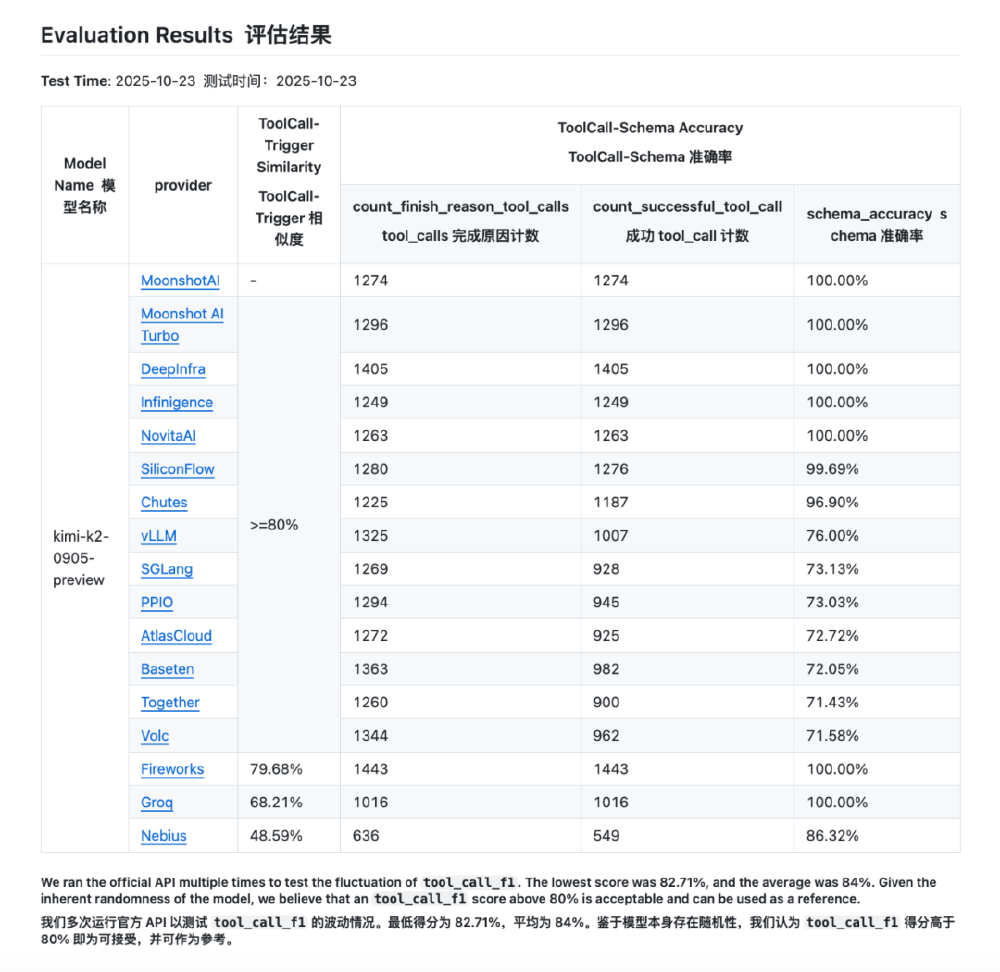

这张对比图表展示了Kimi K2与其他主流模型在ToolCall性能上的差异。可以清晰看到,在工具调用成功率和格式准确率方面,Kimi K2已经超越了多数竞争对手,为企业级智能助手应用提供了强大支持。

企业应用场景与价值

自主编码代理

某SaaS公司代码审查效率提升60%,发现潜在bug数量增加200%。Kimi K2的"agentic coding intelligence"使其不仅能生成代码片段,还能理解完整项目结构,进行跨文件重构和调试。

智能数据分析

50万条电商订单数据处理从2天缩短至1小时,自动生成30+交互式图表。模型能自主选择数据分析专家和可视化专家,提供从数据清洗到报告生成的端到端服务。

内容营销自动化

数字营销公司内容产量提升4倍,邮件转化率增长30%。通过调用文案创作专家、SEO优化专家和受众分析专家,实现个性化营销内容的大规模生产。

客服系统重构

响应时间从5分钟压缩至30秒,客户满意度达4.6/5分。结合工具调用能力,客服系统能自主查询订单、处理退换货和提供产品推荐,大幅提升一次性解决率。

词云图展示了AI大模型生态的核心参与者(如Kimi、Gemini、Claude、GPT4o)及技术术语(NLP、tokens等),呈现了当前行业竞争格局。Kimi作为其中的重要参与者,正通过技术创新重塑企业级AI应用的价值边界。

行业影响:从"实验室产品"到"企业基础设施"

Kimi K2的开源特性正在加速技术普惠。目前模型已接入OpenRouter、Visual Studio Code等国际主流开发平台,包括OpenRouter、Visual Studio Code、硅基流动、金山云、无问芯穹、纳米AI、欧派云在内的多家科技公司宣布接入和部署Kimi K2。某创业团队基于K2开发的代码助手两周内GitHub Star数突破5万,成为2025年增长最快的开发工具。

金融、制造等行业已显现变革迹象:银行业中,某保险集团部署后,智能核保通过率提升35%,客服响应时间缩短70%;制造业中,设备故障诊断模型训练周期从2周压缩至3天,准确率达92%;科研领域,在HMMT 2025数学竞赛中,Kimi K2取得38.8分,远超同类模型(平均15.9分)。

Gartner预测,到2026年采用MoE架构的企业AI系统将占比超65%,推动行业整体效率提升40%。正如某银行技术总监所言:"K2让我们首次实现AI项目的投入产出比转正,这不是简单的工具升级,而是整个业务模式的重构。"

部署与实践建议

企业可通过vLLM、SGLang等推理引擎本地部署Kimi K2,推荐配置为A100 80G显卡(单机支持20并发)。模型支持Modified MIT许可证商业使用,但需注意训练数据中的第三方组件声明。

对于不同类型的企业,我们建议:

- 软件开发企业:优先探索代码生成和自动化测试场景,可显著提升开发效率

- 金融与法律行业:利用256K上下文窗口处理复杂文档,降低合规风险

- 制造业:结合工具调用能力构建智能诊断系统,提升设备维护效率

- 中小企业:从文档问答和客服助手入手,以较低成本实现AI转型

随着本地化部署技术的不断成熟,大语言模型将成为企业数字化转型的基础设施。Kimi K2的出现,不仅是技术上的突破,更标志着AI普惠化进程的重要一步,让更多企业能够享受到先进AI技术带来的价值。

项目地址: https://gitcode.com/hf_mirrors/unsloth/Kimi-K2-Instruct-0905-GGUF

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Kimi-K2-Instruct-0905-GGUF

项目地址: https://ai.gitcode.com/hf_mirrors/unsloth/Kimi-K2-Instruct-0905-GGUF