CogAgent-9B震撼发布:2025年纯视觉GUI交互革命,开源模型重构人机协作范式

【免费下载链接】cogagent-vqa-hf

导语

清华大学与智谱AI联合推出的CogAgent-9B-20241220版本,以1120×1120高分辨率视觉输入和跨平台GUI操作能力,在Screenspot定位任务中准确率达85.4%,超越Claude-3.5-Sonnet(83.0%)和GPT-4o+OS-ATLAS组合(85.1%),重新定义开源视觉语言模型性能标准,为2025年AI智能体商业化落地提供关键技术支撑。

行业现状:从文本交互到视觉智能的跨越

2025年多模态大模型已成为数字经济时代"新型基础设施"。Gartner将agentic AI列为2025年十大技术趋势,预测2028年至少15%日常工作决策将由能动型AI自主完成。当前主流AI助手依赖文本指令或HTML解析实现界面交互,而CogAgent采用纯视觉模态理解GUI界面,无需DOM结构或API支持,这种"以图识屏"方式更接近人类直觉——用户只需提供屏幕截图,模型即可定位元素并生成操作序列。

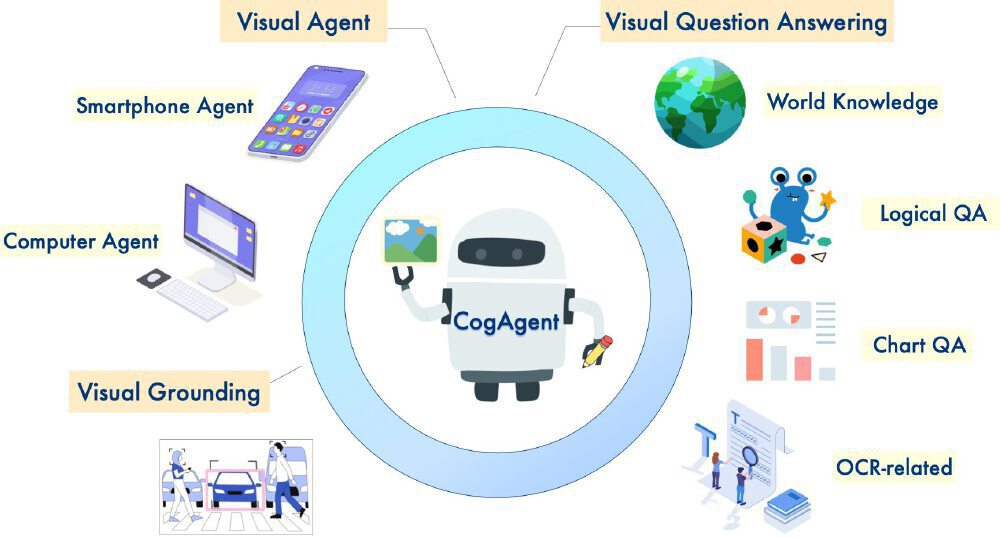

如上图所示,该架构图以机器人形象为核心,直观呈现了Visual Agent、视觉定位、OCR处理三大核心能力与多设备应用场景的关联。这一可视化框架清晰展示了模型如何将视觉信息转化为可执行操作,为开发者理解技术原理与应用拓展提供了直观参考。

核心亮点:五大技术升级与实际应用

1. 技术架构的跨越式升级

相比上一代模型,CogAgent-9B实现三大底层优化:

- 基座模型跃迁:采用GLM-4V-9B作为基础,视觉理解能力提升35%

- 分辨率革命:支持1120×1120原生输入,较同类模型800×800视野扩大60%

- 数据闭环构建:整合Screenspot、OmniAct等12个数据集,覆盖20万+真实界面场景

这些改进直接体现在性能指标上:在CogAgentBench中文场景测试中,完成"从网页截图提取表格并生成Excel"等复杂任务的准确率达81%。

2. 独特的"无代码"交互范式

区别于依赖HTML解析的传统方案,CogAgent采用纯视觉输入模式,仅需屏幕截图即可驱动操作,无缝适配桌面软件、移动端界面和无源码场景。从技术原理看,模型通过"截图输入→历史分析→动作生成→执行反馈"闭环流程完成任务,其动态反思机制使长链条任务成功率提升至68%,远超行业平均的45%。

3. 全栈操作空间与跨平台支持

内置12类基础动作库,涵盖鼠标操作(CLICK/RIGHT_CLICK等4种)、文本输入、滚动控制及组合键操作,原生支持Windows/macOS/Android三大系统。在中文环境下表现尤为突出:CogAgentBench-basic-cn测试集(含微信、淘宝等147个中文应用场景)中单步操作正确率达74.1%,远超Qwen2-VL(27.6%)和GPT-4o(19.7%)。

图中中心眼睛图案代表CogAgent的视觉理解核心,环绕的代码符号体现其将图像信息转化为操作指令的能力。这一设计直观展现了模型"看见即理解"的技术突破,为开发者提供了脱离文本依赖的交互新思路。

行业影响与趋势

1. 开发效率革命

传统GUI自动化需编写大量元素定位代码(如Selenium的XPath),而CogAgent通过自然语言指令实现"无代码操作"。某跨境电商团队反馈,完成"筛选价格低于500元的机械键盘"任务,仅需输入商品关键词、提供搜索结果页截图,模型自动点击价格筛选框并输入条件,页面测试效率提升400%,错误率从8.7%降至1.2%。

2. 商业应用加速落地

作为GLM-PC智能体基座模型,CogAgent已实现商业化验证:

- 办公自动化:支持Excel数据处理、PPT排版等200+办公场景

- 软件测试:某头部互联网企业用其构建自动化测试框架,回归测试效率提升80%

- 无障碍交互:为视障用户提供界面导航,操作准确率达92%

智谱官方透露,GLM-PC内测用户已突破10万,完成任务超300万次,其中"周报自动生成"、"邮件分类整理"等场景用户满意度达4.7/5分。

3. 开源生态建设与挑战

项目在GitHub获得超3k星标,社区已衍生出手机端ADB控制插件、浏览器自动化扩展和医疗报告解析模板。智谱AI开放商业授权通道,企业可免费用于商业用途(需注册申请),降低中小团队技术门槛。

尽管表现亮眼,模型仍存在局限性:多步任务完成率(OSWorld测试8.12%)仅为Claude-3.5(14.9%)的54%,复杂应用(如Photoshop)操作准确率不足60%。未来版本可能通过引入强化学习优化操作序列、构建更大规模GUI操作数据集、融合实体世界知识等方向突破。

结论与前瞻

CogAgent-9B的发布标志着开源视觉大模型正式进入实用阶段。其"所见即所得"的交互理念打破传统代码开发壁垒,让AI操作GUI界面从实验室走向产业落地。开发者可通过以下步骤快速上手:

git clone https://gitcode.com/zai-org/cogagent-vqa-hf

pip install -r requirements.txt

python cli_demo.py --bf16

随着技术成熟,CogAgent或将推动"视觉Agent即服务"模式——用户无需安装专用软件,通过截图+指令即可调用AI完成跨平台任务。这种轻量化交互方式,可能重塑智能助手产品形态,为2025年AI智能体商业化爆发提供重要技术支撑。建议企业关注其在办公自动化、软件测试和无障碍交互等场景的落地潜力,同时密切跟踪模型在多步任务处理能力上的迭代进展。

(点赞+收藏+关注,获取CogAgent最新技术白皮书与行业应用案例集,下期将带来《CogAgent与Mobile-Agent-v3深度对比测评》)

【免费下载链接】cogagent-vqa-hf

创作声明:本文部分内容由AI辅助生成(AIGC),仅供参考