文章目录

众所周知,Ceph集群可以向客户端提供对象存储服务(Object Storage)、块设备服务(Block Device)和文件系统服务(File System)。

本文将介绍搭建Ceph集群后如何使用块设备服务。使用 rbd 命令可以创建、查看、修改和删除块设备映像。您还可以使用它来克隆映像、创建快照、将映像回滚到快照、查看快照等。

要使用Ceph Block Device命令,首先必须要能访问正在运行的Ceph集群。

前言

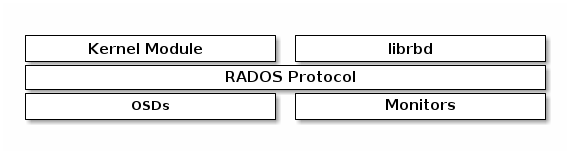

Kernel modules can use Linux page caching. For

librbd-based applications, Ceph supports RBD Caching.

内核模块可以使用Linux页面缓存。对于基于librbd的应用程序,Ceph支持RBD Caching。

要在Ceph中使用块设备服务,有如下几个步骤:

- 创建pool,关联RBD应用程序。

- 【可选】创建Ceph用户,授予对pool和image的权限,也可以直接使用admin。

- 创建image,个人理解image相当于在pool中开辟出的磁盘空间,可以像操作块设备一样,对其进行格式化、挂载等操作。

- 映射块设备。

- 格式化。

- 挂载使用。

创建pool

-

使用

ceph工具创建pool池ceph osd pool create { pool-name} [{ pg-num} [{ pgp-num}]] [replicated] [crush-rule-name] [expected-num-objects]版本差异

Ceph reef和Ceph nautilus:ceph osd pool create { pool-name} { pg-num} [{ pgp-num}] [replicated] [crush-rule-name] [expected-num-objects]在nautilus版本中,

pg_num是必须的,而在最新的reef版本中是可选的。

本文详细介绍了如何在Ceph集群中使用rbd命令管理块设备,包括创建pool和image,设置用户权限,操作image(如调整大小、删除和恢复),以及映射、格式化和挂载image的过程。

本文详细介绍了如何在Ceph集群中使用rbd命令管理块设备,包括创建pool和image,设置用户权限,操作image(如调整大小、删除和恢复),以及映射、格式化和挂载image的过程。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2223

2223

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?