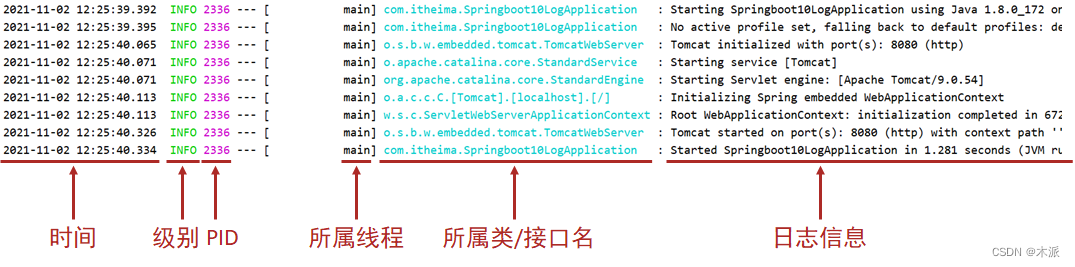

1.日志格式

日志的记录格式:

- PID: 进程ID,用于表明当前操作所处的进程,当多服务同时记录日志时,该值可用于协助程序员调试程序

- 所属类/接口名: 当前显示信息为SpringBoot重写后的信息,名称过长时,简化包名书写为首字母,甚至直接删除

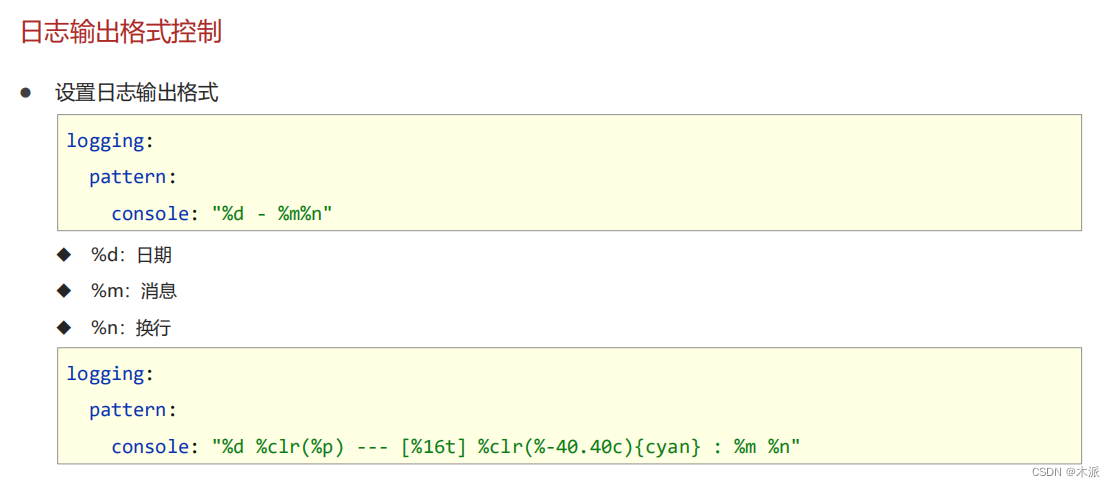

logging:

pattern:

console: "%d %clr(%p) --- [%16t] %clr(%-40.40c){cyan} : %m %n"

2.日志文件

- 设置日志文件:

logging:

file:

name: server.log

- 日志文件详细配置:

logging:

logback:

rollingpolicy:

max-file-size: 3KB

file-name-pattern: server.%d{yyyy-MM-dd}.%i.log

文章介绍了日志记录的格式,包括PID用于标识进程,以及SpringBoot中自定义的日志显示方式。此外,还详细讨论了如何设置日志文件,如指定文件名为server.log,并详细配置了logback的rollingpolicy,限制每个日志文件的最大大小为3KB,且按照日期和序列号进行滚动存储。

文章介绍了日志记录的格式,包括PID用于标识进程,以及SpringBoot中自定义的日志显示方式。此外,还详细讨论了如何设置日志文件,如指定文件名为server.log,并详细配置了logback的rollingpolicy,限制每个日志文件的最大大小为3KB,且按照日期和序列号进行滚动存储。

2209

2209

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?