LangChain 1.0 入门实战教学:Agent开发流程

LangChain 1.0 的重磅变化之一,就是引入了全新的 create_agent() API。至此,LangChain 的 Agent 不再只是简单的“模型调用器”,而是一个可感知上下文、具备决策与执行能力的 智能运行体(Intelligent Runtime Unit)。本章重点介绍 create_agent() API 的使用方法。更多由浅入深的优质内容,加入赋范空间 👉 赋范空间 免费领取。

一、 一体化 Agent API

在 LangChain 0.x 时代,Agent 系统经历了“碎片化”阶段:

create_react_agent→ 思维链推理;create_structured_chat_agent→ 结构化对话;create_tool_calling_agent→ 工具调用。

这种设计灵活但分散,导致学习曲线陡峭、模块难以复用。而在 1.0 版本中,所有入口被统一为 create_agent(),接下来我们通过一个简单的示例来演示:

# 1.导入相关库

from langchain.agents import create_agent

from langchain_deepseek import ChatDeepSeek

from langchain_community.tools.tavily_search import TavilySearchResults

# 2.导入模型和工具

web_search = TavilySearchResults(max_results=2)

model = ChatDeepSeek(model="deepseek-chat")

# 3.创建Agent

agent = create_agent(

model=model,

tools=[web_search],

system_prompt="你是一名多才多艺的智能助手,可以调用工具帮助用户解决问题。"

)

# 4.运行Agent获得结果

result = agent.invoke(

{"messages": [{"role": "user", "content": "请帮我查询2024年诺贝尔物理学奖得主是谁?"}]}

)

result['messages'][-1].content

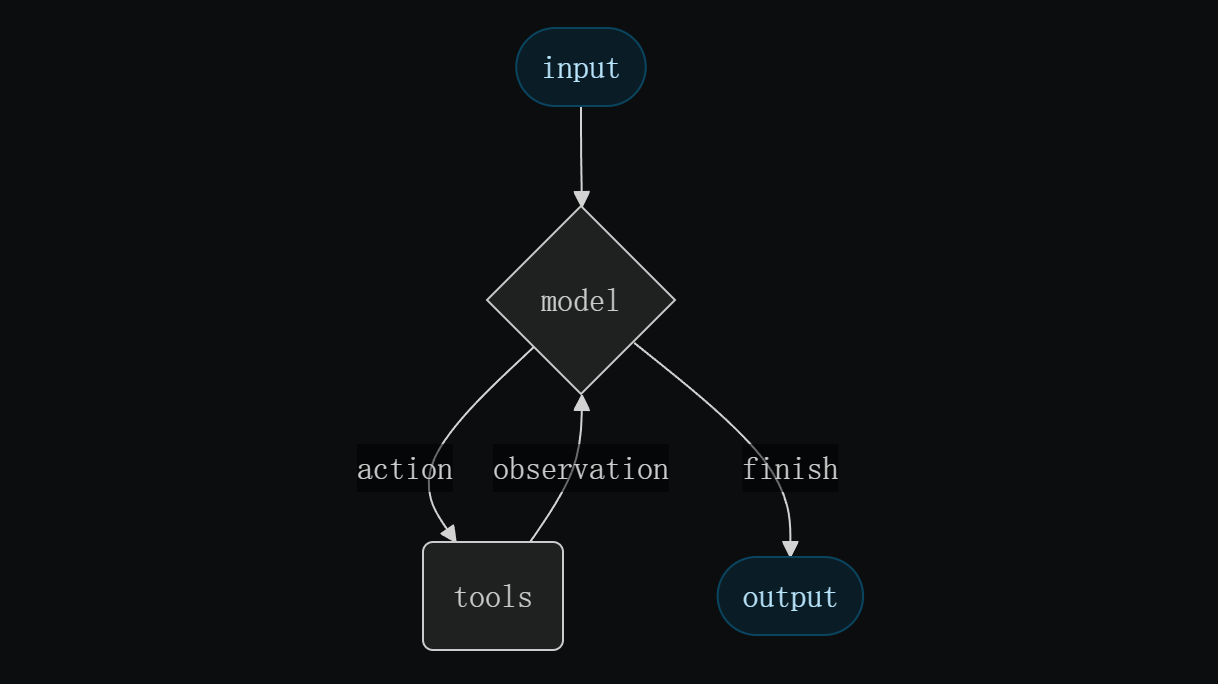

二、LangGraph 驱动的 Agent Runtime

LangChain 1.0 将 LangGraph 下沉为底层执行引擎。换句话说,通过 create_agent API 创建的每个 Agent 的生命周期、每次模型调用、每个工具执行,都是 LangGraph 图中的一个节点或边。

🚀 统一架构的优势

- 接口统一,降低心智负担:无论是工具型、规划型还是对话型 Agent共用同一 API 创建。

- 跨生态兼容性强:与 LangServe、LangGraph甚至 OpenAI Responses API 都完全兼容。

- 中间件机制:允许通过装饰器在生命周期中插入自定义逻辑。如日志、速率限制、记忆压缩、内容重写等。使 Agent 具备可观察性与可管理性。

- 扩展性强:基于标准化状态流(State Graph)用户可以自由地扩展 Agent 行为而不破坏核心逻辑。

三、使用 create_agent 接入组件

LangChain 1.0 中 Agent 不再是简单的脚本,而是包含循环推理(Agent Loop)的智能体

在 create_agent() 的底层运行机制中,最重要的三个组件分别是:

-

模型(Model):负责理解任务与决策推理。它既可以是静态模型(固定不变),也可以是动态模型(根据上下文切换)。

-

工具(Tools):由模型选择调用不同工具来实现特定子任务,例如:联网搜索(web_search)、计算公式(calculate)、查询数据源(database_query)

-

中间件(Middleware):负责在模型调用前后拦截请求、修改参数、或动态调整模型选择逻辑,是 LangChain 1.0 的强大扩展机制。

模型调用示例

静态模型调用示例:

from langchain.agents import create_agent

agent = create_agent("deepseek:deepseek-chat", tools=tools)

或先实例化模型,然后再将实例化后的模型带入create_agent中创建Agent,这样可以进行更多的参数设置:

from langchain_deepseek import ChatDeepSeek

from langchain.agents import create_agent

model = ChatDeepSeek(

model="deepseek-chat",

temperature=0.1,

max_tokens=1000,

timeout=30

)

agent = create_agent(model, tools=tools)

动态模型(Dynamic Model)模式允许智能体在运行时切换模型,实现性能与成本优化,通过中间件@wrap_model_call装饰器实现。

加入 👉 赋范空间 免费领取完整 LangChain1.0 学习资料以及更多 Agent 开发课程

接入内置工具

LangChain 提供了丰富的内置工具库(搜索、数据库、Slack、Jira、文件系统等),可通过 langchain_community 快速接入。

- LangChain内置工具列表:https://python.langchain.com/docs/integrations/tools/

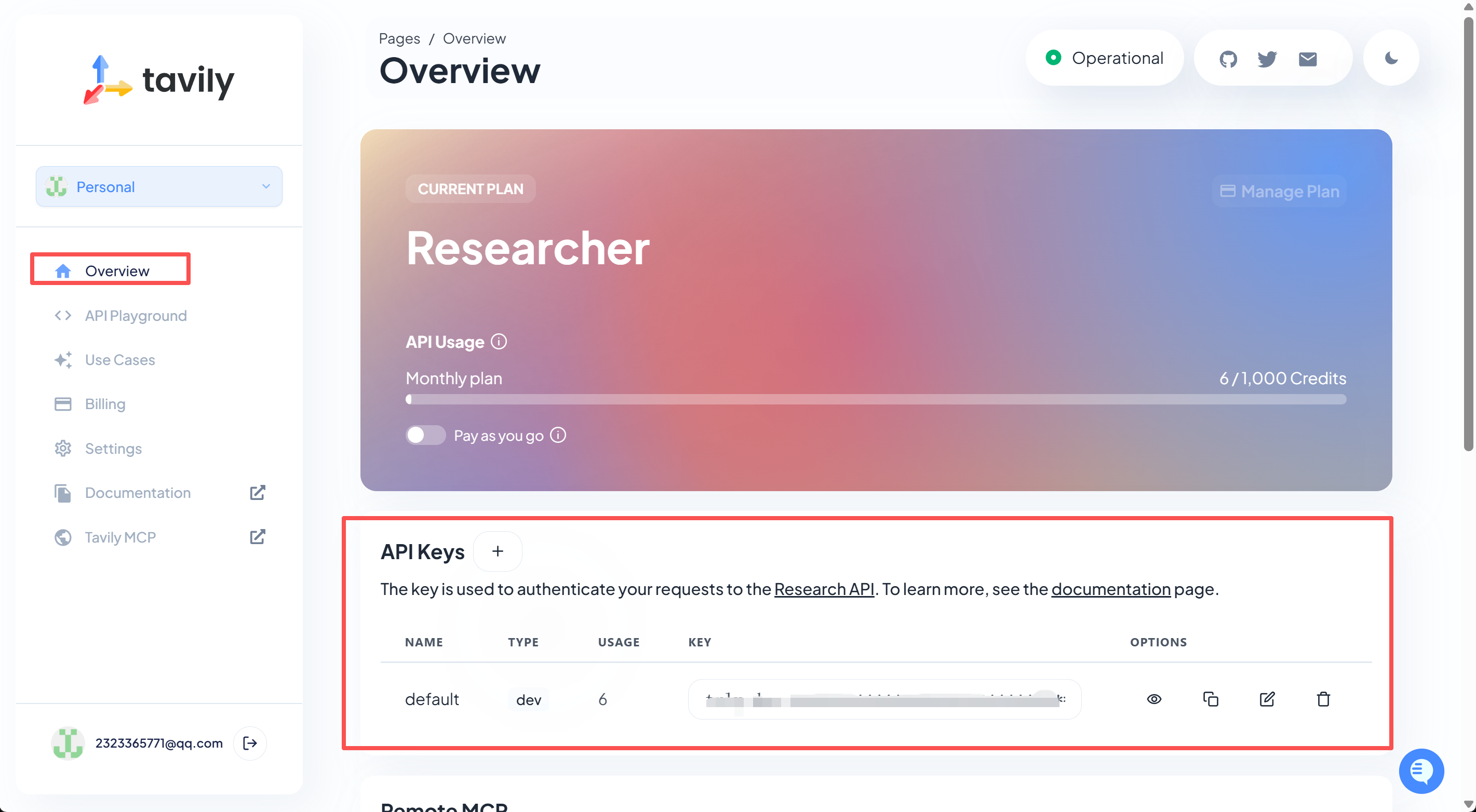

以其中内置的TavilySearchResults网络搜索工具为例,借助Tavily进行网络搜索和信息爬取。来介绍如何将内置工具接入create_agent中。

需要先在tavily官网注册并获得API-KEY(每月有免费额度):https://www.tavily.com/

然后将API-KEY写到本地.env中的TAVILY_API_KEY变量中。然后即可进行调用。

from langchain_community.tools.tavily_search import TavilySearchResults

web_search = TavilySearchResults(max_results=2)

web_search.invoke("请问截至目前,2025年诺贝尔奖颁发了几个?")

将工具直接带入create_agent中作为外部工具。

# 1.导入相关库

from langchain.agents import create_agent

from langchain_deepseek import ChatDeepSeek

from langchain_community.tools.tavily_search import TavilySearchResults

# 2.导入模型和工具

web_search = TavilySearchResults(max_results=2)

model = ChatDeepSeek(model="deepseek-chat")

# 3.创建Agent

agent = create_agent(

model=model,

tools=[web_search],

system_prompt="你是一名多才多艺的智能助手,可以调用工具帮助用户解决问题。"

)

# 4.运行Agent获得结果

result = agent.invoke(

{"messages": [{"role": "user", "content": "请帮我查询2024年诺贝尔物理学奖得主是谁?"}]}

)

result['messages'][-1].content

接入自定义工具与 ReAct 循环

智能体的核心在于能调用外部工具。以下示例创建一个可查询实时天气的自定义工具:

这里需要先登录openweather官网获取API-KEY:https://home.openweathermap.org/ ,然后将其写入.env中的OPENWEATHER_API_KEY变量中。

import requests, os, json

from langchain.tools import tool

def get_weather(loc):

"""

查询即时天气函数

:param loc: 必要参数,字符串类型,用于表示查询天气的具体城市名称,\

注意,中国的城市需要用对应城市的英文名称代替,例如如果需要查询北京市天气,则loc参数需要输入'Beijing';

:return:OpenWeather API查询即时天气的结果,具体URL请求地址为:https://api.openweathermap.org/data/2.5/weather\

返回结果对象类型为解析之后的JSON格式对象,并用字符串形式进行表示,其中包含了全部重要的天气信息

"""

# Step 1.构建请求

url = "https://api.openweathermap.org/data/2.5/weather"

# Step 2.设置查询参数

params = {

"q": loc,

"appid": os.getenv("OPENWEATHER_API_KEY"), # 输入API key

"units": "metric", # 使用摄氏度而不是华氏度

"lang":"zh_cn" # 输出语言为简体中文

}

# Step 3.发送GET请求

response = requests.get(url, params=params)

# Step 4.解析响应

data = response.json()

return json.dumps(data)

带入到create_agent中,创建一个简易的天气查询Agent:

# 1.导入相关库

from langchain.agents import create_agent

from langchain_deepseek import ChatDeepSeek

from langchain_community.tools.tavily_search import TavilySearchResults

# 2.导入模型

model = ChatDeepSeek(model="deepseek-chat")

# 3.创建Agent

agent = create_agent(

model=model,

tools=[get_weather],

system_prompt="你是一名多才多艺的智能助手,可以调用工具帮助用户解决问题。"

)

# 4.运行Agent获得结果

result = agent.invoke(

{"messages": [{"role": "user", "content": "请问北京今天天气如何?"}]}

)

result['messages'][-1].content

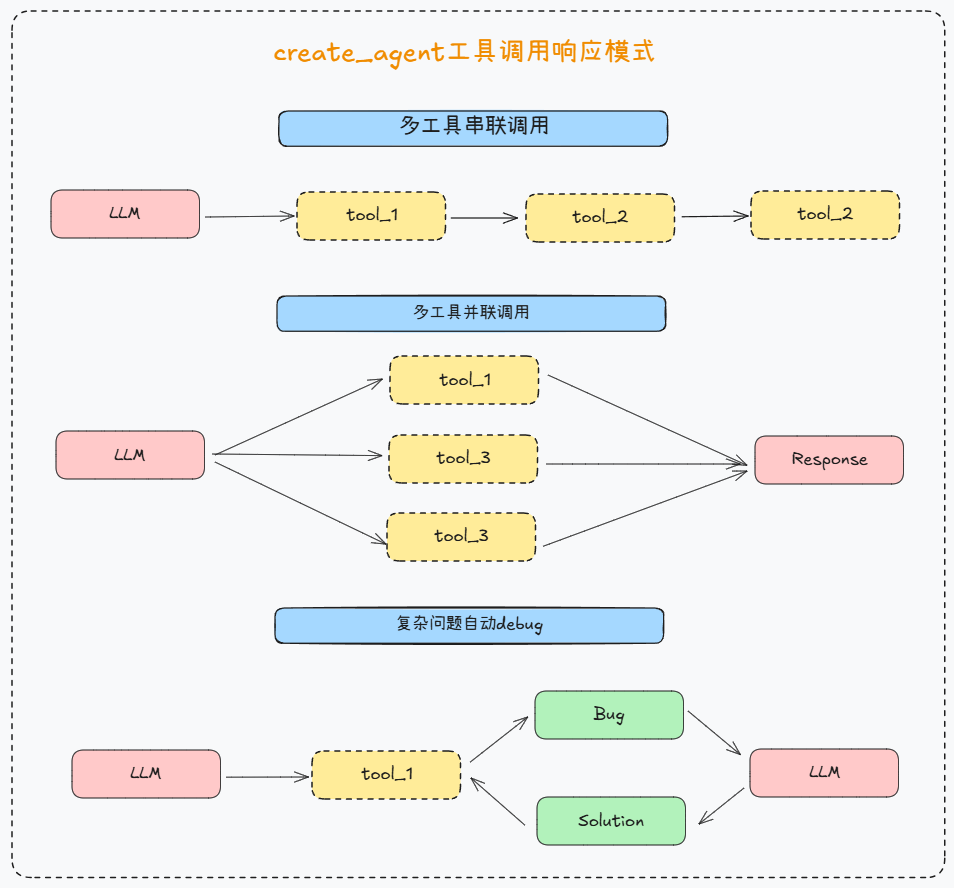

对于create_agent API来说,其工具调用的核心逻辑也是React循环工具调用,即可以在简短的推理步骤和有针对性的工具调用之间交替,并将得到的观察结果反馈到后续决策中,直到他们能够给出最终答案。并且具备如下特性:

- 按顺序调用多个工具(由单个提示触发)

- 适当时并行调用工具

- 根据先前结果进行动态工具选择

- 工具重试逻辑和错误处理

- 跨工具调用的状态持久性

并发调用示例:并发调用天气查询工具,分别查询杭州和南昌的天气

result = agent.invoke(

{"messages": [{"role": "user", "content": "请问今天杭州和南昌哪里更冷?"}]}

)

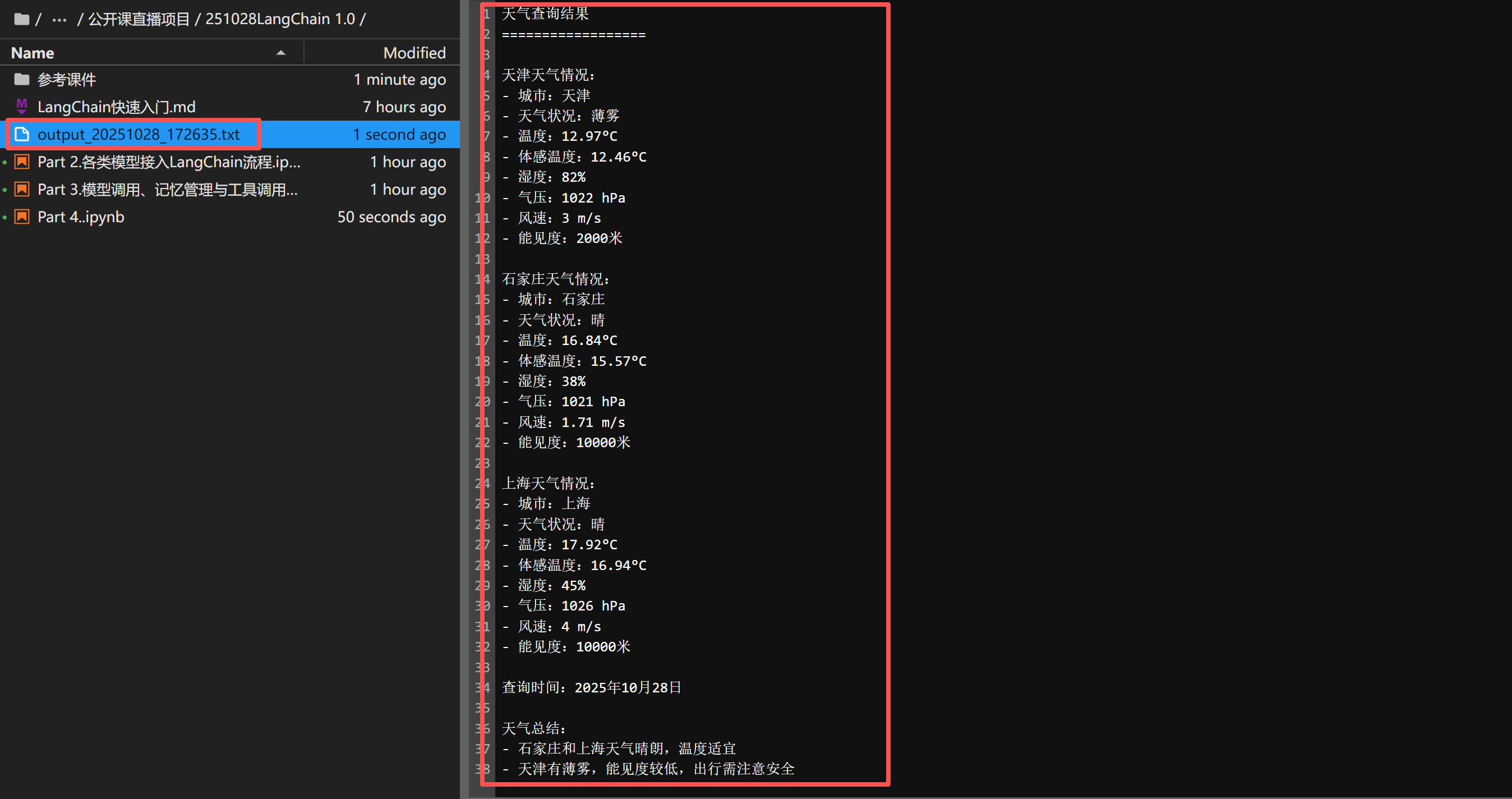

按顺序多步调用示例:先查询天气、然后写入到本地文件

import os

from datetime import datetime

@tool

def write_file(content: str) -> str:

"""

将指定内容写入本地文件。

:param content: 必要参数,字符串类型,用于表示需要写入文档的具体内容。

:return: 写入结果提示信息。

"""

try:

# ✅ 始终先定义文件名(防止未绑定变量)

timestamp = datetime.now().strftime("%Y%m%d_%H%M%S")

filename = f"output_{timestamp}.txt"

# 写入文件

with open(filename, "w", encoding="utf-8") as f:

f.write(content)

abs_path = os.path.abspath(filename)

return f"✅ 已成功写入本地文件:{abs_path}"

except Exception as e:

return f"❌ 文件写入失败:{str(e)}"

agent = create_agent(

model=model,

tools=[get_weather, write_file],

system_prompt="你是一名多才多艺的智能助手,可以调用工具帮助用户解决问题。"

)

result = agent.invoke(

{"messages": [{"role": "user", "content": "请帮我查询天津、石家庄、上海等地天气,并写入本地文件。"}]}

)

result['messages'][-1].content

如果出现调用工具报错,一般会尝试2-3次之后停止尝试。此外,关于调用工具报错信息的输出格式、以及控制报错响应流程,都可以使用中间件来完成。

create_agent记忆管理

在实际进行Agent开发时,智能体记忆管理至关重要。

from langgraph.checkpoint.memory import InMemorySaver

checkpointer = InMemorySaver()

tools = [get_weather]

agent = create_agent(model=model,

tools=tools,

checkpointer=checkpointer)

config = {

"configurable": {

"thread_id": "1"

}

}

response = agent.invoke(

{"messages": [{"role": "user", "content": "你好,我叫陈明,好久不见!"}]},

config

)

response['messages'][-1].content

此时记忆就自动保存在当前Agent和线程中

当我们再次进行对话时,直接带入线程ID,即可带入此前对话记忆:

response = agent.invoke(

{"messages": [{"role": "user", "content": "你好,请问你还记得我叫什么名字么?"}]},

config

)

response['messages'][-1].content

而如果更新线程ID,则会重新开启对话:

config2 = {

"configurable": {

"thread_id": "2"

}

}

总结

LangChain 1.0 的 Agent 框架代表了 AI 编程方式的重大演进:

- 从“模型调用” → “智能运行体”;

- 从“函数封装” → “状态图驱动”;

- 从“单轮调用” → “多步决策与工具调度”。

其底层的 LangGraph 架构与中间件机制,使得 Agent 真正具备了可扩展、可部署、可观测的能力,成为通往 生产级智能体系统 的关键桥梁。

如果你希望系统学习 Agent 开发全流程,欢迎加入 👉 赋范空间 领取学习资料

1253

1253

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?