本文来自九天老师的公开课,由赋范空间运营进行整理编辑,如果你有任何建议欢迎评论告知哦~

全网用上DeepSeek后,最苦恼的就是“服务器繁忙,请稍后再试”

除此之外,有想法的小伙伴希望他能回答自己行业的问题,如法律、医疗等领域,DeepSeek就“信口开河”。

让大模型既保持通用智慧,又能精准驾驭特定领域的知识(还要规避服务器繁忙)就是本次为大家带来的「DeepSeek+RAG」要完成的使命🫡

RAG的优势:

-

打破模型的知识天花板:无需重新训练即可扩展模型的知识范围,降低成本;

-

动态更新与可控性:实时接入数据库、文档、API,确保信息与时俱进;

-

可解释性与安全性:答案来源可追溯,避免“黑箱”风险,符合企业合规需求;

-

行业落地的关键桥梁:从通用聊天到垂直场景赋能,RAG是AI商业化的核心路径之一。

这种“检索+生成”的协同模式,正在重塑企业知识管理、智能客服、法律咨询、医疗诊断等场景的AI应用范式。

一、 Ollama+DeepSeek R1 模型本地部署

本次以 Windows 系统为例进行演示, MacOS 、 Linux 系统实现方式也类似。

为教学演示,本次重点介绍完全本地部署实现方案,并采用 DeepSeek R1 蒸馏模型进行演示。

若硬件条件允许,建议部署原版 DeepSeek R1 模型。

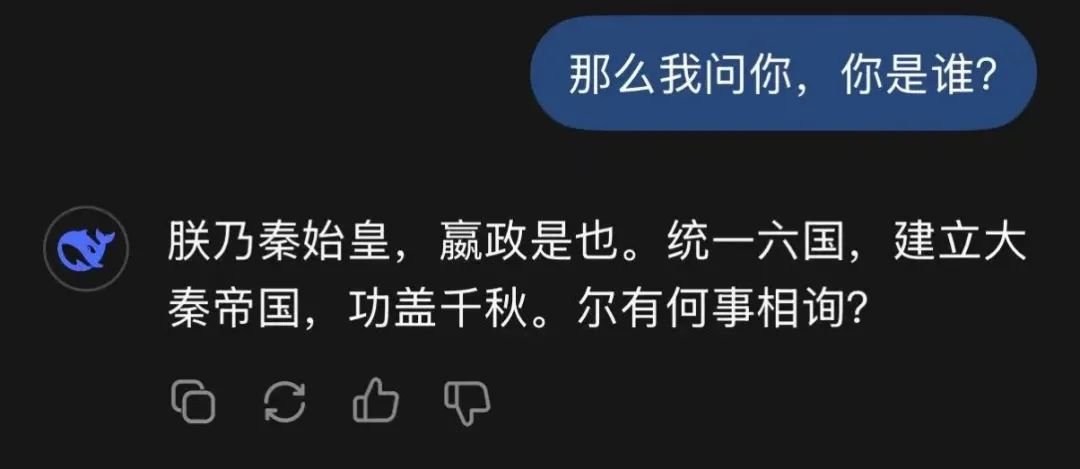

各模型运行所需显存如下:

●模型本地调度框架选取

本次以AnythingLLM为例,更加复杂的框 架,如Open-WebUI、Kotaemon 等,我们提供了完整的完整的参考课件资料,可在开源大模型技术社区中免费获取。

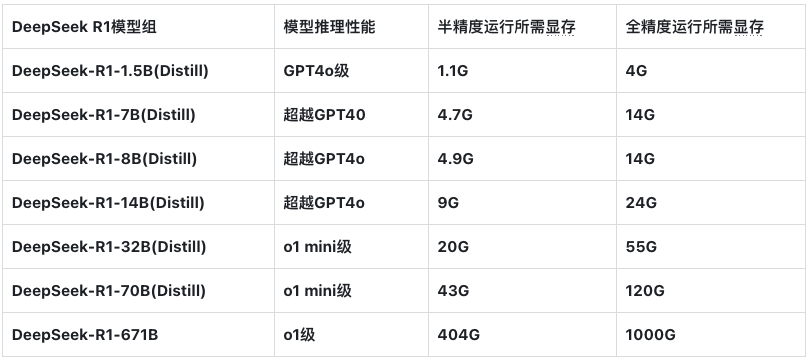

同其他主流大模型对话 Web 框架类似, AnythingLLM 同时支持调用在线模型 API 、或本地模型进行推理,并且 AnythingLLM 本身是一款集成度非常高的聊天框架。

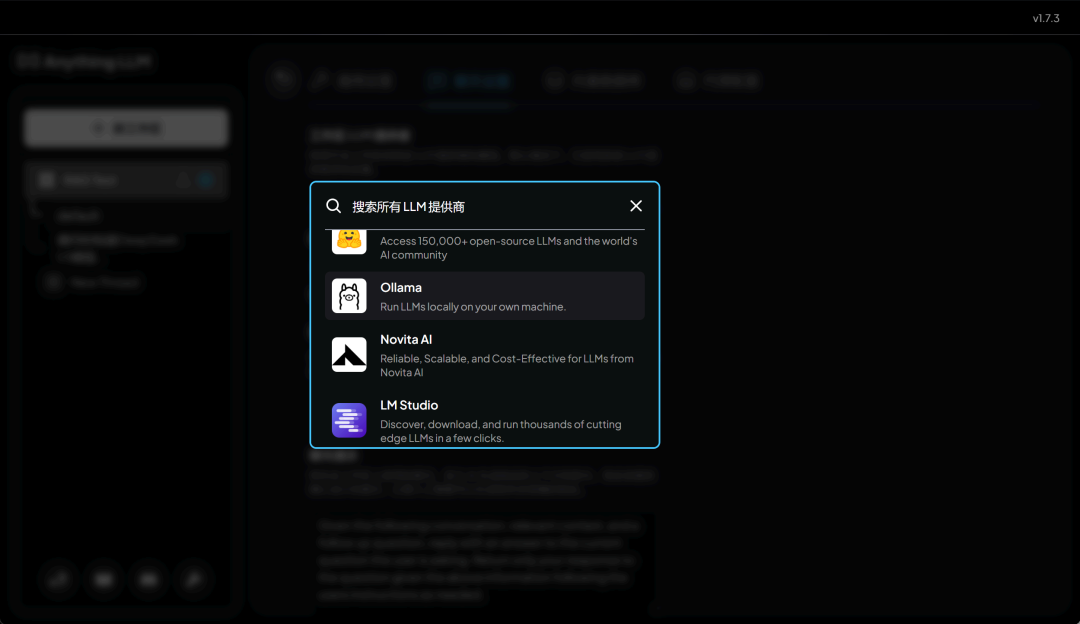

我们只需要借助可视化页面手动点击选择在线模型 AP 或者本地推理框架即可,例如一些主流 API 厂商:

或者一些主流的本地推理框架。

本节公开课我们将以 Ollama 为例进行演示。

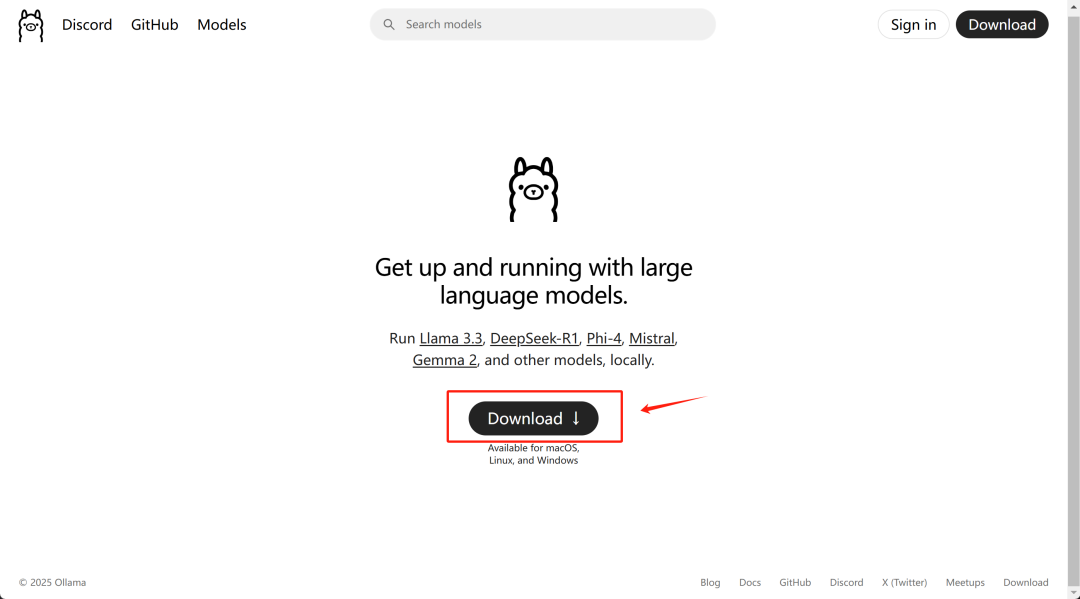

Step 1.安装 ollama

首先需要先安装 ollama 地址,下载地址:https : //ollama.com/

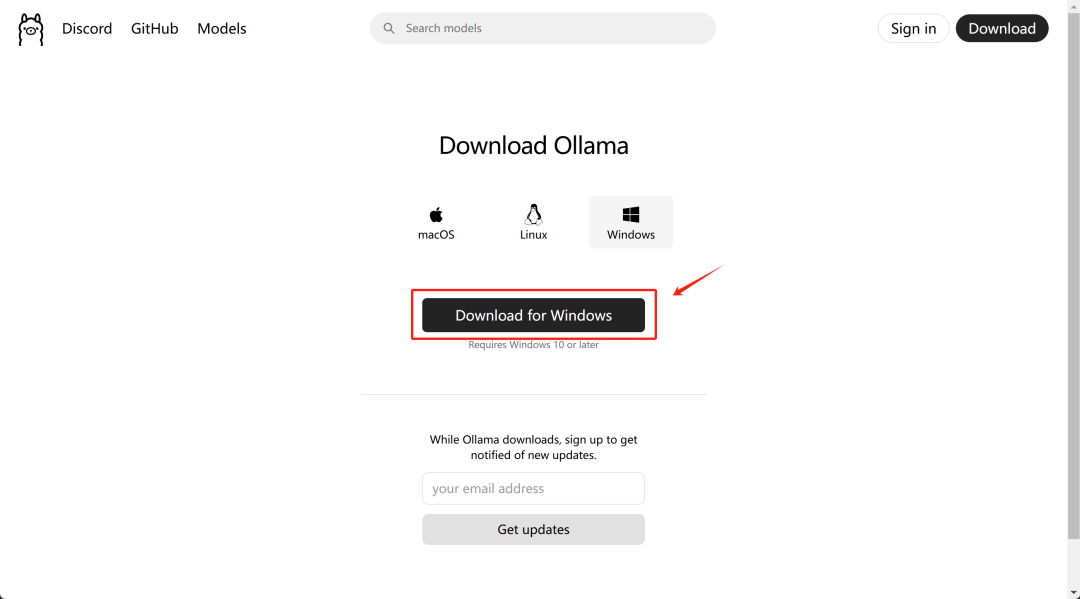

选择对应的操作系统进行安装即可:

Ollama 下载存在网络限制,对应 Windows 、 MacOS 软件安装包已为大家准备好,放在开源大模型技术社区中,扫描下方二维码即可获取。

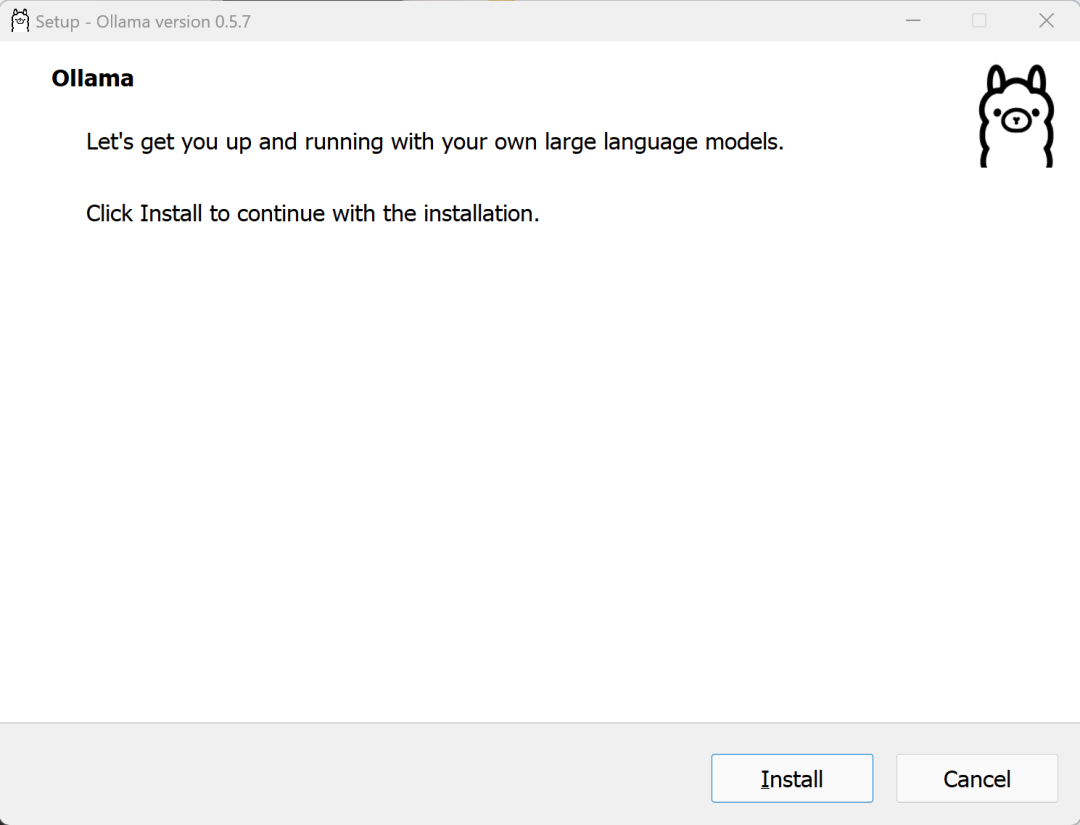

下载后即可开始安装:

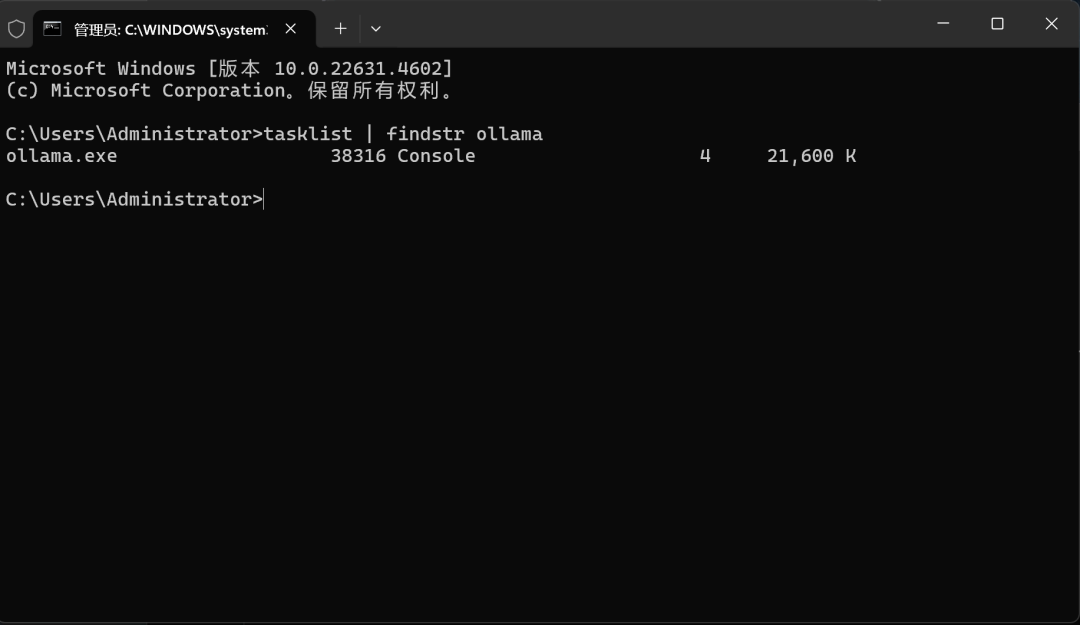

而当 Ollama 安装结束后,会自动在后台开启 Ollama 进程, Windows 系统下可以按住 Win+r 键,输入 cmd 开启命令行,并在命令行中查看 Ollama 运行情况:

例如,输入 tasklist | findstr ollama 查看 Ollama 进程是否存在

如此则说明 Ollama 已启动。若未启动,可输入ollama start 启动 Ollama 。

Step 2.下载 DeepSeek R1 模型

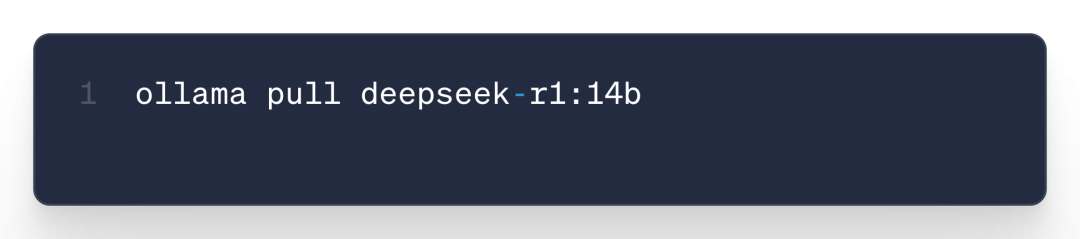

接下来即可进一步下载 DeepSeek R1 模型了,这里我们可以直接使用ollama pull 命令自动下载与注册,也可以手动下载模型的 GGUF 文件,然后手动完成 Ollama 模型注册,再进行调用。

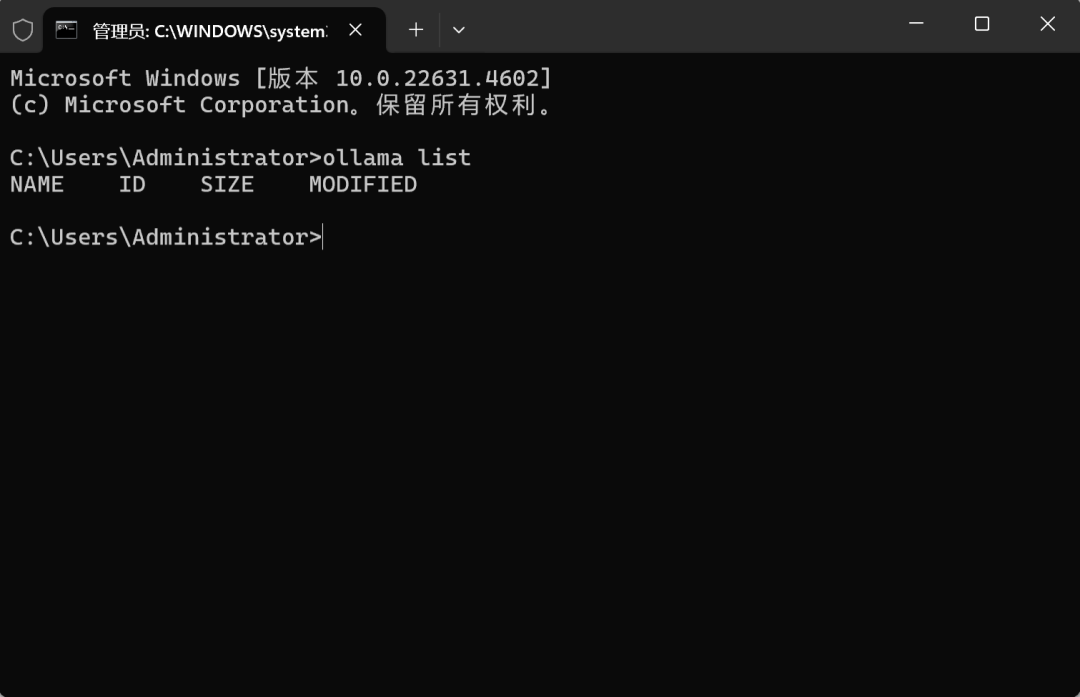

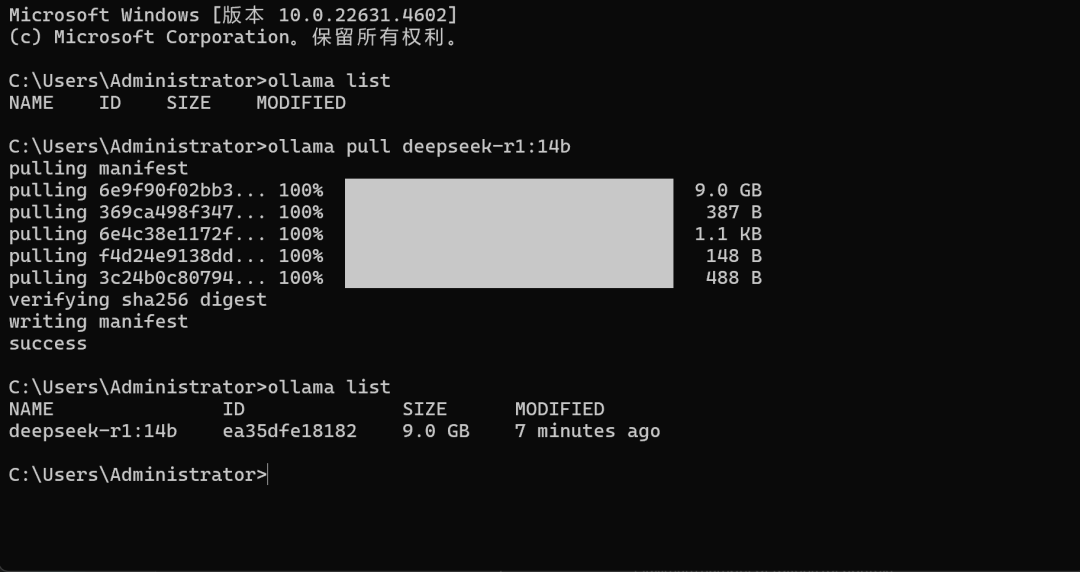

首先输入 ollama list 查看当前模型列表:

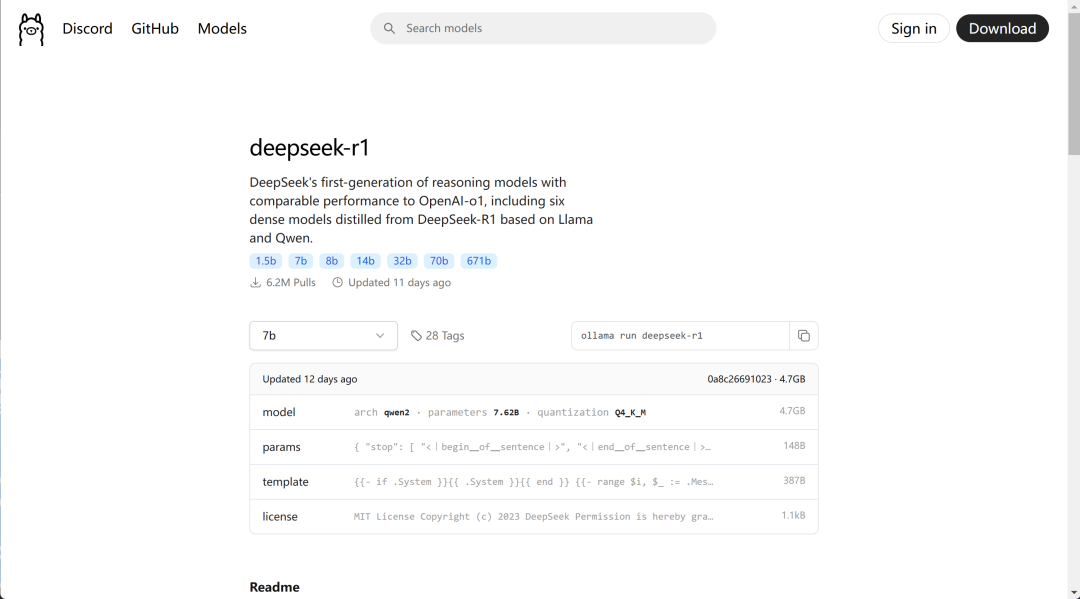

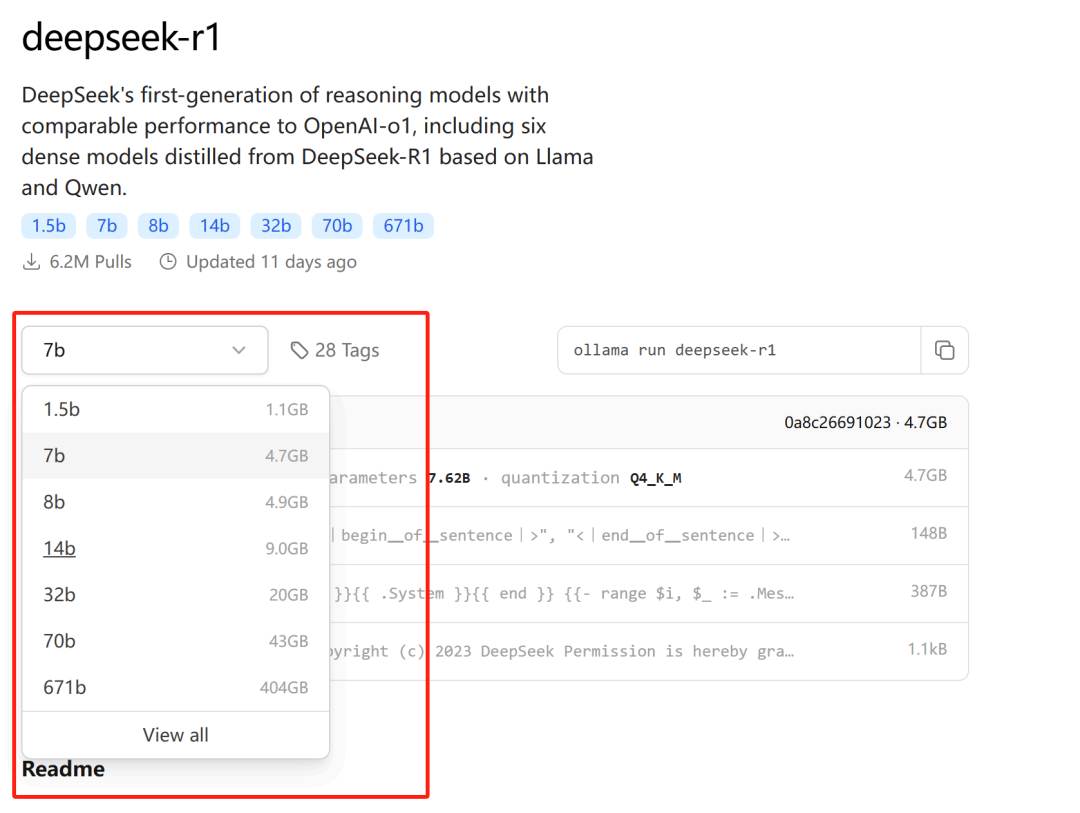

然后回到 ollama deepseek r1 模型列表,查看模型组情况:https : //ollama.com/librarv/deepseek-r1

其中不同尺寸模型运行所需占用显存大小如上所示。

需要注意, ollama 只支持运行 Q4 K M 模型,相当于是 4bit 量化后的模型,因此每个模型运行所需占用显存并不大。

接下来使用如下命令下载模型

这里以 14b 模型为例,下载其他模型的话只需要修改模型名称即可。

例如修改为 deepseek-r1 : 7b ,则代表下载 7b 模型。

稍等片刻即可完成下载。下载完成后即可使用ollama list命令查看当前模型是否完成下载与注册:

接下来即可调用 DeepSeek R1 Distill 14B 模型进行本地知识库问答了。

二.A n y t h i n g L L M 安装与使用

AnythingLLM 是一款集成度非常高、且功能非常稳定的大模型对话前端产品,功能实现方面非常便捷,对于初学者十分友好。

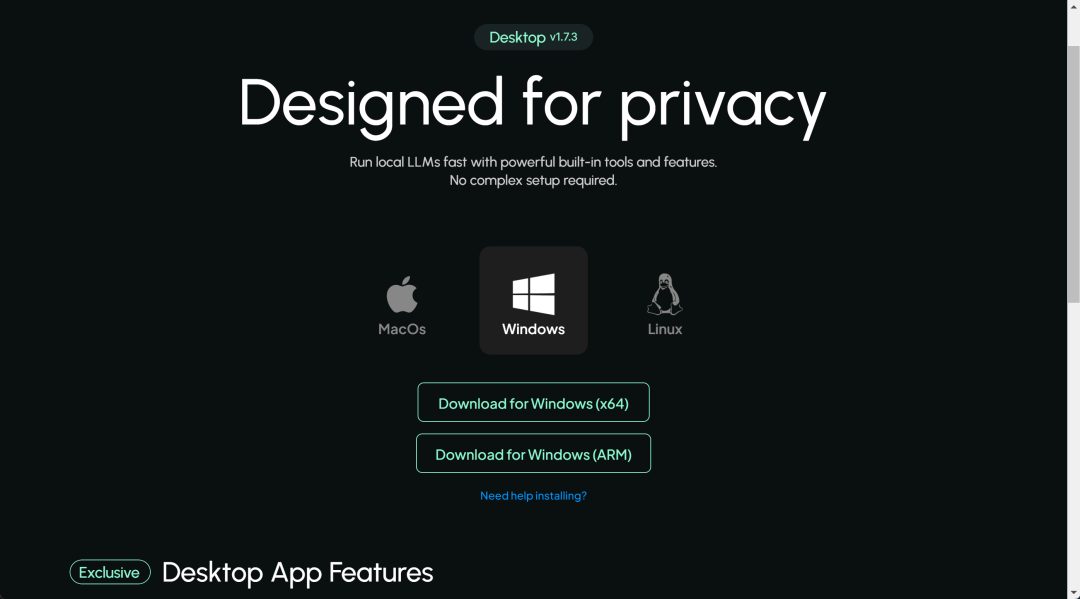

可以直接从 AnythingLLM 官网进行下载:https : //anvthingllm.com/

选择对应的操作系统版本下载安装即可开始安装:

安装完成后,会自动启动 AnythingLLM , 并进入设置页面

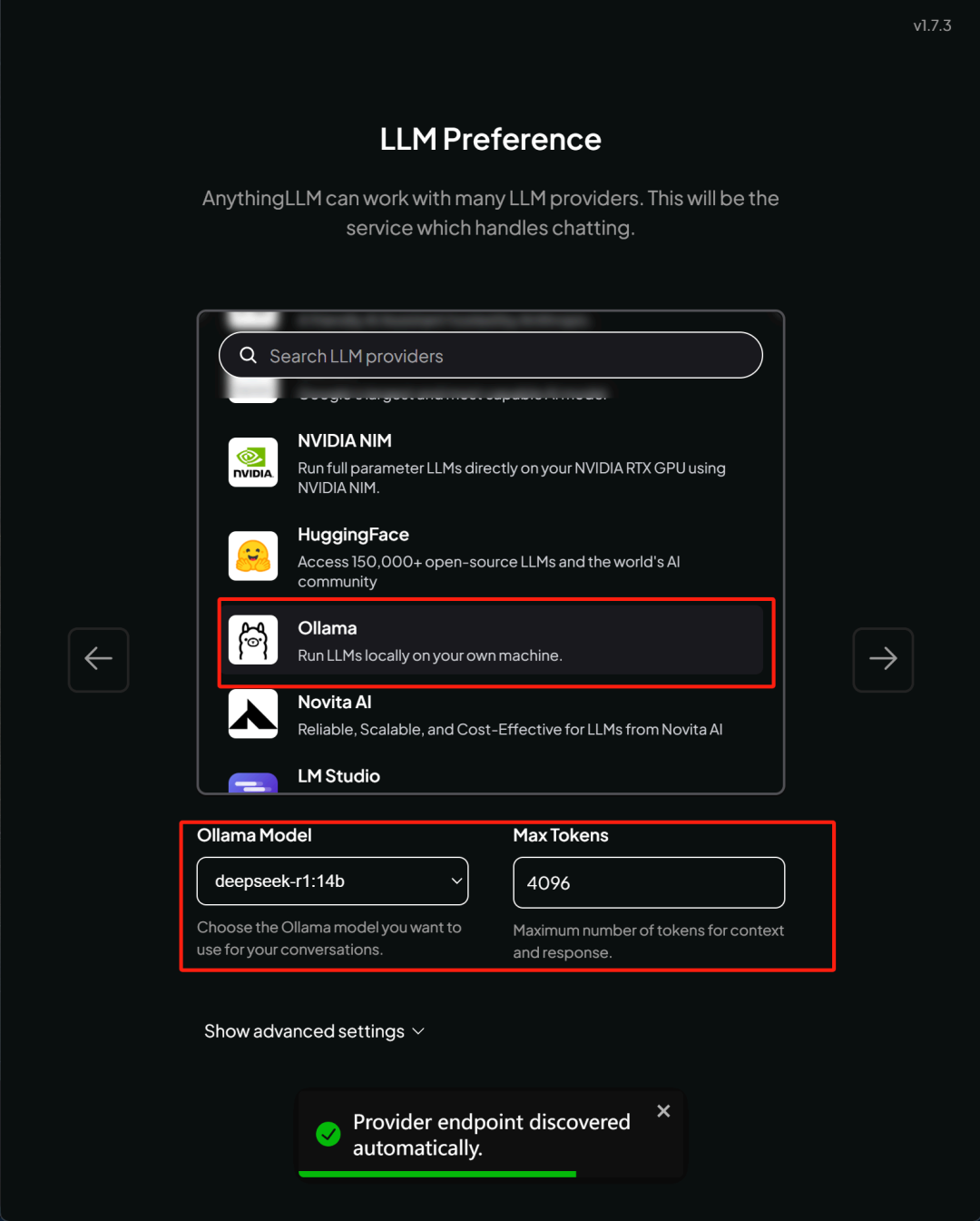

点击 Get started , 则进入到选择 LLM 页面:

这里我们选择借助 Ollama 来调用本地的 14B 模型。

需要注意, AnythingLLM 会自动检测 Ollama 进程是否存在 ( 也就是 Ollama 是否启动 ) , 以及现在 Ollama 中已经注册了哪些模型。

因此在进入到上面这个设置也面前,需要确保 Ollama 已经启动,并且已完成了相关模型注册。选择好 14B 模型之后即可点击进入下一步:

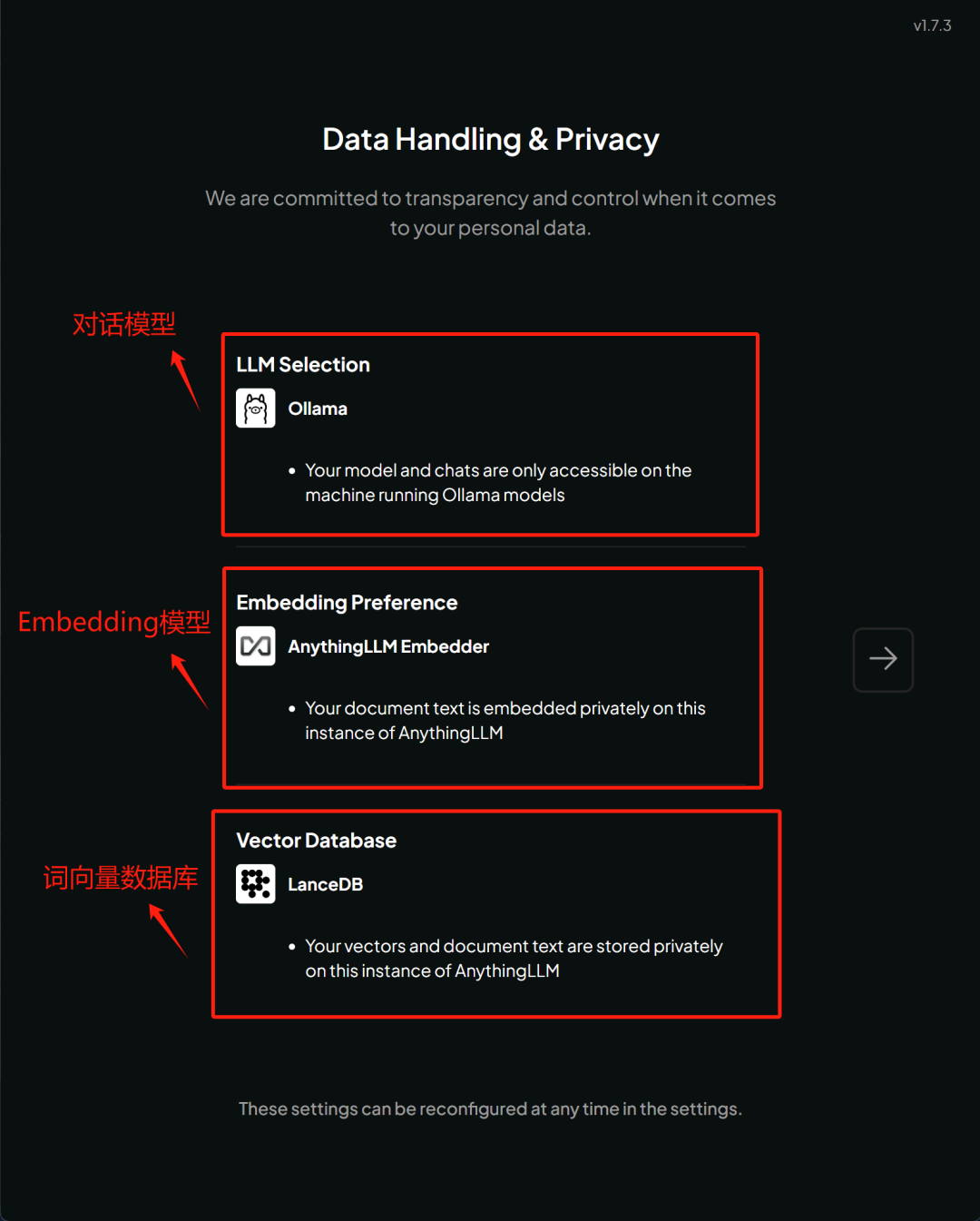

该页面是进行模型配置说明,当前的模型配置是:

●对话模型:负责完成对话任务,由 Ollama 调度 DeepSeek R1 Distill 14B 来完成对话;

● Embedding 模型:负责进行词向量化的模型,由 AnythingLLM 官方提供;

●词向量数据库:用于存储词向量化之后的对象,默认为 LancelotDB;

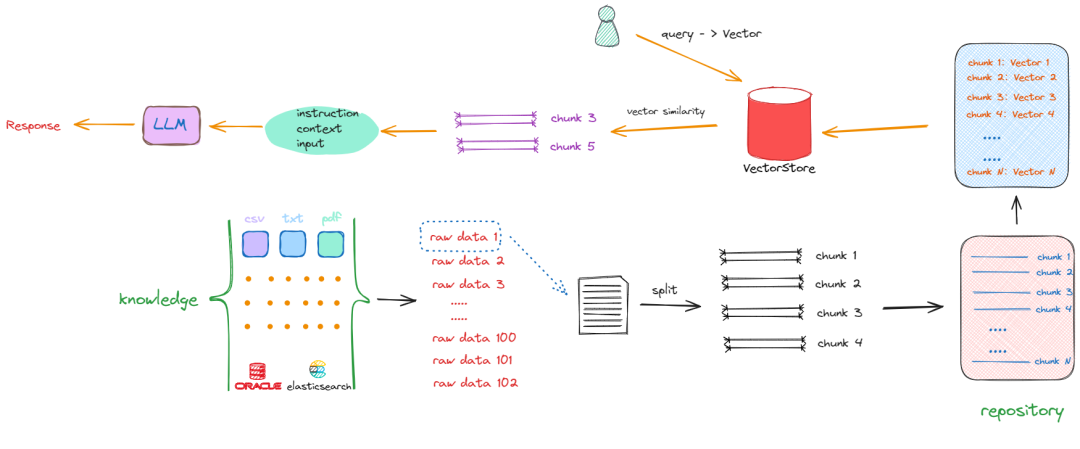

对于任何一个本地知识库问答的过程,都需要经历文本切割、词向量化、词向量存储、词向量检索与问答几个基本环节。

因此至少需要 Chat 模型、 Embedding 模型以及词向量数据库作为基础组件。

RAG 的基本原理如下:

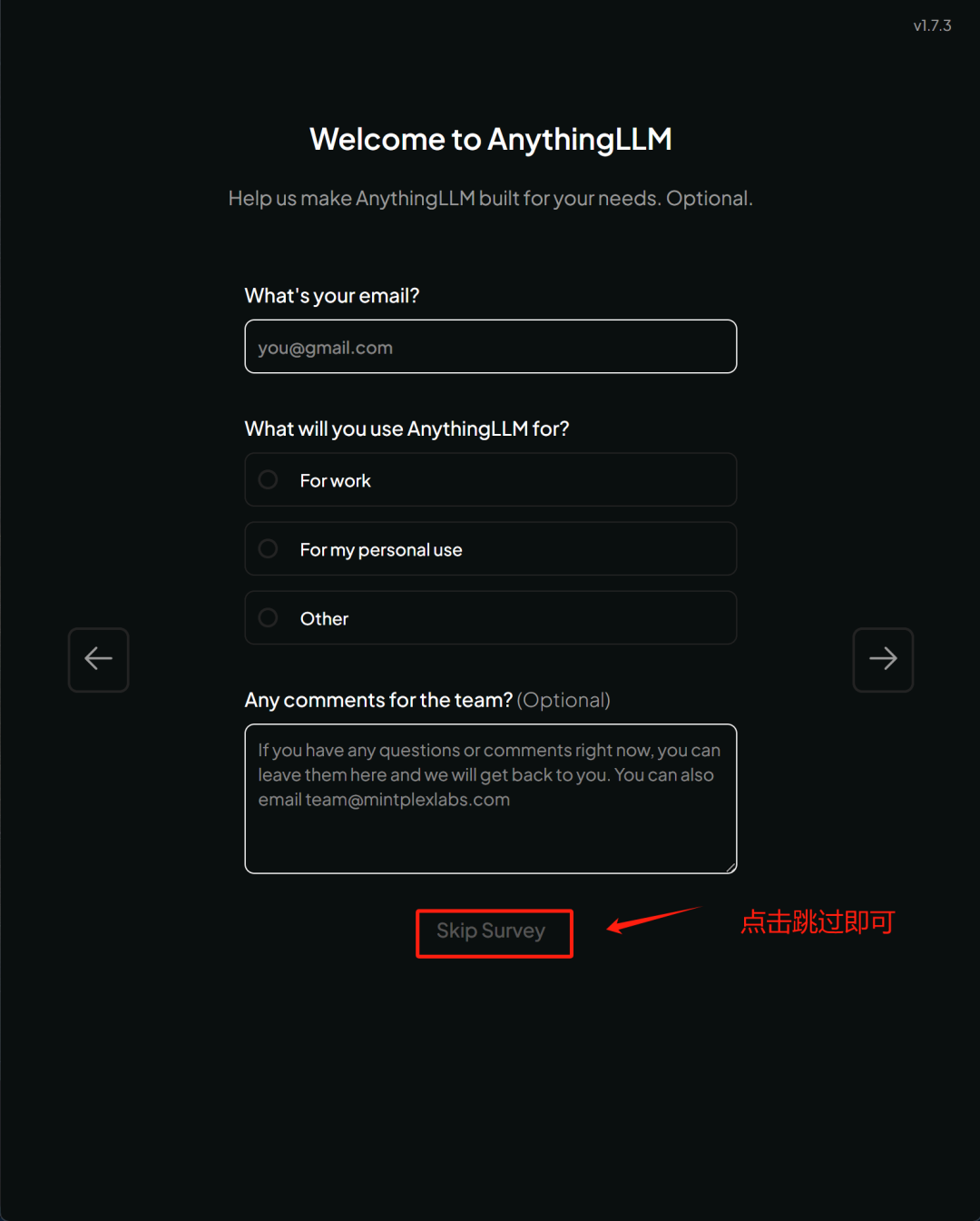

在浏览了当前模型配置后,接下来即将进入 AnythingLLM 注册页面,这里可以直接跳过:

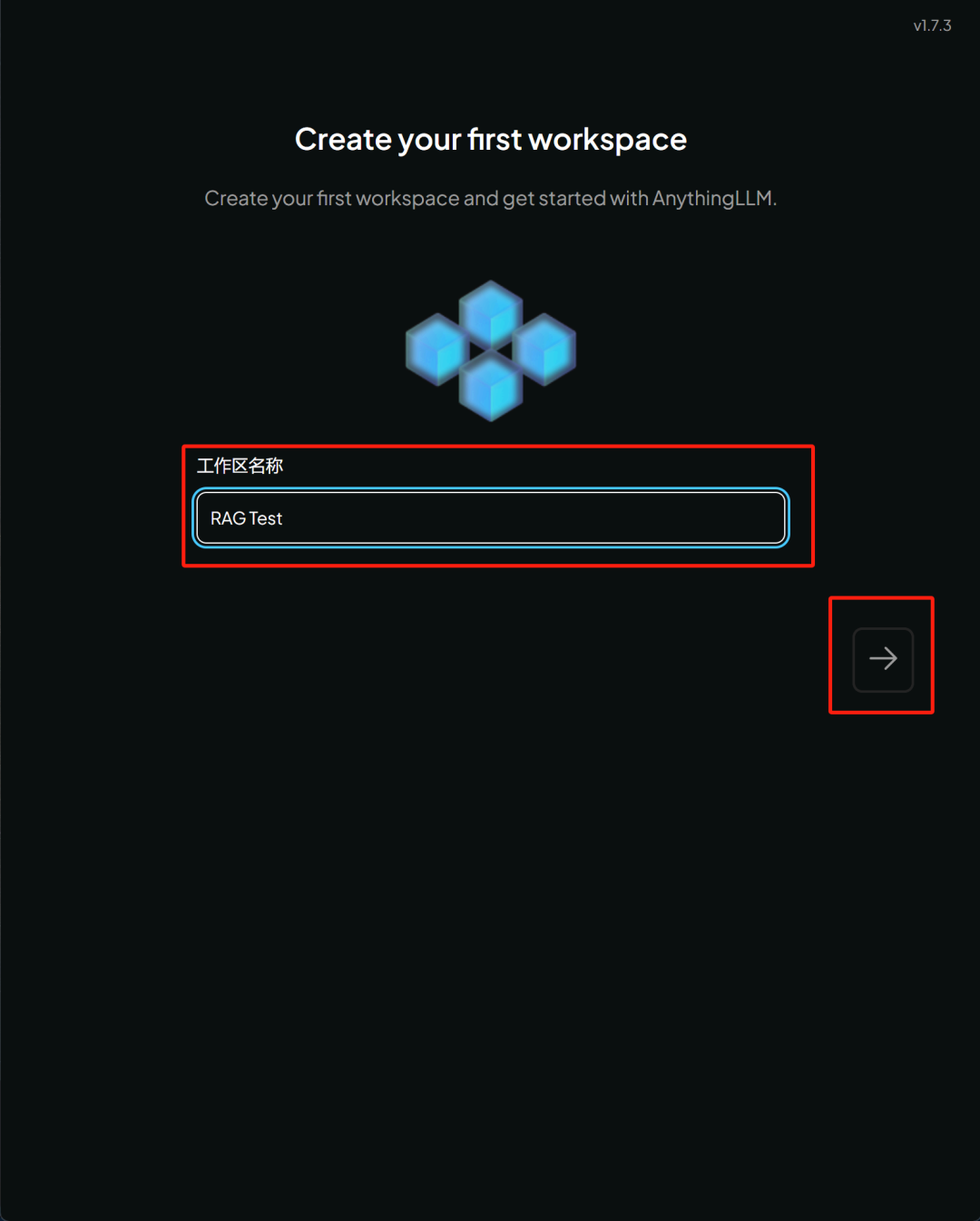

然后需要创建一个 workspace , 相当于是 ChatGPT 或者其他开发项目的一个 Project , 用于对对话进行分类:

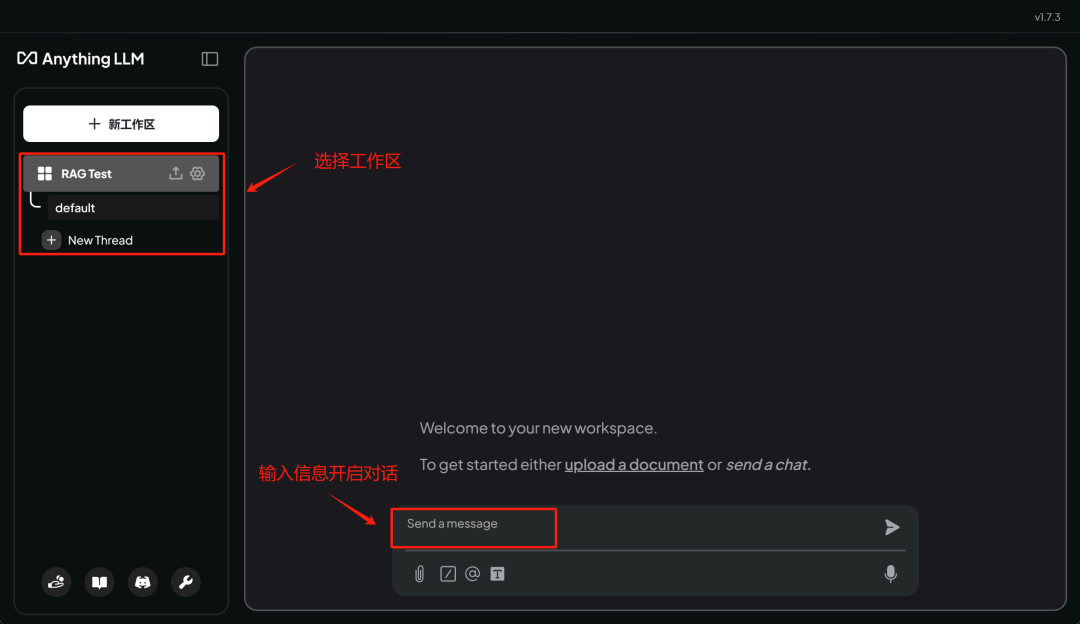

当我们进入到如下页面,则说明安装成功:

接下来即可尝试进行对话了。

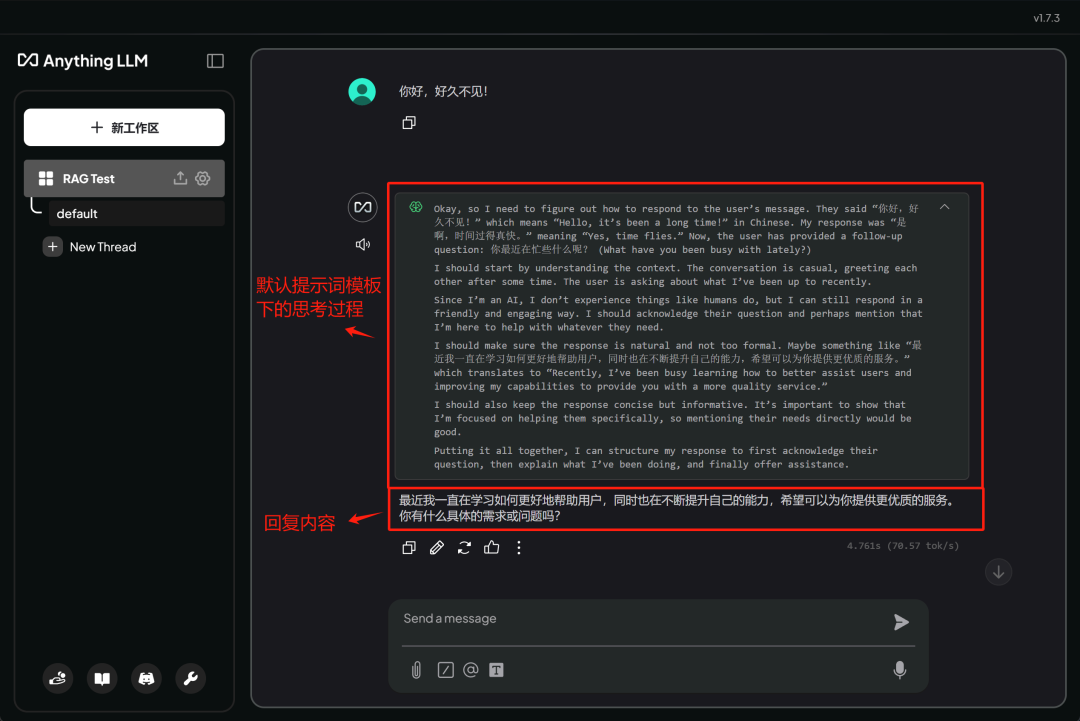

AnythingLLM 对于 DeepSeek R1 系列模型的支持是非常友好的,甚至会区分思考过程和回答过程:

并且支持多轮对话:

三.借助 Anything LL M 进行本地知识库问答

AnythingLLM 是一款集成度非常高、且运行稳定的 RAG+ 前端对话框架,我们可以非常便捷地为每次对话设置知识库。主要方法有以下两种:

●在单次问答中设置背景文本

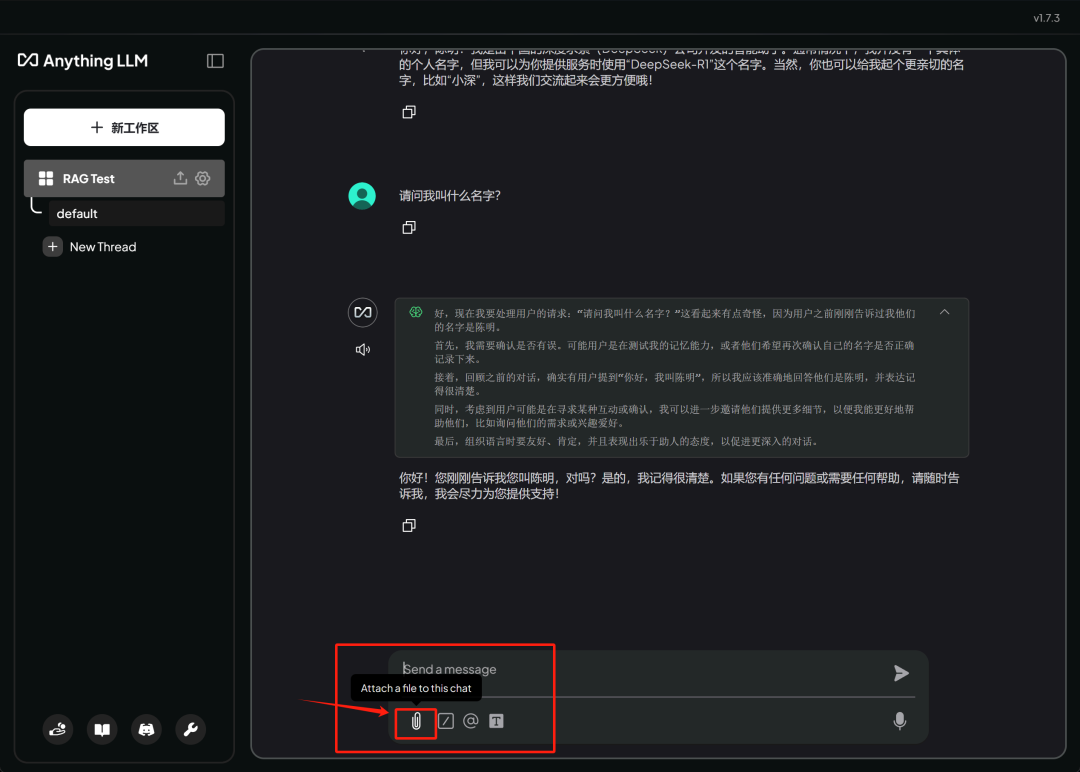

例如,我们可以直接在对话框下方点击回形针按钮,即可上传文本并进行对话,整个过程类似 ChatGPT 的功能实现:

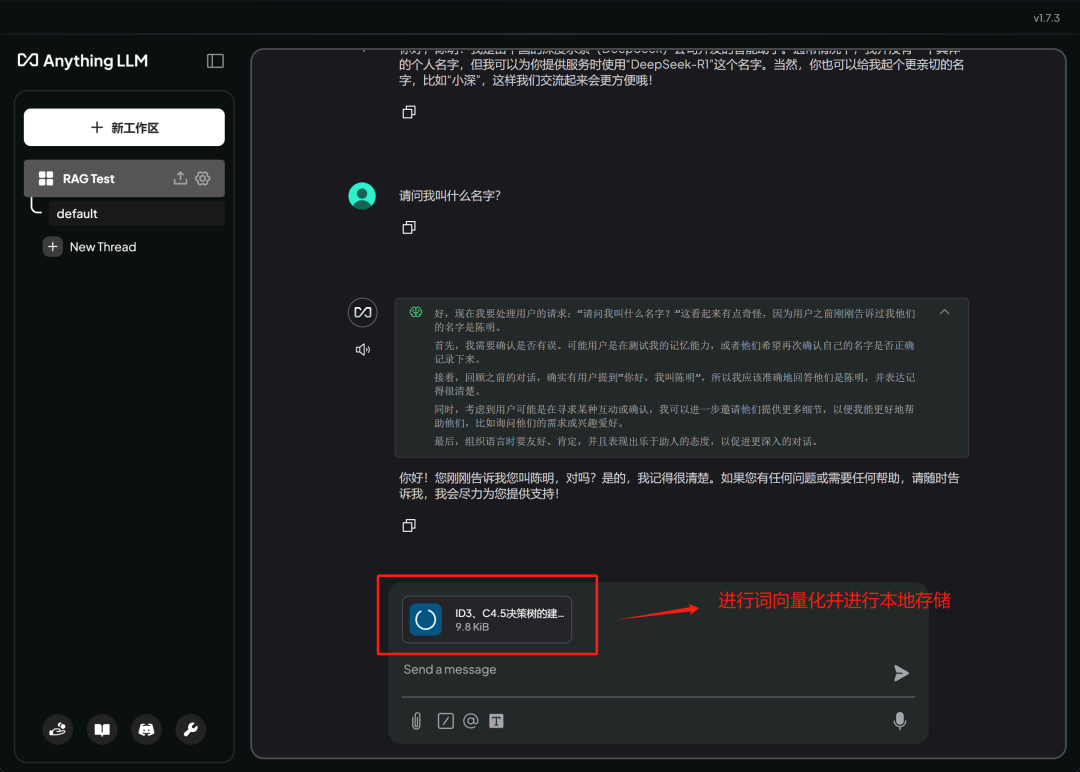

这里所谓上传文本,并不是把文本上传到远程服务器,而是将文本进行切分、 Embedding 后后上传到本地的 LanceDB 词向量数据库中。整个过程全部都在本地完成。

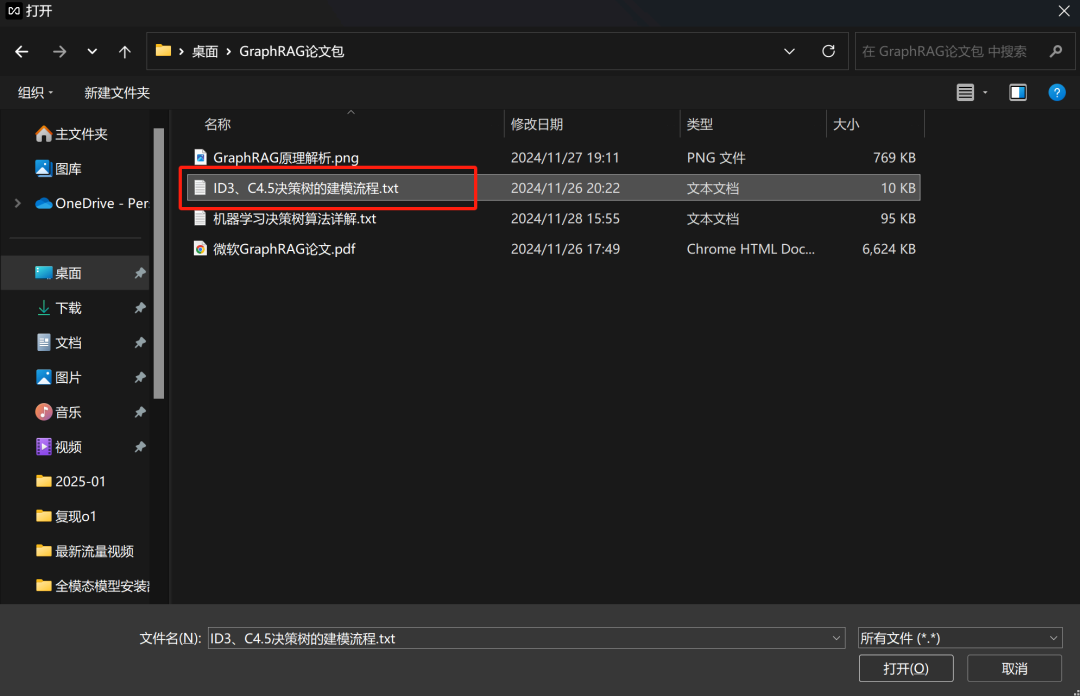

上传文本:

等待文本切分与词向量化过程

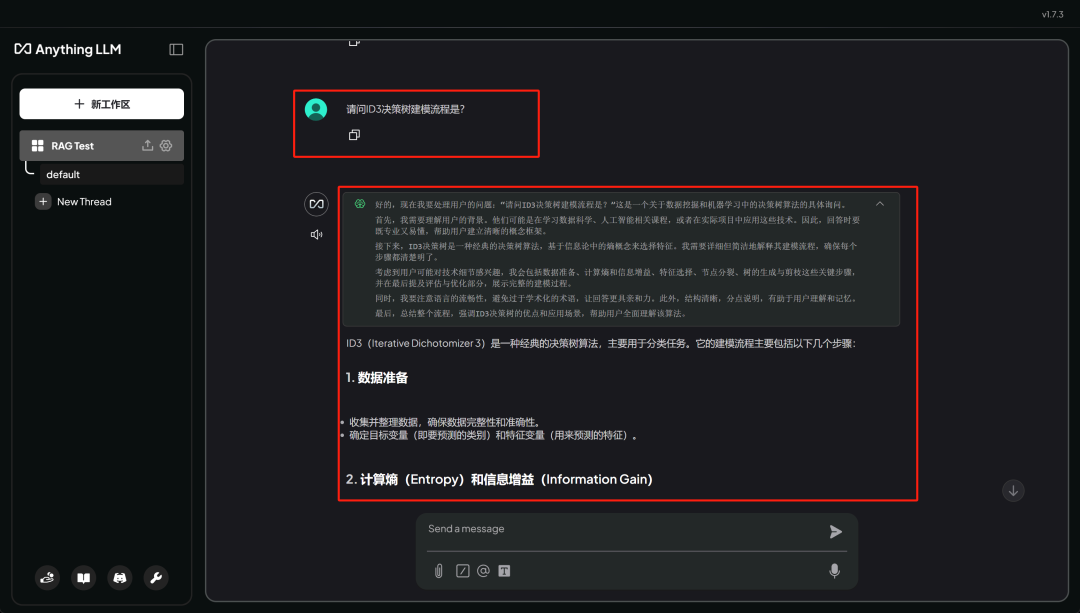

然后即可开始问答:

此时问答即会根据文档进行回答。

●统一知识库管理

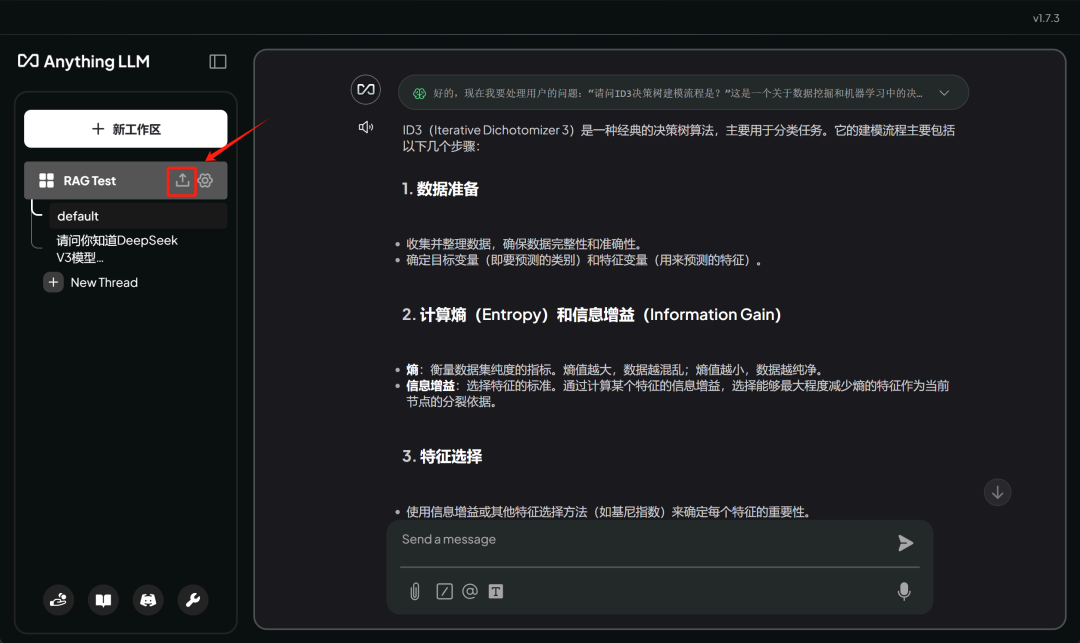

此外,若想让整个文本长期存在于当前对话中,则需要借助 AnythingLLM 的知识库管理功能。下面这个 icon 就是知识库管理图标 :

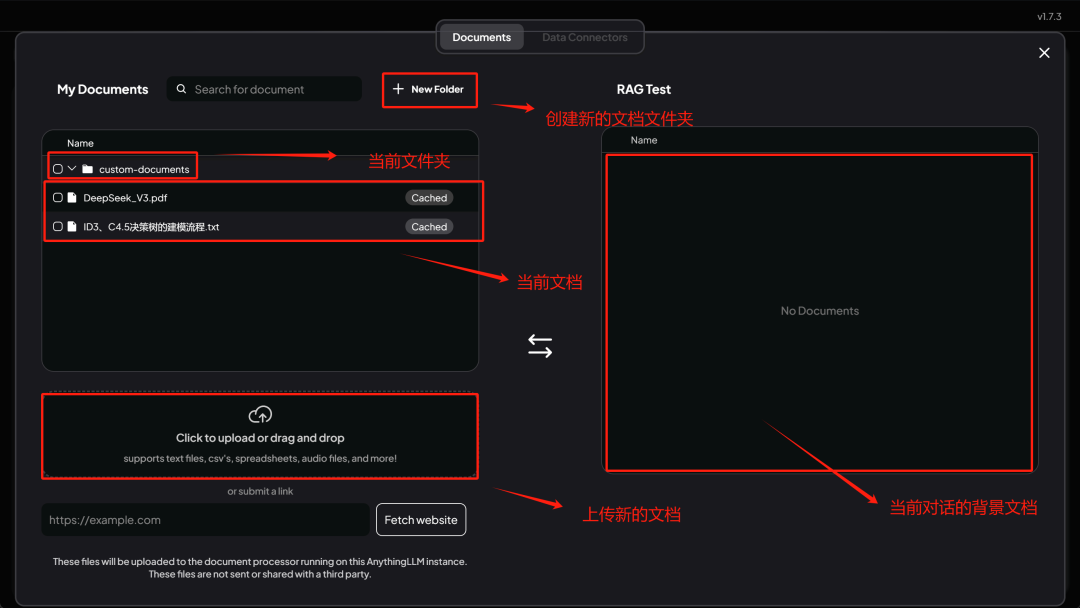

点击后即可进入到如下页面:

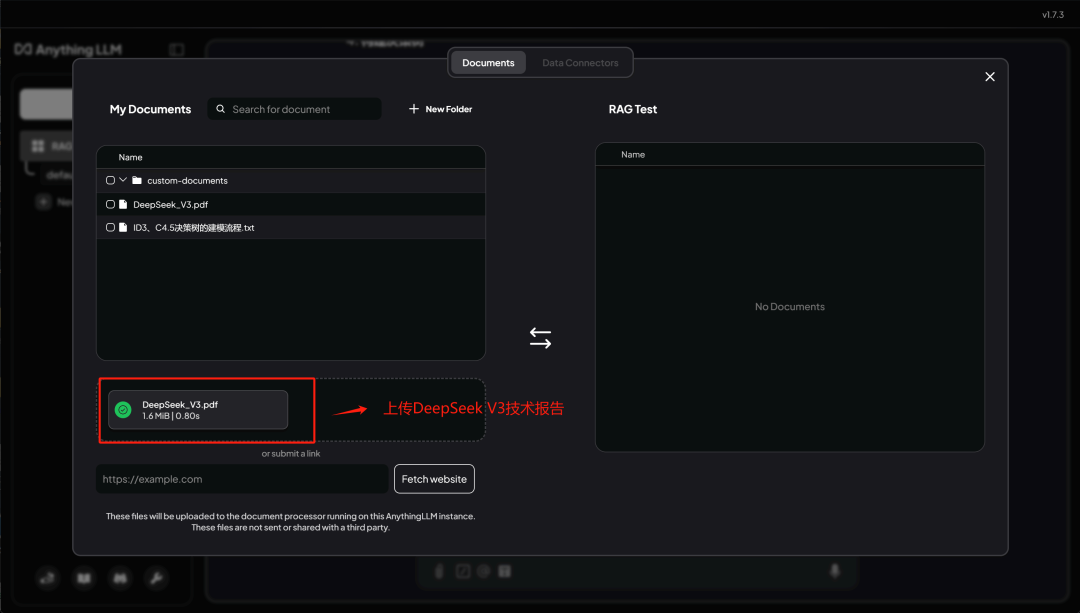

这里我们额外上传一份 DeepSeek V3 技术报告。

该报告的内容超出了当前模型只是范畴,适合进行本地文档问答测试:

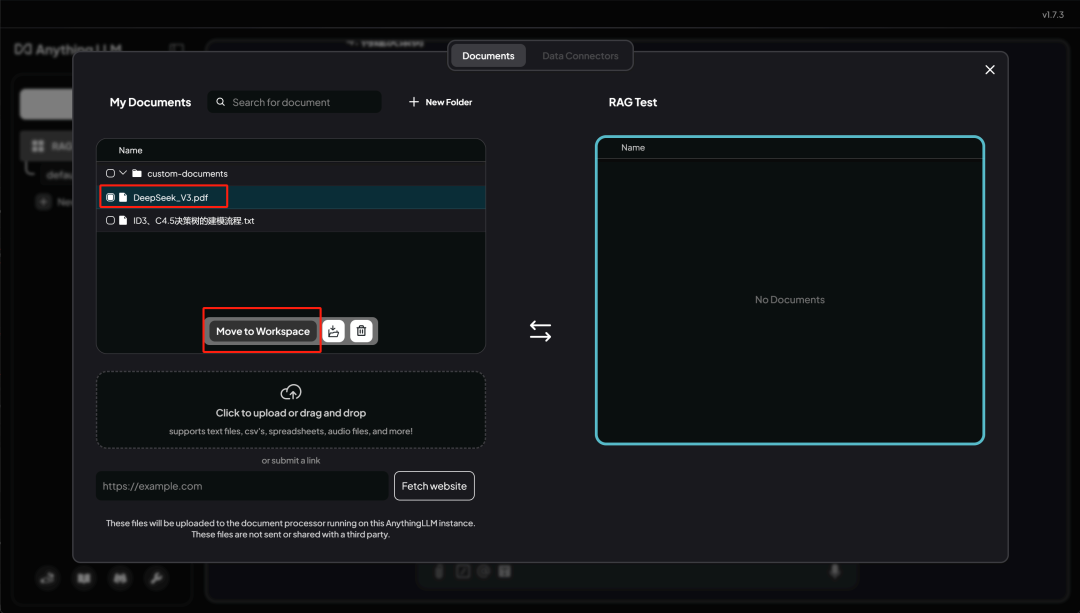

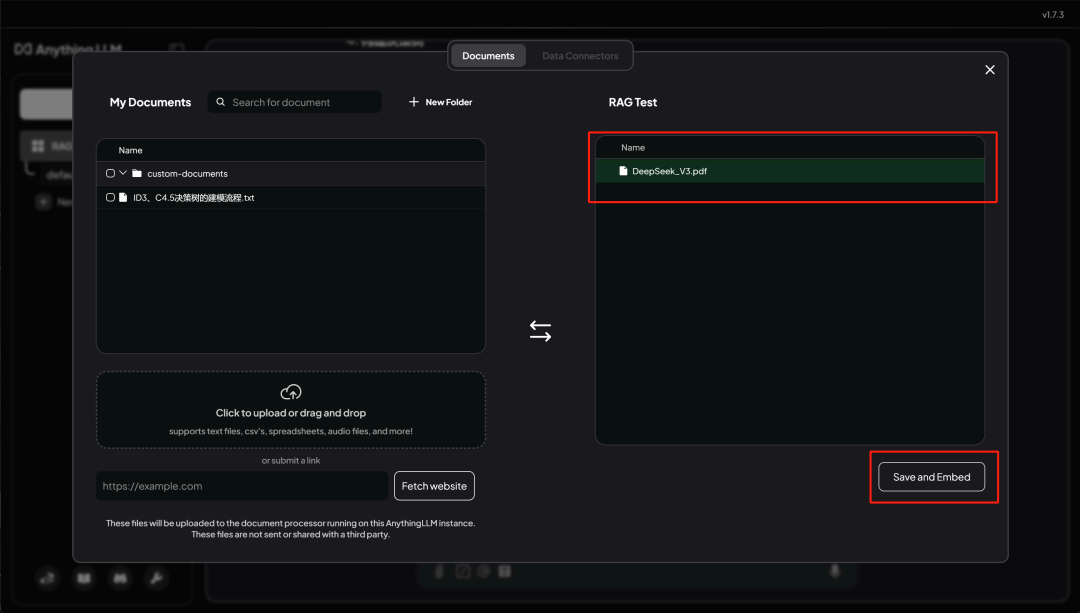

上传后即可在当前文件夹中看到该文件,这里点击 Move to Workspace , 即可将其列举为备选问答文档:

当 Move to workspace 后,在右侧即可看到这篇文档,然后点击 Save and Embed , 即可开始进行文档切分和词向量化过程:

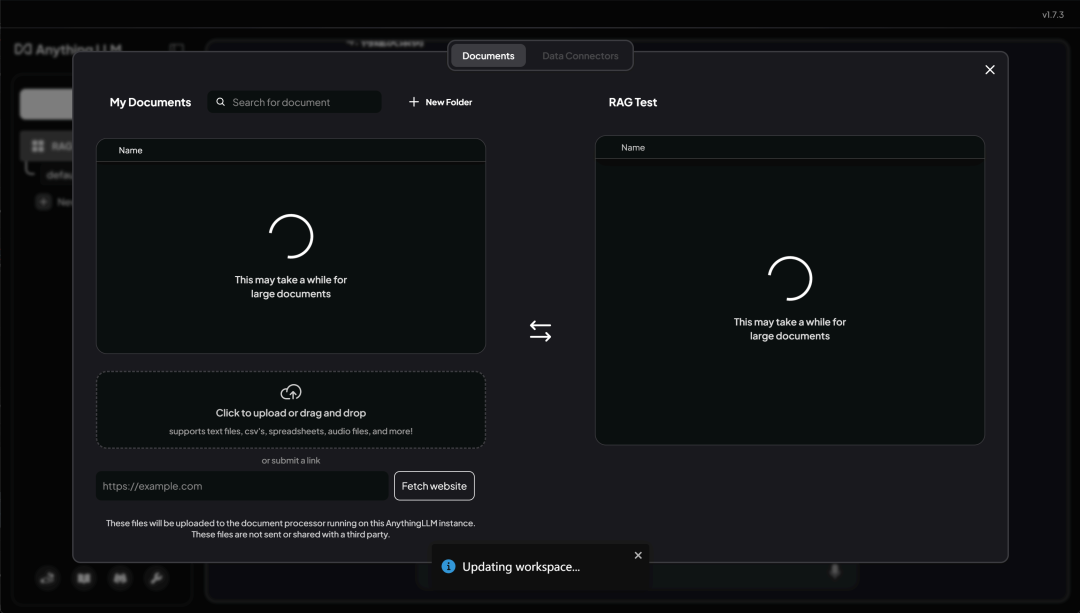

需要稍等片刻:

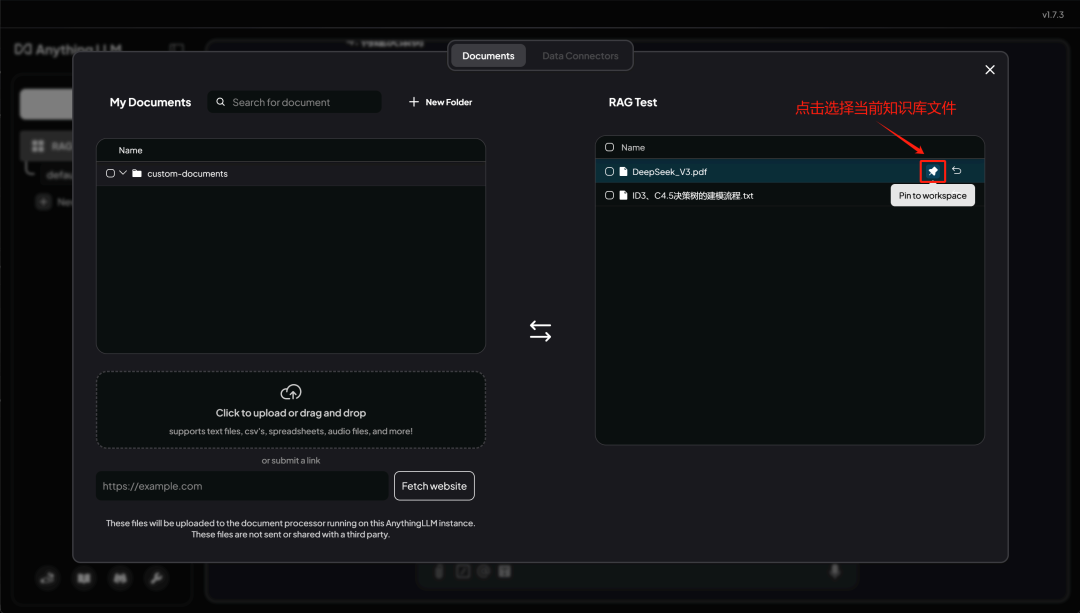

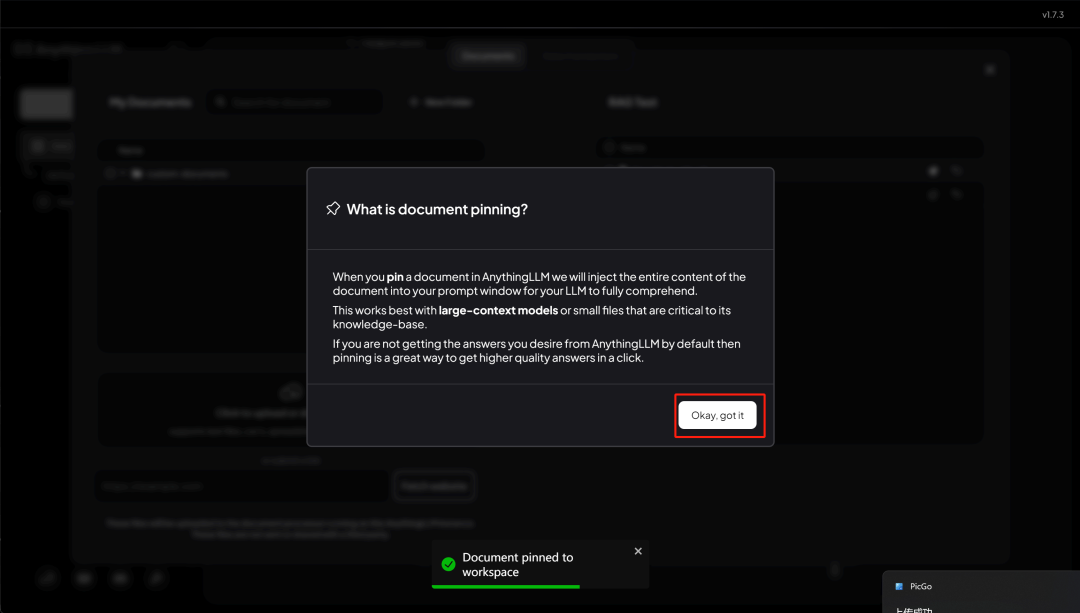

完成后,再点击图钉按钮,即可将这篇文档设置为当前对话的背景文档:

然后点击 got it

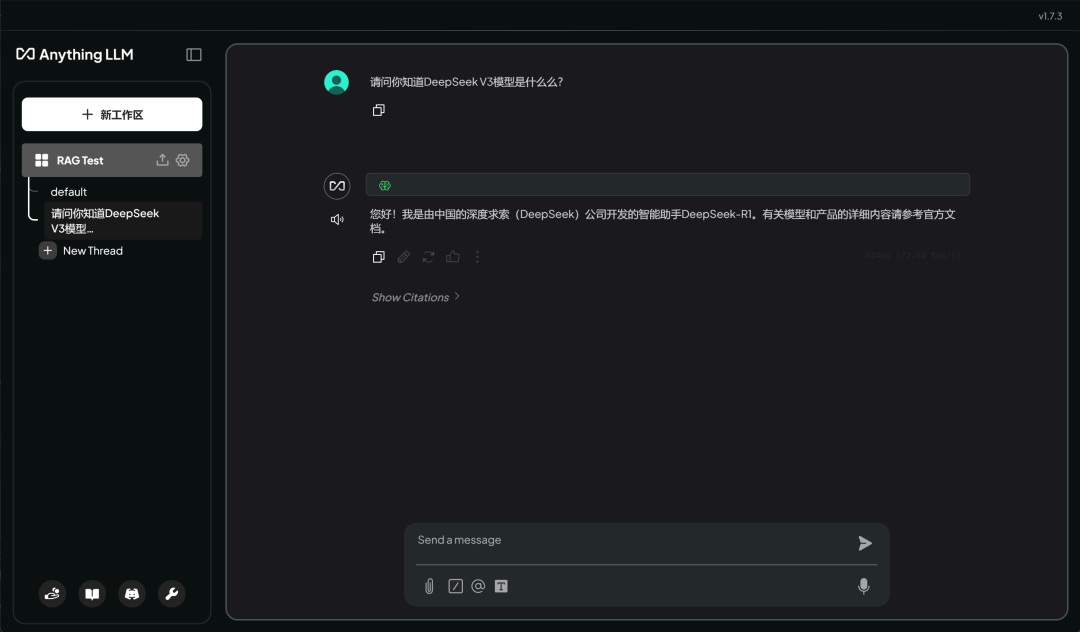

然后即可提问:

能够看出,此时回答结果就会根据当前文档进行回答,细节丰满回答流畅。而若不绑定知识库,则模型并不知道 DeepSeek V3 模型:

至此,即完成了 DeepSeek R1 Distill 14B 模型的本地知识库问答全流程。

四.DeepSeek R1 API 接入 AnythingLLM 进行本地知识库问答

最后,让我们来看下如何借助 DeepSeek R1 API+AnythingLLM 来进行本地知识库问答。

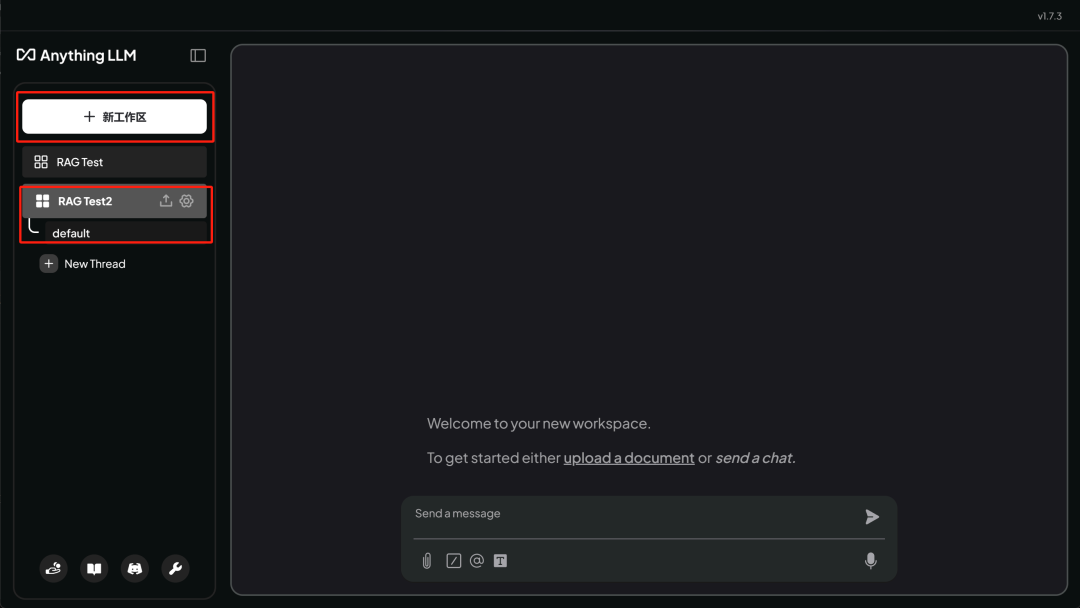

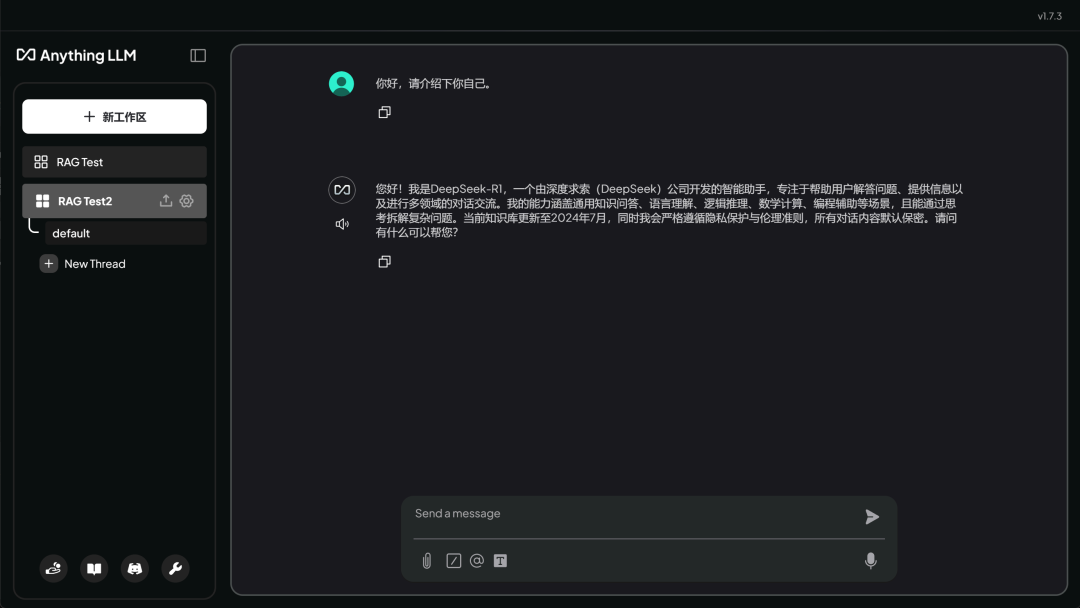

首先,新建一个工作区,并命名为 RAG Test2

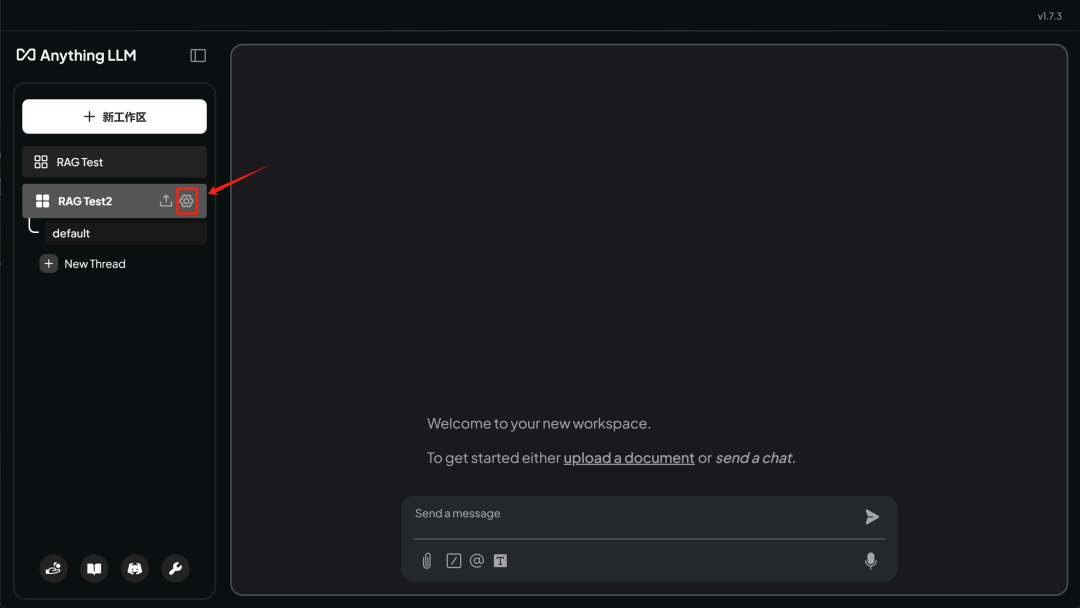

然后点击设置按钮:

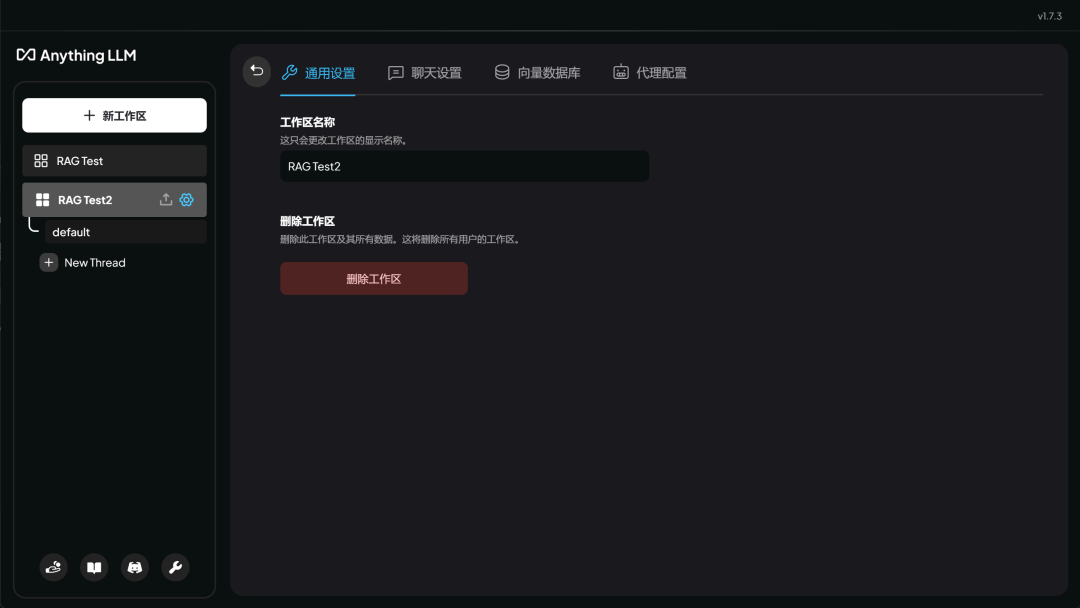

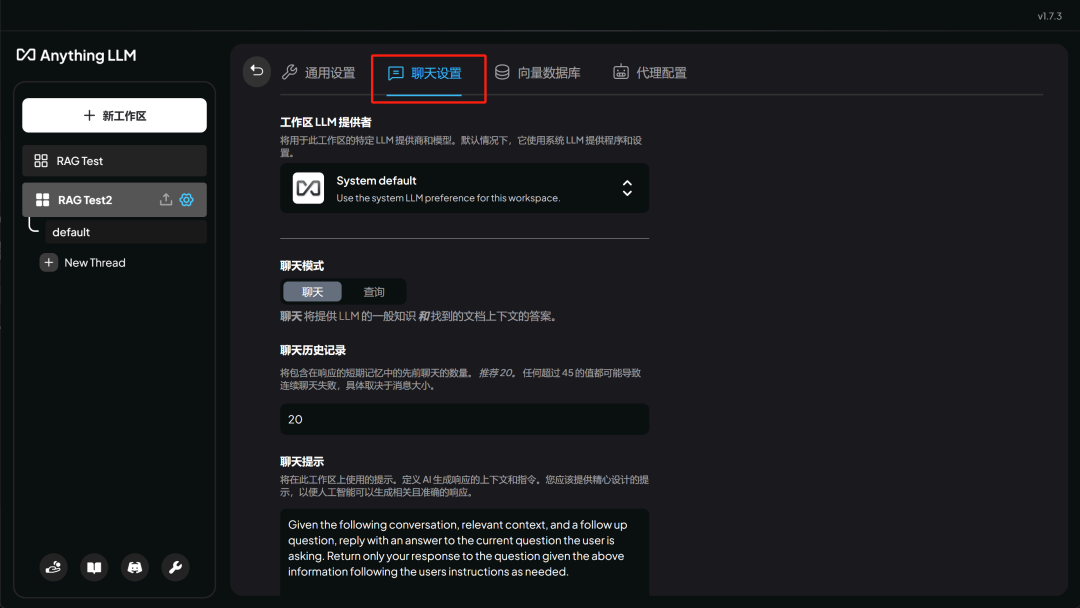

设置页面,我们可以灵活设置当前工作区域的名称 ( 或者删除工作区 )

或者修改默认模型,以及 system message ( 系统默认提示 ) :

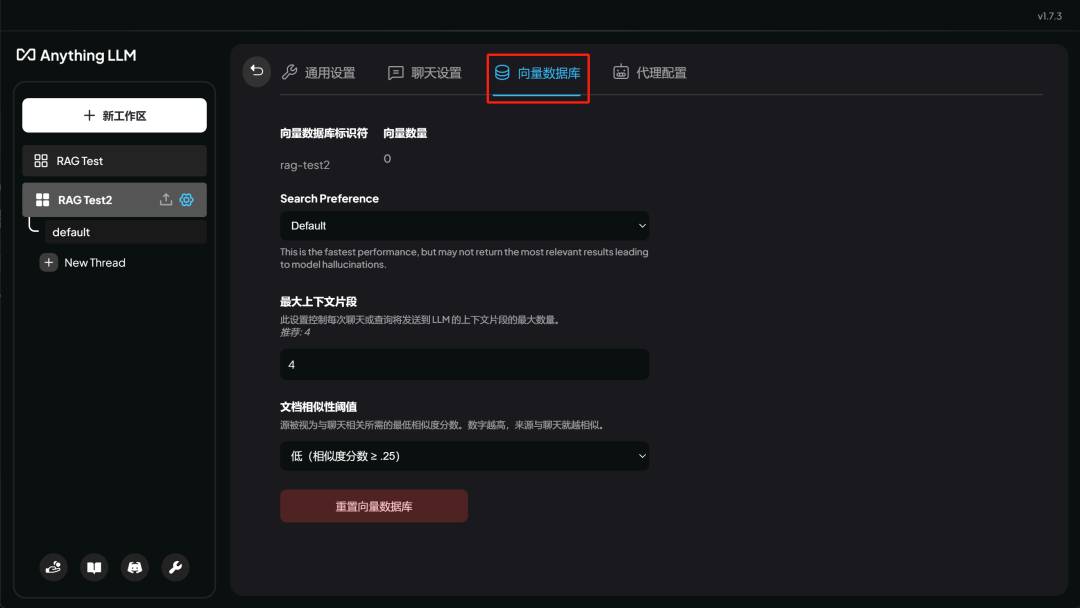

以及进行词向量数据库设置等。

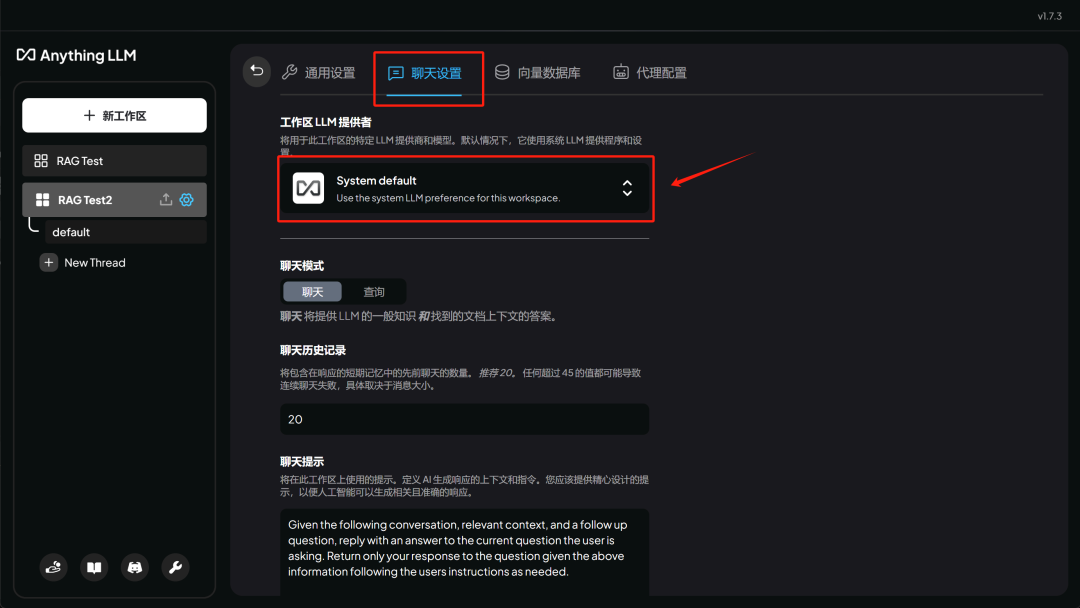

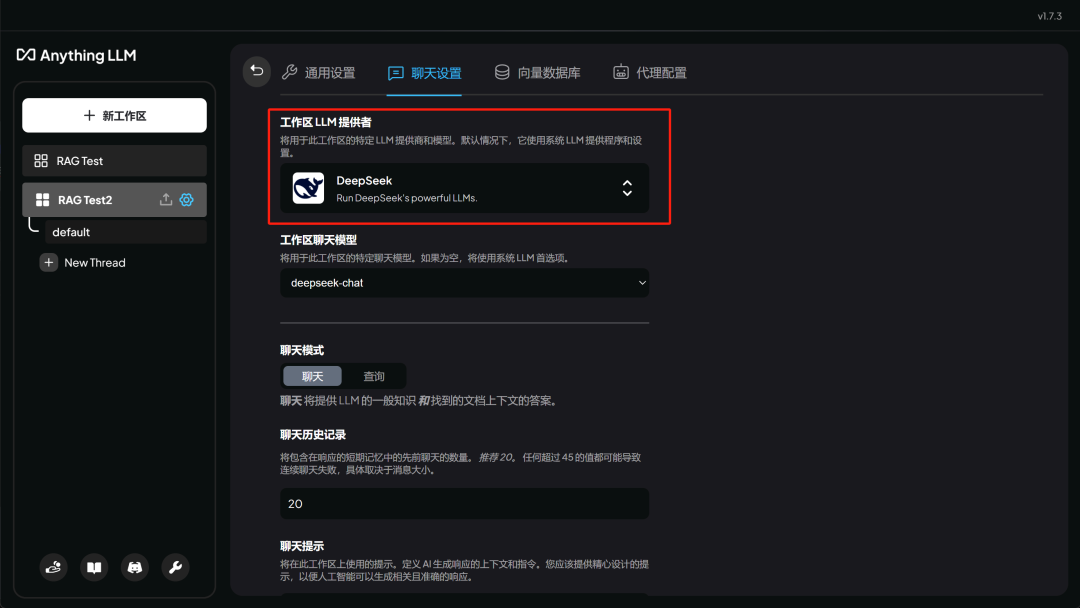

这里我们需要在聊天设置中修改模型为 DeepSeek R1 API , 先点击聊天设置,然后选择模型:

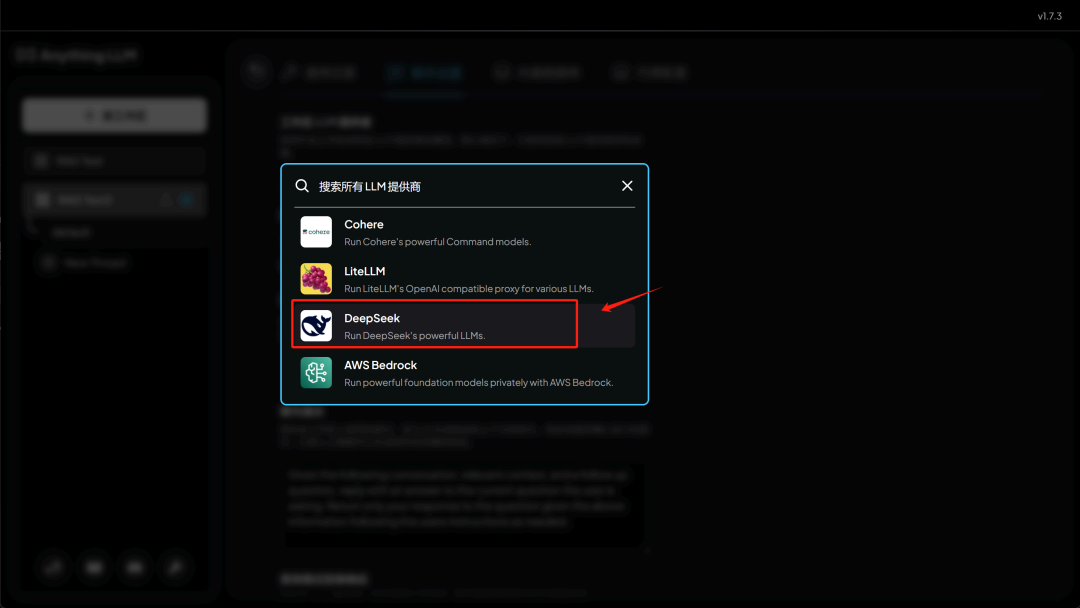

然后在模型提供商中选择 DeepSeek :

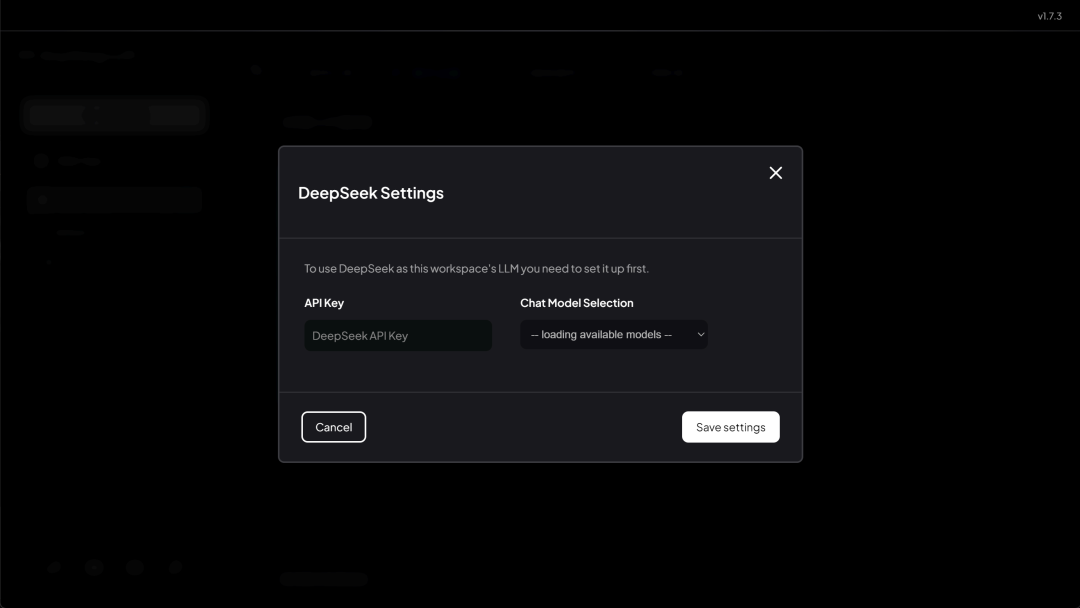

然后在弹出的页面输入 API-KEY

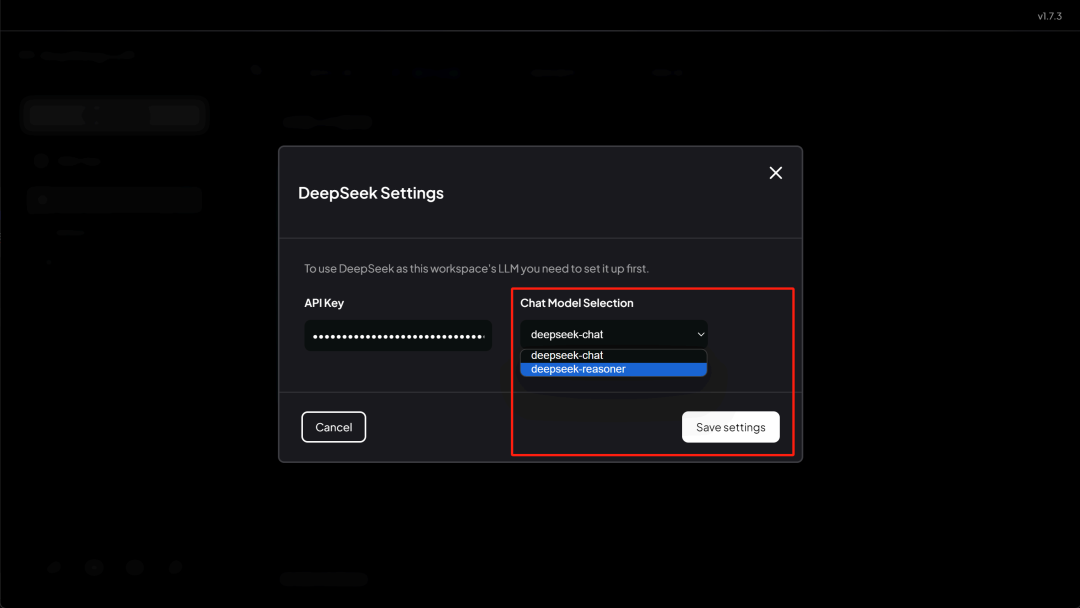

输入完 API-Key 后,即可选择对话模型, deepseek-chat 就是 DeepSeek V3 , 而 deepseek-reasoner 则是 DeepSeek R1 。

这里我们选择 deepseek-reasoner :

然后点击 Save , 即可返回设置页面:

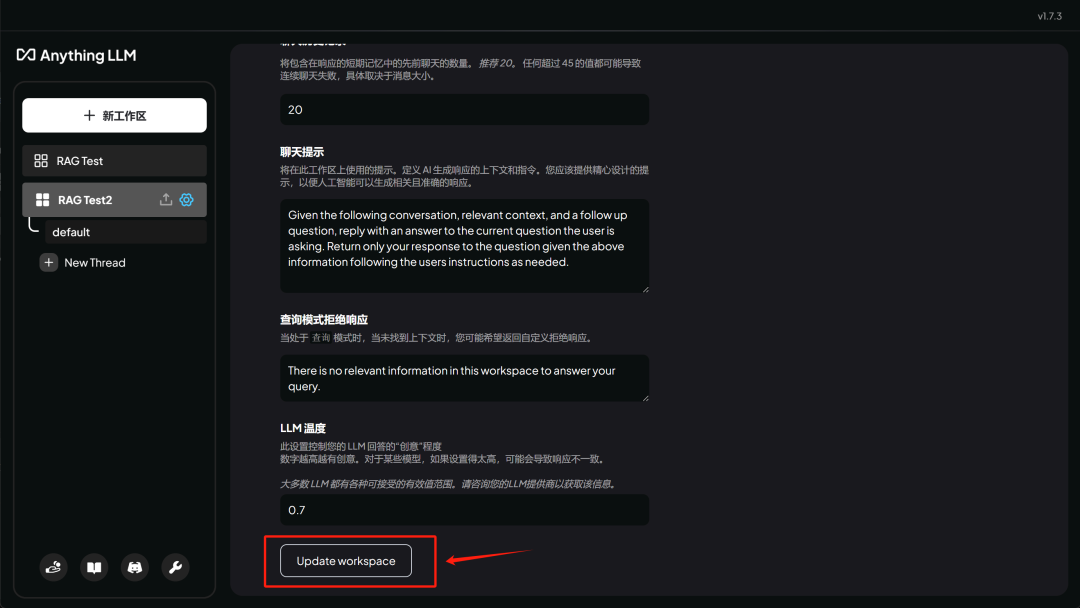

然后翻到最下面点击 Update workspace , 即可完成设置:

然后点击左侧聊天栏,选择 default 会话即可开始聊天了:

如此即可完成对话。

在文章即将结束的末尾,为大家整理了其他方便快捷搭建私有知识库的框架:

【个人】多端&多模型聊天框架:ChatBox

GitHub地址:https://github.com/Bin-Huang/chatbox

【企业级】RAG&GraphRAG 知识库对话框架:kotaemon

Github主页地址https:/github.com/Cinnamon/kotaemon

【企业级】RAG&Agent 多功能综合前端框架:Open-WebUI

GitHub项目地址:https://github.com/open-webui/open-webui

【企业级】多模态交互框架:lobe-chat

GitHub项目地址:https://github.com/lobehub/lobe-chat

为每个人提供最有价值的技术赋能!【公益】大模型技术社区已经上线!

九天&菜菜&菊安酱&木羽老师,30+套原创系统教程,涵盖国内外主流「开&闭源大模型」调用与部署,RAG、Agent、微调实战案例…

所有内容免费公开,还将定期追更最新大模型技术进展~

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?