最近开始玩起了机器学习,以前都是用matlab做一些机器学习的东西,毕竟要真正放到工程上应用还是python用起来比较好,所以今天就开始学习下使用SVM进行回归(分类)预测。

SVM 使用的一般步骤是:

1)准备数据集,转化为 SVM支持的数据格式 :

[label] [index1]:[value1] [index2]:[value2] ...

即 [l类别标号] [特征1]:[特征值] [特征2]:[特征值] ...

2)对数据进行简单的缩放操作(scale);(为什么要scale,这里不解释了)

3)考虑选用核函数(通常选取径函数,程序默认);

4)优化算法选择最佳参数C与g ;

5)用得到的最佳参数C与g 对整个训练集进行训练得到SVM模型;

6)用得到的SVM模型进行测试

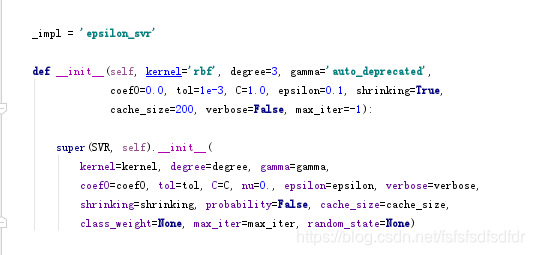

在这个基本操作中,优化算法起到了关键作用,常见优化算法有网格搜索算法、遗传算法、粒子群算法、蚁群算法。这些优化算法主要实现对SVM参数进行优化。在sklearn 中有对svm的实现,其中回归的构造函数中的参数就是模型的参数,包括核函数,惩罚因子C、不敏感系数g、RBF中的核宽度epsilon。

参数:

l C:C-SVC的惩罚参数C?默认值是1.0

C越大,相当于惩罚松弛变量,希望松弛变量接近0,即对误分类的惩罚增大,趋向于对训练集全分对的情况,这样对训练集测试时准确率很高,但泛化能力弱。C值小,对误分类的惩罚减小,允许容错,将他们当成噪声点,泛化能力较强。

l kernel :核函数,默认是rbf,可以是‘linear’, ‘poly’, ‘rbf’, ‘sigmoid’, ‘precomputed’

0 – 线性:u’v

1 – 多项式:(gamma*u’*v + coef0)^degree

2 – RBF函数:exp(-gamma|u-v|^2)

3 –sigmoid:tanh(gamma*u’*v + coef0)

l degree :多项式poly函数的维度,默认是3,选择其他核函数时会被忽略。

l gamma : ‘rbf’,‘poly’ 和‘sigmoid’的核函数参数。默认是’auto’,则会选择1/n_features

l coef0 :核函数的常数项。对于‘poly’和 ‘sigmoid’有用。

l probability :是否采用概率估计?.默认为False

l shrinking :是否采用shrinking heuristic方法,默认为true

l tol :停止训练的误差值大小,默认为1e-3

l cache_size :核函数cache缓存大小,默认为200

l class_weight :类别的权重,字典形式传递。设置第几类的参数C为weight*C(C-SVC中的C)

l verbose :允许冗余输出?

l max_iter :最大迭代次数。-1为无限制。

l decision_function_shape :‘ovo’, ‘ovr’ or None, default=None3

l random_state :数据洗牌时的种子值,int值

主要调节的参数有:C、kernel、degree、gamma、coef0。

因此我们使用sklearn 中的SVm时候,要选择好参数

from sklearn import svm

X = [[0, 0], [2, 2]]

y = [0.5, 2.5]

clf = svm.SVR()

clf.fit(X, y)

SVR(C=1.0, cache_size=200, coef0=0.0, degree=3, epsilon=0.1,

gamma='auto_deprecated', kernel='rbf', max_iter=-1, shrinking=True,

tol

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

636

636