掘金的文章也是我写的,只是复制过来,因为csdn无法上传图片。

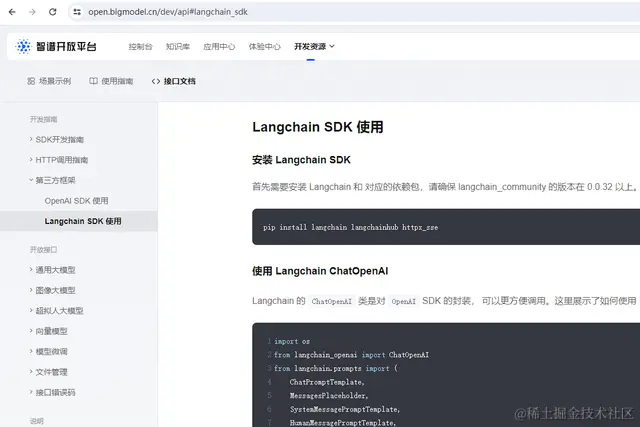

本次对接的大模型是智谱,首先想到去智谱开放平台找找有没有和langchain结合的文档:

结果还真有,就省去了谷歌的时间,但是智谱的文档只提供了非流式的示例代码,想着先拷过来跑一下再说,结果就是非流式是正常输出的,流式就遇到问题了,不管我咋配置,好像只能在控制台输出流失内容,遂去谷歌“langchain 流式输出”:

前面三篇文章都看了,第一篇内容:

好像和智谱官方的文档写法不一样,遂放弃使用该方式,接着又看了第二篇文章:

他这里说是要在初始化llm的时候加一个callbacks参数,并且自定义callbacks,最终的代码大致如下:

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

5526

5526

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?