SpoolDirectorySource.java:280

FATAL: Spool Directory source r1: { spoolDir: /tmp/logs }: Uncaught exception in SpoolDirectorySource thread. Restart or reconfigure Flume to continue processing.

java.lang.IllegalStateException: File name has been re-used with different files. Spooling assumptions violated for /tmp/logs/slave1.txt.COMPLETED

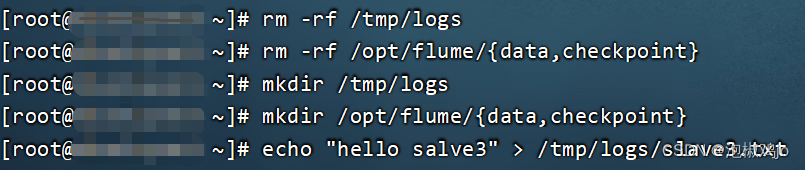

删除:/tmp/logs重建立(清除数据)

我是把数据存放目录和数据缓存目录、检查点目录全部删除重新建立

然后启动后再流入数据的

Caused by: java.net.ConnectException: 拒绝连接: /x.x.x.x:44444

我是因为配置文件:a1.sinks.k1.hostname=主机名(或者ip)(我且形容为主节点吧)

而且启动flume要按顺序来先master再启动slave

Application是flume进程号,停直接kill -9 (其他方法不晓得)

注意:启动flume前需要启动hadoop集群

最后附上让我似乎快要悟了的博文

565

565

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?