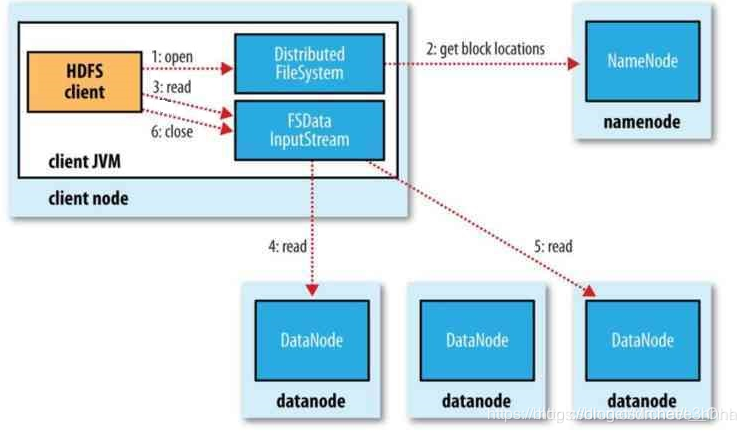

HDFS的读流程

- 客户端通过FileSystem的对象调用open()方法给namenode发送打开一个文件的请求

- 在namenode角度来看客户端是通过DisturbuedSystem发送到请求,namende收到请求后会验证客户端是否有权限读取该文件,该文件是否存在等一系列验证,经过验证后,namenode会返回给客户端一个FSDataInputstream流(可以定位数据副本的位置方便读取),并且返回该文件存储的副本所在位置同时按照距离客户端的远近排好序。

- FSDataInputstream立即连接第一个数据所在的最近的副本块,开始读取,客户端通过反复调用FSDataInputstream的read()方法将文件读入内存。

- 当客户端读取完一个数据块时FSDataInputstream关闭与DataNode的连接,寻找下一个块进行相同的过程知道数据都读取完毕。

- 客户端读取数据时是按照FSDataInputstream和DataNode的新建连接的顺序读取的,FSDataInputstream也会根据需要向namenode请求下一批数据块在哪,一旦读完就调用FSDataInputstream的close()方法关闭流

- 若是读取过程中datanode与FSDataInputstream通信出现问题FSDataInputstream会试着重连如果重连不成功就会寻找下一个距离最近的datanode,同时标记出问题的datanode以确保后续不会在上面读取数据,FSDataInputstream会检测数据的完整性正确性以确保读取到的数据是正确的。

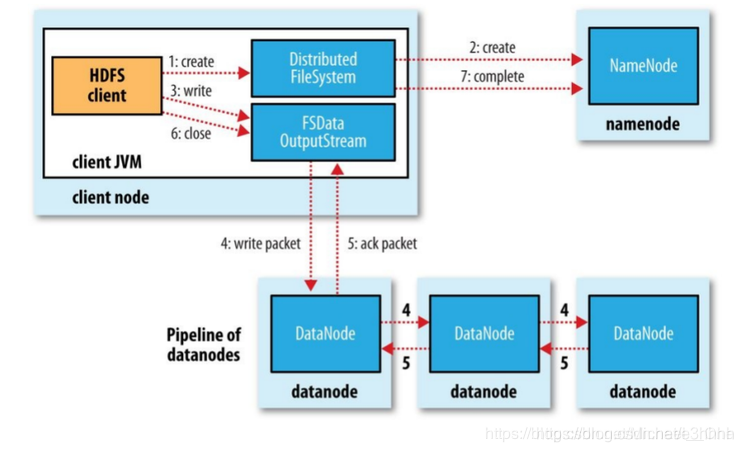

HDFS写流程

- 客户端使用FileSystem的对象调用create()方法向namenode发送请求,要求创建一个文件,

- DistributedFileSystem对namenode远程调用rpc创建一个文件,但是文件没有元数据在内存中没有相应的数据块

- namenode会检查客户端是否有权限创建文件,以及文件是否存在等一系列的检查后,若是检查通过则返回一个FSDataOuputStream对象客户端可以通过FSDataOuputStream对象调用write()方法写入文件,若是通不过则报一个异常通过异常客户端可以知道是什么错误

- 在写入数据时客户端将内存里的数据通过FSDataOuputStream对象写出,FSDataOuputStream对象将数据每64K打包成一个package,并且存入dataqueue(这是一个数据包队列由DataStreamer负责维护)DataStreamer的职责是挑选出适合写入的Datanode并且请求namenode分配数据块,namenode分配数据块后将这些datanod组成一个管道返回给客户端,DataStreamer将数据传给第一个datanode,第一个datanode写完后会会返回一个消息告知客户端写完,然后第一个将数据传给第二个数据块,同理第二个写完也会告知客户端,写完。

- 当客户端得到第一个块写完的消息后会将在dataqueue的package移动到ack queue队列中

- 当收到所有管道的ResponseProcessor线程发送的写入成功的信息后,ResponseProcessor会将数据包从去确认队列中删除

- 如果写入期间发生故障,

- 则会关闭管道,将确认队列的说有数据包的返回dataqueue以确保故障块后的块数据完整

- 将故障块标识以防止后续不断地写入,并且为能正常工作的datanode的数据块制定一个新的编号,以便故障的datanode恢复正常时可删除故障块

- 将剩余的能正常工作的数据块组成一个管道继续写出,

- 当namenode发现副本块不足时会自动调用副本策略生成新的数据块

在一个块被写入期间可能会有多个datanode同时发生故障,但概率非常低。只要写入了dfs.namenode.replication.min的复本数(默认1),写操作就会成功,并且这个块可以在集群中异步复制,直到达到其目标复本数dfs.replication的数量(默认3)

本文详细解析了HDFS的读写流程,包括客户端如何通过FileSystem对象与NameNode交互,读取和写入数据的过程,以及在读写过程中遇到问题时的处理策略。

本文详细解析了HDFS的读写流程,包括客户端如何通过FileSystem对象与NameNode交互,读取和写入数据的过程,以及在读写过程中遇到问题时的处理策略。

1019

1019

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?