一. AlexNet网络结构

2012年,该网络ILSVRC-2012图像分类的冠军,top-5的识别错误率为15.3%, 比第二名高出10个百分点。

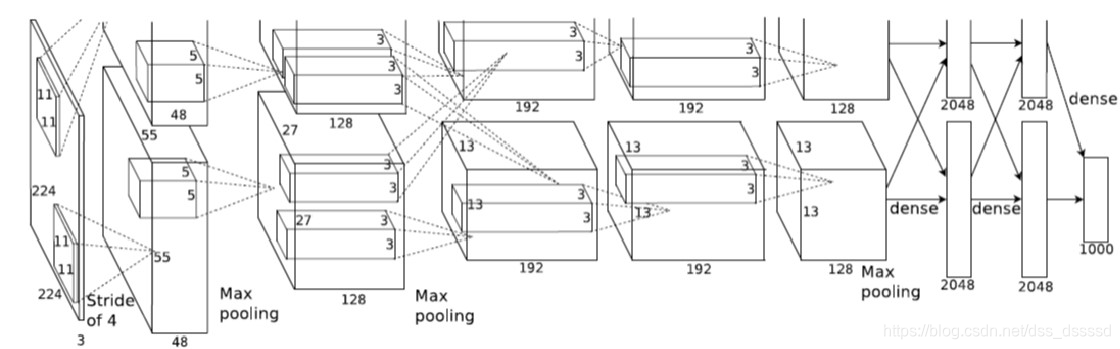

- 下面是论文中的网络结构:

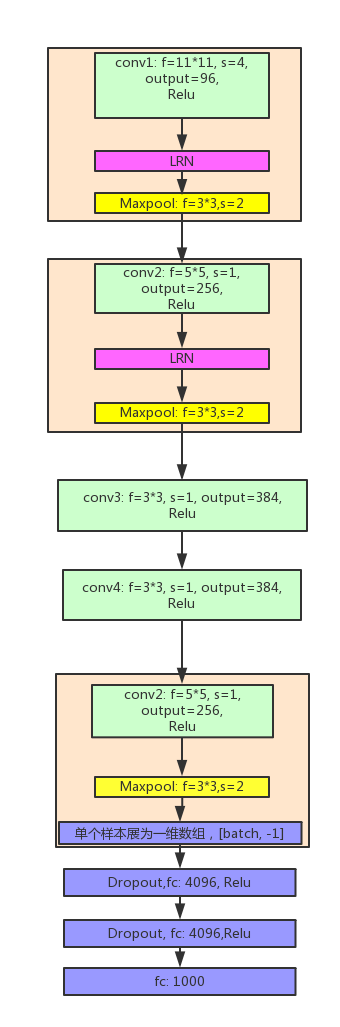

原始网络将模型分为两部分,分开在两个GPU上训练,与下面合并的网络结构等价:

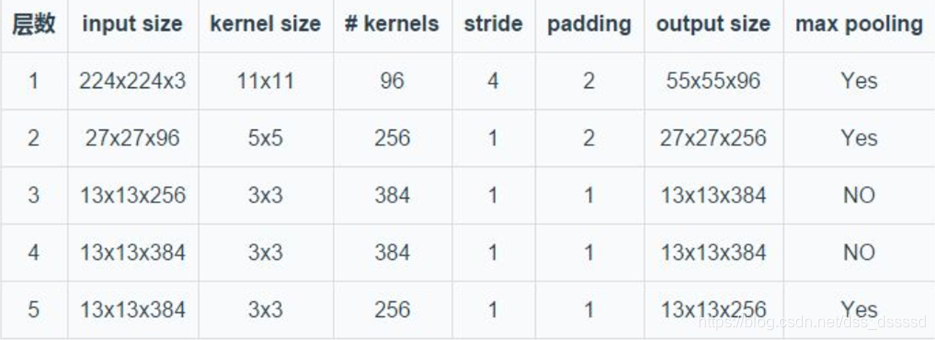

- 各部分网络结构的参数及输入输出图像大小计算:

二. AlexNet的意义及技术优势

1. 在神经网络罗发展历史上的重要意义

- 证明了CNN在复杂模型下的有效性

- 使用GPU训练可以在可接受的时间内得到结果

以上两点推动了深层网络结构的构建以及采用GPU的加速训练方法 。

2. 技术上引进新的思想

-

激活函数使用Relu, 不再使用sigmoid和tanh函数,其优势在于收敛速度更快,使得训练时间更短, 已成为卷积神经网络最常用的激活函数。https://blog.youkuaiyun.com/NOT_GUY/article/details/78749509

函数形式: f ( x ) = m a x ( 0 , x ) f(x) = max(0, x) f(x)

本文详细介绍了AlexNet的网络结构及其在深度学习历史上的重要意义,包括使用ReLU激活函数、局部响应归一化层以及重叠最大池化的技术突破。此外,还探讨了AlexNet如何通过数据扩增、Dropout等方法减轻过拟合,并简要提及PyTorch中的实现细节。

本文详细介绍了AlexNet的网络结构及其在深度学习历史上的重要意义,包括使用ReLU激活函数、局部响应归一化层以及重叠最大池化的技术突破。此外,还探讨了AlexNet如何通过数据扩增、Dropout等方法减轻过拟合,并简要提及PyTorch中的实现细节。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

646

646

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?