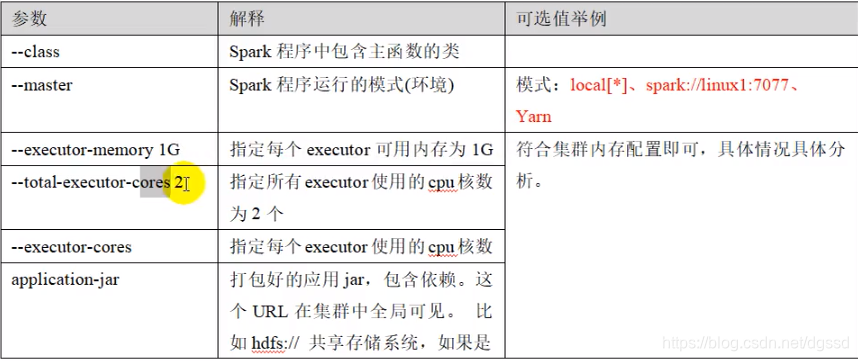

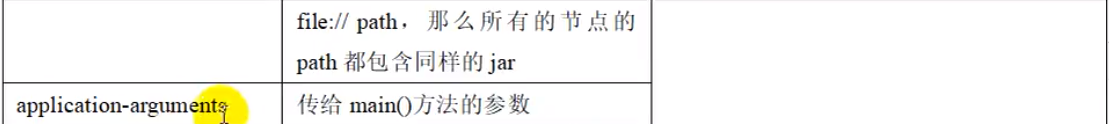

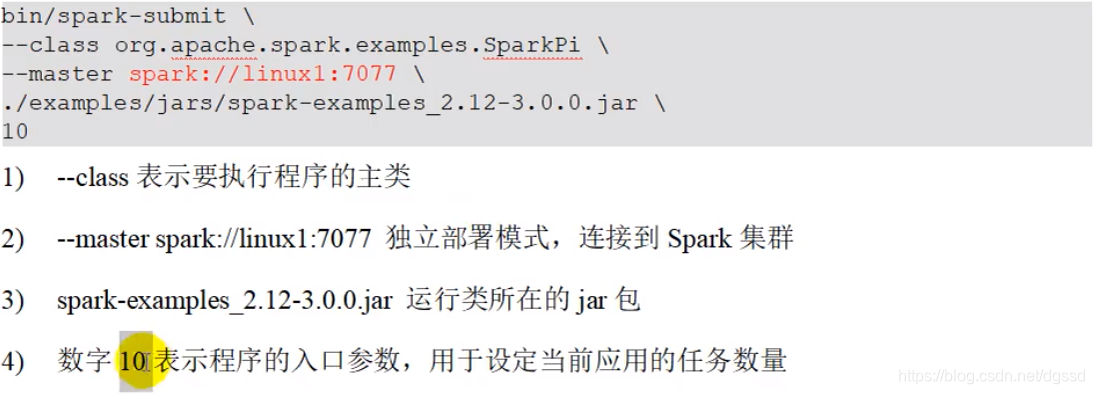

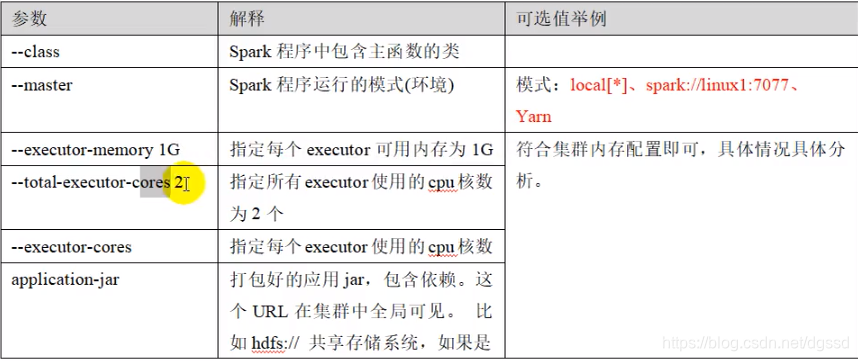

Spark-Spark提交参数配置

最新推荐文章于 2023-11-27 23:47:23 发布

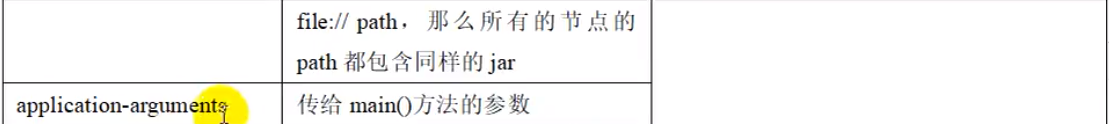

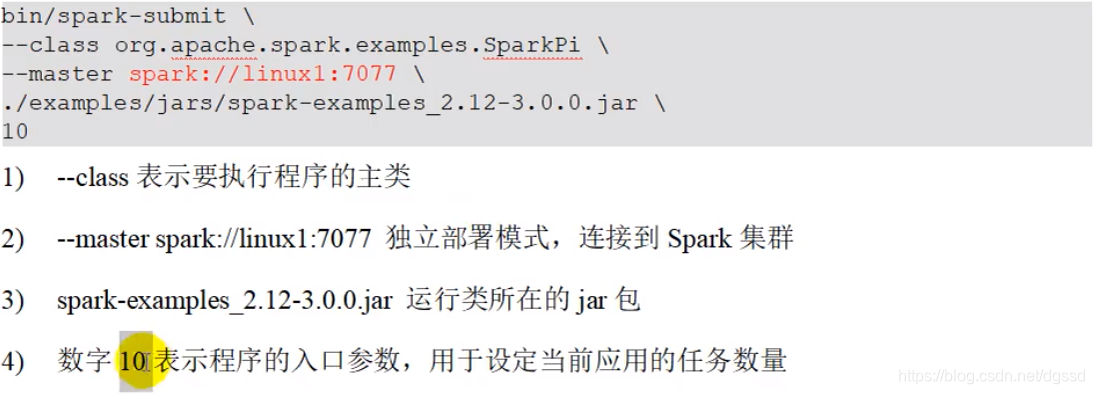

博客围绕Spark提交参数配置展开,虽未给出具体内容,但可知聚焦于Spark在提交任务时相关参数的设置,这在大数据开发中对Spark性能调优、任务顺利执行等有重要意义。

博客围绕Spark提交参数配置展开,虽未给出具体内容,但可知聚焦于Spark在提交任务时相关参数的设置,这在大数据开发中对Spark性能调优、任务顺利执行等有重要意义。

博客围绕Spark提交参数配置展开,虽未给出具体内容,但可知聚焦于Spark在提交任务时相关参数的设置,这在大数据开发中对Spark性能调优、任务顺利执行等有重要意义。

博客围绕Spark提交参数配置展开,虽未给出具体内容,但可知聚焦于Spark在提交任务时相关参数的设置,这在大数据开发中对Spark性能调优、任务顺利执行等有重要意义。

2794

2794

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?