<think>我们被要求解释一个使用Keras构建的深度学习模型,该模型包含ConvLSTM2D、TimeDistributed、LayerNormalization、SpatialDropout2D和Conv2D等层。首先,我们需要查看用户提供的代码,但用户并没有给出具体的代码,而是描述了一个函数`build_model(input_shape)`。然而,在之前的引用中,用户提供了一段Keras代码,但那段代码与现在描述的不完全一致(之前的引用代码中使用了ConvLSTM2D、BatchNormalization和Conv2D,没有提到TimeDistributed、LayerNormalization和SpatialDropout2D)。因此,我们需要根据用户现在的问题来解释包含这些层的模型。

由于用户没有提供具体的代码,我们只能根据常见的网络结构和层的作用进行解释。不过,根据用户的问题描述,模型包含以下层:

- ConvLSTM2D

- TimeDistributed

- LayerNormalization

- SpatialDropout2D

- Conv2D

这样的组合通常用于处理时空序列数据,例如视频预测、天气预测等。下面我们将逐一解释这些层的作用,并构建一个可能的模型结构。

### 模型结构解释

1. **ConvLSTM2D层**:

ConvLSTM2D是LSTM(长短期记忆网络)的卷积版本,用于处理具有空间信息的序列数据(如图像序列)。它在时间步上使用卷积操作来捕捉空间特征,同时保留LSTM的时间依赖性。在视频预测中,ConvLSTM2D可以学习帧与帧之间的时空特征。

- 参数说明:通常需要指定`filters`(卷积核数量)、`kernel_size`(卷积核尺寸)、`padding`(填充方式,如'same'或'valid')、`activation`(激活函数)和`return_sequences`(是否返回整个序列)等。

2. **TimeDistributed层**:

TimeDistributed包装器用于将同一个层独立地应用到时间序列的每一个时间步。例如,如果我们有一个包含多个时间步的序列,每个时间步是一个图像,那么使用`TimeDistributed(Conv2D(...))`将会对每个时间步的图像都应用同一个Conv2D层。这样可以在时间维度上共享权重,同时提取每个时间步的空间特征。

3. **LayerNormalization层**:

层归一化(Layer Normalization)用于对每个样本的每个时间步的特征进行归一化,使得网络训练更稳定。与BatchNormalization(按批次归一化)不同,LayerNormalization是在单个样本上对所有特征进行归一化,因此对小批次大小不敏感,适用于动态网络结构(如RNN)。

4. **SpatialDropout2D层**:

空间丢弃(SpatialDropout2D)是Dropout的一种变体,它会对整个特征图进行丢弃,而不是单个元素。在图像数据中,这意味着如果某个特征图被丢弃,那么整个通道(即特征图)都会被置零。这样可以增强卷积网络的泛化能力,防止过拟合。

5. **Conv2D层**:

二维卷积层,用于提取空间特征。在时空序列模型中,通常用于处理每个时间步的特征图,将其映射到所需的输出空间(如预测下一帧的图像)。

### 模型构建示例

根据用户描述,我们可以构建一个示例模型(由于没有具体代码,以下为推测结构)。假设我们构建一个用于视频帧预测的模型,输入为连续的多帧图像,输出为下一帧。

```python

from keras.models import Sequential

from keras.layers import ConvLSTM2D, TimeDistributed, Conv2D, LayerNormalization, SpatialDropout2D

def build_model(input_shape):

model = Sequential()

# 第一个ConvLSTM2D层,返回整个序列(因为后面还有ConvLSTM2D层)

model.add(ConvLSTM2D(filters=64, kernel_size=(3,3), padding='same',

activation='tanh', return_sequences=True,

input_shape=input_shape))

model.add(LayerNormalization()) # 层归一化

model.add(SpatialDropout2D(0.2)) # 空间丢弃

# 第二个ConvLSTM2D层,返回整个序列

model.add(ConvLSTM2D(filters=32, kernel_size=(3,3), padding='same',

activation='tanh', return_sequences=True))

model.add(LayerNormalization())

model.add(SpatialDropout2D(0.2))

# 第三个ConvLSTM2D层,不返回序列(只返回最后一个时间步)

model.add(ConvLSTM2D(filters=16, kernel_size=(3,3), padding='same',

activation='tanh', return_sequences=False))

model.add(LayerNormalization())

# 由于最后一个ConvLSTM2D层返回的是单个时间步(即最后一帧的特征图),我们需要将其扩展为时间序列(单帧)以匹配输出

# 但注意:如果输出是单帧,则不需要TimeDistributed。如果输出是多帧,则需要调整。

# 假设我们输出单帧,那么可以直接用Conv2D

# 使用Conv2D生成输出帧(单帧)

model.add(Conv2D(filters=1, kernel_size=(3,3), padding='same', activation='sigmoid'))

return model

```

### 各层作用总结

- **ConvLSTM2D**:提取输入序列(多帧)的时空特征。前两个ConvLSTM2D层返回整个序列(`return_sequences=True`),以便后续层继续处理时间序列;最后一层返回最后一个时间步的特征(`return_sequences=False`)。

- **LayerNormalization**:在每个时间步后归一化特征,加速训练并提高模型稳定性。

- **SpatialDropout2D**:随机丢弃整个特征图,减少过拟合。

- **Conv2D**:将最后一层ConvLSTM2D输出的特征图(代表学习到的时空特征)转换为预测帧(单通道图像)。

### 模型输入输出

- **输入形状**:`input_shape`应为`(timesteps, height, width, channels)`,例如(10, 128, 128, 1)表示10帧128x128的灰度图像。

- **输出形状**:由于最后一层Conv2D输出单帧,形状为`(height, width, channels)`,例如(128,128,1)。

### 模型训练

模型编译时,通常选择适当的损失函数(如均方误差MSE用于回归问题)和优化器(如Adam)。

```python

model = build_model(input_shape=(10,128,128,1))

model.compile(loss='mse', optimizer='adam')

model.summary()

```

### 总结

该模型通过多个ConvLSTM2D层逐步提取时空特征,中间使用层归一化和空间丢弃来提升训练稳定性和泛化能力,最后通过Conv2D层输出预测帧。这种结构适用于需要从序列数据中学习时空依赖关系的任务,如视频预测、气象预测等[^1][^3]。

§§相关问题§§

1. 在时空序列预测中,ConvLSTM2D与3D卷积相比有什么优势?

2. 层归一化(LayerNormalization)与批归一化(BatchNormalization)在序列模型中如何选择?

3. 如何调整模型结构以预测多帧输出(而不仅仅是下一帧)?

4. 在训练这种模型时,有哪些防止过拟合的策略?

</think>### 解释 Keras 模型结构

以下是对包含 `ConvLSTM2D`、`TimeDistributed`、`LayerNormalization`、`SpatialDropout2D` 和 `Conv2D` 层的深度学习模型的详细解析。该模型适用于处理时空序列数据(如视频预测、气象数据等),其结构设计兼顾时空特征提取和训练稳定性。

#### **1. 核心层功能解析**

1. **`ConvLSTM2D` 层**

- **作用**:处理具有空间维度的时序数据(如视频帧序列),在保留时序依赖的同时提取空间特征[^1][^3]。

- **关键参数**:

- `filters`:卷积核数量(特征图深度)

- `kernel_size`:卷积窗口尺寸(如 `(3,3)`)

- `padding='same'`:保持特征图尺寸不变(通过零填充)[^2]

- `return_sequences=True`:输出完整时序(供后续层处理)

2. **`TimeDistributed` 层**

- **作用**:将指定层(如 `Conv2D`)独立应用于时序中的每一帧,实现**逐帧空间特征提取**[^4]。

- **典型用法**:

```python

TimeDistributed(Conv2D(filters, kernel_size)) # 对每帧执行2D卷积

```

3. **`LayerNormalization` 层**

- **作用**:沿特征维度归一化激活值(非批次维度),加速收敛并减少对批次大小的敏感度[^5]。

- **优势**:比 `BatchNormalization` 更适用于可变长度序列(如视频)[^5]。

4. **`SpatialDropout2D` 层**

- **作用**:随机丢弃**整个特征图通道**(非单个像素),强制模型学习冗余特征表达,有效抑制过拟合[^2]。

- **与标准 Dropout 区别**:保留通道内空间相关性,更适合卷积特征图。

5. **`Conv2D` 层**

- **作用**:提取单帧的空间特征,通常作为输出层生成预测结果(如下一帧图像)[^1]。

- **关键参数**:

- `filters=1`:输出单通道(如灰度图预测)

- `padding='same'`:保持输出尺寸与输入一致[^2]

---

#### **2. 模型结构示例与流程**

以下是一个典型的视频预测模型结构(基于问题描述):

```python

from keras.models import Sequential

from keras.layers import ConvLSTM2D, TimeDistributed, LayerNormalization, SpatialDropout2D, Conv2D

def build_model(input_shape):

model = Sequential()

# 第一层:ConvLSTM2D(返回完整序列)

model.add(ConvLSTM2D(

filters=64,

kernel_size=(3, 3),

padding='same',

activation='tanh',

return_sequences=True, # 输出整个时序

input_shape=input_shape # 如 (6, 128, 128, 1) 表示6帧128x128灰度图

))

# 归一化与正则化

model.add(LayerNormalization())

model.add(SpatialDropout2D(0.2)) # 丢弃20%特征图通道

# 第二层:ConvLSTM2D(仅返回末帧)

model.add(ConvLSTM2D(

filters=32,

kernel_size=(3, 3),

padding='same',

activation='tanh',

return_sequences=False # 仅输出最后一帧特征

))

# 输出层:通过TimeDistributed逐帧生成预测

model.add(TimeDistributed(Conv2D(

filters=1, # 预测单通道图像

kernel_size=(3, 3),

padding='same',

activation='sigmoid' # 像素值归一化到[0,1]

)))

model.compile(loss='mse', optimizer='adam')

return model

```

##### **数据处理流程**

1. **输入**:形状为 $(T, H, W, C)$ 的时序数据(如 6 帧 $128 \times 128$ 灰度图)

2. **时空特征提取**:

- 第一层 `ConvLSTM2D` 提取时序特征,输出形状 $(T, H, W, 64)$

- `LayerNormalization` 和 `SpatialDropout2D` 提升训练稳定性

3. **时序聚合**:第二层 `ConvLSTM2D` 聚合时序信息,输出形状 $(H, W, 32)$(末帧特征)

4. **空间重建**:`TimeDistributed(Conv2D)` 将特征解码为预测帧,输出形状 $(T_{\text{pred}}, H, W, 1)$

---

#### **3. 设计原理与优势**

1. **时空特征分离**:

- `ConvLSTM2D` 捕获帧间动态变化

- `Conv2D` 专注单帧空间结构

2. **训练优化**:

- `LayerNormalization` 解决序列数据内部协变量偏移[^5]

- `SpatialDropout2D` 抑制卷积特征图间的共适应性[^2]

3. **灵活输出**:

- 通过调整 `TimeDistributed` 可生成多帧预测(如未来 $k$ 帧)

- 输出层激活函数选择(如 `sigmoid` 用于像素回归)

---

#### **4. 典型应用场景**

1. **视频预测**:预测下一帧或多帧画面(如天气雷达回波预测)

2. **动作识别**:从视频片段中识别动作类别

3. **医学影像分析**:处理动态 MRI 或 CT 序列

该模型通过融合时空特征提取与序列建模能力,在保留空间细节的同时学习长期时序依赖,是处理动态视觉数据的强大工具[^1][^3][^5]。

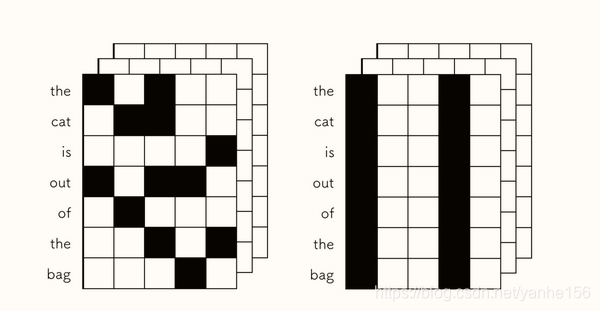

本文详细解析了Dropout()和SpatialDropout1D()的区别,通过实例演示了两者如何在不同维度上进行dropout操作。同时,文章还介绍了如何通过调整Dropout()的noise_shape参数来模拟SpatialDropout的效果,以及SpatialDropout系列函数在不同输入形状下的应用。

本文详细解析了Dropout()和SpatialDropout1D()的区别,通过实例演示了两者如何在不同维度上进行dropout操作。同时,文章还介绍了如何通过调整Dropout()的noise_shape参数来模拟SpatialDropout的效果,以及SpatialDropout系列函数在不同输入形状下的应用。

3473

3473

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?