最新案例动态,请查阅基于华为开发者空间云主机——5分钟让华为云主机加持 DeepSeek。小伙伴们快来领取华为开发者空间进行实操吧!

1 概述

1.1 案例介绍

华为开发者空间,是为全球开发者打造的专属开发者空间,致力于为每位开发者提供一台云主机、一套开发工具和云上存储空间,汇聚昇腾、鸿蒙、鲲鹏、GaussDB、欧拉等华为各项根技术的开发工具资源,并提供配套案例指导开发者 从开发编码到应用调测,基于华为根技术生态高效便捷的知识学习、技术体验、应用创新。

免费领取开发者空间云主机

→ PC端

→ 移动端

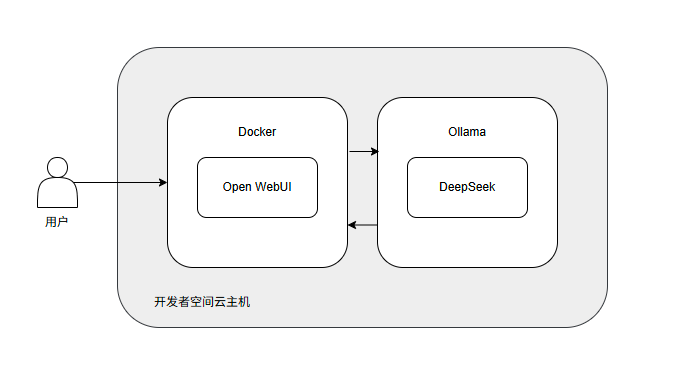

本案例演示如何在华为开发者空间云主机上,一步步完成Open WebUI环境搭建及 DeepSeek模型接入,并进行简单的文本生成任务。

1.2 适用对象

-

企业研发团队

-

AI/ML 爱好者

-

高校师生

1.3 案例时间

本案例总时长预计60分钟。

1.4 案例流程

说明:

-

打开华为开发者空间云主机;

-

安装并启动Ollama模型服务;

-

安装Open WebUI;

-

使用Ollama部署DeepSeek模型;

-

通过Open WebUI使用DeepSeek进行聊天交互。

1.5 资源总览

本案例预计花费0元。

| 资源名称 | 规格 | 单价(元) | 时长(分钟) |

| 开发者空间–云主机 | 4 vCPUs 8 GB Ubuntu 24.04 Server 定制版 | 0 | 60 |

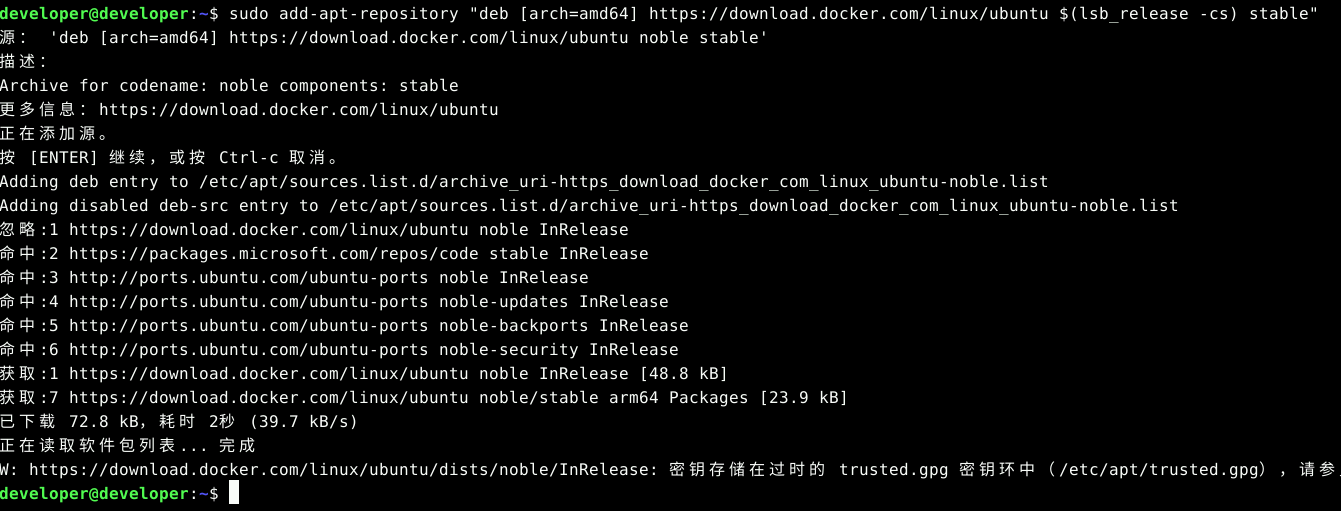

2 环境配置

2.1 开发者空间配置

面向广大开发者群体,华为开发者空间提供一个随时访问的“开发桌面云主机”、丰富的“预配置工具集合”和灵活使用的“场景化资源池”,开发者开箱即用,快速体验华为根技术和资源。

如果还没有领取开发者空间云主机,可以参考免费领取云主机文档领取。

领取云主机后可以直接进入华为开发者空间工作台界面,点击打开云主机 > 进入桌面连接云主机。

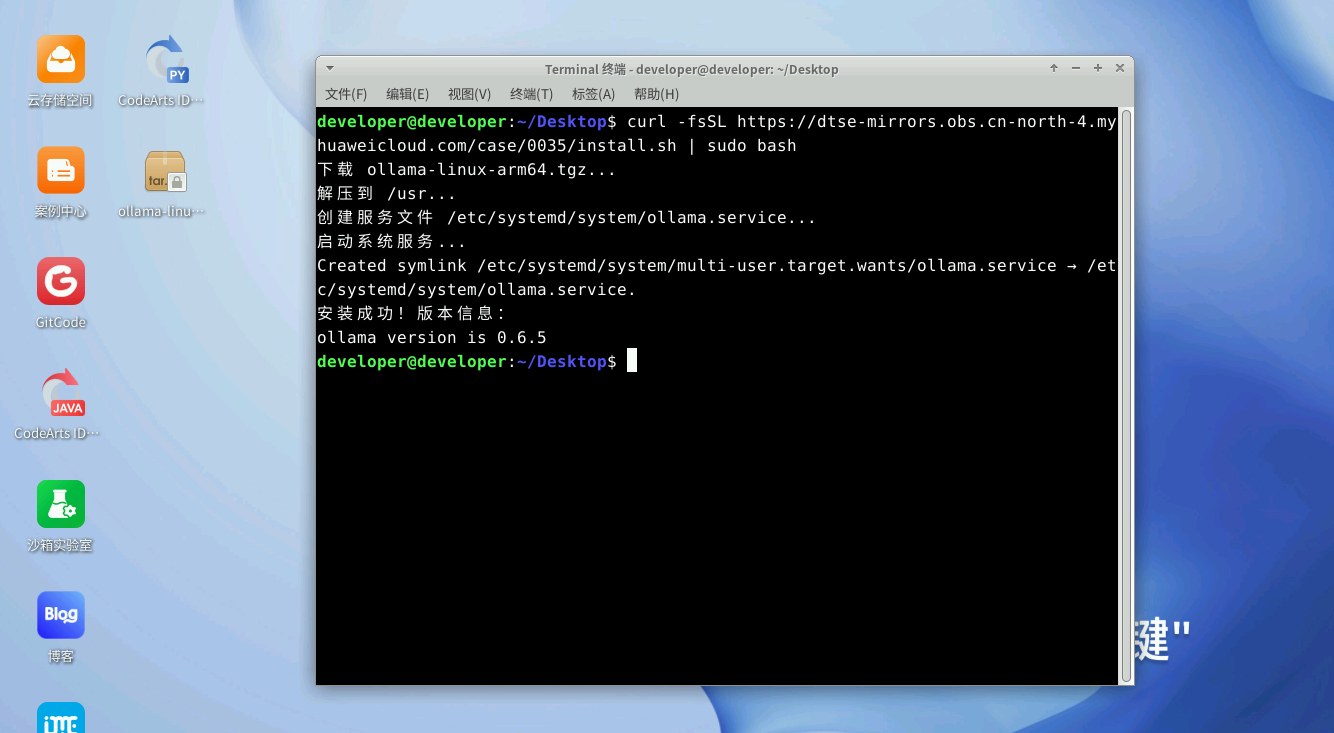

2.2 安装 Ollama

Ollama 是一个强大的开源工具,旨在帮助用户轻松地在本地运行、部署和管理大型语言模型(LLMs)。它提供了一个简单的命令行界面,使用户能够快速下载、运行和与各种预训练的语言模型进行交互。Ollama 支持多种模型架构,并且特别适合那些希望在本地环境中使用 LLMs 的开发者和研究人员。

# 安装Ollama脚本

curl -fsSL https://dtse-mirrors.obs.cn-north-4.myhuaweicloud.com/case/0035/install.sh | sudo bash

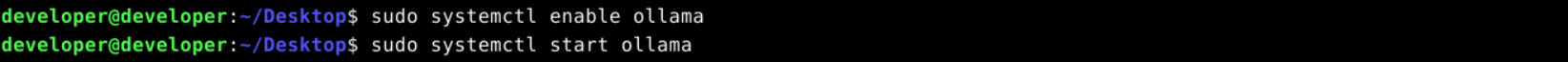

设置并启动Ollama服务。

sudo systemctl enable ollama

sudo systemctl start ollama

接下来可以根据需要,借助 Ollama 工具来部署大模型。

2.3 安装Open WebUI

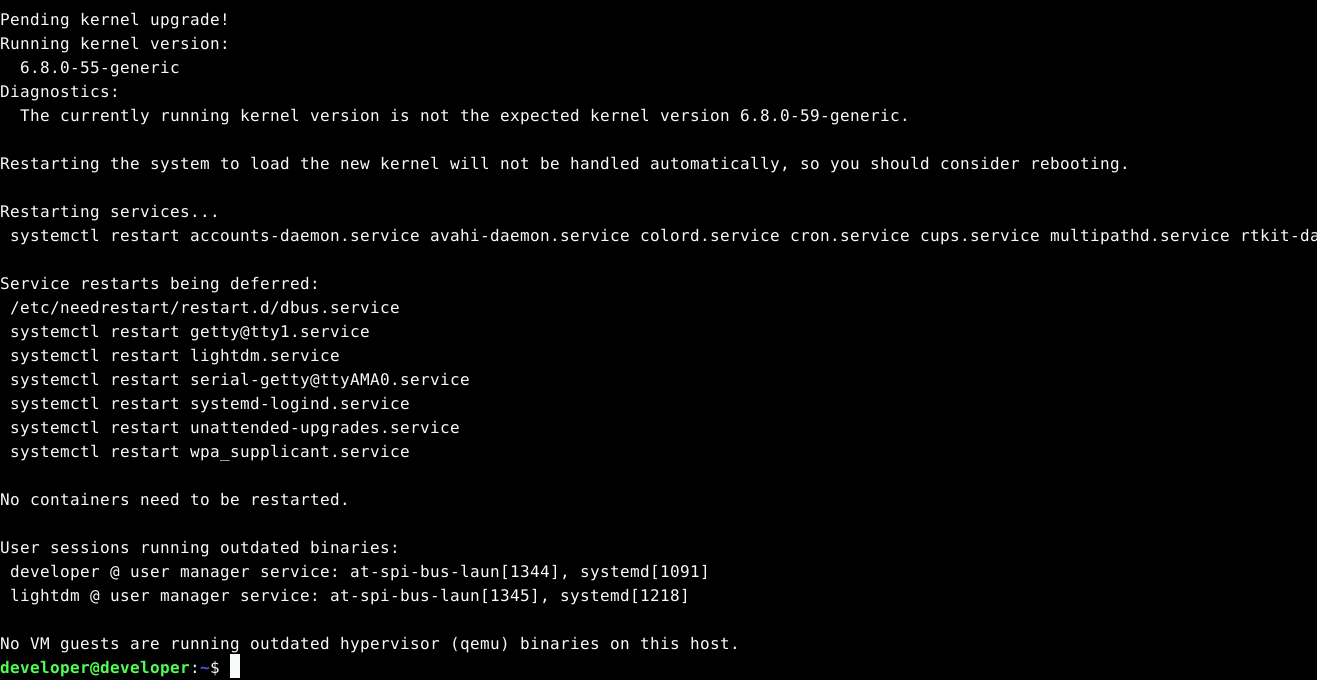

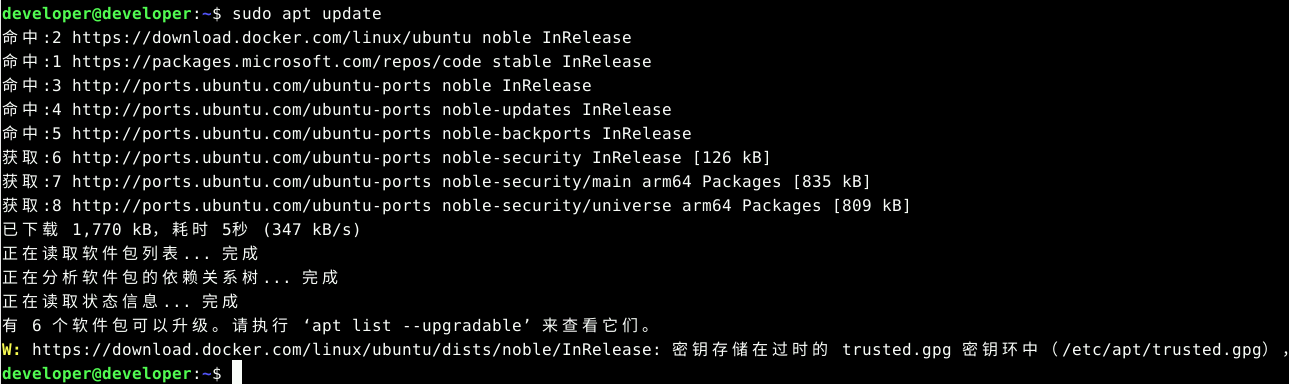

打开云主机命令行窗口输入以下命令,更新软件包。

sudo apt update

sudo apt upgrade -y

卸载旧版本Docker(如果已安装)。

sudo apt-get remove docker docker-engine docker.io containerd runc

安装必要的依赖。

sudo apt install apt-transport-https ca-certificates curl software-properties-common

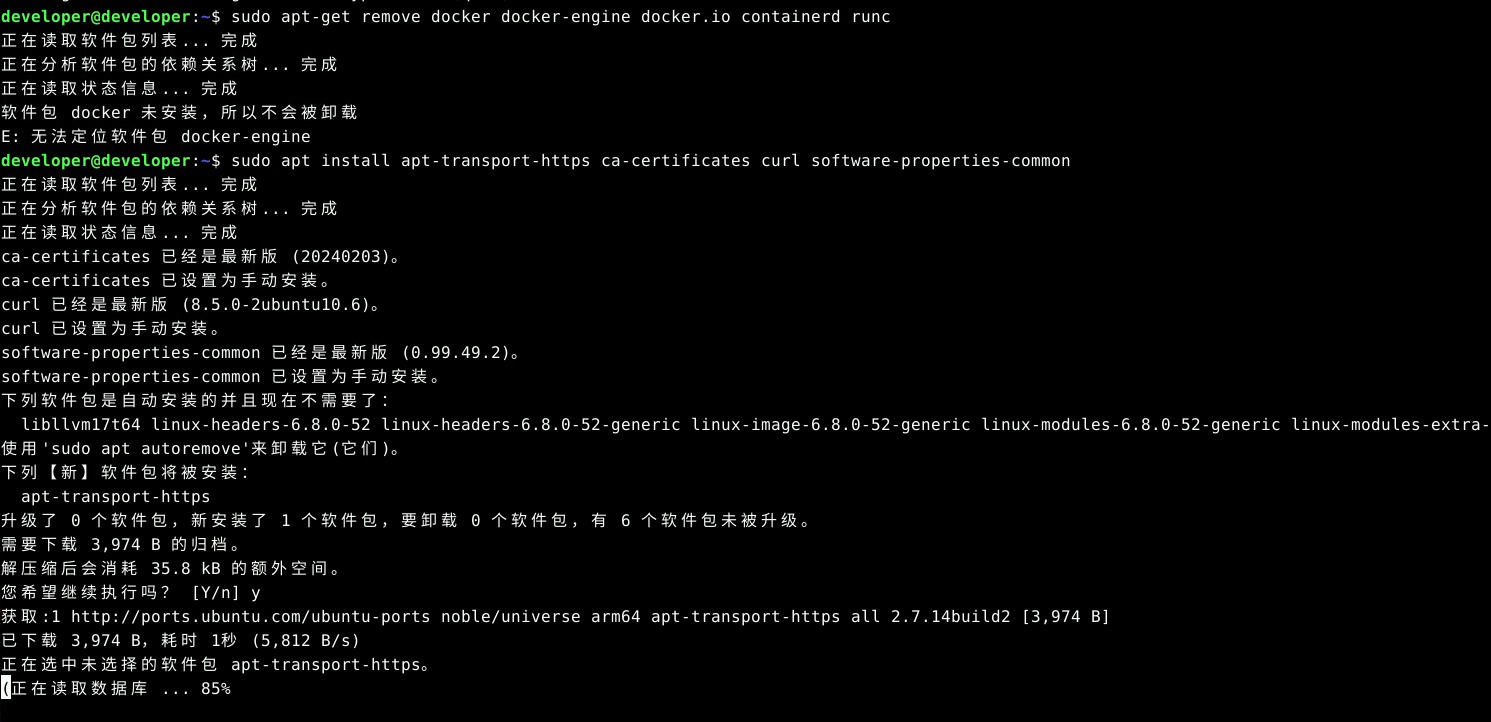

添加Docker的官方GPG密钥。(如果云主机已安装dokcer,且操作上一步卸载再安装,执行该步骤第一次会报找不到OpenPGP,须再次执行)

sudo curl -fsSL https://download.docker.com/linux/ubuntu/gpg | sudo apt-key add -

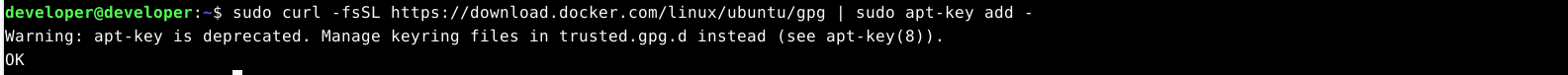

添加Docker的APT源。

sudo add-apt-repository "deb [arch=amd64] https://download.docker.com/linux/ubuntu $(lsb_release -cs) stable"

更新APT包索引。

sudo apt update

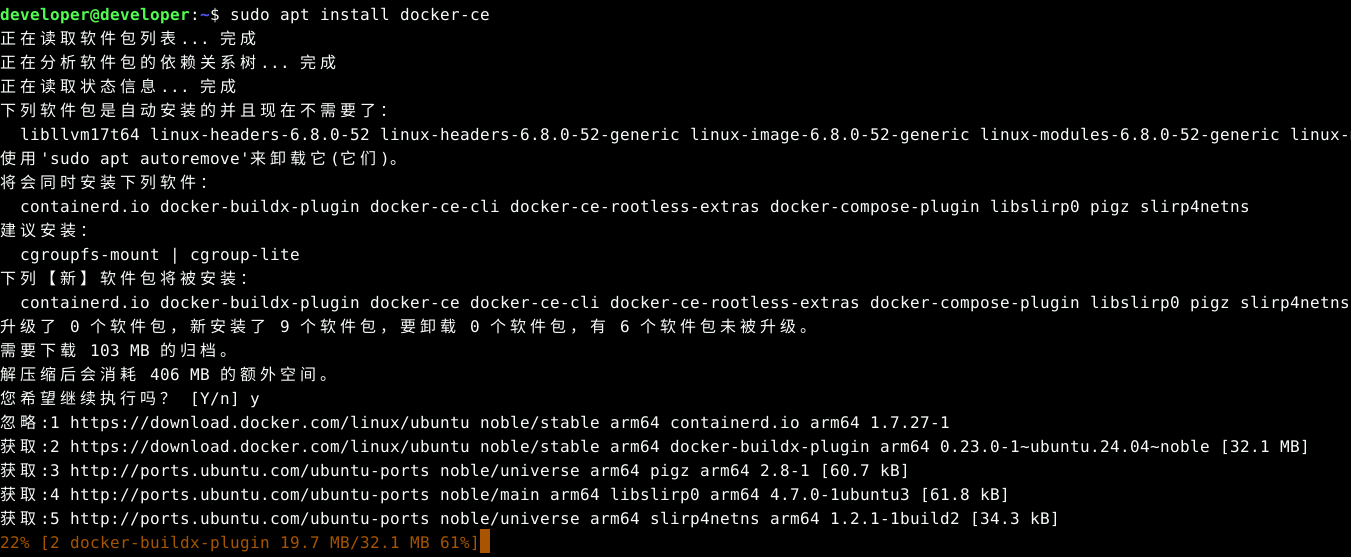

安装Docker CE。

sudo apt install docker-ce

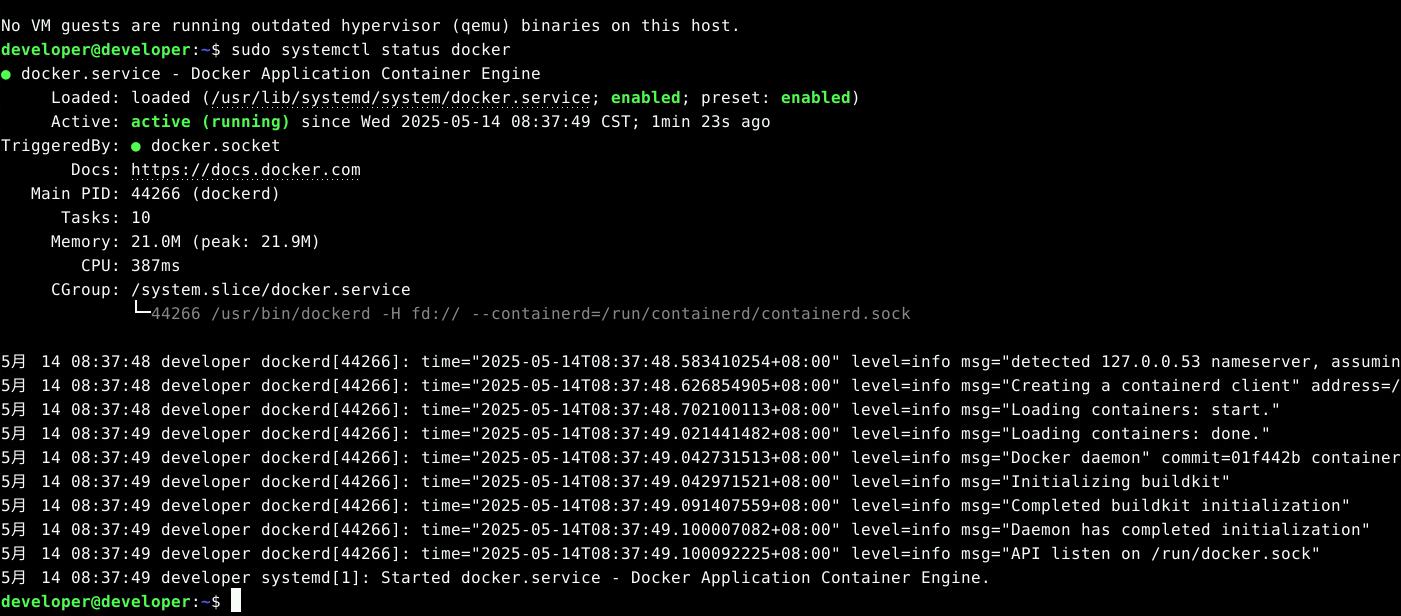

验证Docker是否安装成功。

sudo systemctl status docker

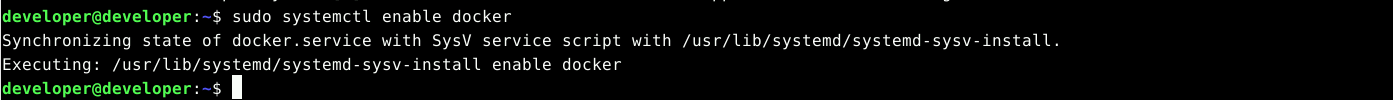

设置Docker自动启动。

sudo systemctl enable docker

安装 Open WebUI。

sudo docker pull ghcr.io/open-webui/open-webui:main

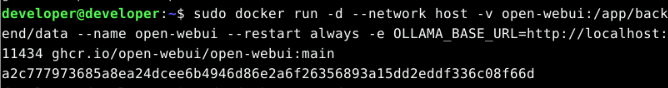

运行 Open WebUI 容器。

sudo docker run -d --network host -v open-webui:/app/backend/data --name open-webui --restart always -e OLLAMA_BASE_URL=http://localhost:11434 ghcr.io/open-webui/open-webui:main

大概等待两分钟,容器可以启动完成。

浏览器输入 localhost:8080,即可访问Open WebUI。

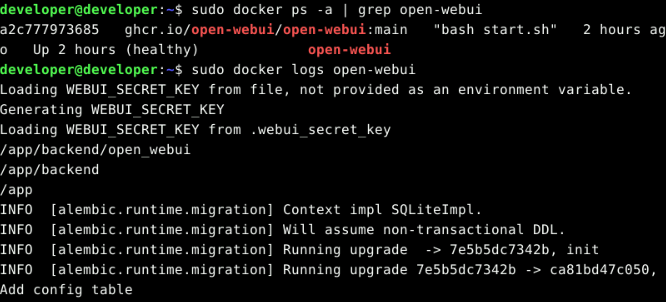

注:如果访问失败,可以输入下面命令查看日志。

# 查看容器状态

sudo docker ps -a | grep open-webui

# 检查日志

sudo docker logs open-webui

3 实战项目

3.1 使用Ollama部署DeepSeek模型

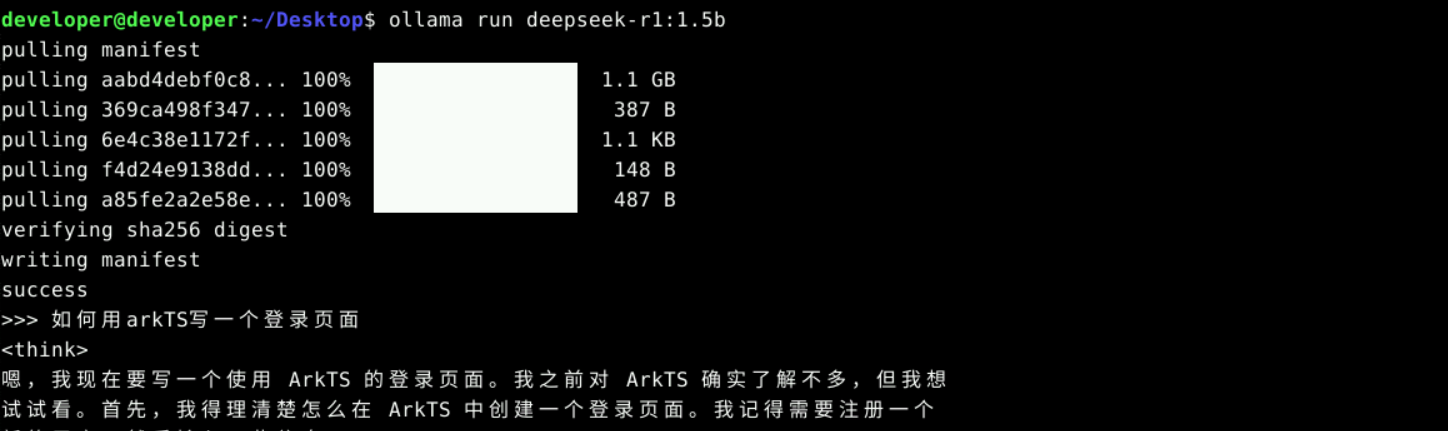

部署 deepseek-r1:1.5b 版本,执行 DeepSeek 的安装命令,安装完成后,DeepSeek 将自动运行。

ollama run deepseek-r1:1.5b

安装完成后,我们可以直接在终端里和 DeepSeek 进行交互。

ctrl + D退出Ollama。

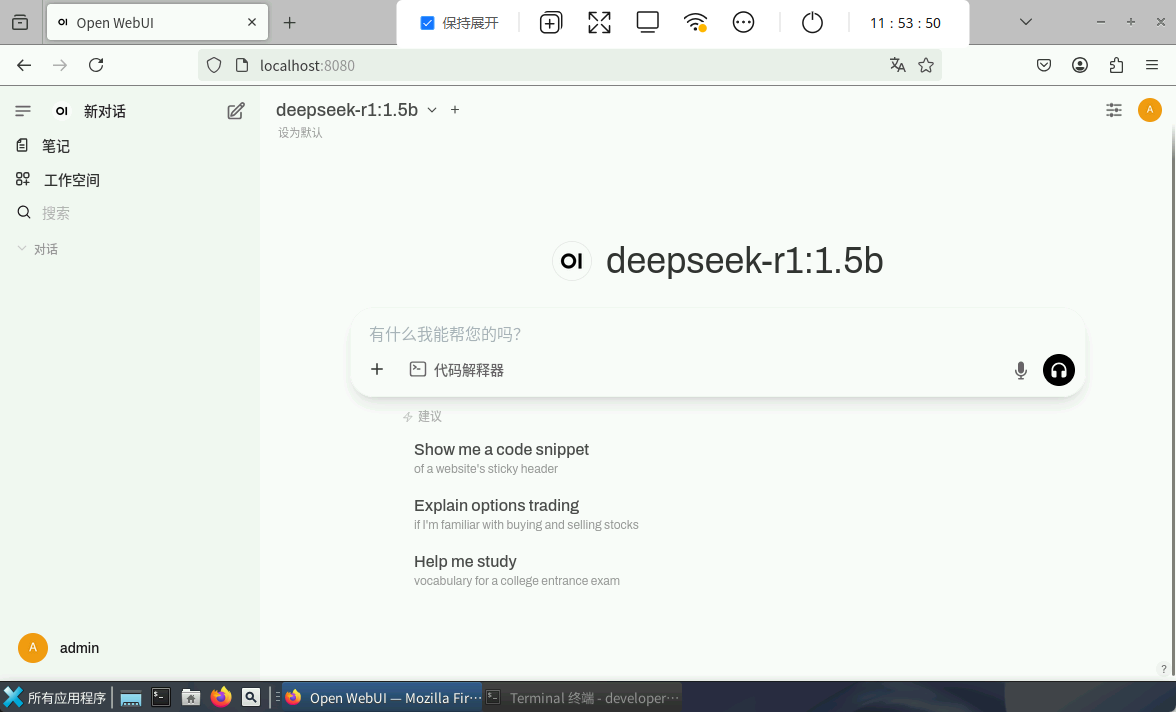

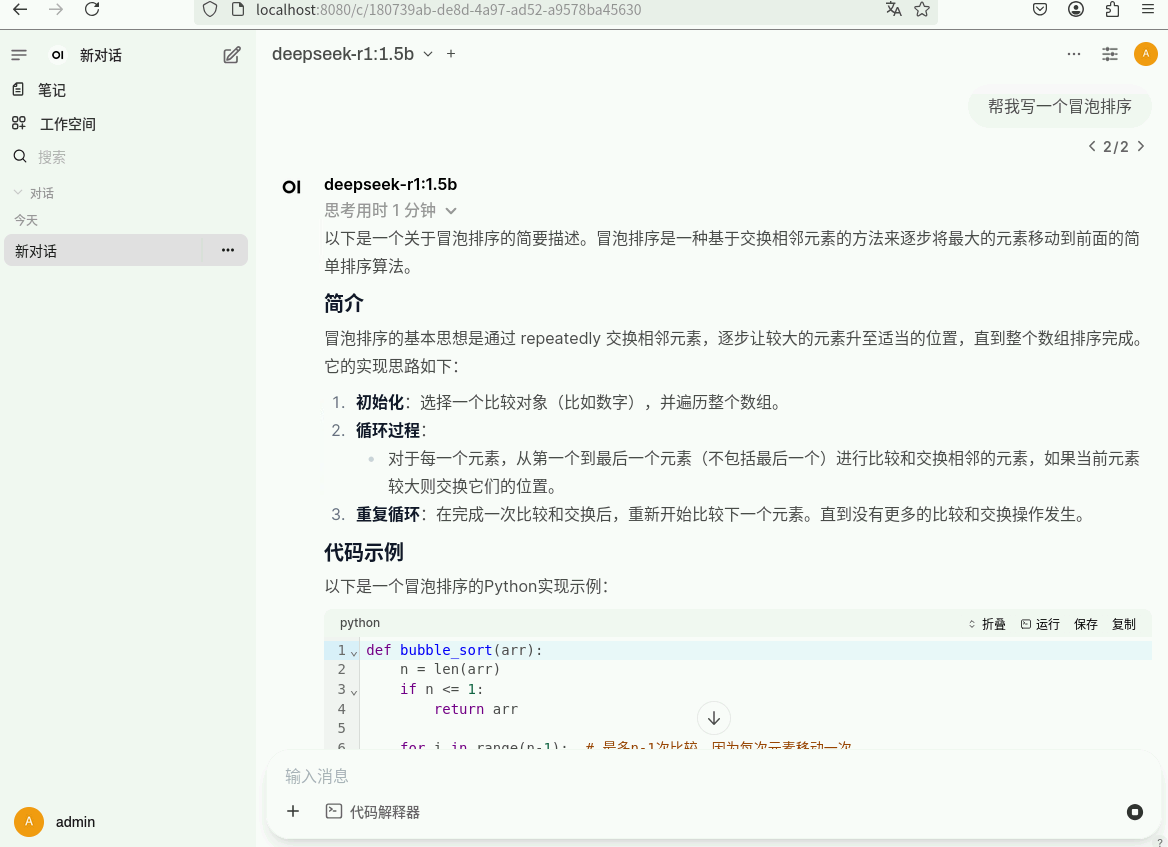

3.2 通过Open WebUI使用DeepSeek进行聊天交互

浏览器输入localhost:8080,访问Open WebUI。

首次登录,需要创建管理员账号。登录后,界面如下:

向deepseek-r1模型提问,比如:“帮我写一个冒泡排序”。

可以看到模型自动回复成功。

以上就是DeepSeek-R1结合Open WebUI的使用。大家可以带着自己想要提问的问题,测试本次部署的应用。

249

249

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?