1.依赖包

| PACKAGE | VERSION |

|---|---|

| python | 3.5 |

| six | 1.10.0 |

| thriftpy | 0.3.9 |

| thrift-sasl | 0.2.1(不能用最新版本) |

| bitarray | 0.8.3 |

| Impyla | 0.14.1 |

| thrift | 0.9.3 |

| pure-sasl | 0.5.1 |

2.修改源文件

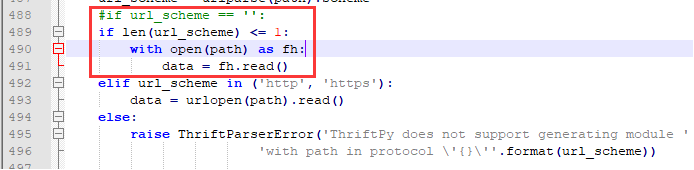

2.1 修改Anaconda3\Lib\site-packages\thriftpy\parser\parser.py文件

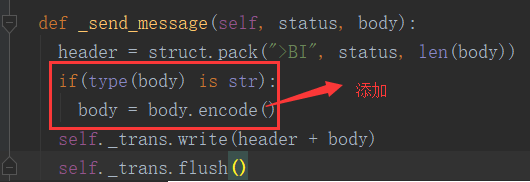

2.2 修改Anaconda3\Lib\site-packages\thrift_sasl\__init__.py

3.注意事项

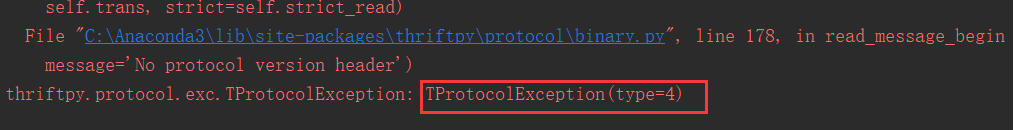

(1)创建连接时,auth_mechanism='PLAIN’必须添加,否则会出现如下错误:

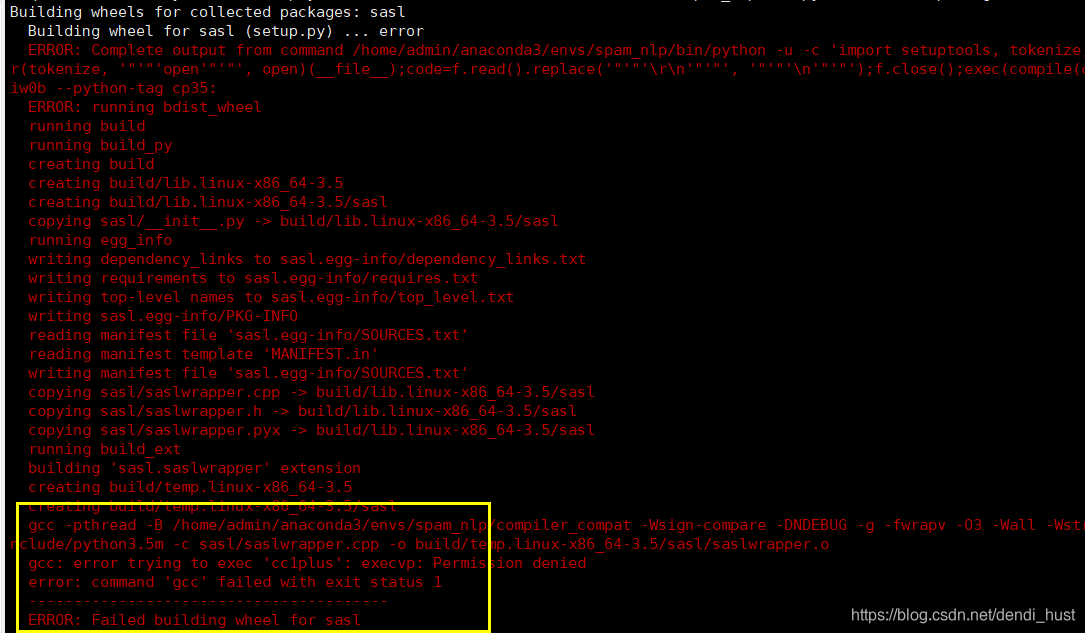

(2)Linux 解决 thrift_sasl 安装失败问题

使用命令安装如下依赖包:

yum install gcc-c++ python-devel.x86_64 cyrus-sasl-devel.x86_64

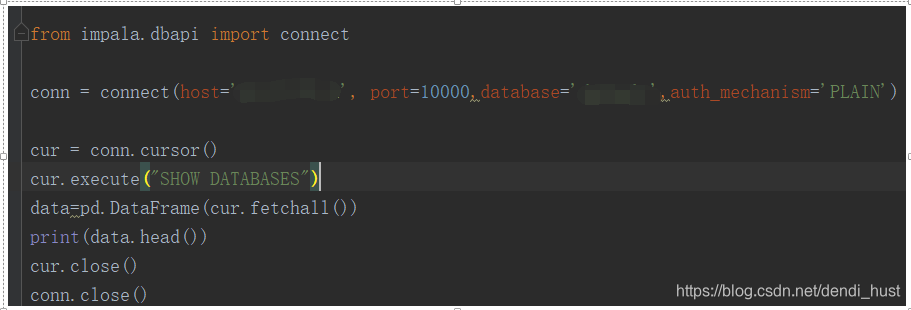

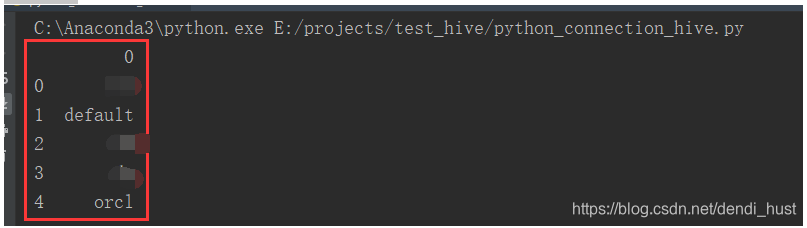

4. DEMO

效果如下:

12

12

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?