attention和self-attention和co-attention

-

Attention和self-attention其具体计算过程是一样的,只是计算对象发生了变化而已。

attention是source对target的attention,

而self attention 是source 对source的attention。

参考材料1

-

co-attention和attention

参考材料2

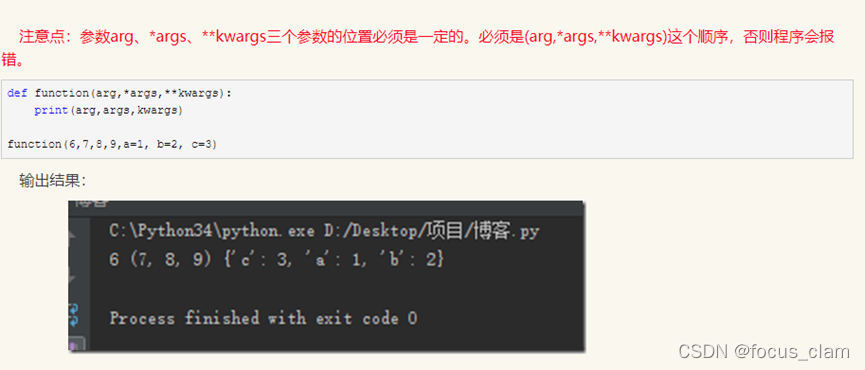

*args和**kwargs

resnet32在cifar100上训练

参考材料3

参考材料4

git如何切换用户

参考材料5

python如何判断一个目录下是否存在某个文件

os.path.exists(filename)

参考材料6

5832

5832

2493

2493

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?