Deep Research:Agent 时代的核心能力

2025 年被称为 Agent 落地元年,在解锁的各类场景中,最有代表性之一,就是 Deep Research 或者以它为基座的各类应用。为什么这么讲? 因为通过 Agentic RAG 及其配套的反思机制,Deep Research 驱动 LLM 在用户自有数据上实现了专用的推理能力,它是 Agent 发掘深层次场景的必经之路。举例来说,让 LLM 帮助创作小说、各行业辅助决策,这些都离不开 Deep Research ,我们可以把 Deep Research 看作 RAG 在 Agent 加持下的自然升级,因为相比朴素 RAG ,Deep Research 确实可以发掘数据内部更深层次的内容,所以跟 RAG 类似 ,它本身既可以是单独的产品,也可以是其他嵌入更多行业 Know-how 的 Agent 基座。

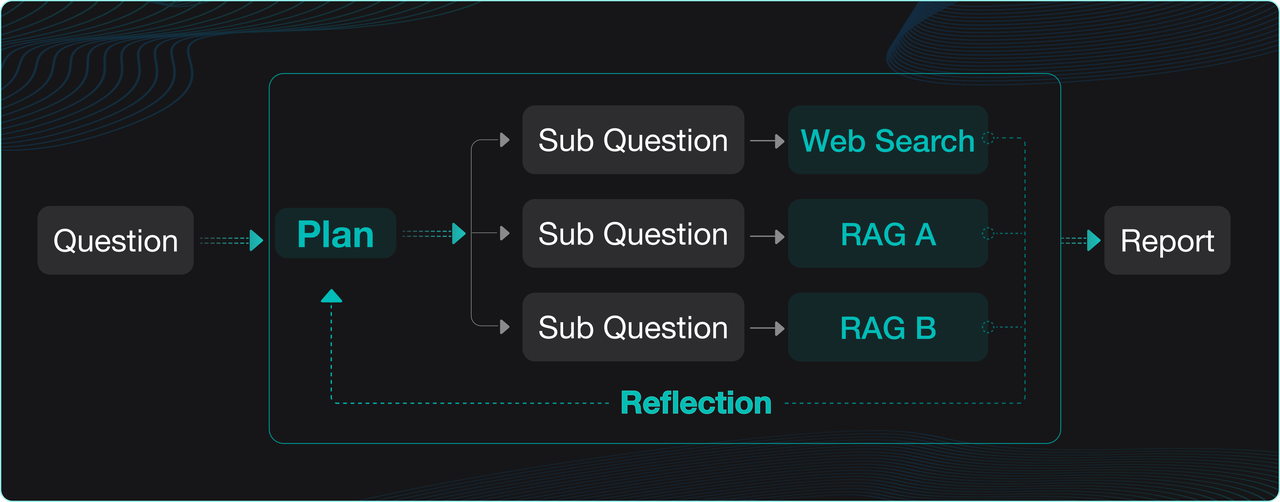

Deep Research 的工作流程大体上都如下图这样:对于用户的提问,先交给 LLM 进行拆解和规划,随后问题被发到不同的数据源,包括内部的 RAG ,也包含外网的搜索,然后这些搜索的结果再次被交给 LLM 进行反思和总结并调整规划,经过几次迭代后,就可以得到针对特定数据的思维链用来生成最终的答案或者报告。

RAGFlow 在 0.18.0 版本,就已经实现了内置的 Deep Research,不过当时更多是作为一种演示,验证和发掘推理能力在企业场景的深度应用。市面上各类软件系统,也有大量的 Deep Research 实现,这些可以分为两类:

-

其一是在 Workflow 界面上通过无代码编排来实现。换而言之,通过工作流来实现 Deep Research。

-

其二是实现专门的 Agent 库或者框架,有很多类似工作,具体可以参见【文献 1】列表。

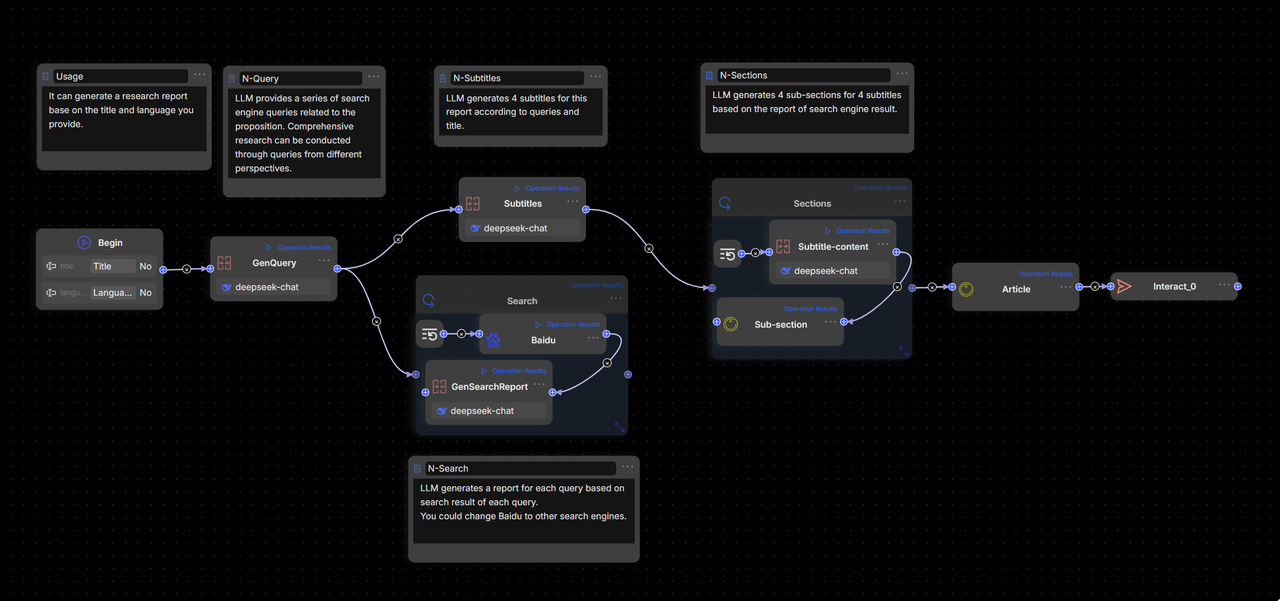

RAGFlow 0.20.0 作为一个同时支持 Workflow 和 Agentic,并且能够在同一画布下统一编排的 RAG + Agent 一体化引擎,可以同时采用这 2 种方式实现 Deep Research,但采用 Workflow 实现 Deep Research,只能说堪用,因为它的画面是这样的:

这会导致 2 个问题:

-

编排复杂且不直观。Deep Research 只是基础模板,尚且如此复杂,那完整的应用将会陷入蜘蛛网密布从而难以维护。

-

Deep Research 天然更适合 Agentic 机制,问题的分解,决策,是一个动态的过程,决策控制的步骤依赖算法,而 Workflow 的拖拉拽只能实现简单的循环机制,难以实现更加高级和灵活的控制。

RAGFlow 0.20.0 实现了完整的 Agent 引擎,但同时,它的设计目标是让多数企业能够利用无代码方式搭建出产品级的 Agent ,Deep Research 作为支撑它的最重要的 Agent 模板,必须尽可能简单且足够灵活。因此相比于目前已知方案,RAGFlow 着重突出这些能力:

-

采用 Agentic 机制实现,但由无代码平台驱动,它是一个可灵活定制的完整应用模板 ,而非 SDK 或者运行库。

-

允许人工干预(后续版本提供)。Deep Research 是由 LLM 生成计划并执行的机制,天然就是 Agentic 的,但这也代表了黑箱和不确定性。RAGFlow 的 Deep Research 模板可以引入人工干预,这为不确定的执行引入了确定性,是企业级应用 Agent 的必备能力。

-

业务驱动和结果导向:开发者可以结合企业的业务场景灵活调整 Deep Research Agent 的架构以及可以使用的工具,例如配置内部知识库检索企业内部资料,快速为业务定制一个 Deep Research Agent。我们暴露了 Agent 所有运作流程、Agent 生成的规划以及执行结果,让开发者可以结合这些信息调整自己的提示词。

Deep Research 搭建实践

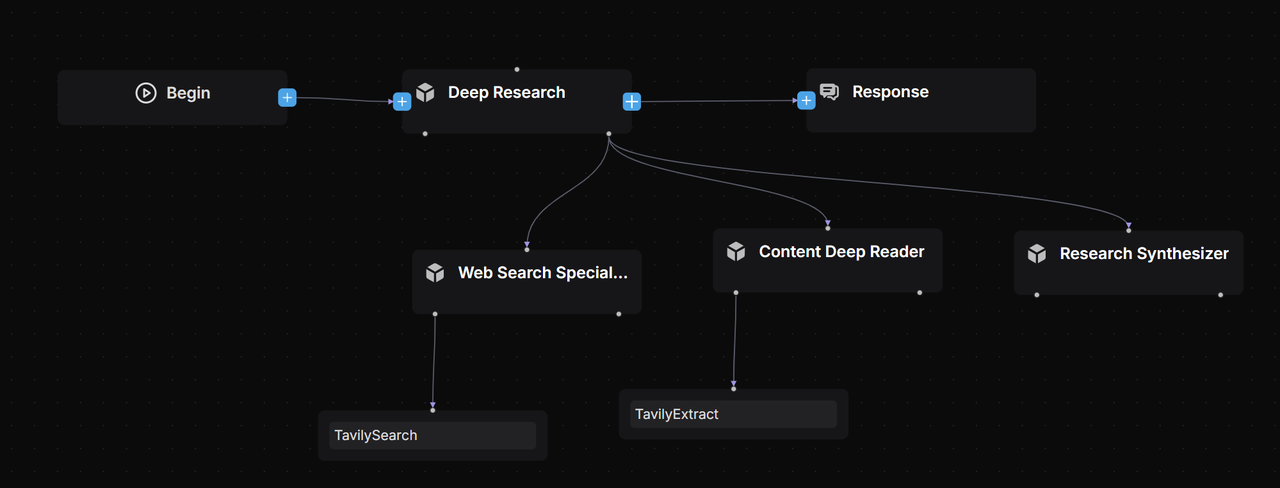

我们采用 Mult-Agent 架构【文献 2】并且通过大量的 Prompt Engineering 【文献 4】编写每个 Agent 的定位和职责边界【文献 6】:

-

Lead Agent:作为 Deep Research Agent 的领导者定位承担任务的规划和反思,拆解任务给 Subagent,记忆所有的工作进程的职责。

-

Web Search Specialist Subagent:承担信息搜索专家的定位,负责调用搜索引擎查找信息并给搜索结果评分返回最高质量信息源的 URL。

-

Deep Content Reader Subagent:承担网络信息阅读专家的定位,通过 Extract 工具阅读和整理搜索专家返回 URL 的正文信息作为撰写最终报告的优质素材。

-

Research Synthesizer Subagent:作为整合信息和生成报告的专家,可以根据 Lead Agent 的需求生成咨询公司标准的专业深度报告。

模型选择:

-

Lead Agent:作为规划者优先选择有强推理能力的模型,例如 DeepSeek r1,通义千问 3,Kimi2,ChatGPT o3,Claude 4,Gemini 2.5 Pro 等。

-

Subagent:作为执行者可以选择推理,执行效率与质量平衡的模型,同时结合其职责定位也需要将模型的 Context Window 长度作为选择标准之一。

<

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

938

938

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?