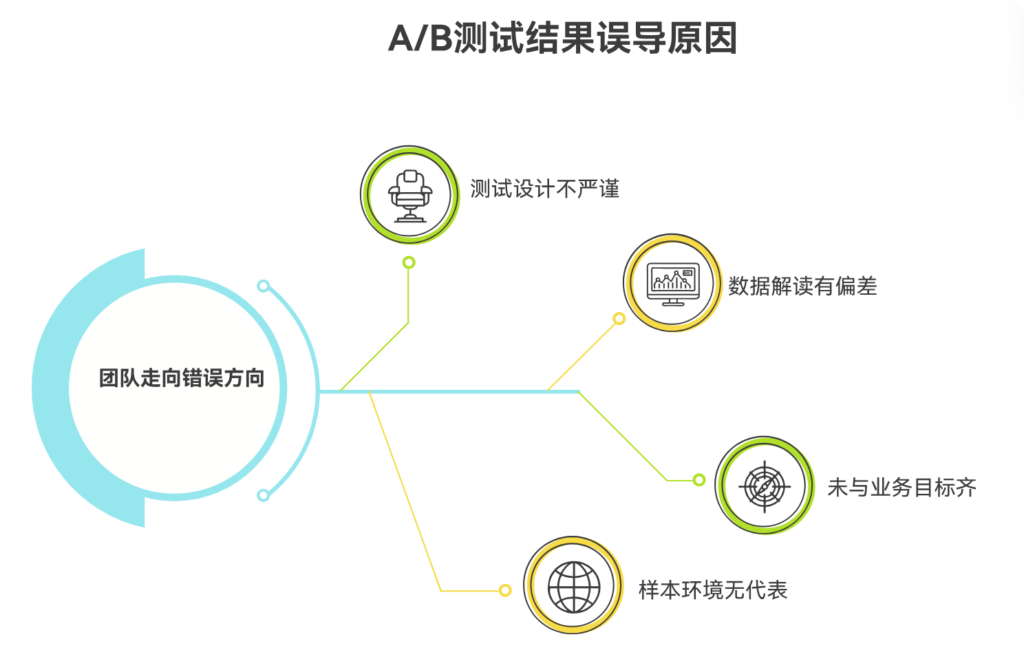

A/B测试之所以会得出误导性的结果,主要原因在于测试设计不严谨、样本与环境不具代表性、数据解读存在偏差,以及未与业务目标对齐。 换句话说,A/B测试不是万能工具,如果方法论错误,它会让团队自信地走向错误方向。正如统计学家 George Box 所说:“所有模型都是错的,但有些模型是有用的。”A/B 测试也是如此,只有科学使用才有价值。

一、测试样本量不足导致结果不具统计意义

许多团队在样本量未达到统计显著水平时就仓促结束测试。这会导致结果因偶然波动而产生巨大偏差。例如前期少量用户的行为刚好支持某个实验版本,就可能得出“显著提升”的误判。样本量不足是 A/B 测试最常见且最危险的陷阱之一。

统计显著不仅依赖样本数量,也依赖数据波动性和业务指标特点。若不进行预估与显著性检验,很容易被短期随机变化误导。尤其对于转化率较低的业务指标,没有充足样本积累,就无法得出真实可信的结论。正确做法是:运行足够长周期、达到预估样本量、确保跨用户群体代表性,避免“幸运数据点”绑架决策。

二、忽略用户群体差异导致结论片面

如果不同用户分布在对照组和实验组中的比例不一致,例如新老用户比例差异较大,就会影响测试结果的真实性。不同地区、不同设备性能、不同渠道流量等差异,都可能造成错误判断。A/B测试不是简单随机,而是确保各组用户结构一致。

此外,还需考虑用户生命周期阶段影响。例如活动期间新用户大量涌入,行为与稳定期用户完全不同,这会放大某些实验数据的虚假优势。更科学的方法是进行多维数据分层、建立用户画像对照,保证测试环境条件一致,否则结果只对部分用户有效,无法推广到整体业务。

三、测试周期过短忽略行为波动与学习成本

很多产品在尚未经历完整用户行为周期时就停止测试,导致结论被短期现象误导。例如刚上线的新功能可能让用户感到新鲜而增加操作,但过段时间可能因复杂而下降。短期数据不代表长期趋势,用户学习周期必须被纳入判断。

应关注稳定后的指标表现,而不是上线初期的波动。如果不考虑学习成本,设计偏好可能倾向于“短期爽、长期烦”的方案,例如隐藏重要功能的界面改动,初期减少步骤,但长期导致操作困惑。真正有效的测试要覆盖用户多次使用周期,验证可持续性,而不是追求瞬时指标好看。

四、错误的指标选择导致判断偏差

如果仅依据单一指标判断成效,A/B测试很容易被“局部最优”误导。例如点击率提升,并不一定意味着体验更好,也可能是用户没找到出口;页面停留时间变长,也可能是用户陷入困惑。指标必须反映真实目标,而非为了验证方案而挑选数据。

因此建议采用多指标体系:主指标体现核心目标,如转化率、任务成功率;辅指标用于解释行为,如错误率、中断路径等。指标冲突时,应优先业务核心目标,避免片面胜利造成整体失败。指标体系健全程度,决定测试结果的真实价值。

五、缺乏业务背景解读造成策略方向错误

A/B测试是策略验证工具,但不是策略本身。有些测试虽然数据表现良好,却与业务长期方向不一致。例如增加诱导性弹窗虽能短期提升点击,但会伤害品牌信任与长期留存。数据好看不等于决策正确,业务背景必须参与解读。

团队需要明确:为什么测试?成功定义是什么?是否会影响长期关系与品牌定位?否则就会出现“为了测试而测试”,甚至落入数据驱动的陷阱,即完全忽视战略,盲目依赖短期结果。数据需要价值判断框架,否则方向可能越走越偏。

六、协作缺失导致意图与实现偏差(适度提及)

A/B测试涉及产品、设计、研发、分析等多角色,若沟通不畅,将造成测试方案与原意不匹配。例如埋点缺失、实验条件不一致等都会导致结果失真。此时专业项目管理系统如 PingCode 可追踪实验变更背景,Worktile 可保障执行透明同步。工具让验证路径可追溯,减少误导性测试的发生。

没有协作保障,测试不仅结果误导,还会浪费宝贵测试机会。团队必须事前审查测试质量与技术准确性,让验证真正反映策略有效性,而非错误执行效果。

七、缺乏复盘与知识沉淀导致错误重复

很多团队测试做了,但结论没有整理,经验没有沉淀,导致历史错误一再发生。复盘不是回顾数据,而是分析模型假设、测试设计与决策逻辑是否合理。复盘能让团队越来越聪明,而不是不断掉入同一个坑。

将 A/B测试经验沉淀为测试手册、指标体系与案例库,能让未来测试更准确、更高效,将试错成本转化为组织能力提升,使数据真正成为增长力量,而不是随机试验的副产品。

常见问答

Q1:A/B测试失败是坏事吗?

A:不是,有效验证假设同样是成功。

Q2:测试结果冲突怎么办?

A:延长周期、扩大样本、细分用户群体重新评估。

Q3:如何避免误导性测试?

A:保证方法严谨、指标正确、解读结合业务目标。

775

775

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?