本案例由开发者:于明浩提供

1 概述

1.1 案例介绍

社交媒体已成为全球用户表达情感与观点的重要平台,Twitter 作为典型代表,每日产生海量文本数据。情感分析作为自然语言处理的重要分支,在舆情监测、品牌口碑分析等领域发挥关键作用。传统的情感分析多依赖基于规则或简单词袋模型,难以捕捉复杂语义与领域特定情感表达。在 Twitter 文本中,包含大量口语化、非正式的短语,精准提取这些情感短语并构建高效情感分析模型,成为提升社交媒体情感分析准确性与实用性的关键挑战。 数据科学价值

本案例演示如何在华为开发者空间云主机上,⼀步步完成Linux版Cherry Studio环境搭建及 DeepSeek-R1模型接⼊,最终在Cherry Studio IDE 中对本地⽂档进⾏ AI 驱动的处理与创意⽂案⽣成。

1.2 适用对象

- 企业

- 个人开发者

- 高校学生

1.3 案例时间

本案例总时长预计60分钟。

1.4 案例流程

{{{width="60%" height="auto"}}}

{{{width="60%" height="auto"}}}

说明:

- 开发者空间配置

- 软件安装和运行环境配置

- 实战项目

1.5 资源总览

本案例预计花费0元。

| 资源名称 | 规格 | 单价(元) | 时长(分钟) |

|---|---|---|---|

| 开发者空间–云主机 | 4vCPUs 8 GB ARM/鲲鹏 Ubuntu 24.04 Server 定制版 | 0 | 60 |

| Linux版Cherry Studio | AppImage可执⾏镜像 | 0 | 60 |

| Ollama本地模型服务 | DeepSeek-R1(本地部署) | 0 | 60 |

| 本地⽂档(任意格式) | Markdown/Word/PDF … | 0 | 60 |

2 开发者空间配置

2.1 开发者空间配置

面向广大开发者群体,华为开发者空间提供一个随时访问的“开发桌面云主机”、丰富的“预配置工具集合”和灵活使用的“场景化资源池”,开发者开箱即用,快速体验华为根技术和资源。

如果还没有领取开发者空间云主机,可以参考免费领取云主机文档领取。

领取云主机后可以直接进入华为开发者空间工作台界面,点击打开云主机 > 进入桌面连接云主机。

3 软件安装和运行环境配置

3.1 安装并配置 Ollama

Ollama 是开源的本地 LLM 管理⼯具,⽀持快速下载、运⾏及交互多种预训练模型。

打开⼀共命令⾏窗⼝,执⾏下⾯命令:

#安装 Ollama

curl -fsSL https://dtse-mirrors.obs.cn-north-4.myhuaweicloud.com/case/0035/install.sh | sudo bash

# 启动 Ollama 服务

sudo systemctl enable ollama

sudo systemctl start ollama

运行结果:

部署 DeepSeek-R1 模型:

ollama run deepseek-r1:1.5b

运行结果:

3.2 安装 Linux 版 Cherry Studio

打开⼀个新的命令⾏窗⼝输⼊以下命令,更新软件包。

sudo apt update

sudo apt upgrade -y

注:从Cherry Studio Releases下载 ARM64 AppImage:(如果是X86云主机,请选择性x86_64版本),版本:Cherry-Studio-1.3.9-arm64.AppImage或更新的版本,自行选择。

在终端输入以下命令进行相关依赖包的下载:

sudo apt update #升级系统所有软件包

sudo apt install zlib1g zlib1g-dev #提供运行时库文件,供依赖zlib的程序运行时使用。

接着,我们启用Ubuntu的universe软件仓库并安装libfuse2软件包,这是FUSE(Filesystem in Userspace)的核心库,FUSE允许普通用户在用户空间实现文件系统(无需内核模块),常用于挂载虚拟文件系统或特殊用途的文件系统。

sudo add-apt-repository universe #启用Ubuntu的universe软件仓库

sudo apt install libfuse2 #安装libfuse2软件包

赋予执行权限并启动:(请替换成实际下载版本文件名)

cd ../home/developer/Downloads/

sudo chmod u+x Cherry-Studio-1.3.9-arm64.AppImage

./Cherry-Studio-1.3.9-arm64.AppImage --no-sandbox

启动成功后,自动跳出 Cherry Studio 页面。

4 实战项目

4.1 启动 Ollama 模型服务

在终端中执行(如已启动可忽略):

ollama run deepseek-r1:1.5b

确认服务已启动,ollama服务 默认监听本地 11434 端口。

4.2 在 Cherry Studio 中接入 DeepSeek 模型服务

打开 Cherry Studio → “设置” → “模型服务” → Ollama → “管理”

点击加号按钮,将 deepseek-r1:1.5b 添加到模型服务里。

回到 Cherry Studio 主页面,在界面上方选择我们本次通过 ollama服务 部署的 deepseek-r1:1.5b 模型。

接着我们向 deepseek 提问,测试模型是否可以正常工作。

如正常返回,则说明 Cherry Studio 已经成功接入 DeepSeek 模型服务。

4.3 基于 DeepSeek 进行文档续写、语句优化、文档总结

下面,我们开展一些在 Cherry Studio 中调试 DeepSeek 模型的案例。

文档续写

我们给出一段小说片段,让 DeepSeek 帮助我们续写内容。

提问:“你是一共小说家,请发挥想象,帮我续写下面故事的下文,300字即可”:

夜色凝重,微风拂过湖面,泛起层层涟漪,像无数被遗忘的梦。柳树下,少女的倩影映在水中,如画卷轻轻铺开。她手握一盏青瓷灯,灯光柔和却透着幽冷。脚步声在岸边回荡,仿佛来自过去的呢喃。“是谁在呼唤?”她低声呢喃。远处古桥下,传来轻微涛声,与她心跳同步。月华撒落,如银丝滴在灯影里,时光在这一刻凝固。忽然,一声鸟鸣破空,少女回首,眼中有星辰在闪烁,她似在等待,又似在抛弃。夜风中灯光随她呼吸颤动将旅程铺向远方。

可以看到,DeepSeek 成功续写了约300字的小说内容。

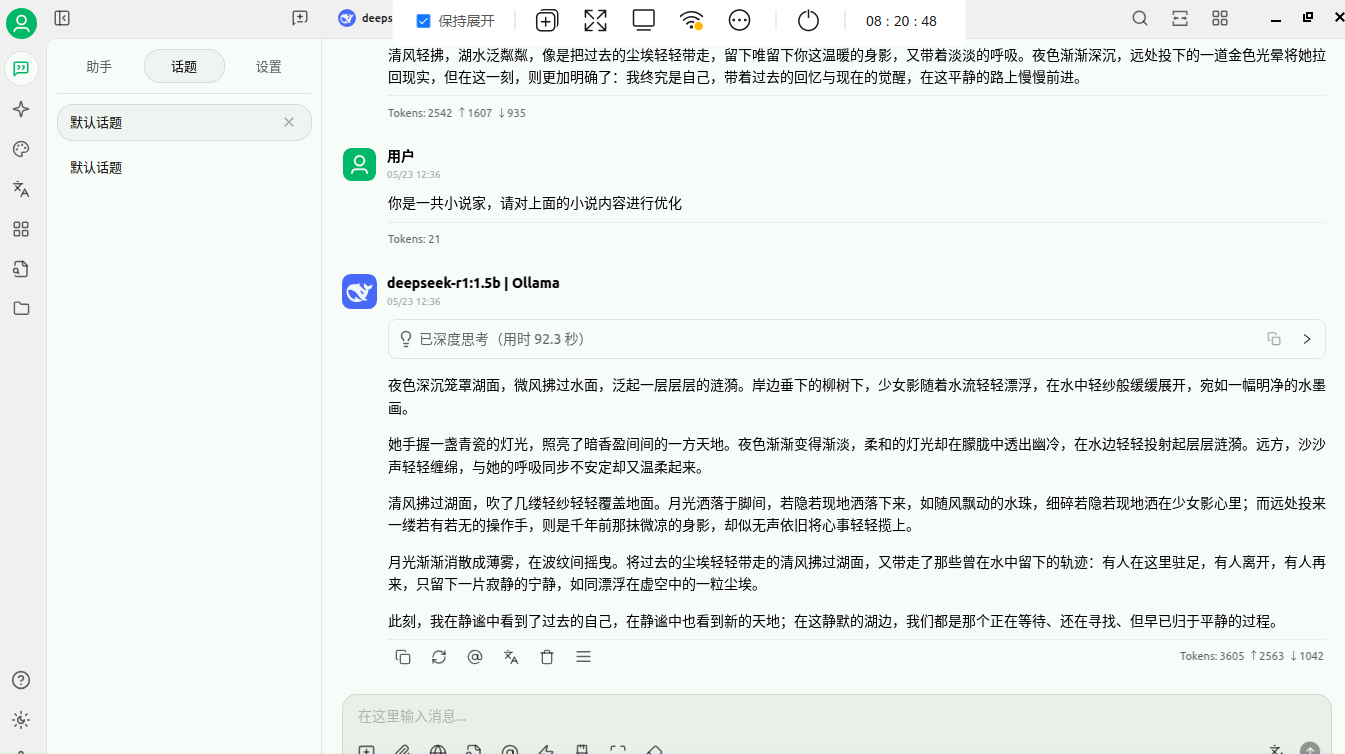

语句优化

继续上面的内容,我们提出让AI帮助我们优化这个小说片段。

提问:“你是一共小说家,请对上面的小说内容进行优化”

可以看到,DeepSeek 对小说内容进行了优化。

文档总结

继续上面的内容,我们提出让AI帮助我总结这个小说片段。

提问:“请总结上面的小说内容,100字即可”

可以看到,DeepSeek 对上述内容进行了总结。

4.4 基于本地文档进行摘要提取并生成创意文案

接着,我们基于 DeepSeek 对本地文档进行 AI 操作。

摘要提取

我们需要准备一个某产品介绍的文档,如果没有可以去网上下载一个,这里作为演示的是我事先准备的华为云ECS产品说明文档。下载链接: test.pdf

下载完成后,我们开启一个新的对话,在对话里添加附件即可。

对话框内上传附件,

提问:“读取附件内容,给出本文的150字摘要”,来获取文件内容的摘要。

可以看到,文件内容被 DeepSeek 精准解析,并成功返回约150字的全文摘要。

根据产品描述生成创意文案

对话框内上传我们之前下载的PDF附件,

提问:“读取附件内容,熟悉产品的描述和特点,生成150字的产品创意文案”。

可以看到,文件内容被 DeepSeek 精准解析,并具有创意的返回了约150字的文案。

至此,您已完成从环境搭建到深度实战的全流程,能够在 Cherry Studio 中高效利用本地 DeepSeek-R1 服务,快速处理文档并生成创意内容。祝您实验顺利!

构建DeepSeek智能文档处理器

构建DeepSeek智能文档处理器

6万+

6万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?