AIGC的火已经把世界烧过一遍了,但是大家有没有想过,市面上那些开源的大模型,原理是什么,是怎么跑起来的?从而衍生出了很多的问题,不仅仅是大模型是怎么训练的?我们如何在本地部署大模型等等这些问题。那么为了不被时代淘汰,跟上AI的步伐,所以作者决定出一系列的文章来和大家一起探索一下AIGC的世界,专栏就叫《重生之我要学AIGC》,欢迎大家订阅!!!谢谢大家。 。

前言

今年回了个年,约高中同学去聚一聚,发现不是行内的同学都知道了deepseek,而且过年这段时间几乎被deepseek给刷屏了,还有人公众号作者在评论区说deepseek就是一个搜索引擎(啊?是这样的吗?)。那么我心中有个疑问deepseek是个啥啊?于是就去了解了一下,并且在本地部署了一套deepseek,就有了这篇文章。

deepseek是什么

我们从官网中可以看到deepseek的相关介绍,原来就是类似OpenAI的GPT-4o,阿里的Qwen2.5 也是个模型来着。

但是不知道大家有没有发现,这次deepseek的爆火程度远远超过阿里原来发布Qwen模型的时候,上一次这么火还是ChatGPT横空出世的时候了。事后和同事聊了一些,之所以能如此**“爆红”**,我们讨论出来的大致原因就是:好传播。因为deepseek是国内的模型,所以相比于本身就有网络限制的ChatGPT,大家直接能登录网站就能即时体验了。

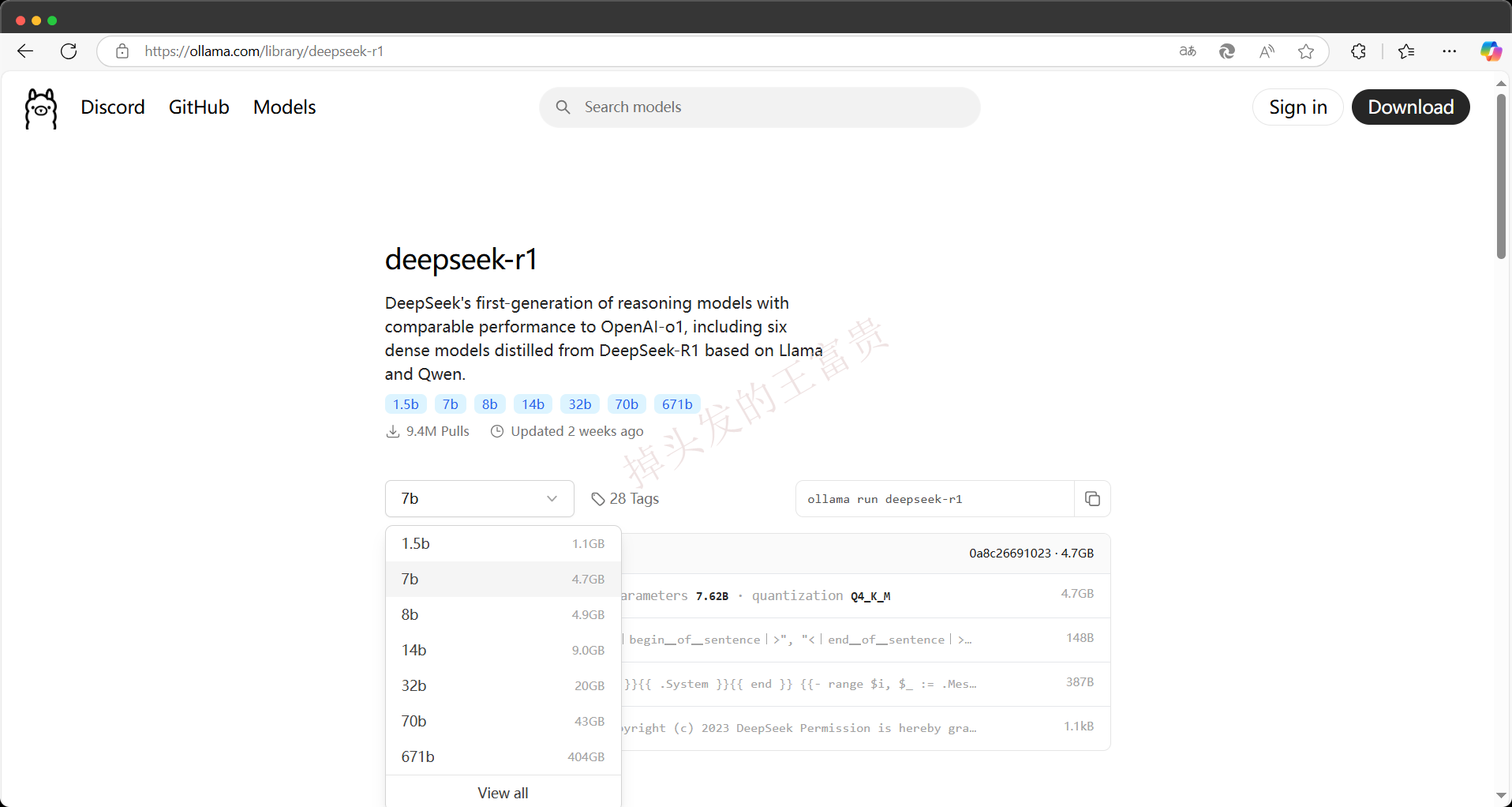

不过有个问题,本地部署不了非常大的模型,例如 deepseek-r1 671b(404GB)。而本地部署的好处是稳定性高,不会像 deepseek 那样经常崩溃。如果你的电脑只是几千块钱的配置,那可能只能尝试一些小模型,但这仍然对我们了解大模型有所帮助。

环境准备

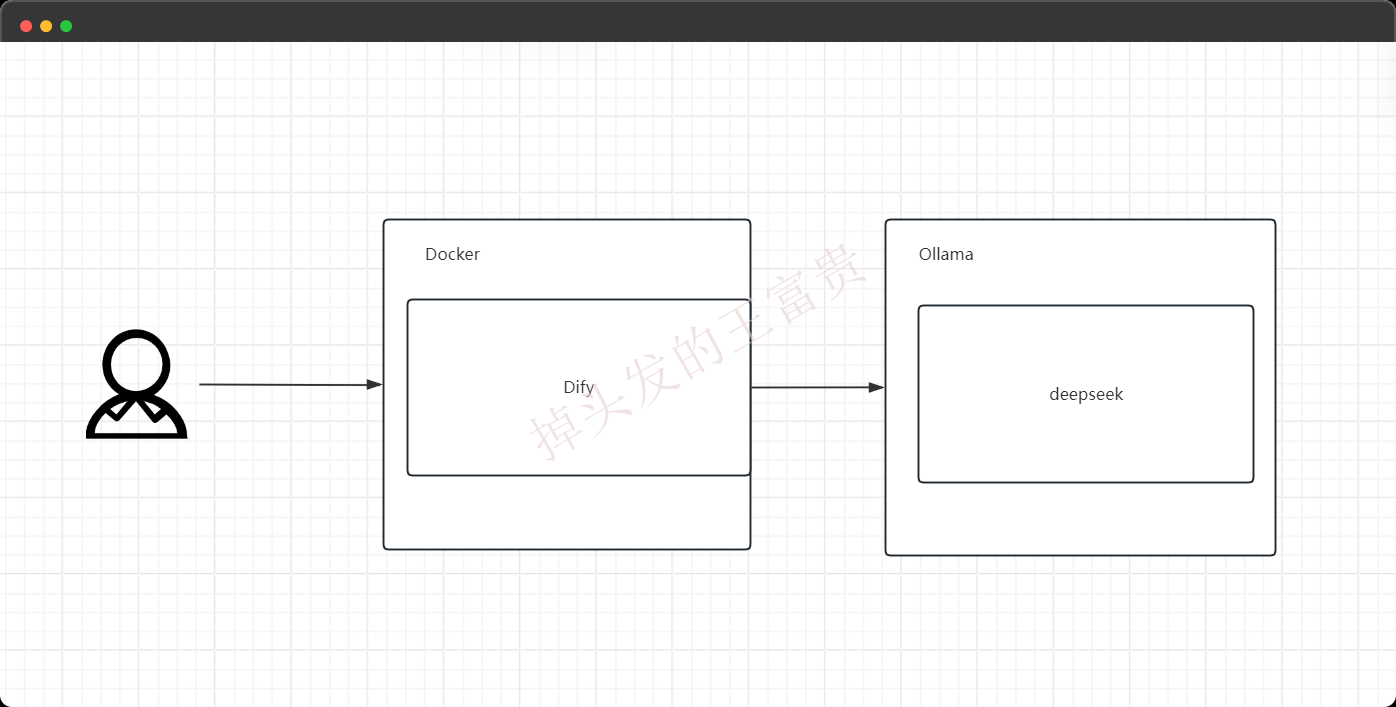

这次我们用到的环境有:Dify,Ollama,deepseek模型,Docker

Ollama和Docker作者之前有介绍并且有说过他们的安装方法,如果感兴趣的话可以去这里翻翻:

| 标题 | 链接 |

|---|---|

| 如果我们需要在本地运行大模型,我们应该怎么做?Ollama入门指南 | https://juejin.cn/post/7433426879448629274 |

| SpringBoot应用:Docker与Kubernetes全栈实战秘籍 | https://juejin.cn/post/7440687454594793522 |

| Docker入门之Windows安装Docker初体验 | https://juejin.cn/post/7415656200463581211 |

| 从零开始玩转 Docker:一站式入门指南,带你快速掌握镜像、容器与仓库 | https://juejin.cn/post/7403184763501117480 |

| 面试官让你介绍一下docker,别再说不知道了 | https://juejin.cn/post/7402830607124905999 |

由于Ollama是默认安装在C盘的,所以我们需要在安装完成Ollama之后可以选择把Ollama安装路径软链接到其他非系统盘去,先把文件夹剪切到新的目录中,然后执行下面的命令即可

mklink /D C:\Users\Windows用户名\AppData\Local\Programs\Ollama D:\Ollama\app

安装Dify

技术也是需要包装的

虽然我们可以直接用命令行去吧deepseek跑起来,并且和它进行对话,但是如果我们通过页面化的工具来与他进行对话,这样会不会有一种科技之美了,所以我们这次使用Dify来进行网页版的集成。

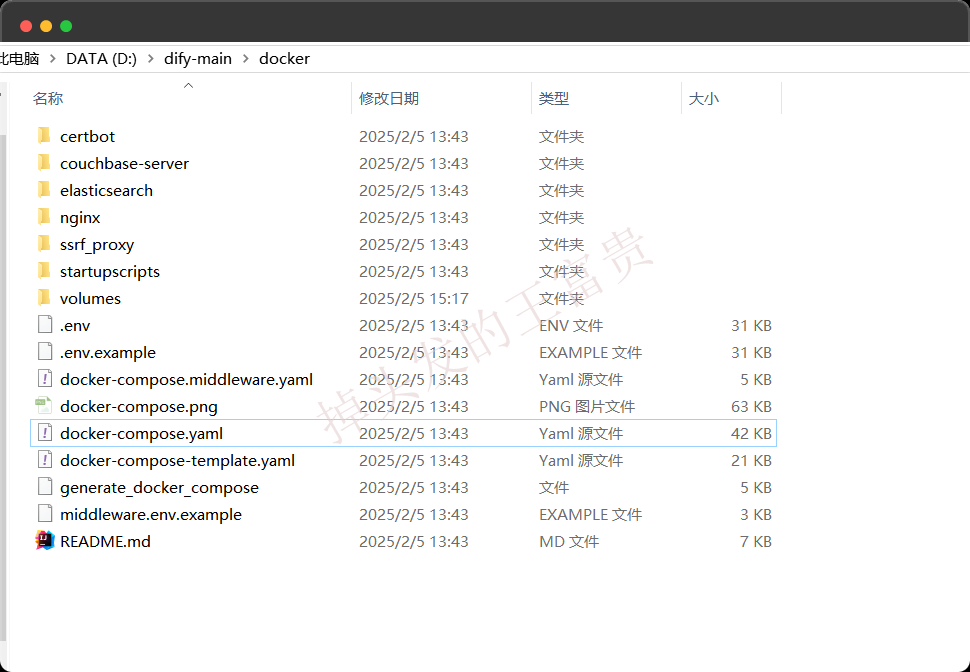

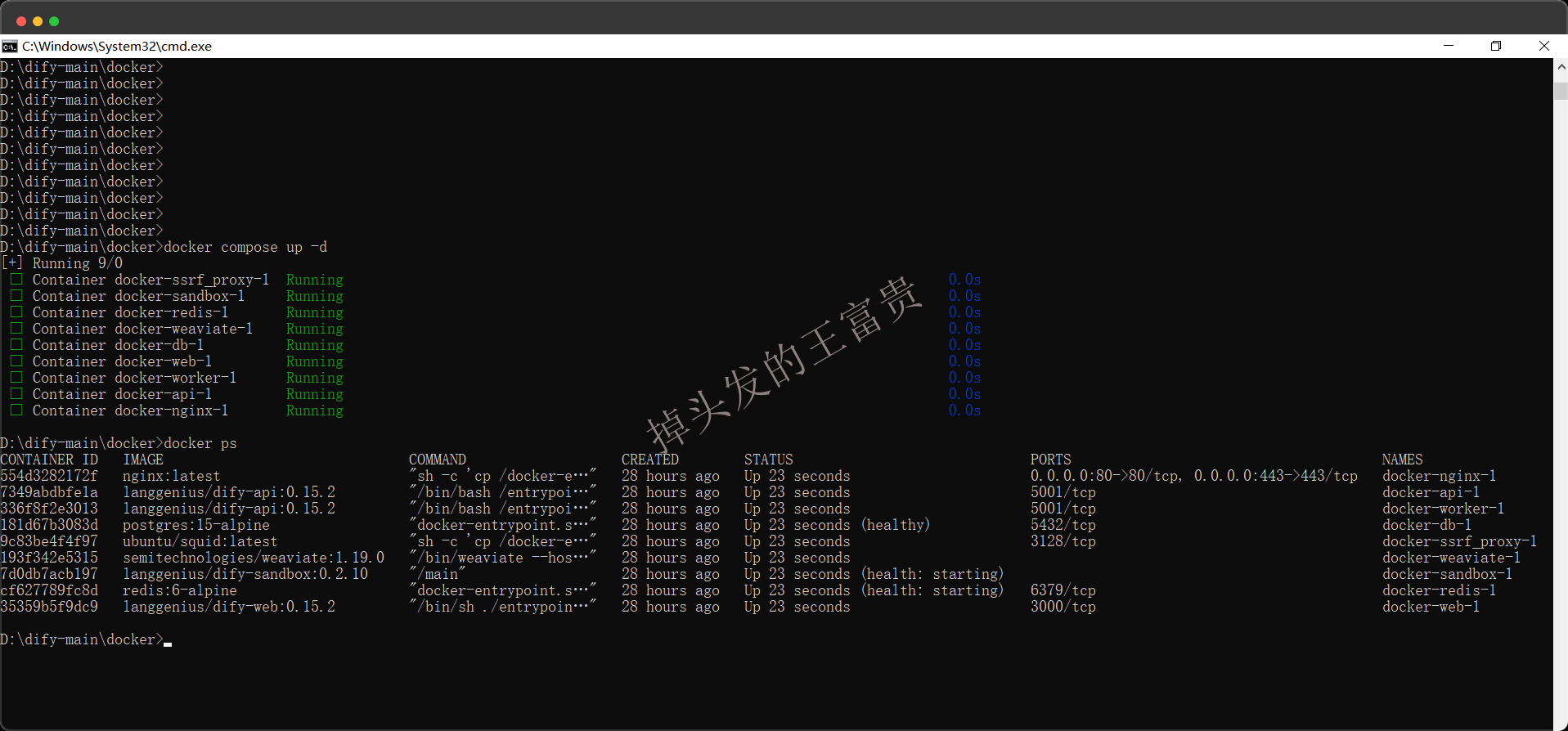

我们需要把仓库clone下来,如果clone不下来我们也可以下载压缩包,之后我们执行下面的命令即可(注意,需要把Docker启动起来):

cd dify-main

cd docker

cp .env.example .env #复制文件

docker compose up -d #启动Compose应用

docker-compose up -d 是 Docker Compose 的一个常用命令,用于在后台(detached mode)启动和管理多个容器。例如我们执行这个命令之后就会通过docker把这个文件夹里面所有的服务启动起来。

docker-compose up用于根据docker-compose.yml文件中定义的配置启动容器。-d参数表示以“分离模式”(detached mode)运行容器,即容器在后台运行,不会占用当前终端。

适用于开发、测试和生产环境中快速部署多容器应用。

执行完之后就会发现我们docker里面多了很多的容器(作者这是第二次执行,第一次执行会很慢):

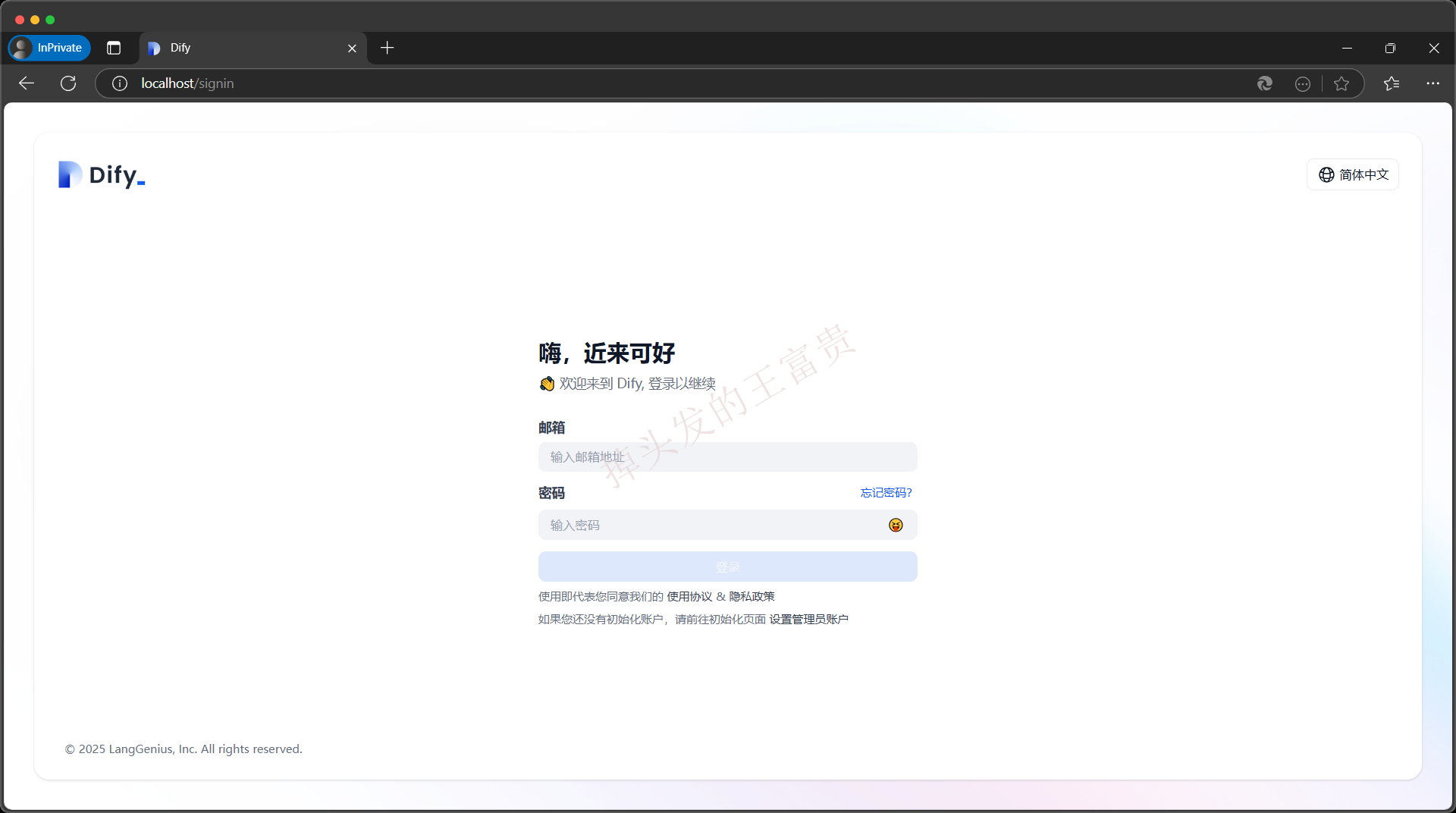

之后我们就可以访问地址 http://localhost/install 去初始化Dify,然后就可以直接访问:http://localhost/ 来访问我们的网页端

Ollama运行deepseek

我们可以直接在Ollama官网上看到deepseek有哪些版本:

https://ollama.com/library/deepseek-r1

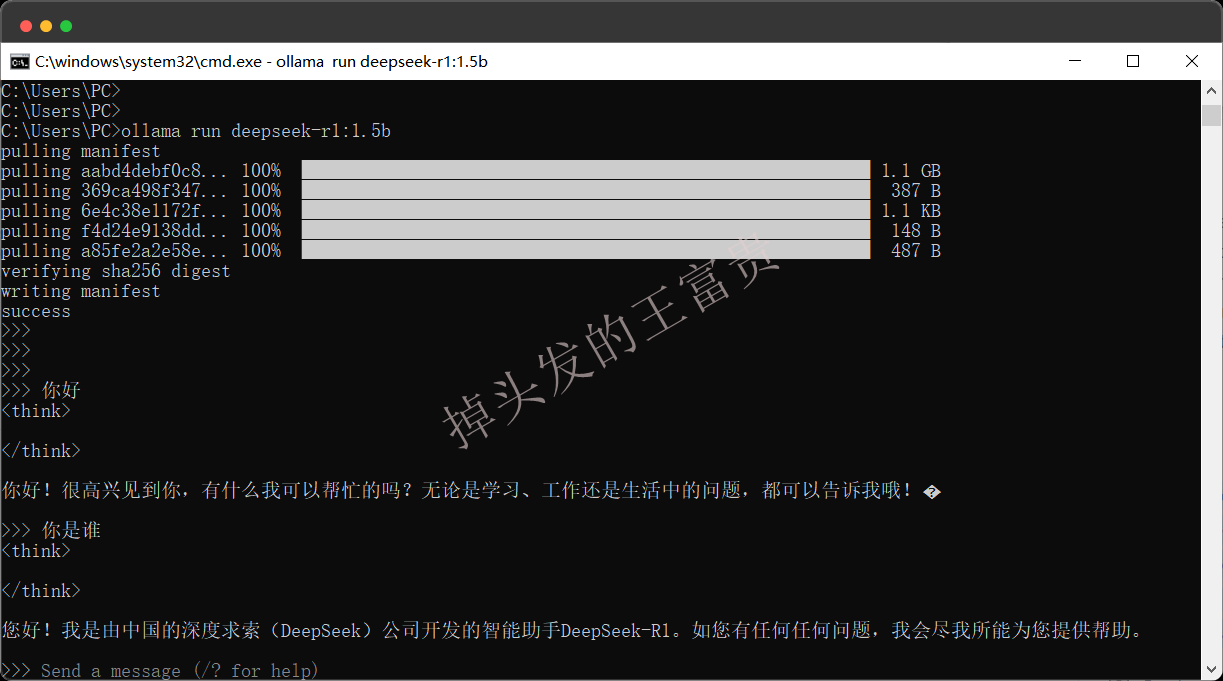

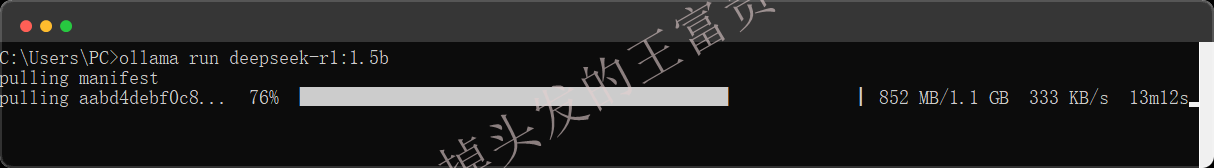

然后在安装Ollama之后,选好对应的deepseek版本,作者这里选的是1.5b ,直接敲命令行运行:

ollama run deepseek-r1:1.5b

Dify集成Ollama

右上角头像设置选择模型供应商,如下配置即可

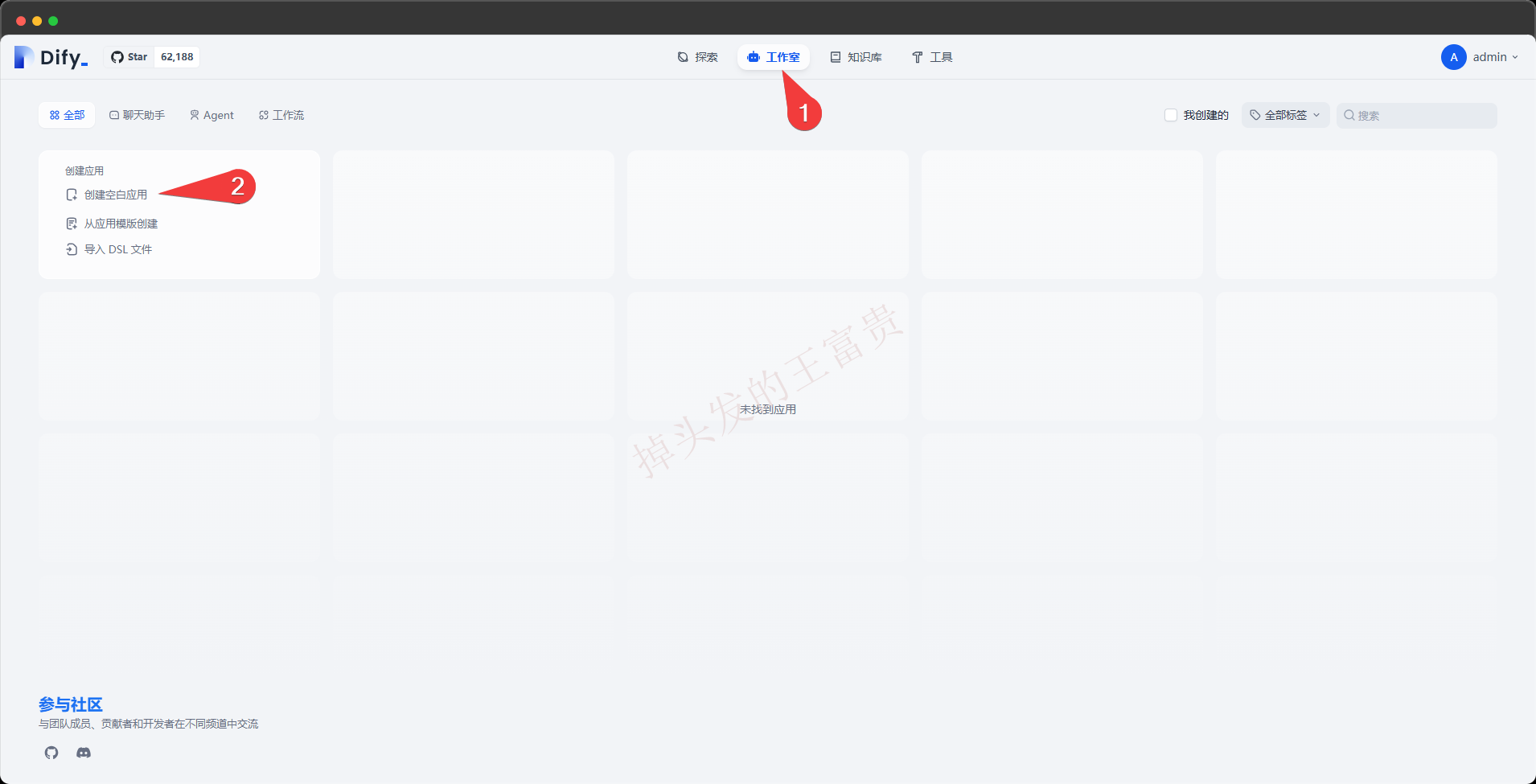

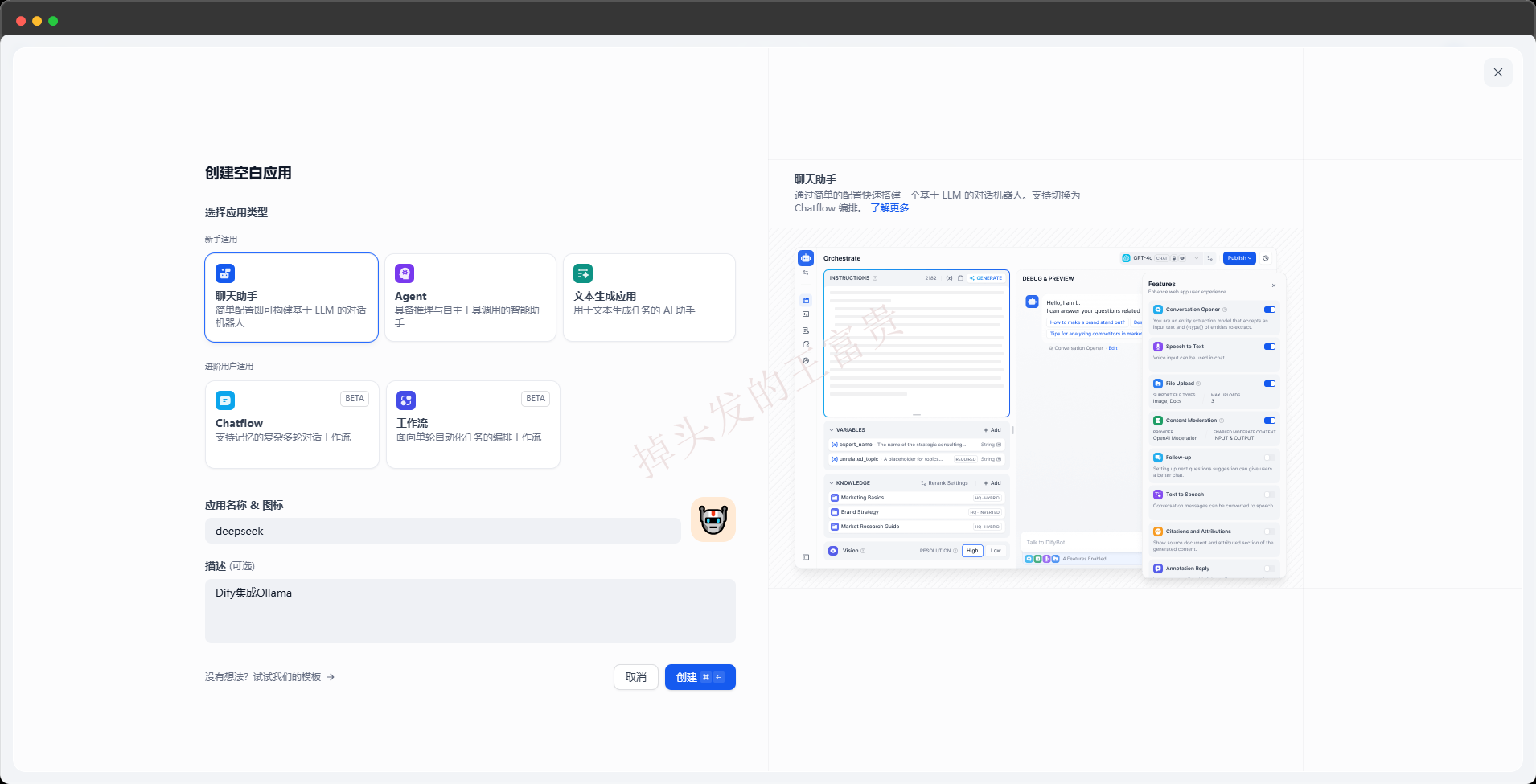

接下来创建一个空白应用

右上角选择我们刚刚配置好的deepseek模型即可开始对话

如果出现 NewConnectionError('<urllib3.connection.HTTPConnection object at 0x7f8bb7af5a90>: Failed to establish这样的报错,命令行run一下deepseek即可解决

至此,我们就实现了在本地运行了deepseek模型了。

4万+

4万+