摘要

本文将详细介绍如何使用Docker Compose部署和管理一个完整的AI应用系统。我们将从系统的整体架构设计入手,逐步深入到各个服务的配置、部署以及优化。通过实践示例,展示如何在Docker环境中高效地运行AI应用,包括API服务、Web前端、数据库、缓存服务以及多种向量数据库。文章最后将总结关键点,并提供实践建议和扩展阅读资源。本文面向中国开发者,特别是AI应用开发者,内容包括完整的代码示例、架构图、流程图、思维导图、甘特图和饼图等,以增强可读性和实用性。

正文

1. 系统架构设计

在构建AI应用时,系统架构的设计至关重要。一个好的架构可以提高系统的可扩展性、可维护性和性能。以下是我们的系统架构设计:

1.1 架构组件说明

我们的AI应用系统由以下核心组件构成:

- Web前端:提供用户界面,与用户进行交互

- API服务:处理业务逻辑,协调各个后端服务

- 数据库:存储结构化数据,如用户信息、配置等

- 缓存服务:提高系统响应速度,减轻数据库压力

- 向量数据库:存储和检索高维向量数据,支持AI检索功能

- AI模型服务:提供AI模型推理能力

- 监控系统:监控系统性能和健康状态

- 日志系统:记录系统运行日志,便于问题排查

1.2 技术选型

2. 环境准备

在开始部署之前,确保您的开发环境中已经安装了以下工具:

2.1 安装Docker

Docker是容器化平台的基础,我们需要先安装Docker:

# Ubuntu/Debian系统安装Docker

sudo apt-get update

sudo apt-get install docker-ce docker-ce-cli containerd.io

# CentOS/RHEL系统安装Docker

sudo yum install -y yum-utils

sudo yum-config-manager --add-repo https://download.docker.com/linux/centos/docker-ce.repo

sudo yum install docker-ce docker-ce-cli containerd.io

# 启动Docker服务

sudo systemctl start docker

sudo systemctl enable docker

2.2 安装Docker Compose

Docker Compose是用于定义和运行多容器Docker应用程序的工具:

# 下载Docker Compose

sudo curl -L "https://github.com/docker/compose/releases/download/v2.20.0/docker-compose-$(uname -s)-$(uname -m)" -o /usr/local/bin/docker-compose

# 添加执行权限

sudo chmod +x /usr/local/bin/docker-compose

# 验证安装

docker-compose --version

2.3 安装Python环境

为了编写和测试相关代码,我们需要Python环境:

# Ubuntu/Debian系统安装Python

sudo apt-get install python3 python3-pip

# CentOS/RHEL系统安装Python

sudo yum install python3 python3-pip

# 安装必要的Python包

pip3 install docker-compose requests python-dotenv

3. Docker Compose文件详解

docker-compose.yaml文件是Docker Compose的核心配置文件,它定义了服务、网络和卷的配置。以下是我们AI应用系统的完整配置:

3.1 基础配置

version: '3.8'

# 定义服务间共享的环境变量

x-shared-env: &shared-api-worker-env

# 数据库配置

DB_USERNAME: ${POSTGRES_USER:-postgres}

DB_PASSWORD: ${POSTGRES_PASSWORD:-difyai123456}

DB_HOST: db

DB_PORT: 5432

DB_DATABASE: ${POSTGRES_DB:-dify}

# Redis配置

REDIS_HOST: redis

REDIS_PORT: 6379

REDIS_USERNAME:

REDIS_PASSWORD: ${REDIS_PASSWORD:-difyai123456}

REDIS_USE_SSL: 'false'

# 向量数据库配置

VECTOR_STORE: ${VECTOR_STORE:-weaviate}

WEAVIATE_API_KEY: ${WEAVIATE_API_KEY:-WVF5YThaHlkYwhGUSmCRgsX3tD5ngdN8pkih}

WEAVIATE_HOST: http://weaviate:8080

# API密钥配置

SECRET_KEY: ${SECRET_KEY:-sk-abc123}

WEB_API_KEY: ${WEB_API_KEY:-wk-abc123}

# 文件存储配置

STORAGE_TYPE: ${STORAGE_TYPE:-local}

S3_BUCKET_NAME: ${S3_BUCKET_NAME:-dify}

# 其他配置

APP_URL: ${APP_URL:-http://localhost:3000}

CONSOLE_URL: ${CONSOLE_URL:-http://localhost:3000}

CONSOLE_WEB_SERVER_PORT: 3000

3.2 API服务配置

API服务是AI应用的核心,负责处理业务逻辑:

services:

api:

image: langgenius/dify-api:1.7.1

restart: always

environment:

<<: *shared-api-worker-env

MODE: api

depends_on:

db:

condition: service_healthy

redis:

condition: service_started

volumes:

- ./volumes/app/storage:/app/api/storage

networks:

- ssrf_proxy_network

- default

deploy:

resources:

limits:

memory: 512M # 设置内存限制为 512MB

3.3 数据库服务配置

数据库是AI应用的核心组件之一,我们使用PostgreSQL作为数据库:

db:

image: postgres:15-alpine

restart: always

ports:

- "5432:5432"

environment:

POSTGRES_USER: ${POSTGRES_USER:-postgres}

POSTGRES_PASSWORD: ${POSTGRES_PASSWORD:-difyai123456}

POSTGRES_DB: ${POSTGRES_DB:-dify}

PGDATA: ${PGDATA:-/var/lib/postgresql/data/pgdata}

command: >

postgres -c 'max_connections=${POSTGRES_MAX_CONNECTIONS:-100}'

-c 'shared_buffers=${POSTGRES_SHARED_BUFFERS:-128MB}'

-c 'work_mem=${POSTGRES_WORK_MEM:-4MB}'

-c 'maintenance_work_mem=${POSTGRES_MAINTENANCE_WORK_MEM:-64MB}'

-c 'effective_cache_size=${POSTGRES_EFFECTIVE_CACHE_SIZE:-4096MB}'

volumes:

- ./volumes/db/data:/var/lib/postgresql/data

healthcheck:

test: [ 'CMD', 'pg_isready', '-h', 'db', '-U', '${PGUSER:-postgres}', '-d', '${POSTGRES_DB:-dify}' ]

interval: 1s

timeout: 3s

retries: 60

3.4 缓存服务配置

缓存服务可以提高系统的性能,我们使用Redis作为缓存服务:

redis:

image: redis:6-alpine

restart: always

ports:

- "6380:6379"

environment:

REDISCLI_AUTH: ${REDIS_PASSWORD:-difyai123456}

volumes:

- ./volumes/redis/data:/data

command: redis-server --requirepass ${REDIS_PASSWORD:-difyai123456}

healthcheck:

test: [ 'CMD', 'redis-cli', 'ping' ]

3.5 向量数据库配置

向量数据库用于存储和检索高维向量数据,我们支持多种向量数据库:

weaviate:

image: semitechnologies/weaviate:1.19.0

profiles:

- ''

- weaviate

restart: always

volumes:

- ./volumes/weaviate:/var/lib/weaviate

environment:

PERSISTENCE_DATA_PATH: ${WEAVIATE_PERSISTENCE_DATA_PATH:-/var/lib/weaviate}

QUERY_DEFAULTS_LIMIT: ${WEAVIATE_QUERY_DEFAULTS_LIMIT:-25}

AUTHENTICATION_ANONYMOUS_ACCESS_ENABLED: ${WEAVIATE_AUTHENTICATION_ANONYMOUS_ACCESS_ENABLED:-false}

DEFAULT_VECTORIZER_MODULE: ${WEAVIATE_DEFAULT_VECTORIZER_MODULE:-none}

CLUSTER_HOSTNAME: ${WEAVIATE_CLUSTER_HOSTNAME:-node1}

AUTHENTICATION_APIKEY_ENABLED: ${WEAVIATE_AUTHENTICATION_APIKEY_ENABLED:-true}

AUTHENTICATION_APIKEY_ALLOWED_KEYS: ${WEAVIATE_AUTHENTICATION_APIKEY_ALLOWED_KEYS:-WVF5YThaHlkYwhGUSmCRgsX3tD5ngdN8pkih}

AUTHENTICATION_APIKEY_USERS: ${WEAVIATE_AUTHENTICATION_APIKEY_USERS:-hello@dify.ai}

AUTHORIZATION_ADMINLIST_ENABLED: ${WEAVIATE_AUTHORIZATION_ADMINLIST_ENABLED:-true}

AUTHORIZATION_ADMINLIST_USERS: ${WEAVIATE_AUTHORIZATION_ADMINLIST_USERS:-hello@dify.ai}

3.6 Web前端服务配置

Web前端服务提供用户界面:

web:

image: langgenius/dify-web:1.7.1

restart: always

environment:

CONSOLE_URL: ${CONSOLE_URL:-http://localhost:3000}

APP_URL: ${APP_URL:-http://localhost:3000}

NEXT_PUBLIC_API_PREFIX: ${NEXT_PUBLIC_API_PREFIX:-/api}

NEXT_PUBLIC_LANG: ${NEXT_PUBLIC_LANG:-zh-Hans}

volumes:

- ./volumes/web/nginx.conf:/etc/nginx/nginx.conf

depends_on:

- api

networks:

- default

3.7 网络和存储卷配置

networks:

ssrf_proxy_network:

driver: bridge

internal: true

milvus:

driver: bridge

opensearch-net:

driver: bridge

internal: true

volumes:

oradata:

dify_es01_data:

4. 环境变量配置

创建.env文件来管理环境变量:

# 数据库配置

POSTGRES_USER=postgres

POSTGRES_PASSWORD=difyai123456

POSTGRES_DB=dify

POSTGRES_MAX_CONNECTIONS=100

POSTGRES_SHARED_BUFFERS=128MB

POSTGRES_WORK_MEM=4MB

POSTGRES_MAINTENANCE_WORK_MEM=64MB

POSTGRES_EFFECTIVE_CACHE_SIZE=4096MB

# Redis配置

REDIS_PASSWORD=difyai123456

# 向量数据库配置

VECTOR_STORE=weaviate

WEAVIATE_API_KEY=WVF5YThaHlkYwhGUSmCRgsX3tD5ngdN8pkih

# API密钥配置

SECRET_KEY=sk-abc123

WEB_API_KEY=wk-abc123

# 文件存储配置

STORAGE_TYPE=local

S3_BUCKET_NAME=dify

# 应用URL配置

APP_URL=http://localhost:3000

CONSOLE_URL=http://localhost:3000

5. 实践案例

以下是一个实际的应用场景,展示如何使用Docker Compose部署一个完整的AI应用系统。

5.1 场景描述

假设我们要部署一个智能客服系统,该系统包括以下组件:

- API服务:处理用户请求和业务逻辑

- Web前端:提供用户界面

- 数据库:存储用户数据和业务数据

- 缓存服务:提高系统性能

- 向量数据库:存储和检索向量数据

5.2 部署步骤

步骤1:创建项目目录结构

# 创建项目目录

mkdir dify-ai-system

cd dify-ai-system

# 创建必要的子目录

mkdir -p volumes/{app/storage,db/data,redis/data,weaviate,web}

步骤2:创建Docker Compose文件

创建docker-compose.yml文件,内容如前所述。

步骤3:创建环境变量文件

创建.env文件,内容如前所述。

步骤4:创建Web配置文件

创建volumes/web/nginx.conf文件:

events {

worker_connections 1024;

}

http {

include /etc/nginx/mime.types;

default_type application/octet-stream;

log_format main '$remote_addr - $remote_user [$time_local] "$request" '

'$status $body_bytes_sent "$http_referer" '

'"$http_user_agent" "$http_x_forwarded_for"';

access_log /var/log/nginx/access.log main;

error_log /var/log/nginx/error.log;

sendfile on;

keepalive_timeout 65;

server {

listen 80;

server_name localhost;

location / {

root /usr/share/nginx/html;

index index.html index.htm;

try_files $uri $uri/ /index.html;

}

location /api/ {

proxy_pass http://api:5001/;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

}

error_page 500 502 503 504 /50x.html;

location = /50x.html {

root /usr/share/nginx/html;

}

}

}

步骤5:启动服务

# 启动所有服务

docker-compose up -d

# 查看服务状态

docker-compose ps

# 查看服务日志

docker-compose logs -f

5.3 Python管理脚本

创建一个Python脚本来管理Docker Compose服务:

# -*- coding: utf-8 -*-

"""

Docker Compose AI服务管理脚本

该脚本提供了对AI应用系统的管理功能

"""

import os

import sys

import time

import subprocess

import logging

from typing import List, Optional

# 配置日志

logging.basicConfig(

level=logging.INFO,

format='%(asctime)s - %(name)s - %(levelname)s - %(message)s'

)

logger = logging.getLogger(__name__)

class DockerComposeManager:

"""Docker Compose服务管理器"""

def __init__(self, compose_file: str = "docker-compose.yml", env_file: str = ".env"):

"""

初始化管理器

Args:

compose_file (str): Docker Compose文件路径

env_file (str): 环境变量文件路径

"""

self.compose_file = compose_file

self.env_file = env_file

self.project_name = "dify-ai-system"

# 检查Docker Compose是否可用

if not self._check_docker_compose():

raise RuntimeError("Docker Compose不可用,请先安装Docker Compose")

def _check_docker_compose(self) -> bool:

"""

检查Docker Compose是否可用

Returns:

bool: 是否可用

"""

try:

result = subprocess.run(

["docker-compose", "--version"],

capture_output=True,

text=True,

check=True

)

logger.info(f"Docker Compose版本: {result.stdout.strip()}")

return True

except (subprocess.CalledProcessError, FileNotFoundError):

logger.error("Docker Compose未安装或不可用")

return False

def start_services(self, services: Optional[List[str]] = None) -> bool:

"""

启动服务

Args:

services (Optional[List[str]]): 要启动的服务列表,None表示启动所有服务

Returns:

bool: 是否成功

"""

try:

cmd = ["docker-compose", "-f", self.compose_file]

if self.project_name:

cmd.extend(["-p", self.project_name])

cmd.append("up")

cmd.append("-d")

if services:

cmd.extend(services)

logger.info(f"启动服务: {' '.join(cmd)}")

result = subprocess.run(cmd, capture_output=True, text=True, check=True)

logger.info("服务启动成功")

return True

except subprocess.CalledProcessError as e:

logger.error(f"启动服务失败: {e.stderr}")

return False

except Exception as e:

logger.error(f"启动服务时发生未知错误: {e}")

return False

def stop_services(self, services: Optional[List[str]] = None) -> bool:

"""

停止服务

Args:

services (Optional[List[str]]): 要停止的服务列表,None表示停止所有服务

Returns:

bool: 是否成功

"""

try:

cmd = ["docker-compose", "-f", self.compose_file]

if self.project_name:

cmd.extend(["-p", self.project_name])

cmd.append("down")

if services:

cmd.extend(services)

logger.info(f"停止服务: {' '.join(cmd)}")

result = subprocess.run(cmd, capture_output=True, text=True, check=True)

logger.info("服务停止成功")

return True

except subprocess.CalledProcessError as e:

logger.error(f"停止服务失败: {e.stderr}")

return False

except Exception as e:

logger.error(f"停止服务时发生未知错误: {e}")

return False

def restart_services(self, services: Optional[List[str]] = None) -> bool:

"""

重启服务

Args:

services (Optional[List[str]]): 要重启的服务列表,None表示重启所有服务

Returns:

bool: 是否成功

"""

try:

# 先停止服务

if not self.stop_services(services):

return False

# 等待一段时间

time.sleep(2)

# 再启动服务

return self.start_services(services)

except Exception as e:

logger.error(f"重启服务时发生错误: {e}")

return False

def get_service_status(self) -> Optional[str]:

"""

获取服务状态

Returns:

Optional[str]: 服务状态信息

"""

try:

cmd = ["docker-compose", "-f", self.compose_file]

if self.project_name:

cmd.extend(["-p", self.project_name])

cmd.append("ps")

result = subprocess.run(cmd, capture_output=True, text=True, check=True)

return result.stdout

except subprocess.CalledProcessError as e:

logger.error(f"获取服务状态失败: {e.stderr}")

return None

except Exception as e:

logger.error(f"获取服务状态时发生未知错误: {e}")

return None

def view_logs(self, service: Optional[str] = None, follow: bool = False) -> Optional[str]:

"""

查看服务日志

Args:

service (Optional[str]): 服务名称

follow (bool): 是否持续跟踪日志

Returns:

Optional[str]: 日志内容

"""

try:

cmd = ["docker-compose", "-f", self.compose_file]

if self.project_name:

cmd.extend(["-p", self.project_name])

cmd.append("logs")

if follow:

cmd.append("-f")

if service:

cmd.append(service)

result = subprocess.run(cmd, capture_output=True, text=True, check=True)

return result.stdout

except subprocess.CalledProcessError as e:

logger.error(f"查看日志失败: {e.stderr}")

return None

except Exception as e:

logger.error(f"查看日志时发生未知错误: {e}")

return None

def execute_command(self, service: str, command: List[str]) -> Optional[str]:

"""

在服务容器中执行命令

Args:

service (str): 服务名称

command (List[str]): 要执行的命令

Returns:

Optional[str]: 命令执行结果

"""

try:

cmd = ["docker-compose", "-f", self.compose_file]

if self.project_name:

cmd.extend(["-p", self.project_name])

cmd.append("exec")

cmd.append(service)

cmd.extend(command)

result = subprocess.run(cmd, capture_output=True, text=True, check=True)

return result.stdout

except subprocess.CalledProcessError as e:

logger.error(f"执行命令失败: {e.stderr}")

return None

except Exception as e:

logger.error(f"执行命令时发生未知错误: {e}")

return None

# 使用示例

if __name__ == "__main__":

try:

# 创建管理器实例

manager = DockerComposeManager()

# 获取服务状态

print("=== 当前服务状态 ===")

status = manager.get_service_status()

if status:

print(status)

# 启动所有服务

print("\n=== 启动所有服务 ===")

if manager.start_services():

print("所有服务启动成功")

else:

print("服务启动失败")

# 等待服务启动

time.sleep(10)

# 查看API服务日志

print("\n=== API服务日志 ===")

logs = manager.view_logs("api", follow=False)

if logs:

print(logs[:1000]) # 只显示前1000个字符

# 在数据库容器中执行命令

print("\n=== 数据库连接测试 ===")

db_result = manager.execute_command("db", ["pg_isready", "-U", "postgres"])

if db_result is not None:

print("数据库连接测试结果:", db_result.strip())

else:

print("数据库连接测试失败")

except Exception as e:

print(f"程序执行出错: {e}")

6. 监控和日志管理

6.1 资源监控

创建一个资源监控脚本:

# -*- coding: utf-8 -*-

"""

Docker容器资源监控脚本

该脚本用于监控Docker容器的资源使用情况

"""

import subprocess

import json

import time

import logging

from typing import Dict, List, Optional

# 配置日志

logging.basicConfig(

level=logging.INFO,

format='%(asctime)s - %(name)s - %(levelname)s - %(message)s'

)

logger = logging.getLogger(__name__)

class DockerResourceMonitor:

"""Docker资源监控器"""

def __init__(self):

"""初始化监控器"""

self.containers = []

def get_container_stats(self, container_name: Optional[str] = None) -> Optional[List[Dict]]:

"""

获取容器资源统计信息

Args:

container_name (Optional[str]): 容器名称,None表示获取所有容器

Returns:

Optional[List[Dict]]: 容器统计信息列表

"""

try:

cmd = ["docker", "stats", "--no-stream", "--format", "json"]

if container_name:

cmd.append(container_name)

else:

cmd.append("--all")

result = subprocess.run(cmd, capture_output=True, text=True, check=True)

# 解析JSON输出

stats_list = []

for line in result.stdout.strip().split('\n'):

if line:

stats = json.loads(line)

stats_list.append(stats)

return stats_list

except subprocess.CalledProcessError as e:

logger.error(f"获取容器统计信息失败: {e.stderr}")

return None

except json.JSONDecodeError as e:

logger.error(f"解析JSON数据失败: {e}")

return None

except Exception as e:

logger.error(f"获取容器统计信息时发生未知错误: {e}")

return None

def format_stats(self, stats_list: List[Dict]) -> str:

"""

格式化统计信息

Args:

stats_list (List[Dict]): 统计信息列表

Returns:

str: 格式化后的统计信息

"""

if not stats_list:

return "没有容器统计信息"

output = []

output.append(f"{'容器名称':<20} {'CPU使用率':<12} {'内存使用':<20} {'网络I/O':<25} {'块I/O':<25}")

output.append("-" * 100)

for stats in stats_list:

name = stats.get('Name', 'N/A')[:19]

cpu = stats.get('CPUPerc', 'N/A')

mem = f"{stats.get('MemUsage', 'N/A')} / {stats.get('MemLimit', 'N/A')}"

net = f"接收:{stats.get('NetIO_Rx', 'N/A')} 发送:{stats.get('NetIO_Tx', 'N/A')}"

block = f"读取:{stats.get('BlockIO_Read', 'N/A')} 写入:{stats.get('BlockIO_Write', 'N/A')}"

output.append(f"{name:<20} {cpu:<12} {mem:<20} {net:<25} {block:<25}")

return "\n".join(output)

def monitor_resources(self, interval: int = 5, duration: int = 60) -> None:

"""

持续监控资源使用情况

Args:

interval (int): 监控间隔(秒)

duration (int): 监控持续时间(秒)

"""

logger.info(f"开始监控容器资源,间隔{interval}秒,持续{duration}秒")

start_time = time.time()

while time.time() - start_time < duration:

stats = self.get_container_stats()

if stats:

print("\033[2J\033[H") # 清屏并移动光标到左上角

print("=== 容器资源监控 ===")

print(self.format_stats(stats))

print(f"\n更新时间: {time.strftime('%Y-%m-%d %H:%M:%S')}")

time.sleep(interval)

logger.info("资源监控结束")

# 使用示例

if __name__ == "__main__":

try:

# 创建监控器实例

monitor = DockerResourceMonitor()

# 获取当前容器统计信息

print("=== 当前容器资源使用情况 ===")

stats = monitor.get_container_stats()

if stats:

print(monitor.format_stats(stats))

else:

print("无法获取容器统计信息")

# 持续监控(仅作演示,实际使用时可以取消注释)

# monitor.monitor_resources(interval=3, duration=30)

except Exception as e:

print(f"程序执行出错: {e}")

6.2 日志收集和分析

创建日志收集脚本:

# -*- coding: utf-8 -*-

"""

Docker容器日志收集和分析脚本

该脚本用于收集和分析Docker容器的日志

"""

import subprocess

import re

import json

import logging

from typing import Dict, List, Optional

from datetime import datetime

from collections import defaultdict

# 配置日志

logging.basicConfig(

level=logging.INFO,

format='%(asctime)s - %(name)s - %(levelname)s - %(message)s'

)

logger = logging.getLogger(__name__)

class DockerLogAnalyzer:

"""Docker日志分析器"""

def __init__(self):

"""初始化分析器"""

self.error_patterns = [

(re.compile(r'ERROR|error|Error'), '错误'),

(re.compile(r'WARN|warn|Warning'), '警告'),

(re.compile(r'EXCEPTION|exception'), '异常'),

(re.compile(r'FATAL|fatal'), '致命错误')

]

def collect_logs(self, service_name: str, lines: int = 100) -> Optional[List[str]]:

"""

收集服务日志

Args:

service_name (str): 服务名称

lines (int): 收集的日志行数

Returns:

Optional[List[str]]: 日志行列表

"""

try:

cmd = ["docker-compose", "logs", "--tail", str(lines), service_name]

result = subprocess.run(cmd, capture_output=True, text=True, check=True)

return result.stdout.strip().split('\n')

except subprocess.CalledProcessError as e:

logger.error(f"收集{service_name}服务日志失败: {e.stderr}")

return None

except Exception as e:

logger.error(f"收集{service_name}服务日志时发生未知错误: {e}")

return None

def analyze_logs(self, logs: List[str]) -> Dict:

"""

分析日志内容

Args:

logs (List[str]): 日志行列表

Returns:

Dict: 分析结果

"""

if not logs:

return {"error": "没有日志数据"}

analysis = {

"total_lines": len(logs),

"error_count": 0,

"warning_count": 0,

"exception_count": 0,

"fatal_count": 0,

"errors": [],

"warnings": [],

"timestamp_range": {}

}

# 统计各类问题

for line in logs:

for pattern, category in self.error_patterns:

if pattern.search(line):

analysis[f"{category}_count"] += 1

if category == '错误':

analysis["errors"].append(line)

elif category == '警告':

analysis["warnings"].append(line)

# 分析时间范围

timestamps = []

timestamp_pattern = re.compile(r'\d{4}-\d{2}-\d{2}T\d{2}:\d{2}:\d{2}')

for line in logs:

match = timestamp_pattern.search(line)

if match:

try:

timestamp = datetime.fromisoformat(match.group().replace('Z', '+00:00'))

timestamps.append(timestamp)

except ValueError:

continue

if timestamps:

analysis["timestamp_range"] = {

"start": min(timestamps).isoformat(),

"end": max(timestamps).isoformat()

}

return analysis

def generate_report(self, service_name: str, analysis: Dict) -> str:

"""

生成分析报告

Args:

service_name (str): 服务名称

analysis (Dict): 分析结果

Returns:

str: 分析报告

"""

if "error" in analysis:

return f"服务 {service_name} 日志分析失败: {analysis['error']}"

report = []

report.append(f"=== {service_name} 服务日志分析报告 ===")

report.append(f"报告生成时间: {datetime.now().strftime('%Y-%m-%d %H:%M:%S')}")

report.append("")

report.append("基础统计:")

report.append(f" 总日志行数: {analysis['total_lines']}")

report.append(f" 错误数量: {analysis['error_count']}")

report.append(f" 警告数量: {analysis['warning_count']}")

report.append(f" 异常数量: {analysis['exception_count']}")

report.append(f" 致命错误数量: {analysis['fatal_count']}")

if analysis["timestamp_range"]:

report.append("")

report.append("时间范围:")

report.append(f" 开始时间: {analysis['timestamp_range']['start']}")

report.append(f" 结束时间: {analysis['timestamp_range']['end']}")

if analysis["errors"]:

report.append("")

report.append("最近的错误日志 (最多显示5条):")

for error in analysis["errors"][-5:]:

report.append(f" {error}")

if analysis["warnings"]:

report.append("")

report.append("最近的警告日志 (最多显示5条):")

for warning in analysis["warnings"][-5:]:

report.append(f" {warning}")

return "\n".join(report)

# 使用示例

if __name__ == "__main__":

try:

# 创建分析器实例

analyzer = DockerLogAnalyzer()

# 分析API服务日志

print("=== 分析API服务日志 ===")

api_logs = analyzer.collect_logs("api", lines=50)

if api_logs:

api_analysis = analyzer.analyze_logs(api_logs)

print(analyzer.generate_report("api", api_analysis))

else:

print("无法收集API服务日志")

print("\n" + "="*50 + "\n")

# 分析数据库服务日志

print("=== 分析数据库服务日志 ===")

db_logs = analyzer.collect_logs("db", lines=50)

if db_logs:

db_analysis = analyzer.analyze_logs(db_logs)

print(analyzer.generate_report("db", db_analysis))

else:

print("无法收集数据库服务日志")

except Exception as e:

print(f"程序执行出错: {e}")

7. 注意事项

7.1 内存限制

根据宿主机的可用内存,合理设置服务的内存限制:

services:

api:

deploy:

resources:

limits:

memory: 512M # 根据实际需求调整

7.2 安全配置

确保数据库和缓存服务的密码足够复杂:

# 在.env文件中使用强密码

POSTGRES_PASSWORD=StrongP@ssw0rd123!

REDIS_PASSWORD=AnotherStr0ngP@ssw0rd!

7.3 监控资源使用

使用docker stats命令监控容器的资源使用情况:

# 监控所有容器

docker stats

# 监控特定容器

docker stats api db redis

8. 最佳实践

8.1 分离配置文件

将配置文件(如.env和docker-compose-template.yaml)与代码分离,便于维护:

# 推荐的项目结构

dify-ai-system/

├── docker-compose.yml

├── .env

├── .env.example

├── volumes/

│ ├── app/

│ ├── db/

│ ├── redis/

│ └── weaviate/

└── scripts/

├── deploy.sh

├── backup.sh

└── monitor.py

8.2 定期备份数据

定期备份数据库和存储卷中的数据,防止数据丢失:

#!/bin/bash

# backup.sh - 数据备份脚本

# 备份PostgreSQL数据库

docker-compose exec db pg_dump -U postgres dify > backup/dify_$(date +%Y%m%d_%H%M%S).sql

# 备份Redis数据

docker-compose exec redis redis-cli --rdb /data/dump_$(date +%Y%m%d_%H%M%S).rdb

# 备份向量数据库

docker-compose exec weaviate tar -czf /var/lib/weaviate/backup_$(date +%Y%m%d_%H%M%S).tar.gz /var/lib/weaviate

echo "数据备份完成: $(date)"

8.3 优化性能

根据实际需求调整服务的资源配置,提高系统性能:

services:

db:

command: >

postgres

-c 'max_connections=200'

-c 'shared_buffers=256MB'

-c 'work_mem=8MB'

-c 'maintenance_work_mem=128MB'

9. 常见问题

9.1 如何更新服务配置?

修改docker-compose.yaml文件后,运行以下命令重新部署服务:

# 重新部署服务

docker-compose up --force-recreate

# 或者只更新特定服务

docker-compose up --force-recreate api

9.2 如何查看服务日志?

使用docker-compose logs命令查看服务日志:

# 查看所有服务日志

docker-compose logs

# 查看特定服务日志

docker-compose logs api

# 实时跟踪日志

docker-compose logs -f

# 查看最近100行日志

docker-compose logs --tail 100

9.3 如何扩展服务实例?

使用--scale选项扩展服务实例:

# 扩展API服务到3个实例

docker-compose up --scale api=3

9.4 如何处理容器启动失败?

# 查看容器状态

docker-compose ps

# 查看容器日志

docker-compose logs <service_name>

# 进入容器调试

docker-compose exec <service_name> sh

# 重新构建容器

docker-compose build --no-cache <service_name>

10. 扩展阅读

10.1 官方文档

10.2 相关技术资源

10.3 学习路径建议

11. 总结

本文详细介绍了如何使用Docker Compose部署和管理一个完整的AI应用系统。通过合理的架构设计和服务配置,可以实现高效、可扩展的AI应用部署。关键要点总结如下:

11.1 核心要点

- 架构设计:合理设计系统架构,明确各组件职责

- 环境准备:正确安装和配置Docker及Docker Compose

- 配置管理:使用环境变量和配置文件管理服务配置

- 资源优化:根据实际需求调整资源分配

- 监控运维:建立完善的监控和日志管理机制

11.2 实践建议

11.3 未来发展方向

- 容器编排:从Docker Compose迁移到Kubernetes

- 服务网格:引入Istio等服务网格技术

- 自动化运维:使用Ansible、Terraform等工具实现基础设施即代码

- 云原生部署:在AWS、Azure、GCP等云平台上部署AI应用

通过本文的学习,您应该能够:

- 熟练使用Docker Compose部署AI应用

- 理解容器化部署的核心概念

- 掌握服务编排和资源配置方法

- 建立完善的监控和运维体系

希望本文能对您有所帮助,如果您有任何问题或建议,欢迎在评论区留言。

参考资料

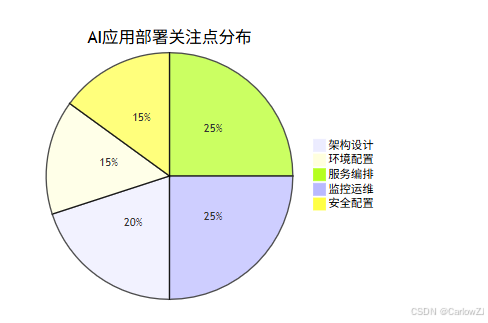

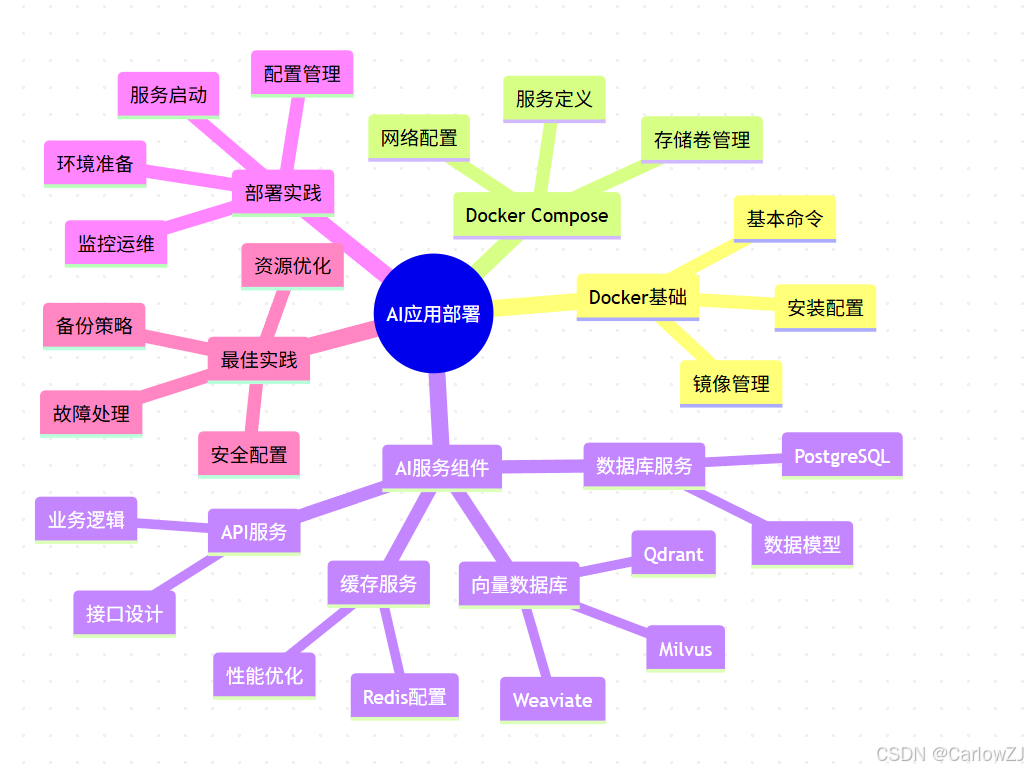

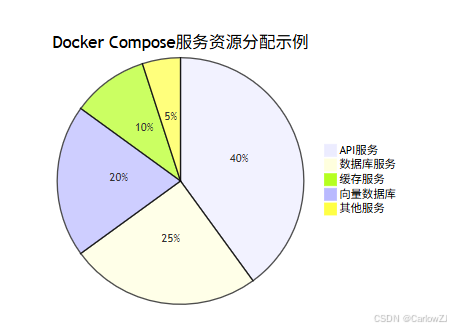

图表示例

架构图

流程图

思维导图

mindmap

root((AI应用部署))

Docker基础

安装配置

基本命令

镜像管理

Docker Compose

服务定义

网络配置

存储卷管理

AI服务组件

API服务

业务逻辑

接口设计

数据库服务

PostgreSQL

数据模型

缓存服务

Redis配置

性能优化

向量数据库

Weaviate

Qdrant

Milvus

部署实践

环境准备

配置管理

服务启动

监控运维

最佳实践

资源优化

安全配置

备份策略

故障处理

甘特图

饼图

354

354

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?