摘要

本文深入解析 freeCodeCamp 挑战评测系统原理,结合 AI 自动批改实践,系统讲解评测系统全景、架构设计、数据流、自动批改实现、AI集成、评测安全与攻防、性能优化、最佳实践与未来展望。通过评测架构图、流程图、思维导图、甘特图、Python 实践代码、常见问题解答等,帮助中国开发者高效构建智能、安全、可扩展的自动评测系统,赋能AI驱动的创新应用。

目录

- 挑战评测系统全景与核心理念

- freeCodeCamp 评测系统架构与数据流

- 自动批改实现原理与流程详解

- Python实现自动批改与AI集成实战

- 评测安全、攻防与性能优化

- 评测系统开发甘特图与思维导图

- 常见问题、最佳实践与未来展望

- 总结

- 参考资料与扩展阅读

- 常见问题解答(FAQ)

一、挑战评测系统全景与核心理念

freeCodeCamp 挑战评测系统是支撑全球数百万用户在线编程学习的核心模块。其设计理念包括:

- 自动化与智能化:自动批改、AI智能评分与反馈

- 安全隔离:沙箱环境、权限控制、攻击防护

- 高可用与可扩展:服务解耦、分布式部署、弹性伸缩

- 数据驱动优化:评测数据分析、个性化推荐、课程迭代

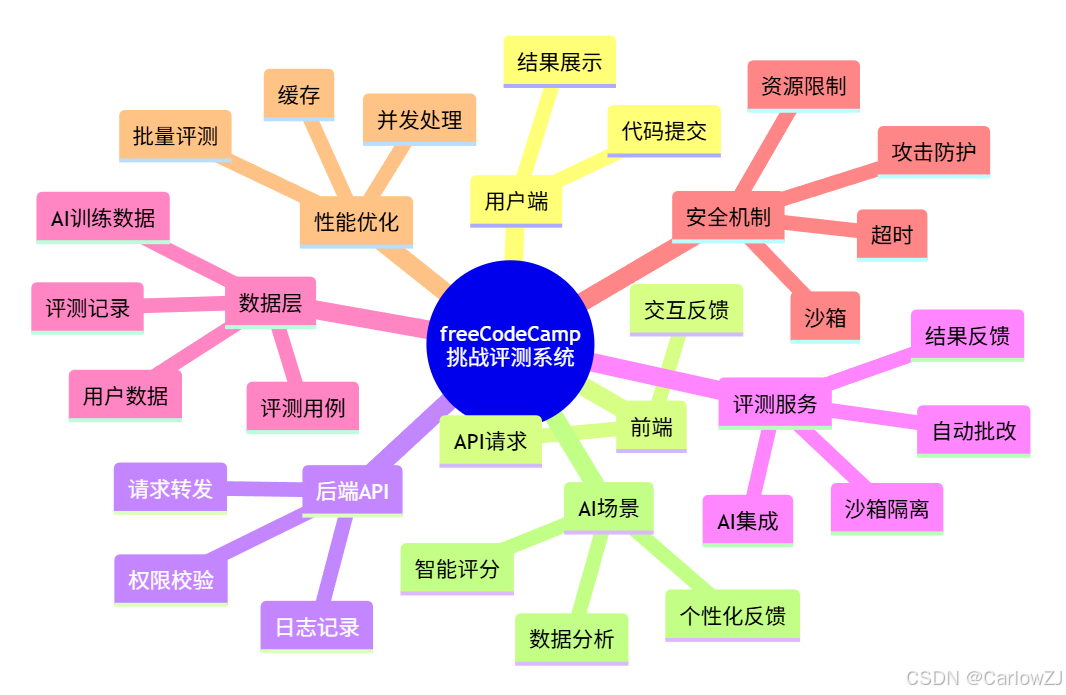

1.1 评测系统架构思维导图

mindmap

root((freeCodeCamp 挑战评测系统))

用户端

代码提交

结果展示

前端

API请求

交互反馈

后端API

请求转发

日志记录

权限校验

评测服务

自动批改

AI集成

沙箱隔离

结果反馈

数据层

评测记录

用户数据

评测用例

AI训练数据

安全机制

沙箱

超时

资源限制

攻击防护

性能优化

并发处理

缓存

批量评测

AI场景

智能评分

个性化反馈

数据分析

二、freeCodeCamp 评测系统架构与数据流

2.1 评测系统架构图

2.2 评测数据流全景

2.3 关键模块说明

- 前端:收集用户代码,展示评测结果

- 后端API:转发请求,记录评测日志,权限校验

- 评测服务:自动化批改,AI集成,安全隔离

- 沙箱环境:安全执行用户代码,防止恶意操作

- AI批改模块:智能评分、个性化反馈、数据分析

- 数据层:评测记录、用例、AI训练数据

重点: 评测系统需保障安全、准确、智能与高可用。

三、自动批改实现原理与流程详解

3.1 自动批改流程图

3.2 自动批改核心原理

- 用户提交代码与输入用例

- 后端API校验并转发至评测服务

- 评测服务在沙箱环境运行代码,捕获输出

- 自动比对输出与预期结果,支持多用例

- AI模块分析代码风格、语义、鲁棒性,生成智能反馈

- 评测结果与反馈写入数据库,返回前端

3.3 AI自动批改扩展

- 结合大语言模型(LLM)、AST分析、静态检查等技术

- 支持代码风格、可读性、算法复杂度等多维度评分

- 个性化学习建议与错误定位

四、Python实现自动批改与AI集成实战

4.1 基础自动批改实现

# -*- coding: utf-8 -*-

"""

示例:Python 自动批改系统(基础版,含多用例、异常处理、沙箱隔离建议)

"""

from flask import Flask, request, jsonify

import subprocess

import tempfile

import os

import signal

app = Flask(__name__)

# 评测接口

@app.route('/judge', methods=['POST'])

def judge():

data = request.json

code = data.get('code')

test_cases = data.get('test_cases', []) # [{"input": "1 2", "output": "3"}, ...]

results = []

for case in test_cases:

with tempfile.NamedTemporaryFile('w', delete=False, suffix='.py') as f:

f.write(code)

temp_path = f.name

try:

# 安全执行用户代码(生产环境建议用docker/sandbox)

proc = subprocess.Popen(['python', temp_path], stdin=subprocess.PIPE, stdout=subprocess.PIPE, stderr=subprocess.PIPE, text=True, preexec_fn=os.setsid)

try:

out, err = proc.communicate(input=case['input'], timeout=3)

except subprocess.TimeoutExpired:

os.killpg(os.getpgid(proc.pid), signal.SIGKILL)

results.append({'case': case, 'result': '超时', 'score': 0})

continue

output = out.strip()

if output == case['output']:

results.append({'case': case, 'result': '通过', 'score': 100})

else:

results.append({'case': case, 'result': '未通过', 'score': 0, 'output': output, 'error': err})

except Exception as e:

results.append({'case': case, 'result': '异常', 'score': 0, 'error': str(e)})

finally:

os.remove(temp_path)

return jsonify({'results': results})

if __name__ == '__main__':

app.run(debug=True)

代码说明:

- 支持多用例、输入输出、超时与异常处理

- 建议生产环境用docker/sandbox隔离

- 结果结构化,便于前端与AI模块集成

4.2 AI智能批改集成(伪代码)

# 伪代码:AI 智能批改

# 1. 代码语法分析(AST)

# 2. 语义理解与评分(LLM/AI模型)

# 3. 个性化反馈生成

# 4. 结合用例结果与AI评分综合打分

# 可结合 OpenAI/GPT/自研模型等API

4.3 单元测试与批量评测脚本

# 单元测试示例

import requests

def test_judge():

url = 'http://localhost:5000/judge'

data = {

'code': 'a, b = map(int, input().split()); print(a+b)',

'test_cases': [

{'input': '1 2', 'output': '3'},

{'input': '10 20', 'output': '30'}

]

}

resp = requests.post(url, json=data)

print(resp.json())

test_judge()

五、评测安全、攻防与性能优化

5.1 评测安全与攻防

- 沙箱隔离:docker、firejail、gVisor等

- 资源限制:CPU、内存、磁盘、网络

- 超时与死循环防护

- 输入输出校验与注入防护

- 日志与审计,异常追踪

5.2 常见攻击与防护措施

| 攻击类型 | 防护措施 |

|---|---|

| 无限循环/超时 | 设置超时、强制kill |

| 资源消耗攻击 | 限制CPU/内存/磁盘 |

| 文件/系统访问 | 沙箱隔离、权限最小化 |

| 网络攻击 | 禁用网络、隔离环境 |

| 代码注入 | 输入校验、只允许特定语言 |

5.3 性能优化与并发扩展

- 并发评测队列、异步处理

- 评测结果缓存、批量评测

- 评测用例与AI模型分层调度

- 日志与监控,自动扩容

六、评测系统开发甘特图与思维导图

七、常见问题、最佳实践与未来展望

- AI批改落地的挑战与机遇

- 评测安全与智能化的平衡

- 数据驱动的课程与评测优化

- 未来趋势:AI原生评测、智能反馈、自动化攻防

八、总结

freeCodeCamp 挑战评测系统为AI自动批改提供了优秀范例。通过自动化、AI集成、沙箱安全、性能优化等机制,开发者可高效构建智能、安全、可扩展的评测系统。建议结合自身业务需求,持续创新与优化。

九、参考资料与扩展阅读

扩展阅读:

- 《Python 自动化评测实战》

- 《AI 智能批改系统设计》

- 《AI 系统工程实践》

- 《安全沙箱与攻防》

十、常见问题解答(FAQ)

- freeCodeCamp 如何保障评测安全?

- 采用沙箱环境,限制代码权限,防止恶意操作。

- Python 自动批改如何防止死循环?

- 设置超时限制,捕获异常,强制kill进程。

- AI 批改如何落地?

- 结合 LLM、代码分析等技术,生成智能反馈。

- 如何实现多用例与批量评测?

- 支持用例列表,循环评测,结构化返回结果。

- 生产环境需注意哪些安全细节?

- 沙箱、资源限制、日志审计、异常处理全流程覆盖。

注意事项:

- 代码示例仅供参考,生产环境需加强安全与异常处理

- 评测系统设计需结合实际业务需求

- 图表需结合实际项目调整

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?