摘要

本文系统介绍如何利用Claude大模型与向量数据库(如Pinecone、MongoDB)集成,构建企业级RAG(检索增强生成)系统。通过多级检索增强、摘要索引、重排序等实战案例,帮助中国AI开发者掌握RAG核心技术与最佳实践。

目录

RAG原理与应用场景

- RAG(Retrieval Augmented Generation):结合检索与生成,提升大模型对企业知识、私有数据的问答能力。

- 典型场景:企业知识库问答、智能客服、金融/法律分析、技术文档检索等。

- Claude优势:支持多种向量数据库,原生API易于集成,支持多级检索增强。

重点:RAG极大提升了大模型在企业级场景下的准确性与可控性。

Claude与向量数据库集成方法

1. 环境准备与API调用

# 安装所需库

%pip install anthropic pinecone-client voyageai

import pinecone

import voyageai

from anthropic import Anthropic

# 初始化API客户端

client = Anthropic()

pinecone.init(api_key="<YOUR_PINECONE_API_KEY>", environment="us-west1-gcp")

vector_db = pinecone.Index("your-index-name")

embedding_client = voyageai.Client(api_key="<YOUR_VOYAGE_API_KEY>")

2. 文档嵌入与向量化

# 文本转向量并上传Pinecone

texts = ["文档1内容", "文档2内容"]

embeddings = embedding_client.embed(texts, model="voyage-2").embeddings

ids = ["doc1", "doc2"]

vector_db.upsert(vectors=list(zip(ids, embeddings)))

3. 检索与生成一体化流程

# 查询向量数据库并用Claude生成答案

query = "请问公司2023年营收是多少?"

query_embedding = embedding_client.embed([query], model="voyage-2").embeddings[0]

results = vector_db.query(queries=[query_embedding], top_k=3)

retrieved_texts = [match['metadata']['text'] for match in results['matches']]

prompt = f"""

你是企业知识专家,请结合以下文档内容回答用户问题:

{retrieved_texts}

问题:{query}

"""

response = client.messages.create(

model="claude-3-opus-20240229",

max_tokens=1024,

messages=[{"role": "user", "content": prompt}]

)

print(response.content[0].text)

多级检索增强实战:基础RAG、摘要索引、重排序

1. 基础RAG实现

# 以本地向量数据库为例

from skills.retrieval_augmented_generation.evaluation.vectordb import VectorDB

db = VectorDB("anthropic_docs")

db.load_data(anthropic_docs) # 预先加载文档

def answer_query_base(query, db):

results, context = db.search(query, k=3), ""

for result in results:

context += f"\n{result['metadata']['text']}\n"

prompt = f"请结合以下文档回答:{context}\n问题:{query}"

response = client.messages.create(

model="claude-3-haiku-20240307",

max_tokens=1024,

messages=[{"role": "user", "content": prompt}]

)

return response.content[0].text

2. 摘要索引与增强检索

# 使用摘要增强的向量数据库

from skills.retrieval_augmented_generation.evaluation.vectordb import SummaryIndexedVectorDB

db_summary = SummaryIndexedVectorDB("anthropic_docs_summaries")

db_summary.load_data(anthropic_docs_summaries)

def answer_query_summary(query, db):

results = db.search(query, k=3)

context = ""

for result in results:

chunk = result['metadata']

context += f"\n{chunk['chunk_heading']}\n{chunk['summary']}\n{chunk['text']}\n"

prompt = f"请结合以下摘要与原文回答:{context}\n问题:{query}"

response = client.messages.create(

model="claude-3-haiku-20240307",

max_tokens=1024,

messages=[{"role": "user", "content": prompt}]

)

return response.content[0].text

3. 重排序与多轮优化

# 先检索20条,再用Claude重排序,选最相关3条

from skills.retrieval_augmented_generation.evaluation.prompts import _rerank_results

def answer_query_rerank(query, db):

initial_results = db.search(query, k=20)

reranked_results = _rerank_results(query, initial_results, k=3)

context = ""

for result in reranked_results:

chunk = result['metadata']

context += f"\n{chunk['chunk_heading']}\n{chunk['summary']}\n{chunk['text']}\n"

prompt = f"请结合以下重排序后的文档回答:{context}\n问题:{query}"

response = client.messages.create(

model="claude-3-haiku-20240307",

max_tokens=1024,

messages=[{"role": "user", "content": prompt}]

)

return response.content[0].text

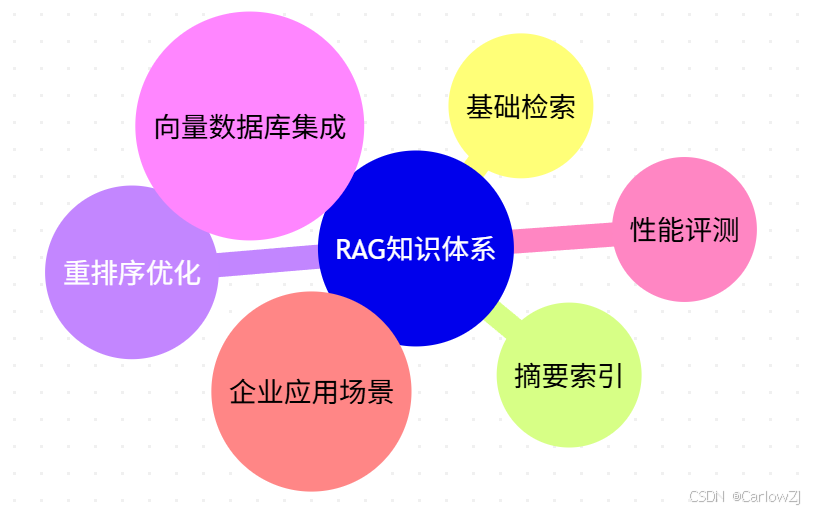

架构图、流程图与思维导图

RAG系统架构图

多级检索增强流程图

RAG知识体系思维导图

mindmap

root((RAG知识体系))

子节点1((基础检索))

子节点2((摘要索引))

子节点3((重排序优化))

子节点4((向量数据库集成))

子节点5((性能评测))

子节点6((企业应用场景))

性能评测与优化技巧

- 评测指标:准确率、召回率、F1、MRR、端到端准确率等。

- 优化技巧:

- 合理分块与摘要,提升召回质量

- 多级检索与重排序,提升相关性

- 缓存与并发,提升响应速度

- 结合业务场景定制检索策略

注意事项与最佳实践

- 数据安全:企业数据需加密存储与传输,API密钥妥善管理。

- 分块策略:文档分块需兼顾粒度与上下文,避免信息丢失。

- 多轮优化:可结合摘要、重排序等多级增强,提升答案准确率。

- 错误处理:API调用需加异常捕获,保证系统稳定性。

最佳实践:优先结构化知识库,合理设计分块与索引,结合多级检索与重排序。

常见问题与扩展阅读

- Q: Claude能否支持多种向量数据库?

- A: 支持,包括Pinecone、MongoDB、本地向量库等。

- Q: 如何提升RAG系统的召回率?

- A: 优化分块、摘要索引、重排序等多级检索。

- Q: 企业数据如何保证安全?

- A: 加密存储、权限控制、API密钥管理。

扩展阅读:

总结与参考资料

- RAG结合向量数据库是企业级AI问答系统的核心能力。

- Claude原生支持多种数据库与多级检索增强,适合复杂业务场景。

- 推荐结合Mermaid图表、思维导图等工具,提升系统可视化与知识梳理能力。

参考资料:

- Anthropic Cookbook官方仓库

- Claude RAG官方文档

- Pinecone集成指南

- Python并发与多线程最佳实践

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?