摘要

本文系统梳理了AgentGPT在与向量数据库集成及知识检索方面的核心原理与工程实现,面向中国AI开发者,深入浅出地讲解其向量检索原理、Pinecone集成、知识库构建、代码实现与工程实践。通过架构图、流程图、思维导图、甘特图、饼图等多种可视化手段,结合详实的Python代码示例和实际应用案例,帮助开发者全面掌握AgentGPT的知识检索与向量数据库集成机制。内容涵盖原理剖析、工程实现、常见问题与最佳实践,适合AI应用开发者、架构师、技术爱好者系统学习与落地。

目录

1. 向量数据库集成系统架构

图1:AgentGPT与向量数据库集成系统架构

2. 核心原理与关键流程

2.1 向量检索的本质

- 文本嵌入:将文本转为高维向量表示

- 向量存储:将嵌入向量存入向量数据库(如Pinecone)

- 相似度检索:根据用户问题向量,检索最相关知识

- 知识拼接:将检索结果拼接到LLM上下文

2.2 关键流程图

图2:AgentGPT向量检索与知识拼接流程

3. 向量检索与知识库实现机制

3.1 文本嵌入与向量化

- 利用OpenAI、HuggingFace等模型将文本转为向量

- 支持多语言、多模态嵌入

3.2 向量数据库集成

- 采用Pinecone、FAISS等高性能向量数据库

- 支持高效的相似度检索与批量写入

3.3 知识检索与上下文拼接

- 检索相关知识,拼接到LLM上下文,提升回复准确性

4. Python实战代码详解

4.1 文本嵌入与向量化

from openai import OpenAI

def get_embedding(text):

# 伪代码:调用OpenAI API获取文本向量

response = OpenAI.Embedding.create(input=text, model="text-embedding-ada-002")

return response["data"][0]["embedding"]

4.2 向量数据库集成与检索

class VectorDB:

def __init__(self, client):

self.client = client # Pinecone或FAISS实例

def insert(self, embedding, text):

# 伪代码:插入向量及原文

self.client.upsert(vectors=[{"id": text, "values": embedding}])

def search(self, embedding, top_k=3):

# 伪代码:相似度检索

results = self.client.query(queries=[embedding], top_k=top_k)

return [match["id"] for match in results["matches"]]

4.3 知识检索与上下文拼接

def retrieve_knowledge(vector_db, query):

embedding = get_embedding(query)

related_texts = vector_db.search(embedding)

return related_texts

def build_context(user_question, related_texts):

# 拼接知识到上下文

context = [user_question] + related_texts

return context

5. 可视化图表与知识体系

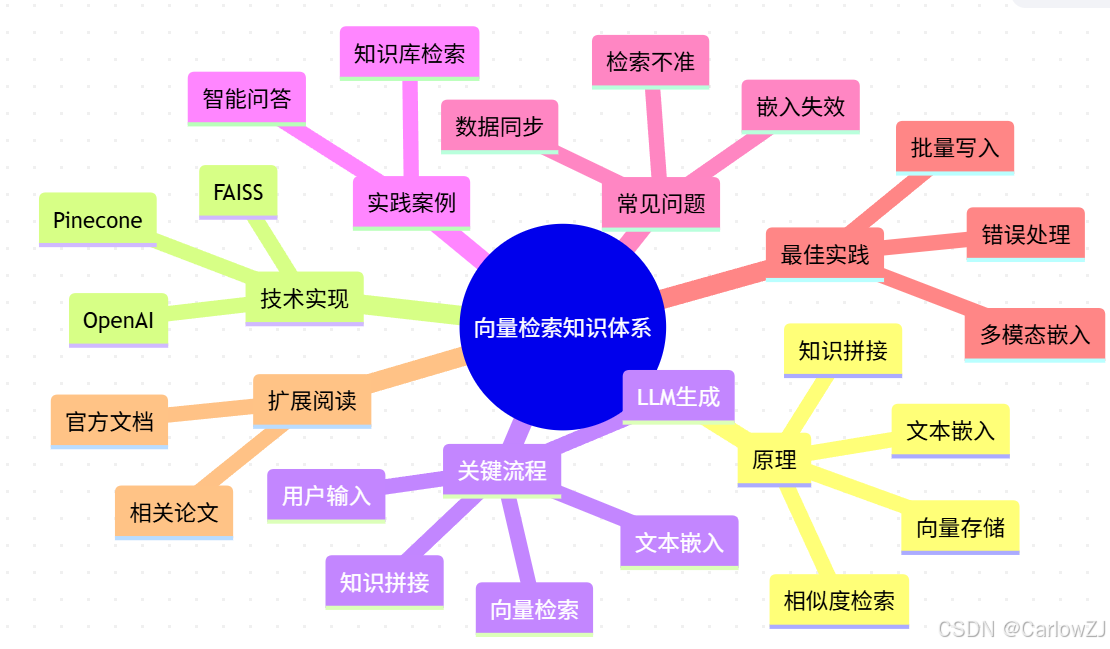

5.1 向量检索知识体系思维导图

mindmap

root((向量检索知识体系))

原理

文本嵌入

向量存储

相似度检索

知识拼接

技术实现

OpenAI

Pinecone

FAISS

关键流程

用户输入

文本嵌入

向量检索

知识拼接

LLM生成

实践案例

智能问答

知识库检索

常见问题

检索不准

嵌入失效

数据同步

最佳实践

批量写入

多模态嵌入

错误处理

扩展阅读

官方文档

相关论文

图3:向量检索与知识库集成知识体系思维导图

5.2 项目实施甘特图

图4:向量数据库与知识检索模块开发甘特图

5.3 数据分布饼图

图5:知识库数据分布饼图

5.4 知识检索时序图

图6:知识检索与上下文拼接时序图

6. 实践案例与最佳实践

6.1 实践案例:智能知识库问答

场景描述:

用户输入"AgentGPT支持哪些数据库?",系统自动检索知识库,拼接相关文档,LLM生成准确回复。

实现步骤:

- 用户输入问题

- 系统将问题嵌入向量,检索相关知识

- 拼接知识到上下文,LLM生成回复

- 前端展示答案

代码片段:

user_question = "AgentGPT支持哪些数据库?"

related_texts = retrieve_knowledge(vector_db, user_question)

context = build_context(user_question, related_texts)

reply = call_llm('\n'.join(context))

print(f"AI:{reply}")

注意事项:

- 嵌入模型需与检索模型一致,防止向量失配

- 数据库需定期同步,保证知识时效性

- 检索结果建议人工校验,提升准确性

7. 常见问题与注意事项

Q1:检索不准怎么办?

优化嵌入模型,增加多模态数据,人工校验结果。

Q2:嵌入失效如何处理?

定期更新嵌入,保证与最新知识同步。

Q3:数据同步不及时怎么办?

增加自动同步与校验机制,保证知识库一致性。

8. 总结与实践建议

- 向量数据库集成极大提升了AgentGPT的知识检索能力

- 建议批量写入与多模态嵌入结合,提升检索效率与准确性

- 参数校验与错误处理是工程落地的关键

- 持续关注向量检索与知识库技术进展,及时优化集成方案

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?