摘要

本文深入探讨HIGRESS在大规模流量场景下的性能优化策略,包括系统架构优化、资源配置优化、缓存策略优化、负载均衡优化等核心内容。通过实际案例和性能测试数据,展示如何构建高性能、高可用的API网关系统。

目录

1. 性能优化概述

1.1 性能指标

1.2 优化目标

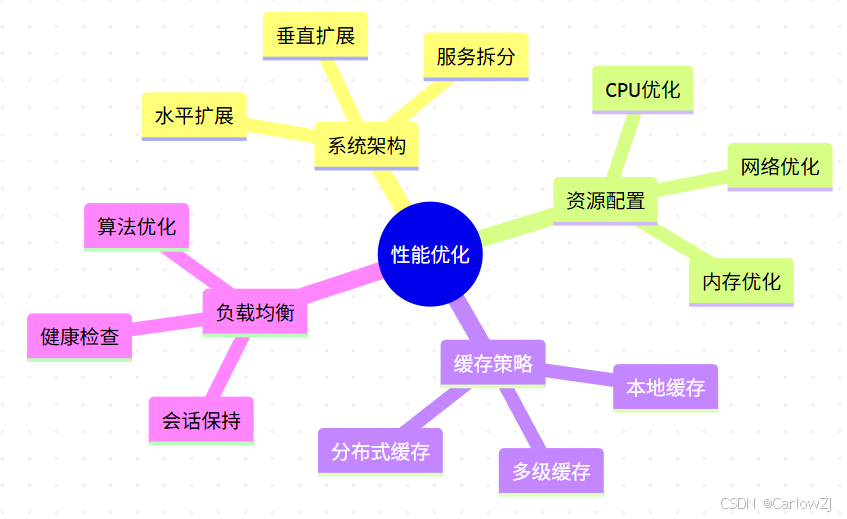

mindmap

root((性能优化))

系统架构

水平扩展

垂直扩展

服务拆分

资源配置

CPU优化

内存优化

网络优化

缓存策略

本地缓存

分布式缓存

多级缓存

负载均衡

算法优化

会话保持

健康检查

2. 系统架构优化

2.1 架构设计

2.2 优化实现

#!/usr/bin/env python3

# -*- coding: utf-8 -*-

from typing import Dict, Any, List

import asyncio

import aiohttp

from dataclasses import dataclass

import time

@dataclass

class PerformanceMetrics:

"""性能指标"""

qps: float

response_time: float

error_rate: float

cpu_usage: float

memory_usage: float

class SystemOptimizer:

"""系统优化器"""

def __init__(self, config: Dict[str, Any]):

"""

初始化优化器

Args:

config: 优化配置

"""

self.config = config

self.metrics_history: List[PerformanceMetrics] = []

async def collect_metrics(self) -> PerformanceMetrics:

"""

收集性能指标

Returns:

性能指标

"""

# 收集QPS

qps = await self._calculate_qps()

# 收集响应时间

response_time = await self._measure_response_time()

# 收集错误率

error_rate = await self._calculate_error_rate()

# 收集资源使用率

cpu_usage = await self._get_cpu_usage()

memory_usage = await self._get_memory_usage()

return PerformanceMetrics(

qps=qps,

response_time=response_time,

error_rate=error_rate,

cpu_usage=cpu_usage,

memory_usage=memory_usage

)

async def optimize(self):

"""执行优化"""

metrics = await self.collect_metrics()

self.metrics_history.append(metrics)

# 根据指标进行优化

if metrics.cpu_usage > 80:

await self._scale_horizontal()

elif metrics.memory_usage > 80:

await self._optimize_memory()

elif metrics.error_rate > 0.01:

await self._optimize_error_handling()

async def _calculate_qps(self) -> float:

"""计算QPS"""

# 实现QPS计算逻辑

pass

async def _measure_response_time(self) -> float:

"""测量响应时间"""

# 实现响应时间测量逻辑

pass

async def _calculate_error_rate(self) -> float:

"""计算错误率"""

# 实现错误率计算逻辑

pass

async def _get_cpu_usage(self) -> float:

"""获取CPU使用率"""

# 实现CPU使用率获取逻辑

pass

async def _get_memory_usage(self) -> float:

"""获取内存使用率"""

# 实现内存使用率获取逻辑

pass

async def _scale_horizontal(self):

"""水平扩展"""

# 实现水平扩展逻辑

pass

async def _optimize_memory(self):

"""内存优化"""

# 实现内存优化逻辑

pass

async def _optimize_error_handling(self):

"""错误处理优化"""

# 实现错误处理优化逻辑

pass

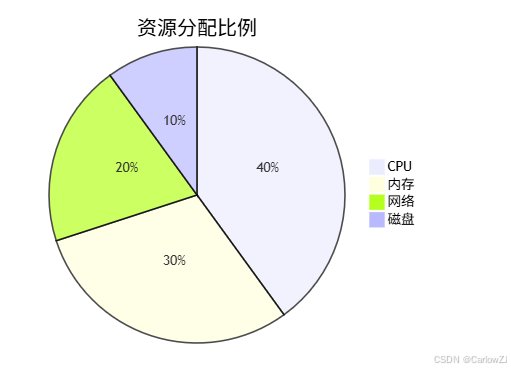

3. 资源配置优化

3.1 资源分配

3.2 优化配置

# resource-config.yaml

apiVersion: v1

kind: ConfigMap

metadata:

name: resource-config

data:

cpu:

request: "2"

limit: "4"

memory:

request: "4Gi"

limit: "8Gi"

network:

bandwidth: "1Gbps"

connections: "10000"

disk:

type: "ssd"

iops: "10000"

4. 缓存策略优化

4.1 缓存架构

4.2 缓存实现

#!/usr/bin/env python3

# -*- coding: utf-8 -*-

from typing import Any, Optional

import redis

from functools import lru_cache

import time

class CacheManager:

"""缓存管理器"""

def __init__(self,

redis_host: str,

redis_port: int,

local_cache_size: int = 1000):

"""

初始化缓存管理器

Args:

redis_host: Redis主机

redis_port: Redis端口

local_cache_size: 本地缓存大小

"""

self.redis_client = redis.Redis(

host=redis_host,

port=redis_port,

decode_responses=True

)

self.local_cache = {}

self.local_cache_size = local_cache_size

@lru_cache(maxsize=1000)

def get_from_local_cache(self, key: str) -> Optional[Any]:

"""

从本地缓存获取

Args:

key: 缓存键

Returns:

缓存值

"""

return self.local_cache.get(key)

def get_from_redis(self, key: str) -> Optional[Any]:

"""

从Redis获取

Args:

key: 缓存键

Returns:

缓存值

"""

return self.redis_client.get(key)

def set_to_local_cache(self, key: str, value: Any, ttl: int = 300):

"""

设置本地缓存

Args:

key: 缓存键

value: 缓存值

ttl: 过期时间

"""

if len(self.local_cache) >= self.local_cache_size:

# 删除最旧的缓存

oldest_key = next(iter(self.local_cache))

del self.local_cache[oldest_key]

self.local_cache[key] = {

'value': value,

'expire_at': time.time() + ttl

}

def set_to_redis(self, key: str, value: Any, ttl: int = 300):

"""

设置Redis缓存

Args:

key: 缓存键

value: 缓存值

ttl: 过期时间

"""

self.redis_client.setex(key, ttl, value)

def get(self, key: str) -> Optional[Any]:

"""

获取缓存

Args:

key: 缓存键

Returns:

缓存值

"""

# 先查本地缓存

value = self.get_from_local_cache(key)

if value is not None:

return value

# 再查Redis

value = self.get_from_redis(key)

if value is not None:

# 更新本地缓存

self.set_to_local_cache(key, value)

return value

return None

def set(self, key: str, value: Any, ttl: int = 300):

"""

设置缓存

Args:

key: 缓存键

value: 缓存值

ttl: 过期时间

"""

self.set_to_local_cache(key, value, ttl)

self.set_to_redis(key, value, ttl)

5. 负载均衡优化

5.1 负载均衡策略

5.2 优化实现

#!/usr/bin/env python3

# -*- coding: utf-8 -*-

from typing import List, Dict, Any

import random

import hashlib

from dataclasses import dataclass

import time

@dataclass

class ServerStats:

"""服务器统计信息"""

connections: int

response_time: float

error_rate: float

cpu_usage: float

memory_usage: float

class LoadBalancer:

"""负载均衡器"""

def __init__(self, strategy: str = "round-robin"):

"""

初始化负载均衡器

Args:

strategy: 负载均衡策略

"""

self.strategy = strategy

self.servers: Dict[str, ServerStats] = {}

self.current_index = 0

def update_server_stats(self,

server: str,

stats: ServerStats):

"""

更新服务器统计信息

Args:

server: 服务器地址

stats: 统计信息

"""

self.servers[server] = stats

def select_server(self, request: Dict[str, Any]) -> str:

"""

选择服务器

Args:

request: 请求信息

Returns:

选中的服务器

"""

if not self.servers:

return None

if self.strategy == "round-robin":

return self._round_robin_select()

elif self.strategy == "weight":

return self._weight_select()

elif self.strategy == "least-connection":

return self._least_connection_select()

elif self.strategy == "consistent-hash":

return self._consistent_hash_select(request)

return list(self.servers.keys())[0]

def _round_robin_select(self) -> str:

"""轮询选择"""

servers = list(self.servers.keys())

server = servers[self.current_index]

self.current_index = (self.current_index + 1) % len(servers)

return server

def _weight_select(self) -> str:

"""权重选择"""

total_weight = sum(1 / (stats.error_rate + 0.001)

for stats in self.servers.values())

random_weight = random.uniform(0, total_weight)

current_weight = 0

for server, stats in self.servers.items():

current_weight += 1 / (stats.error_rate + 0.001)

if random_weight <= current_weight:

return server

return list(self.servers.keys())[-1]

def _least_connection_select(self) -> str:

"""最小连接选择"""

return min(self.servers.items(),

key=lambda x: x[1].connections)[0]

def _consistent_hash_select(self, request: Dict[str, Any]) -> str:

"""一致性哈希选择"""

key = request.get("ip", "")

hash_value = int(hashlib.md5(key.encode()).hexdigest(), 16)

servers = list(self.servers.keys())

return servers[hash_value % len(servers)]

6. 监控与调优

6.1 监控指标

6.2 监控实现

#!/usr/bin/env python3

# -*- coding: utf-8 -*-

from prometheus_client import Counter, Histogram, Gauge

import time

from typing import Dict, Any

import psutil

class PerformanceMonitor:

"""性能监控器"""

def __init__(self):

"""初始化监控器"""

# 系统指标

self.cpu_usage = Gauge(

'system_cpu_usage',

'CPU使用率'

)

self.memory_usage = Gauge(

'system_memory_usage',

'内存使用率'

)

self.network_io = Gauge(

'system_network_io',

'网络IO',

['direction']

)

# 应用指标

self.request_count = Counter(

'app_request_count',

'请求数',

['method', 'path', 'status']

)

self.response_time = Histogram(

'app_response_time',

'响应时间',

['method', 'path'],

buckets=[0.1, 0.5, 1, 2, 5]

)

self.error_count = Counter(

'app_error_count',

'错误数',

['method', 'path', 'error_type']

)

# 业务指标

self.business_success_rate = Gauge(

'business_success_rate',

'业务成功率'

)

self.business_latency = Histogram(

'business_latency',

'业务延迟',

buckets=[0.1, 0.5, 1, 2, 5]

)

self.business_throughput = Gauge(

'business_throughput',

'业务吞吐量'

)

def update_system_metrics(self):

"""更新系统指标"""

# CPU使用率

self.cpu_usage.set(psutil.cpu_percent())

# 内存使用率

memory = psutil.virtual_memory()

self.memory_usage.set(memory.percent)

# 网络IO

net_io = psutil.net_io_counters()

self.network_io.labels('sent').set(net_io.bytes_sent)

self.network_io.labels('recv').set(net_io.bytes_recv)

def record_request(self,

method: str,

path: str,

status: str,

duration: float):

"""

记录请求

Args:

method: 请求方法

path: 请求路径

status: 响应状态

duration: 响应时间

"""

self.request_count.labels(

method=method,

path=path,

status=status

).inc()

self.response_time.labels(

method=method,

path=path

).observe(duration)

def record_error(self,

method: str,

path: str,

error_type: str):

"""

记录错误

Args:

method: 请求方法

path: 请求路径

error_type: 错误类型

"""

self.error_count.labels(

method=method,

path=path,

error_type=error_type

).inc()

def update_business_metrics(self,

success_rate: float,

latency: float,

throughput: float):

"""

更新业务指标

Args:

success_rate: 成功率

latency: 延迟

throughput: 吞吐量

"""

self.business_success_rate.set(success_rate)

self.business_latency.observe(latency)

self.business_throughput.set(throughput)

7. 性能测试

7.1 测试计划

7.2 测试实现

#!/usr/bin/env python3

# -*- coding: utf-8 -*-

import asyncio

import aiohttp

import time

from typing import List, Dict, Any

import statistics

from dataclasses import dataclass

@dataclass

class TestResult:

"""测试结果"""

total_requests: int

success_requests: int

failed_requests: int

response_times: List[float]

throughput: float

error_rate: float

class PerformanceTester:

"""性能测试器"""

def __init__(self,

target_url: str,

concurrency: int = 100,

duration: int = 300):

"""

初始化测试器

Args:

target_url: 目标URL

concurrency: 并发数

duration: 持续时间

"""

self.target_url = target_url

self.concurrency = concurrency

self.duration = duration

self.results: List[TestResult] = []

async def run_test(self) -> TestResult:

"""

运行测试

Returns:

测试结果

"""

start_time = time.time()

end_time = start_time + self.duration

async with aiohttp.ClientSession() as session:

tasks = []

for _ in range(self.concurrency):

task = asyncio.create_task(

self._worker(session, end_time)

)

tasks.append(task)

results = await asyncio.gather(*tasks)

return self._aggregate_results(results)

async def _worker(self,

session: aiohttp.ClientSession,

end_time: float) -> TestResult:

"""

工作协程

Args:

session: HTTP会话

end_time: 结束时间

Returns:

测试结果

"""

total_requests = 0

success_requests = 0

failed_requests = 0

response_times = []

while time.time() < end_time:

start = time.time()

try:

async with session.get(self.target_url) as response:

if response.status == 200:

success_requests += 1

else:

failed_requests += 1

except Exception:

failed_requests += 1

total_requests += 1

response_times.append(time.time() - start)

return TestResult(

total_requests=total_requests,

success_requests=success_requests,

failed_requests=failed_requests,

response_times=response_times,

throughput=total_requests / self.duration,

error_rate=failed_requests / total_requests

)

def _aggregate_results(self,

results: List[TestResult]) -> TestResult:

"""

聚合结果

Args:

results: 测试结果列表

Returns:

聚合后的结果

"""

total_requests = sum(r.total_requests for r in results)

success_requests = sum(r.success_requests for r in results)

failed_requests = sum(r.failed_requests for r in results)

all_response_times = []

for r in results:

all_response_times.extend(r.response_times)

return TestResult(

total_requests=total_requests,

success_requests=success_requests,

failed_requests=failed_requests,

response_times=all_response_times,

throughput=total_requests / self.duration,

error_rate=failed_requests / total_requests

)

def print_report(self, result: TestResult):

"""

打印报告

Args:

result: 测试结果

"""

print("=== 性能测试报告 ===")

print(f"总请求数: {result.total_requests}")

print(f"成功请求: {result.success_requests}")

print(f"失败请求: {result.failed_requests}")

print(f"吞吐量: {result.throughput:.2f} QPS")

print(f"错误率: {result.error_rate:.2%}")

print(f"平均响应时间: {statistics.mean(result.response_times):.3f}s")

print(f"P95响应时间: {statistics.quantiles(result.response_times, n=20)[18]:.3f}s")

print(f"P99响应时间: {statistics.quantiles(result.response_times, n=100)[98]:.3f}s")

8. 最佳实践

8.1 优化建议

-

系统架构

- 采用水平扩展

- 使用缓存层

- 实现服务降级

-

资源配置

- 合理分配CPU

- 优化内存使用

- 控制网络带宽

-

缓存策略

- 使用多级缓存

- 实现缓存预热

- 控制缓存大小

-

负载均衡

- 选择合适算法

- 实现健康检查

- 动态调整权重

8.2 注意事项

-

性能测试

- 模拟真实场景

- 监控系统资源

- 分析性能瓶颈

-

监控告警

- 设置合理阈值

- 及时处理告警

- 定期分析数据

-

运维管理

- 定期维护

- 及时更新

- 做好备份

9. 总结与展望

9.1 关键点总结

- 掌握性能优化方法

- 理解监控指标

- 学会性能测试

- 遵循最佳实践

9.2 后续建议

- 深入学习性能优化

- 了解监控系统

- 掌握测试方法

- 实践项目应用

参考资料

扩展阅读

- 《高性能网站建设指南》

- 《系统性能优化实践》

- 《云原生监控系统》

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?