核心定义:

-

为AI 模型与外部资源建立标准化连接的通信框架

-

让大语言模型 (LLM) 能够安全访问外部数据和工具,而不局限于训练数据

-

定义了统一的通信规范,使不同 AI 系统能无缝交互外部资源

核心框架:

| 组件 | 功能描述 |

| MCP HOST | LLM 应用程序 (如 Claude Desktop、IDE),负责管理客户端和协调 AI 集成 |

| MCP CLIENT | 运行在 Host 内,与 Server 建立 1:1 连接,负责协议交互 |

| MCP SERVER | 轻量级服务,提供特定功能 (如文件访问、数据库查询),封装外部资源 |

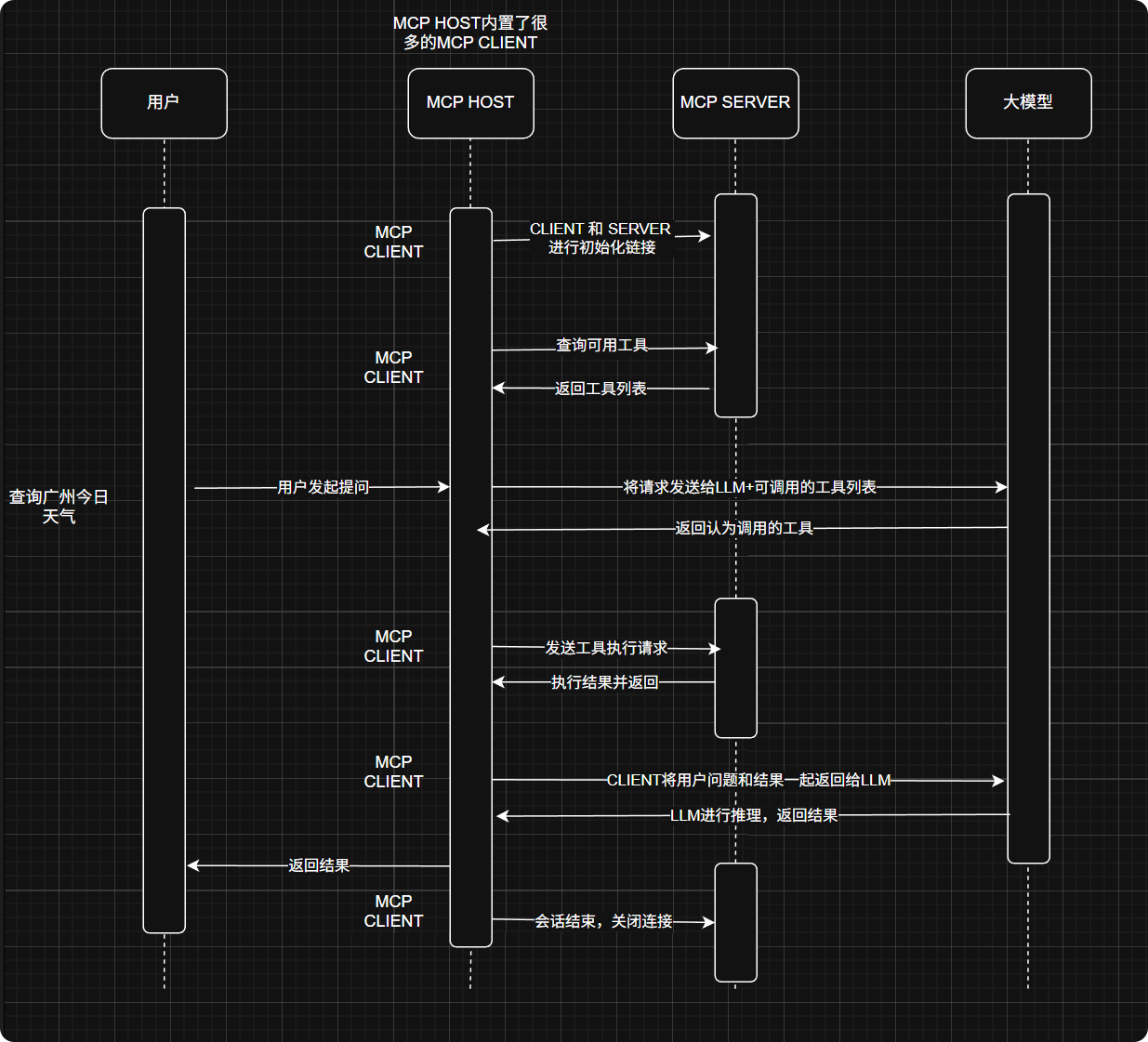

工作流程:

通信机制:

支持两种通信机制:

-

stdio:本地服务,Client 启动 Server 作为子进程,通过标准输入 / 输出通信

-

SSE over HTTP:远程服务,通过服务器发送事件和 HTTP POST 请求交互

核心优势:

-

统一接口:一个协议连接所有外部资源,大幅降低集成成本

-

安全隔离:清晰划分 AI 与外部系统边界,保护敏感数据

-

动态扩展:无需修改模型,随时添加新功能 (如接入新 API)

-

多模型兼容:支持 Claude、GPT 等不同 LLM,实现 "一次集成,多模型使用"

1108

1108

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?