1. 编码器解码器的输入以及目标输出分别是什么

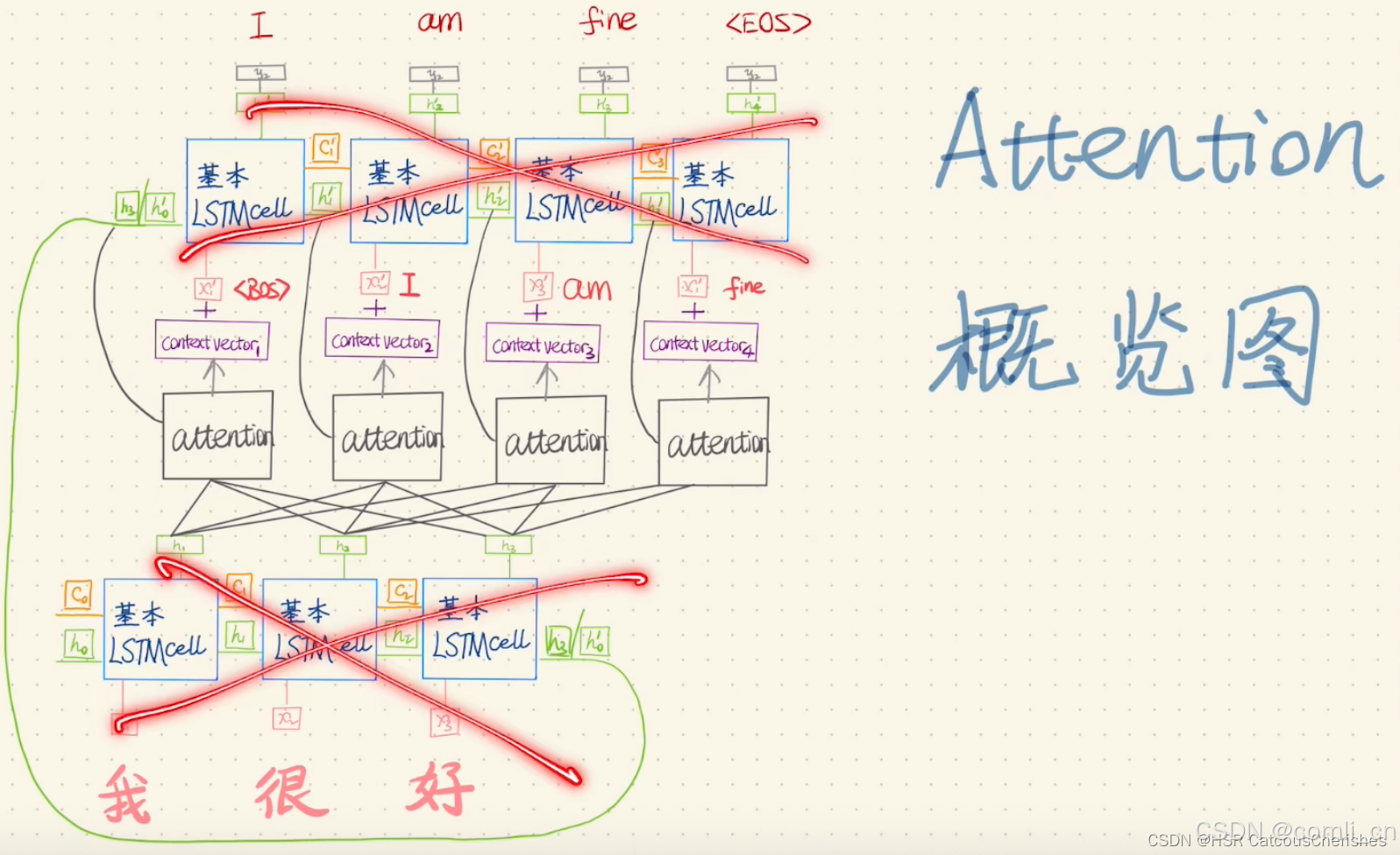

以上图为例,目标是将中文的 “我很好” 翻译成英文的 “I am fine” 。编码器的输入应该是 “我很好”,解码器的输入应该是 “<BOS> I am fine”,而目标是 “I am fine <EOS>”。

2. 手推transformer

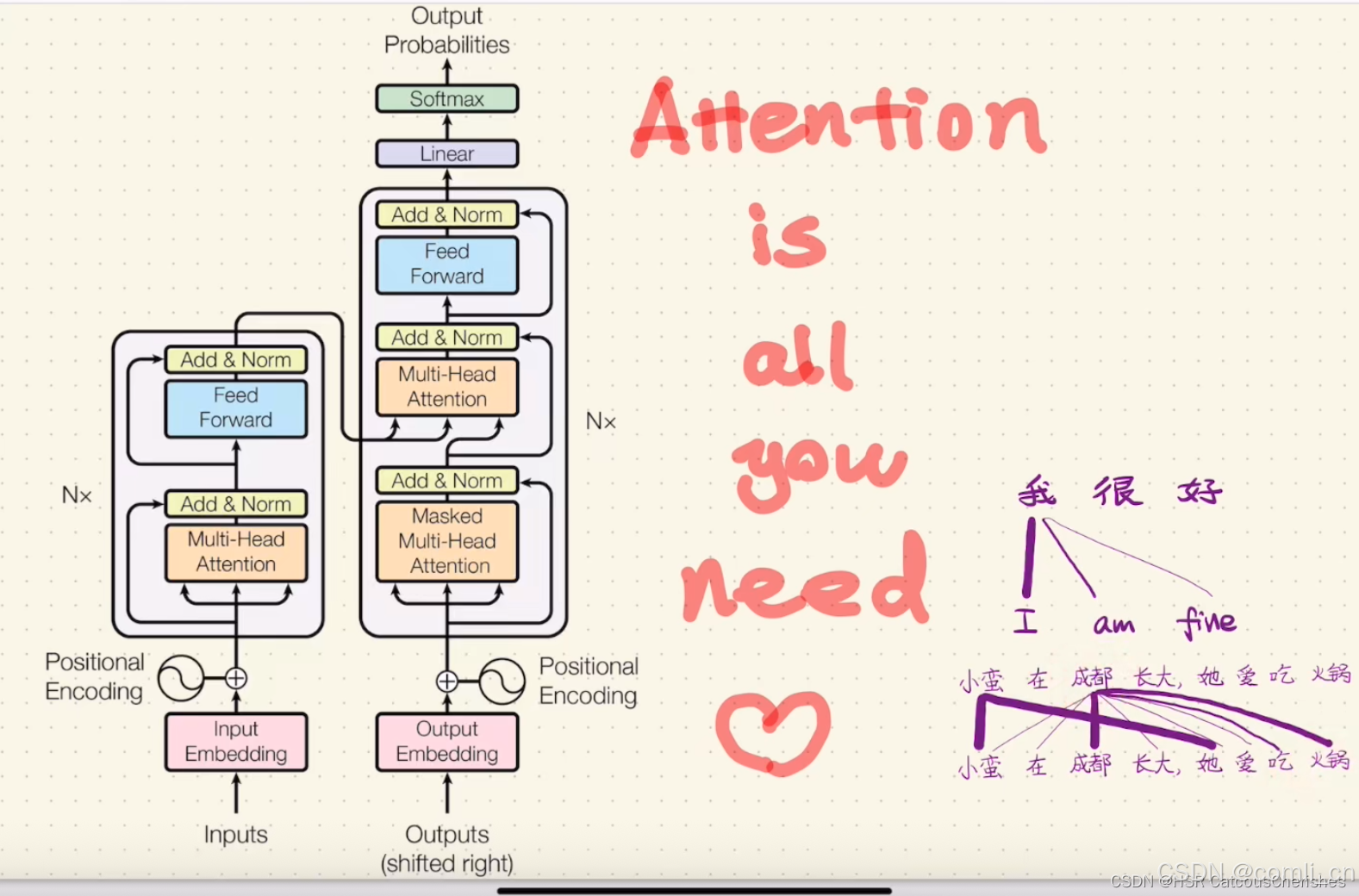

如今transformer的家族成员众多,极大的丰富了NLP领域。首先在transformer出现之前最好的机器翻译模型是带注意力机制的seq2seq模型,但是对于seq2seq模型来说,其中最大的问题是它是循环运算的,这样便不利于保持太长的句子信息,而且也不利于平行计算;然而归根原由,其实是encode与decode中的RNN造成的。既然如此,不如便扔掉RNN,而只保留attention部分。如下图:

下面我们便开始对Attention is all you need来展开Transformer的具体过程计算。

订阅专栏 解锁全文

订阅专栏 解锁全文

1212

1212