源文件是csv,字符集是gbk的,目标mysql是utf8的字符集,按照网上说的,设置characterEncoding为gbk时,能正常导入到mysql,而且没有乱码。但是在做主从库时,出现Slave SQL: Error 'Incorrect string value Error_code: 1366的错误。

仔细追查原因,发现是由于设置characterEncoding为gbk 造成的,需要设置characterEncoding为utf8。但这样导入到mysql的数据中午都是乱码。如何解决呢?

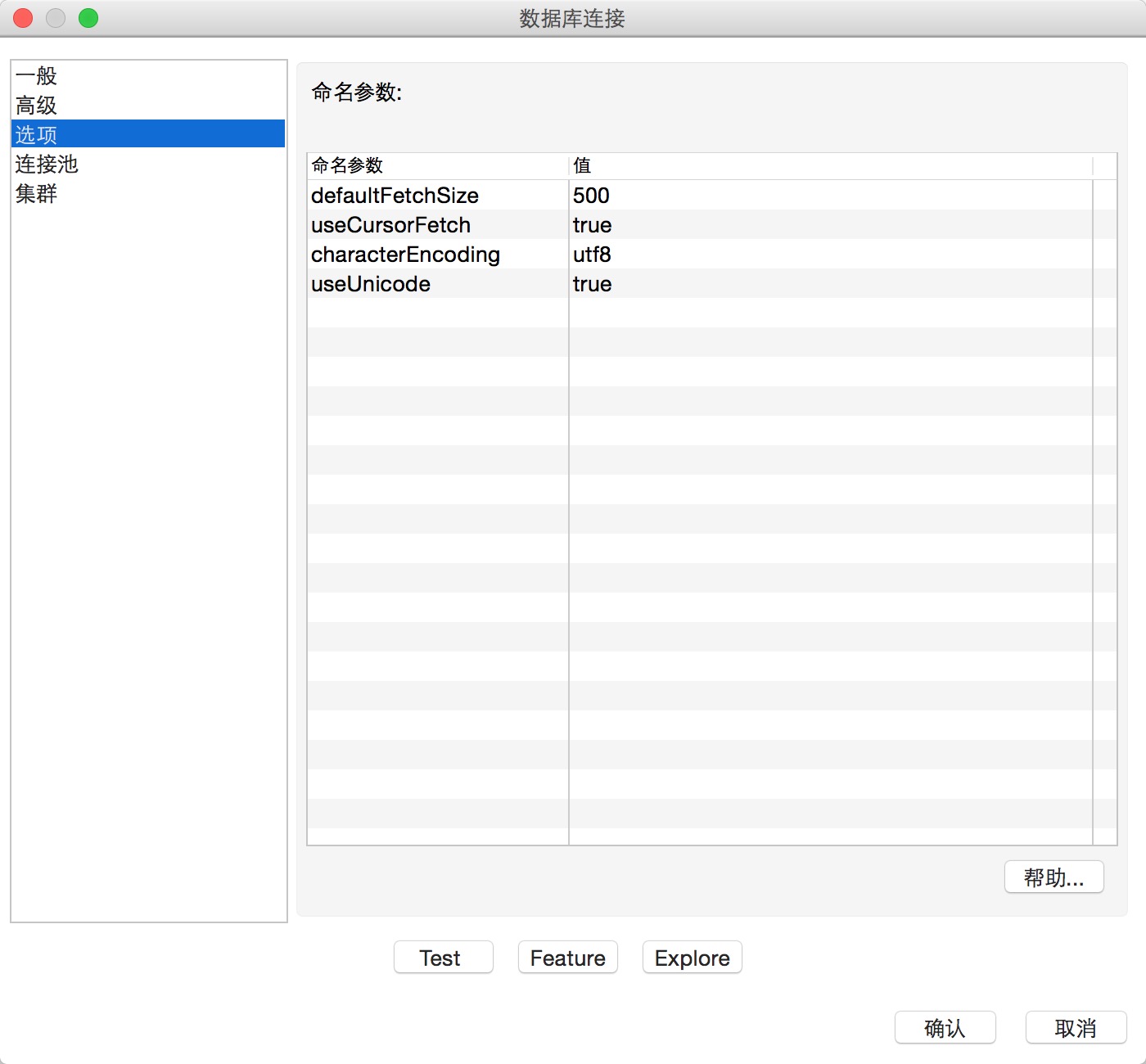

1.设置characterEncoding为utf8。

2.使用select value setp,将中文字段设置为GBK。

本文探讨了从gbk编码的CSV文件导入数据至utf8编码的MySQL数据库时遇到的乱码问题,及在设置主从库同步时出现的“Incorrect string value”错误。文章提出了通过调整字符集设置和使用select valuesetp来解决中文字段乱码的方案。

本文探讨了从gbk编码的CSV文件导入数据至utf8编码的MySQL数据库时遇到的乱码问题,及在设置主从库同步时出现的“Incorrect string value”错误。文章提出了通过调整字符集设置和使用select valuesetp来解决中文字段乱码的方案。

8811

8811

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?