摘要

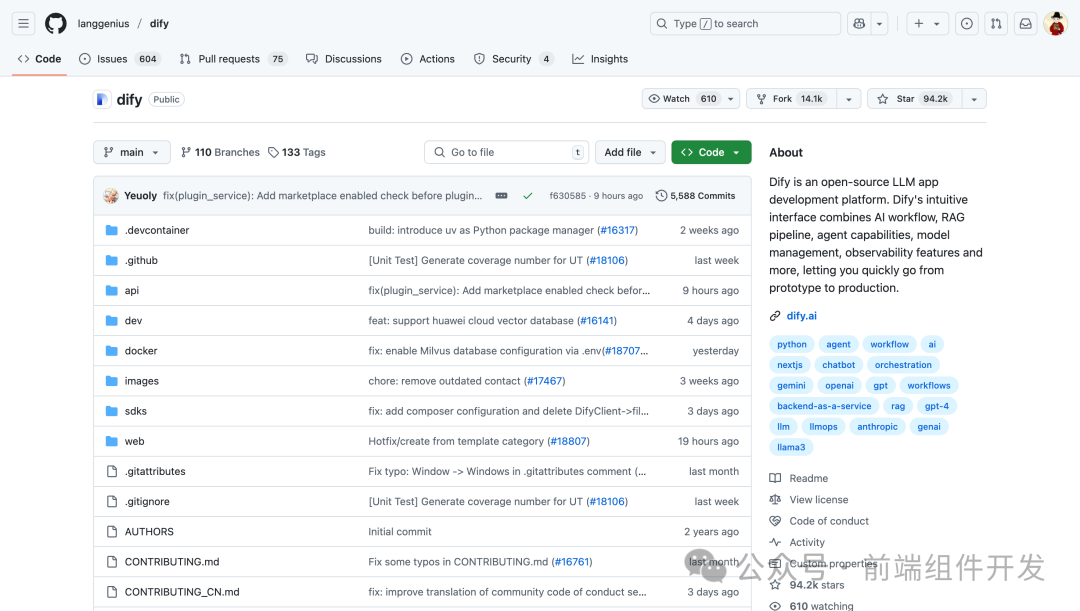

随着大语言模型(LLM)技术的爆发式增长,AI应用的开发门槛逐渐成为制约行业发展的瓶颈。Dify.AI 作为一款开源的LLMOps平台,通过整合AI工作流、RAG(检索增强生成)、Agent智能体、模型管理等核心功能,为开发者提供了一站式解决方案。本文将深入剖析Dify的技术架构、核心优势及其对AI应用开发的革命性影响,并通过对比主流工具(如LangChain、Flowise、OpenAI Assistant API)揭示其差异化价值。

一. 引言:AI应用开发的痛点与破局之道

近年来,LLM技术(如GPT-4、Llama3)的成熟推动了AI应用的快速落地,但开发者仍面临三大挑战:

-

技术栈碎片化:从模型选择、提示工程到RAG优化,开发者需跨越多领域知识;

-

可观测性缺失:生产环境中的模型性能监控与迭代缺乏标准化工具;

-

企业级需求适配难:权限管理、本地化部署等场景缺乏开箱即用的解决方案。

Dify.AI(Dify = Define Your AI)通过“低代码+全生命周期管理”的设计理念,重新定义了LLM应用开发范式,成为开发者与企业的首选平台。

二. Dify.AI的核心架构与功能解析

Dify以模块化设计为核心,覆盖从原型设计到生产运维的全流程,其功能架构如图1所示:

2.1 核心功能模块

-

可视化AI工作流(Workflow)

-

通过拖拽式画布构建复杂逻辑,支持多模型、多工具的组合调用。

-

示例:构建一个“用户查询→文档检索→模型生成→语音播报”的完整流程。

-

-

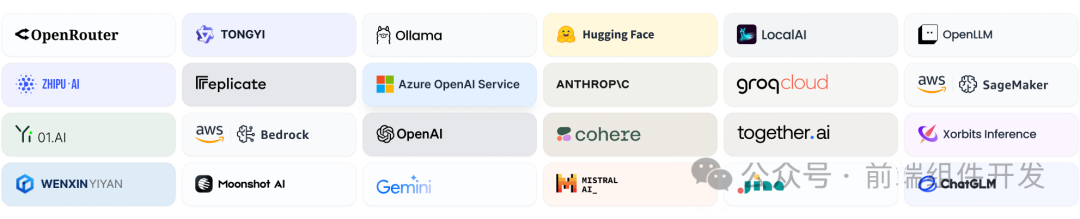

全模型支持与集成

-

兼容数百种开源/闭源模型(GPT、Mistral、Llama3等),支持OpenAI API兼容模型的无缝接入。

-

集成数十种推理服务提供商(如Hugging Face、AWS SageMaker)及自托管方案。

-

-

Prompt IDE:提示工程的全链路优化

-

提供提示词编辑、A/B测试、性能对比等功能,支持文本转语音(TTS)等扩展能力。

-

数据:开发者可通过Prompt IDE将模型响应准确率提升30%以上。

-

-

RAG Pipeline:从文档到知识的闭环

-

支持PDF、PPT等格式的文本提取,结合向量数据库(如Chroma、Pinecone)实现高效检索。

-

内置去重、摘要生成等优化策略,显著提升答案相关性。

-

-

Agent智能体:自主决策的AI助手

-

基于ReAct或函数调用机制,为Agent配置50+内置工具(如Google搜索、DALL·E、WolframAlpha)。

-

案例:通过Agent实现“自动分析用户投诉并生成解决方案”的客服系统。

-

-

LLMOps:生产环境的持续优化

-

实时监控模型性能、日志分析,支持基于用户反馈的提示词与数据集迭代。

-

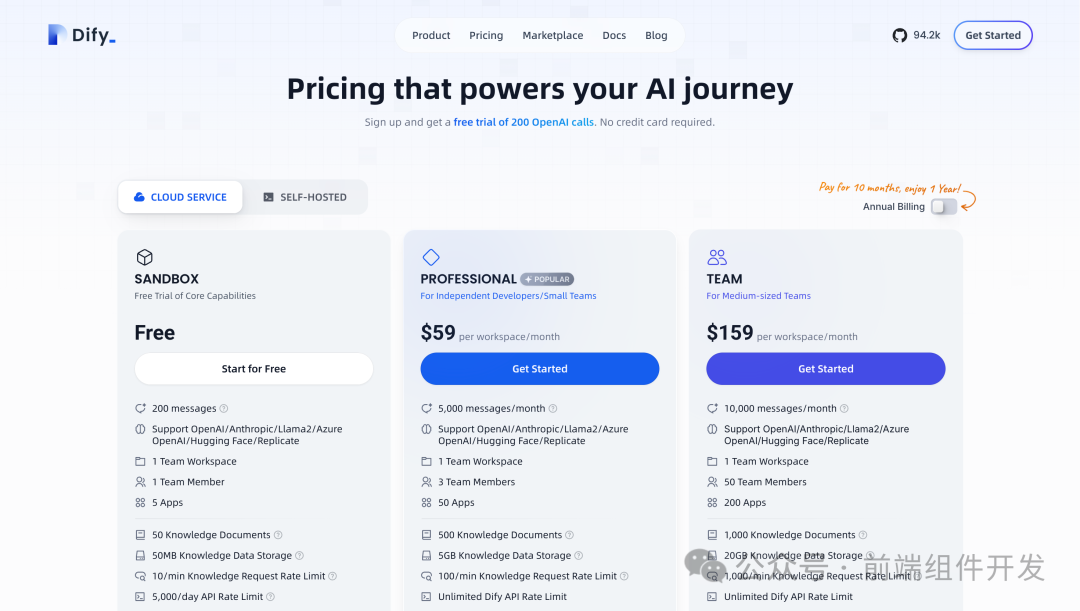

企业版提供SSO、审计日志等安全合规功能。

-

-

后端即服务(BaaS)

-

所有功能通过RESTful API暴露,支持快速集成至现有业务系统。

-

2.2 技术优势

-

低代码优先:非技术人员可通过可视化界面完成80%的开发任务;

-

生态开放:支持自定义插件与模型,避免供应商锁定;

-

企业级支持:提供本地部署、权限控制、高可用集群等方案。

三. 竞品对比:Dify如何脱颖而出?

表1对比了Dify与主流LLM开发工具的关键差异:

| 功能 | Dify.AI | LangChain | Flowise | OpenAI Assistant API |

|---|---|---|---|---|

| 编程方式 |

API + 可视化 |

Python代码 |

可视化 |

API导向 |

| 模型支持 |

数百种(开源/闭源) |

数百种 |

数百种 |

仅OpenAI模型 |

| Agent |

✅(50+内置工具) |

✅ |

❌ |

✅ |

| 工作流 |

✅ |

❌ |

✅ |

❌ |

| 可观测性 |

✅ |

✅ |

❌ |

❌ |

| 本地部署 |

✅ |

✅ |

✅ |

❌ |

关键结论:

-

Dify是唯一同时满足企业级需求(如SSO、本地部署)与全功能覆盖(Agent、工作流、可观测性)的平台;

-

相比LangChain的代码依赖,Dify更易上手;相比Flowise的功能局限,Dify更全面。

四. 快速上手:从零部署Dify社区版

4.1 系统要求

-

CPU:≥2核

-

内存:≥4GB

-

存储:≥20GB(依赖数据量)

4.2 Docker部署步骤

- 克隆仓库并启动服务:

git clone https://github.com/Dify-AI/dify.git cd dify/docker cp .env.example .env docker compose up -d -

访问

http://localhost/install完成初始化配置。

4.3 高级部署选项

-

Kubernetes:通过Helm Chart实现集群化部署;

-

AWS/阿里云:支持一键部署至云平台(如AWS Marketplace、阿里云计算巢)。

五. 应用场景与案例分析

5.1 智能客服系统

-

流程:用户查询 → RAG检索知识库 → Agent调用工具生成答案 → TTS语音反馈。

-

效果:某企业通过Dify将客服响应时间从5分钟缩短至10秒,准确率提升40%。

5.2 数据分析助手

-

流程:上传Excel → Agent解析数据 → 调用WolframAlpha生成可视化报告 → 邮件推送结果。

-

价值:非技术人员可独立完成复杂数据分析任务。

六. 未来展望:Dify的生态化演进

-

模型市场:构建第三方模型与插件的交易平台;

-

边缘计算支持:优化低延迟场景下的推理性能;

-

多模态扩展:集成图像、视频生成能力。

七. 结论

Dify.AI通过“低代码+全栈LLMOps”的创新模式,显著降低了AI应用开发的门槛与成本。其开放生态与企业级支持,使其成为从个人开发者到大型企业的理想选择。随着AI技术的普及,Dify有望推动行业进入“全民开发”的新纪元。

参考文献

[1] Dify.AI官方文档. (2024). https://dify.ai/docs

[2] LangChain官方文档. (2024). https://python.langchain.com/docs

[3] Gartner. (2023). Market Guide for Large Language Model Operations (LLMOps) Platforms.

项目地址:

https://github.com/langgenius/dify

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?