副标题: 从医疗合规到全民开发,低代码如何重构AI生产力?

引言:AI“最后一公里”的破局者

在ChatGPT掀起大模型浪潮后,企业面临的真正挑战并非模型能力,而是如何将AI能力“装进”生产系统。

- 痛点1:开发成本高

——传统AI开发需全栈工程师,周期长、试错成本高;

- 痛点2:场景适配难

——医疗、金融等强监管行业对数据安全、合规性要求严苛;

- 痛点3:运维复杂度高

——模型调优、成本优化、多模型协同等“脏活累活”吞噬企业精力。

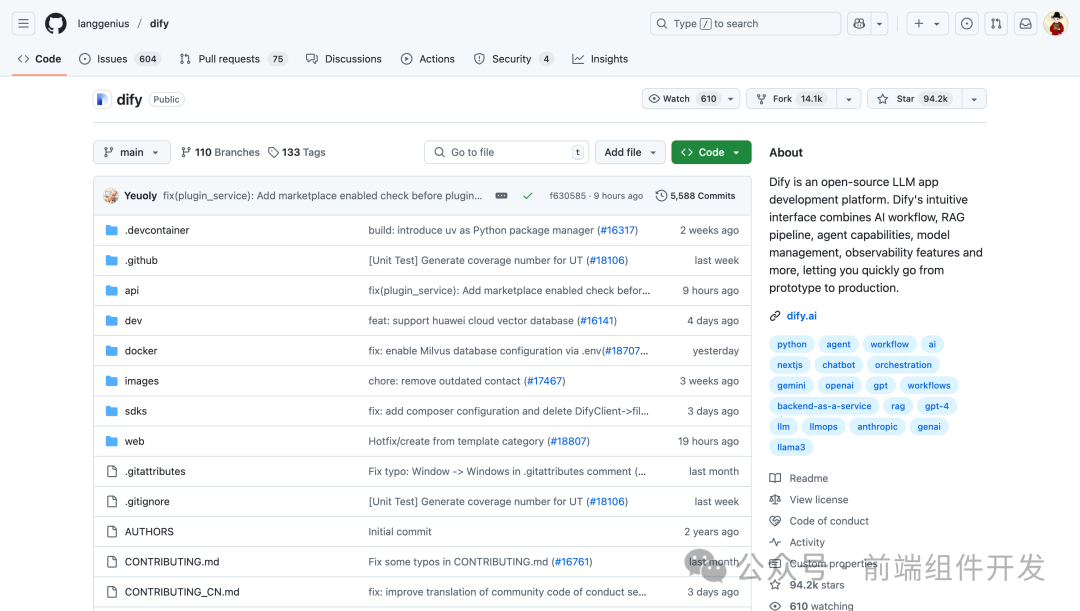

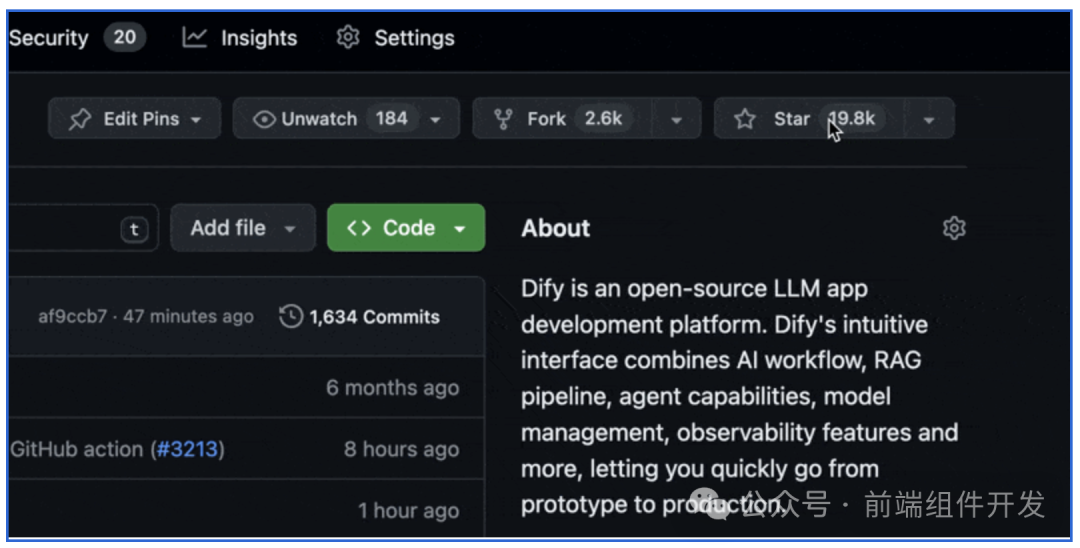

Dify.AI(原腾讯云CODING团队打造)凭借“低代码+LLMOps”双引擎,成为全球首个突破80K Star的生产级AI开发平台。本文将从技术架构、商业价值到行业实践,深度解析其如何成为AI落地的“操作系统”。

一、技术基因:从CODING到LLMOps的降维打击

Dify.AI的诞生绝非偶然,其技术血统源自腾讯云CODING DevOps团队——中国SaaS工具领域的“隐形冠军”。

1. 架构设计:兼顾灵活与安全的“三明治模型”

- 基础设施层

:依托AWS全球节点,实现低延迟部署(日本市场用户占比超30%),支持私有化集群+公有云混合架构;

- AI能力层

:

- RAG引擎

:PDF/PPT秒解析+向量检索(Weaviate/Elasticsearch),检索延迟<100ms,某医疗企业通过混合调用Claude3+通义千问,将专业问答准确率提升至90%;

- Agent框架

:内置50+工具(如谷歌搜索、DALL·E),支持多模态输入(图像、语音),某投资顾问Agent可自动解析用户需求并生成方案;

- RAG引擎

- 应用层

:提供可视化编排(ReactFlow拖拽式设计)+Prompt IDE(代码补全、性能分析),开发者可“零代码”构建AI工作流。

2. 核心技术:打破大模型“不可能三角”

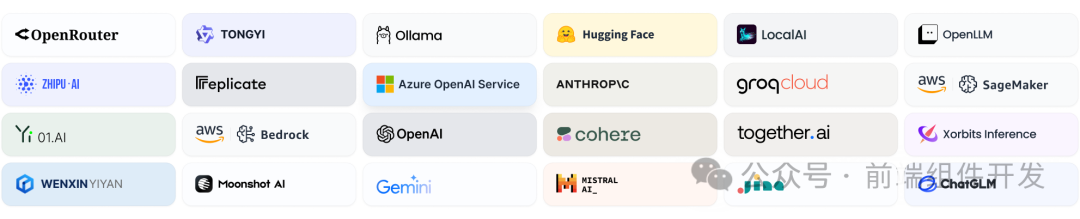

- 多模型中立性

:兼容OpenAI、Claude、Llama等200+模型,支持动态切换(如某企业根据成本/效果自动切换模型);

- 弹性架构

:基于AWS EKS实现4倍并发提升,支撑千万级文档实时处理,某出版社通过Dify将书籍摘要生成效率提升8倍;

- 低代码扩展性

:插件市场提供预构建模块(如SQL生成、数据分析),某科技公司通过插件连接内部工单系统,集成周期从12周缩短至3周。

二、商业价值:AI普惠化的“三把钥匙”

1. 成本优化:让企业“用得起”大模型

- 模型混合调用

:通过策略路由,将计算成本降低30%(如医疗场景混合使用Claude3与通义千问);

- 算力优化

:基于Amazon Graviton芯片,推理成本下降20%,性能提升1.5倍;

- 资源复用

:支持多租户共享模型实例,某物流企业通过共享GPT-4资源,将客服成本降低40%。

2. 效率革命:让业务人员“造得出”AI

- 全民开发

:某科技巨头内部业务团队自主搭建7600个AI应用(覆盖代码审查、数据分析),研发效率提升40%;

- 知识库即服务

:某医院通过RAG+阿里云OpenSearch构建病历检索系统,响应准确率达95%,同时满足HIPAA合规要求;

- 自动化运维

:实时监控Token使用量、模型性能,支持基于用户反馈的持续优化(如某电商将客服响应准确率从60%提升至92%)。

3. 生态协同:构建AI开发的“安卓市场”

- 云服务商集成

:与AWS、阿里云深度合作(如通过阿里云OpenSearch提升RAG检索效率3倍);

- 插件生态

:开放SDK支持企业自定义插件,某制造企业通过插件连接ERP系统,将订单异常处理效率提升70%;

- 社区裂变

:2023年上线36小时内创建1500+应用,GitHub Star突破80K,跻身全球Top 100开源项目。

三、行业实践:从实验室到生产线的“最后一公里”

1. 医疗合规:AI如何守住生命线?

- 场景

:某三甲医院构建患者咨询系统,需满足HIPAA合规要求;

- 方案

:

-

私有化部署+数据加密,确保病历数据不出域;

-

混合调用通义千问+本地医疗大模型,实现专业术语精准解析;

-

通过RAG引擎检索历史病例,结合Agent调用医学文献数据库。

-

- 效果

:响应准确率95%,人工审核量减少80%。

2. 智能制造:AI如何让工厂“更聪明”?

- 场景

:某汽车工厂需实现生产异常的自动化处理;

- 方案

:

-

基于ReAct框架分解任务(如“检测设备故障”→“查询库存”→“生成维修方案”);

-

动态调用摄像头(图像识别)、ERP系统(库存查询)、计算器(成本估算);

-

通过Dify的可视化编排界面,业务人员3天完成开发。

-

- 效果

:人工干预减少70%,设备停机时间缩短50%。

3. 传统企业转型:百年老店的“AI重生”

- 场景

:日本某百年制造企业需构建内部知识管理系统;

- 方案

:

-

集成日语专业术语库和历史文档,支持多模态检索(PDF/视频);

-

通过Dify的低代码能力,业务团队自主开发培训系统、故障诊断助手;

-

部署在AWS东京节点,实现毫秒级响应。

-

- 效果

:员工查询效率提升3倍,成为日本首个采用中国开源工具的传统企业。

四、部署安装

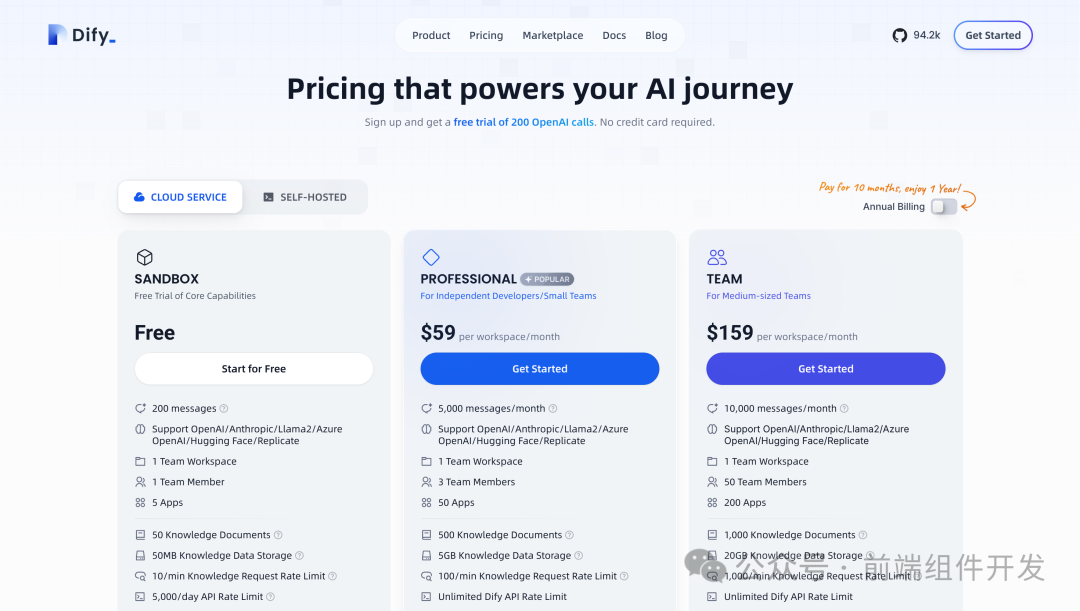

1. 部署方式任选,从云端到本地化自由切换

-

极速上云:通过AWS Marketplace或官网一键启动,新用户免费获200次GPT-4调用,适合验证原型(如个人知识助手)。

-

自托管部署:Docker部署仅需一行命令

docker compose up -d,支持PostgreSQL/Redis/Weaviate等中间件,技术团队可深度定制(如添加自定义模型)。 -

企业级方案:提供Kubernetes高可用部署、OAuth2.0单点登录、独立数据隔离,满足金融级安全要求。

# 克隆仓库

git clone https://github.com/langgenius/dify.git

cd dify/docker

# 复制配置文件

cp .env.example .env

# 启动Docker容器

docker compose up -d

# 浏览器访问初始化界面

http://localhost/install

五、未来展望:AI开发者的“新基建”

Dify.AI的崛起标志着AI开发范式的根本转变:

- 从“模型中心”到“场景中心”

:通过多模型混合调度+RAG知识库,实现成本与效果的平衡;

- 从“技术垄断”到“全民开发”

:业务人员可通过可视化界面完成80%的AI开发工作;

- 从“实验室创新”到“规模化生产”

:LLMOps工具链将AI落地周期从数月缩短至数天。

正如Dify创始人所言:“我们的目标不是替代开发者,而是让每个企业都能拥有自己的‘AI工厂’。”

在AI“寒武纪大爆发”时代,Dify.AI正成为连接技术能力与商业价值的“最后一公里”。

结尾金句:

“当AI能力像水、电、煤一样成为基础设施时,Dify.AI就是那个为你接通管道的工程师。”

点击关注公众号,获取Dify.AI开源版部署教程+行业案例白皮书!

本文数据来源:Dify.AI官网、GitHub仓库、AWS技术白皮书、企业客户访谈(匿名处理)。

版权声明:本文为原创技术解析,转载需注明出处。

1223

1223

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?