当多个线程同时访问一个共享的、可变的资源(如变量、对象、文件等)时,无论操作系统如何调用这些线程,也不论线程间的执行顺序如何交织,程序都能表现出正确的行为,并且不需要额外的同步或协调操作,那就称这个资源是线程安全的。

线程不安全的根源

在开始之前我们先了解一下硬件上的一些处理。

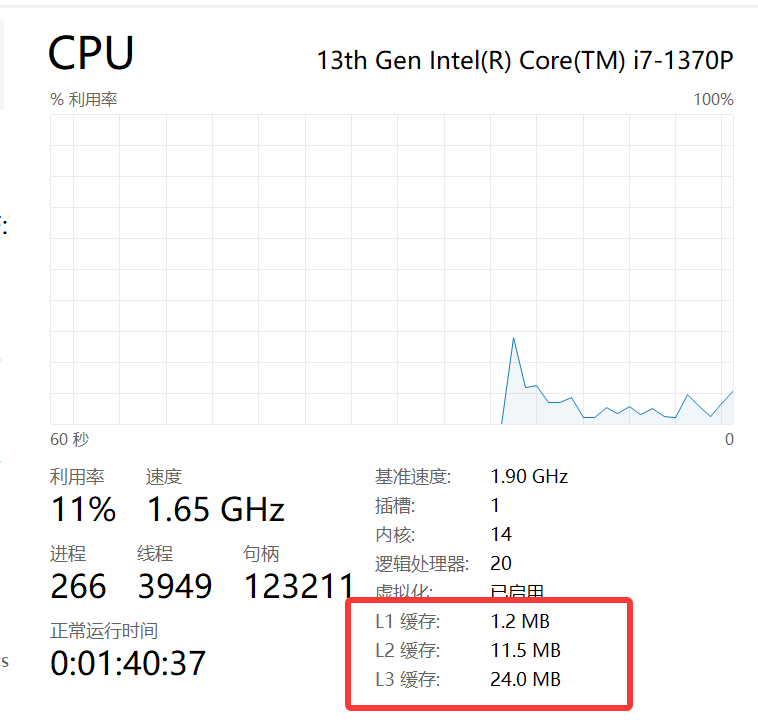

CPU缓存

CPU缓存的出现是为了CPU极致运算速度与主内存相对缓慢速度之间的巨大性能差距,被称为冯·诺伊曼瓶颈。现代CPU通常采用三层缓存结构:

L1缓存:最靠近CPU核心,集成在CPU核心内部,速度最快,访问延迟通常只有1~3个CPU时钟周期;容量是三级缓存里最小的;核心直接使用的数据和指令都来自这里,尽可能快的满足核心的要求。

L2缓存:同样位于CPU核心内部或非常接近核心,速度比L1缓存慢,访问延迟约10~20个时钟周期;作为L1缓存的后备仓库,当L1缓存未命中时,CPU会到L2缓存中查找数据,查找到数据,就将数据返回L1缓存;容量要比L1要大。

L3缓存:由一个CPU插槽上所有核心共享,速度最慢,访问延迟约20~50个时钟周期;但是容量最大;作为所有核心的共享缓冲池,当不同核心需要访问相同数据时,可以从L3快速获取,避免直接访问慢速的主内存,取到数据后将数据返回L2;如果L3中也没有相关数据,才需要访问最慢的主内存。同时也是维护缓存一致性协议(如MESI协议)的关键层面,核心之间通过L3来同步数据的修改。

局部性原理

缓存行:通过一次性加载一个数据块,而不是单个数据项,可以大幅减少访问内存的次数。缓存行的出现是基于时间局部性和空间局部性原理引入的。

时间局部性:如果一个数据被访问,那么它很可能在不久的将来再次被访问。因此尽量重用已经访问过的数据,让它快速留在L1/L2缓存中。

空间局部性:如果一个内存位置被访问,那么它附近的内存位置也可能很快被访问。因此尽量顺序访问数据,充分利用缓存行的预取机制。

缓存一致性

由于每个CPU都有自己的私有缓存,这就导致一个问题:同一个内存地址的数据,可能在多个核心的缓存中都存在副本,如果一个核心修改了自己缓存中的副本,其他核心如何能知道这个数据已“过期”?

缓存一致性协议就是用来解决这个问题的硬件机制,最著名的就是MESI,定义了缓存行的四种状态:

| 状态 | 全称 | 含义 | 当前核心可否写入? | 其他核心是否有副本? | 缓存行数据是否最新? |

|---|---|---|---|---|---|

| M | Modified (修改) | “脏”数据。缓存行已被修改,与主内存中的数据不一致。这是唯一的有效副本。 | 可以 | 否 (独占) | 是 (但内存中不是) |

| E | Exclusive (独占) | “干净”数据。缓存行与主内存一致,且只有当前核心有该副本。 | 可以 (写入后变为 M) | 否 | 是 |

| S | Shared (共享) | “干净”数据。缓存行与主内存一致,但可能有多个核心有该副本。 | 不可以 | 是 | 是 |

| I | Invalid (无效) | 缓存行中的数据是过时、无效的,不能使用。 | 不可以 | - (无意义) | 否 |

当一个核心A读取数据时,如果发现不在自己的缓存中,就在总线上发出“读”请求,如果其他核心都没有这个数据的副本,内存直接提供数据,此核心将缓存行的状态设为E;如果其他核心有这个数据的副本,这些核心会做响应,同时将自己缓存行的状态改为或者保持为S,核心A将自己缓存行状态也设为S。

当核心A要写数据时,判断自己缓存行状态为E时,就直接写入数

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

620

620

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?