✅ 博主简介:擅长数据搜集与处理、建模仿真、程序设计、仿真代码、论文写作与指导,毕业论文、期刊论文经验交流。

✅ 具体问题可以私信或扫描文章底部二维码。

(1)为了有效解决传统粒子群优化算法(PSO)在后期迭代过程中因种群多样性锐减而极易陷入局部最优解的困境,从而导致测试用例生成无法覆盖到程序中某些深层或复杂路径的问题,我们提出了一种融合了自适应随机测试(Adaptive Random Testing, ART)思想的改进粒子群优化算法。该算法的核心机制在于建立一个动态的监控与干预系统。在算法的常规迭代过程中,系统会持续监测种群的收敛状态,通常通过评估种群适应度值的方差或最优粒子位置在连续多代内的停滞情况来判断。一旦检测到种群陷入停滞,即算法可能已经收敛到局部最优区域,系统便会激活自适应随机测试模块。此模块并非简单地引入随机扰动,而是采用一种更具指导性的策略。它首先会分析当前粒子群中所有已生成的测试用_例(即粒子位置),并将这些测试用例视为一个已探索的解空间样本集。接着,对于种群中适应度较低、长期未得到改善的粒子,或者随机选择一部分粒子,算法会启动“相似性驱动的变异”过程。具体而言,它会计算这些待变异粒子与已探索样本集中所有测试用例的欧氏距离或汉明距离,以评估它们之间的相似度。基于“错误往往聚集”的假设,新的候选测试用例应当在远离已知已覆盖区域的位置生成,以探索未知的程序行为。因此,算法会根据相似性评估结果,有策略地在与现有测试用例相似度较低的区域生成新的粒子。这个生成过程可以是在整个搜索空间内进行,但更高效的方式是围绕当前最优粒子,在其邻域内进行差异化探索,或者在多个局部最优解之间进行插值和外推,从而产生既有探索性又保留了一定利用性的新粒子。这些新生成的粒子被注入回种群中,替换掉那些适应度最差的个体,从而瞬间提升了种群的多样性,为算法提供了挣脱局部最优吸引盆的动力。这种自适应的干预机制是“按需”触发的,避免了在算法正常收敛阶段引入不必要的随机性,保证了算法的整体收敛效率,同时又能在关键时刻有效地增强全局探索能力,显著提高了对复杂程序路径的覆盖率。

(2)传统粒子群优化算法在应用于大型、复杂软件的测试用例生成时,面临着一个严峻的挑战:随着程序输入参数维度的增加,测试用例的搜索空间呈指数级增长,导致算法的计算成本急剧上升。每一次迭代中,对每个粒子的适应度进行评估都需要完整地执行一次被测程序,这在程序逻辑复杂、执行时间较长的情况下,会消耗大量的计算资源和时间。为了解决这一“维度灾难”和高昂的评估成本问题,我们引入了代理模型(Surrogate Model)辅助的粒子群优化算法。该策略的核心思想是用一个计算成本极低的近似模型来替代大部分昂贵的真实程序执行。具体实施流程如下:首先,在算法正式开始迭代之前,我们通过拉丁超立方采样(Latin Hypercube Sampling)等高效的实验设计方法,在整个搜索空间中生成一个规模适中、分布均匀的初始样本集。然后,将这个样本集中的每个样本点作为测试用例输入到被测程序中执行,记录其真实的适应度值(例如,路径覆盖的接近程度)。利用这些“输入-输出”数据对,我们训练一个代理模型,常用的模型包括径向基函数网络(RBF)、克里金模型(Kriging)或支持向量回归(SVR)。这个代理模型能够根据输入的粒子位置(测试用例),快速预测其可能的适应度值。在PSO的迭代过程中,对于种群中的每一个粒子,我们不再直接执行被测程序,而是先使用训练好的代理模型对其进行适应度估计。这个过程的计算开销极小。然后,根据代理模型预测的适应度值,我们采用一种精英策略,只选择预测值最优的一小部分粒子(例如,排名前10%的粒子)去执行真实的被测程序,以获取它们精确的适应度值。这样做极大地减少了真实程序的调用次数。更重要的是,这个过程是动态更新和自我优化的。每次获得真实适应度值后,我们会计算它与代理模型预测值之间的误差。这些新的、带有真实标签的数据点将被加入到初始训练集中,用于在线更新和优化代理模型,使其在后续的迭代中预测得更加准确。这种“预测-验证-更新”的闭环机制,使得代理模型能够在算法运行过程中不断学习和进化,逐步逼近真实程序的行为,从而在保证搜索精度的前提下,将计算成本降低几个数量级,显著提升了在高维搜索空间下测试用例生成的效率。

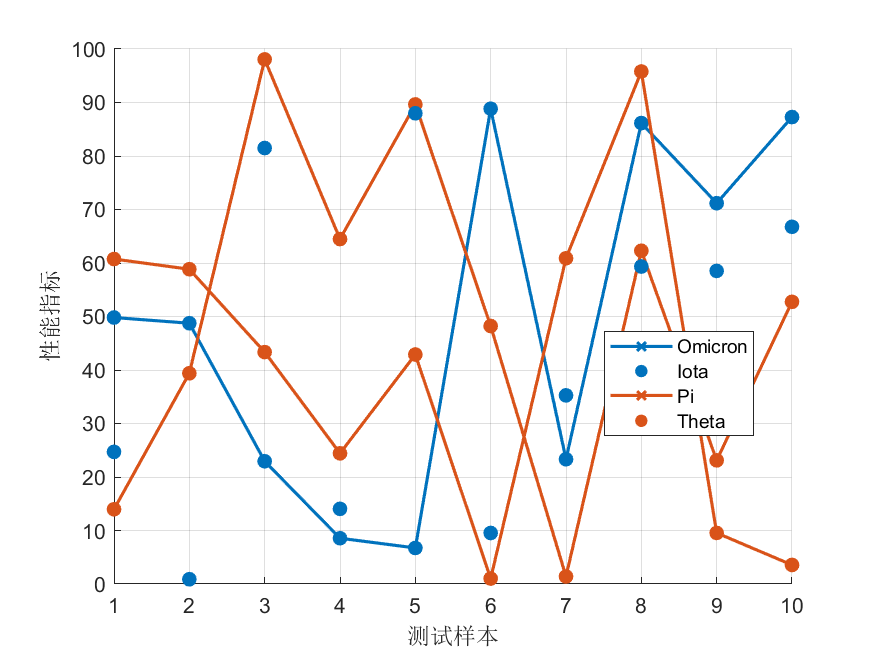

(3)在上述两种核心算法改进的基础上,我们设计并实现了一个集成化的、用户友好的测试用例自动生成原型系统。该系统旨在为软件测试工程师提供一个从参数配置到结果分析的一站式解决方案,并具备良好的可扩展性。系统的前端采用图形用户界面(GUI)设计,用户可以通过直观的窗口和控件进行操作。首先,用户可以方便地加载被测程序(例如,通过指定可执行文件或类库路径),并配置测试目标,如选择需要覆盖的目标路径、分支或函数。接着,用户可以通过界面设置测试用例的输入参数范围、数据类型以及约束条件。在算法选择层面,系统内置了我们提出的两种改进PSO算法以及标准PSO算法作为基线对比。用户可以通过下拉菜单或复选框灵活选择要使用的优化算法,并对算法的关键参数进行调整,例如种群大小、迭代次数、惯性权重、学习因子,以及针对改进算法的特定参数(如随机测试触发阈值、代理模型更新频率等)。系统启动后,后端会调用相应的算法引擎执行测试用例生成任务,并在前端实时显示关键的性能指标,如当前的路径覆盖率、已生成测试用例数量、迭代进程等,通过动态图表(如覆盖率随时间变化的曲线)为用户提供直观的监控。当生成任务完成后,系统会将所有生成的测试用例、对应的覆盖信息以及最终的覆盖率报告进行结构化存储。用户可以在结果分析模块中查看详细的报告,包括每个目标路径是否被覆盖、覆盖该路径的具体测试用例是什么。系统还提供了测试用例集的导出功能,方便用户将其集成到自动化测试框架中。此外,系统的架构设计遵循了模块化和接口化的原则,核心的搜索算法模块被设计成可插拔的插件形式。这为未来集成更多先进的搜索算法(如遗传算法、模拟退火、差分进化等)提供了极大的便利,测试人员只需按照预定义的接口规范实现新的算法,即可无缝对接到系统中,从而极大地提高了算法验证和比较的效率,使该原型系统成为一个功能强大且易于扩展的测试用例生成研究与应用平台。

import numpy as np

import random

class Particle:

def __init__(self, dim, bounds):

self.position = np.array([random.uniform(bounds[i][0], bounds[i][1]) for i in range(dim)])

self.velocity = np.zeros(dim)

self.best_position = np.copy(self.position)

self.fitness = float('inf')

self.best_fitness = float('inf')

def objective_function(x):

# Placeholder for a real test case evaluation function

# e.g., branch distance calculation

target_branch_value = 10

actual_value = sum(x)

return abs(target_branch_value - actual_value)

def pso_for_test_generation(dim, bounds, num_particles, max_iter, w=0.5, c1=1.5, c2=1.5):

swarm = [Particle(dim, bounds) for _ in range(num_particles)]

global_best_particle = min(swarm, key=lambda p: p.fitness)

global_best_position = np.copy(global_best_particle.position)

global_best_fitness = float('inf')

for i in range(max_iter):

for particle in swarm:

particle.fitness = objective_function(particle.position)

if particle.fitness < particle.best_fitness:

particle.best_fitness = particle.fitness

particle.best_position = np.copy(particle.position)

if particle.fitness < global_best_fitness:

global_best_fitness = particle.fitness

global_best_position = np.copy(particle.position)

for particle in swarm:

r1 = np.random.rand(dim)

r2 = np.random.rand(dim)

cognitive_velocity = c1 * r1 * (particle.best_position - particle.position)

social_velocity = c2 * r2 * (global_best_position - particle.position)

particle.velocity = w * particle.velocity + cognitive_velocity + social_velocity

particle.position += particle.velocity

for j in range(dim):

if particle.position[j] < bounds[j][0]:

particle.position[j] = bounds[j][0]

elif particle.position[j] > bounds[j][1]:

particle.position[j] = bounds[j][1]

if global_best_fitness < 1e-6:

print(f"Target reached at iteration {i+1}")

break

print("Global Best Position (Test Case):", global_best_position)

print("Global Best Fitness (Branch Distance):", global_best_fitness)

return global_best_position, global_best_fitness

if __name__ == '__main__':

# --- System Parameters ---

# Dimension of the input vector for the software under test

INPUT_DIMENSION = 5

# Bounds for each input parameter

PARAMETER_BOUNDS = [(-10, 10)] * INPUT_DIMENSION

# --- PSO Algorithm Parameters ---

NUM_PARTICLES = 30

MAX_ITERATIONS = 200

INERTIA_WEIGHT = 0.7

COGNITIVE_COEFFICIENT = 1.8

SOCIAL_COEFFICIENT = 1.8

generated_test_case, fitness = pso_for_test_generation(

dim=INPUT_DIMENSION,

bounds=PARAMETER_BOUNDS,

num_particles=NUM_PARTICLES,

max_iter=MAX_ITERATIONS,

w=INERTIA_WEIGHT,

c1=COGNITIVE_COEFFICIENT,

c2=SOCIAL_COEFFICIENT

)

如有问题,可以直接沟通

👇👇👇👇👇👇👇👇👇👇👇👇👇👇👇👇👇👇👇👇👇👇

2217

2217

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?