Overview

TurboTransformers是腾讯最近开源的BERT推理模型,它的特点就是一个字,快。本人用BERT(huggingface/transformers)在V100上做了测试,测试结果和官宣的基本一致:TurboTransformers的推理速度要比Pytorch快上1~4倍。

它之所以快,是因为它是专用于BERT的轻量级推理模型。

分层

不管是计算机的硬件、软件,还是现在的深度学习,它们都遵循着一个很重要的设计思想–分层:

- 用简单的代码(或电路)来实现一个基本功能组件。

- 用几个基本组件组合成一个功能更强的复杂组件。

- 从简单到复杂,像搭积木一样,一层层地搭建出拥有很强功能的组件。

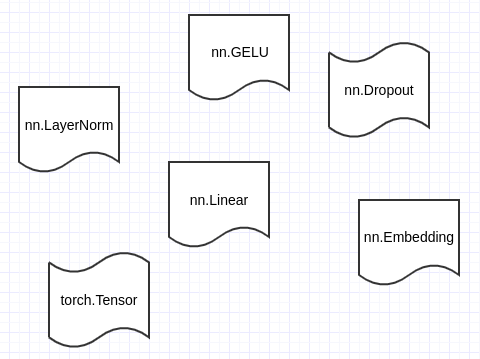

开发者只需要基于PyTorch的几个基本组件就能搭建出BERT模型,而且这些组件本身对他们来说都是透明的。正因如此,PyTorch才越来越受到研究者青睐。

分层设计的优点很多,例如,可以简化问题、降低创新门槛、加速开发等,但它的缺点也很明显:

本文深入解析腾讯开源的TurboTransformers,一个专为BERT推理设计的轻量级模型,能实现比Pytorch快1~4倍的速度。通过分层设计、分层展开和融合算子等优化,降低延迟并提高效率。TurboTransformers的tensor库仅包含BERT前向传播所需算子,并支持与PyTorch模型参数的无缝迁移。

本文深入解析腾讯开源的TurboTransformers,一个专为BERT推理设计的轻量级模型,能实现比Pytorch快1~4倍的速度。通过分层设计、分层展开和融合算子等优化,降低延迟并提高效率。TurboTransformers的tensor库仅包含BERT前向传播所需算子,并支持与PyTorch模型参数的无缝迁移。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?