2023 findings-acl.685

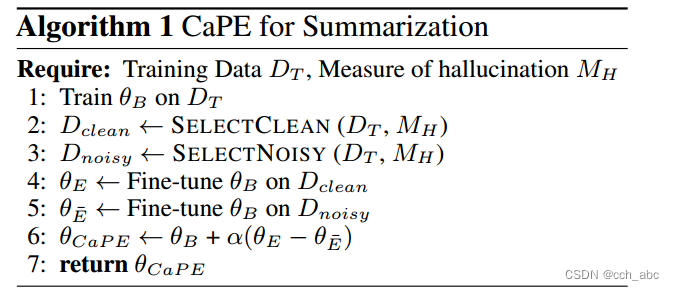

出了一种称为对比参数集成(CaPE)的新方法,可以更有效地使用训练数据,利用训练样本中噪声的变化来减少幻觉。从对整个数据集进行微调的基础模型开始,分别在数据的干净和有噪声的子集上训练专家和反专家模型。然后,我们调整的参数的基础模型,通过添加(减去)的参数的专家(反专家),推进最近的工作添加剂参数集成方法。 在一个小得多的数据子集上训练,专家和反专家模型只会略微(<14%)增加总训练时间。此外,CaPE使用参数集成并且不增加推理时间。实验结果表明,CaPE提高了不同自动事实指标和人工评估的性能,XSUM和CNN/DM数据集的摘要级依赖弧蕴涵准确性最大提高了16.69%和15.38%。CaPE模型根据信息量指标(如ROUGE)对基础模型进行验证。

使用多专家的原因

据过滤减少了训练数据的大小,从而减少了目标摘要的多样性,因为去除的噪声样本也可能包括有用的特定于任务的知识。 这会影响生成的摘要的其他方面,例如信息回忆或流畅性。

在这项工作中,我们设计了一个简单而有效的策略来利用干净和嘈杂的训练样本。基于总结模型中的幻觉水平与训练数据中的噪声水平相关的观察,我们提出了对比参数集成(CaPE),它通过增加(减去)在干净(有噪声)数据子集上训练的模型的权重来调整基础模型的参数。这种方法的动机是最近的工作证明了神经机器翻译中检查点平均的简单形式的有效性

在干净(噪声)数据集上对该模型进行微调,以获得专家(反专家)。通过在全部数据上进行训练,然后在干净(噪声)子集上进行微调,我们希望我们的专家(反专家)模型能保留基础模型的其他方面,如 ROUGE 和信息召回率,而仅在事实质量上有所不同。

θB为模型基本参数 θE为干净模型的参数 θE逆为噪声模型的参数

θB为模型基本参数 θE为干净模型的参数 θE逆为噪声模型的参数

其中

新方法CaPE通过对比训练数据的干净和噪声部分,训练专家和反专家模型,有效减少幻觉,提高XSUM和CNN/DM摘要准确度。

新方法CaPE通过对比训练数据的干净和噪声部分,训练专家和反专家模型,有效减少幻觉,提高XSUM和CNN/DM摘要准确度。

6898

6898