作者丨张冠华

单位丨腾讯实习生 & 哈工大本科生

研究方向丨自然语言处理

导读

句对匹配 (Natural Language Sentence Matching,NLSM) 任务是指给定两个句子,判断它们的关系。常见的自然语言处理任务如 Paraphrase Identification 和 Natural Language Inference 都属于句对匹配的范畴。

在本文中,我们调研了六个 NLSM 数据集,发现这些数据集中广泛地存在一种样本选择偏差 (Selection Bias),以致于只使用三种和语义完全无关的特征,就可以在一些数据集上达到和 LSTM 差不多的准确率,这些特征被称为泄漏特征 (Leakage Feature)。

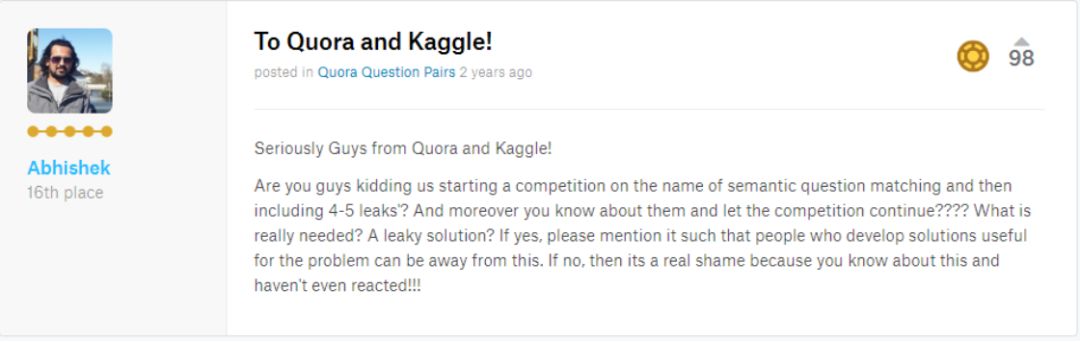

事实上, Leakage Feature 在 Kaggle 的各种比赛中早已受到了广泛的关注。在 Quora 官方在 Kaggle 上举行的比赛 Quora Question Pairs [1] 中,排名前列的模型中全部都用到了 Leakage Feature。而在 WSDM - Fake News Classification [2] 的数据集中,Leakage Features 也有很强的预测能力。

虽然 Leakage Feature 的预测能力很强,但是这些特征中的模式只是数据集构造过程中人工引入,在真实世界中不可推广。所以在比赛的讨论区中,Kaggle Grandmaster,boost.ai 的首席数据科学家 Abhishek 就曾质问比赛的严肃性。

本文探究了 Leakage Feature 的产生原因和其对深度模型的影响,并提出了一种不需要任何额外资源的去偏训练、评估方法,实验证明我们的方法能提升模型的真实泛化能力并提供更可靠的评估结果。

问题定义

句对匹配中的Leakage Features

本文研究了句对匹配任务中存在的一种样本选择偏差,即Leakage Feature,并探讨了其对模型的影响。作者发现,仅使用与语义无关的特征在某些数据集上就能取得较高准确率。为解决这一问题,提出了无需额外资源的去偏训练和评估方法,实验证明该方法能提高模型的泛化能力和评估可靠性。

本文研究了句对匹配任务中存在的一种样本选择偏差,即Leakage Feature,并探讨了其对模型的影响。作者发现,仅使用与语义无关的特征在某些数据集上就能取得较高准确率。为解决这一问题,提出了无需额外资源的去偏训练和评估方法,实验证明该方法能提高模型的泛化能力和评估可靠性。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

911

911

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?