文章汉化系列目录

摘要

我们介绍了 CommerceMM —— 一种多模态模型,能够为给定内容(图像、文本、图像+文本)提供多样化和细粒度的电商主题理解,并且具备推广到广泛任务的能力,包括多模态分类、图像-文本检索、查询到商品检索、图像到商品检索等。我们遵循预训练+微调的训练方案,并提出了5个有效的预训练任务,这些任务针对图像-文本对进行设计。为了更好地适应更常见和多样化的电商数据,涵盖了文本到多模态、图像到多模态和多模态到多模态的映射,我们提出了另外9个创新的跨模态和跨对检索任务,称为 Omni-Retrieval预训练。预训练通过高效的方式进行,针对这14个任务只进行两次前向/反向更新。大量实验和分析表明每个任务的有效性。当我们将所有预训练任务结合时,经过微调后,模型在7个电商相关的下游任务中达到了最先进的性能。此外,我们还提出了一种新的模态随机化方法,能够在不同的效率约束下动态调整我们的模型。

引言

在Facebook,几乎所有与电商相关的帖子都是多模态的。例如,Marketplace帖子由一个或多个产品视图及其产品描述组成;Shop的产品列表由产品图像和详细的产品说明(如标题、属性、尺寸、材质等)构成;而网红们在Instagram上上传的时尚帖子则伴有文字说明和标签。自从Facebook Business发布Facebook/Instagram商店以来,我们的电商平台的使用量呈爆炸式增长。例如,用户每秒都在Marketplace上进行文本查询搜索,寻找特定的产品;用户在上传帖子时也会标记产品(如T恤、项链等);他们还会触发视觉搜索,寻找平台上其他图像中出现的相似产品等。大规模的电商相关数据和各种使用场景促使我们构建了一个专门针对电商的多模态表示方式来处理这些帖子。

最近,视觉与语言表示学习成为了越来越受欢迎的研究主题。这一趋势也促使人们开始研究电商特定的预训练 [8, 11, 50, 51]。在这些研究中,作者在电商图像-文本对上预训练了基于transformer的模型 [37],然后在图像-文本检索、图像标注、类别识别等任务上进行了微调。然而,大多数现有的研究是在中等规模的图像-文本对上进行训练,并在有限的学术任务上进行评估。这引发了一个问题:Facebook能否为各种实际的电商相关应用学习到一个更通用的多模态表示?

本着这一理念,我们介绍了 Commerce MultiModal Representation (CommerceMM),这是一个用于联合多模态电商嵌入的大规模预训练模型,专为Facebook设计。我们将预训练数据的规模从不到100万个扩展到数亿个数据。我们的模型由一个图像编码器、一个文本编码器(基于transformer)和一个多模态融合编码器(基于transformer)组成,如图2所示。随后,我们为该模型提出了两组预训练任务,并在广泛的7个电商相关任务上进行了评估。

第一组预训练任务由5个有效的任务组成,这些任务基于图像-文本对,包括:掩码语言建模(MLM)、掩码图像建模KL散度(MIM-kl)、掩码图像建模特征回归(MIM-fr)、图像-文本对比学习(ITC)和图像-文本匹配(ITM)。尽管之前的研究 [10, 16] 表明MIM对多模态预训练没有帮助,通常掩码语言建模(MLM)是最有效的任务 [5, 19],但我们提出的MIM任务是必不可少的。关键的不同在于:(𝑖)我们使用50%的较大掩码比例,而不是[5, 25, 36]中使用的15%;(𝑖𝑖)我们仅在图像的[CLS] token上恢复信号,而不是重建每个被掩码的图像块;(𝑖𝑖𝑖)监督信号来自于完整原始图像的另外两个视角(ClusterFit [43] 和 GrokNet [4])。

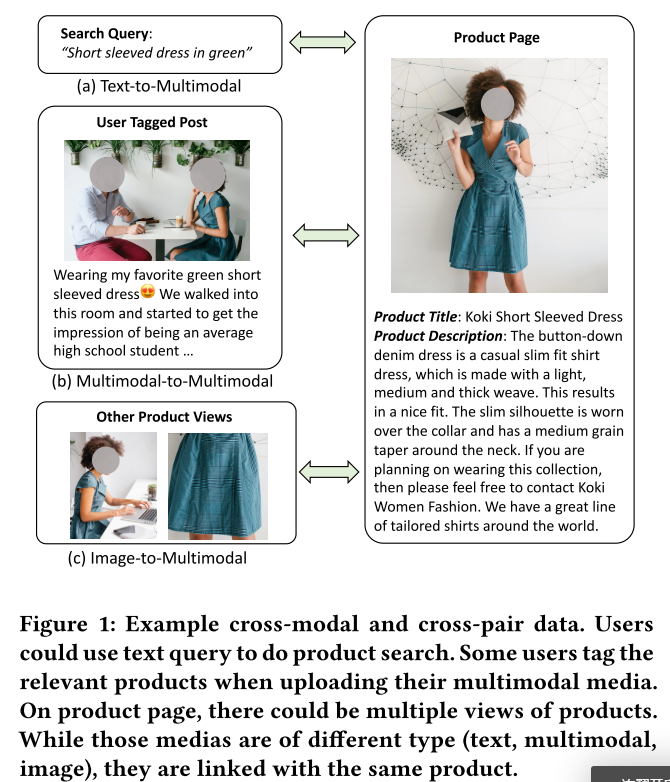

据我们所知,所有现有的多模态预训练方法都将图像-文本对作为默认的输入进行表示学习。然而,在实际应用中,尤其是在电商领域,我们可以访问到更多种类的数据格式,例如多个图像、文本以及其他有价值的数据,如查询和点击,这些数据都围绕同一产品。例如,在图1(a)中,我们展示了用户可以执行查询搜索来找到相关的产品。用户点击某个产品时,生成了查询文本与多模态产品页面之间的文本到多模态映射。图1(b)展示了用户在上传包含照片和文字说明的多模态媒体时标记产品的示例,这构建了一个多模态到多模态的映射。图1©展示了一个产品页面,其中包含同一产品的多个视角,每个视角都可以作为源图像来搜索关联产品,从而形成图像到多模态的映射。我们称这些数据为跨模态和跨对数据。显然,像ITC和ITM这样的常见图像-文本预训练任务已不再适用,因为它们的输入固定为图像-文本对,只能处理图像与文本之间的关系。这促使我们提出了第二组预训练任务——Omni-Retrieval预训练。我们提议构建图像、文本和多模态之间的任意模态类型之间的关系。具体而言,我们将跨对数据封装成(源图像、源文本、目标图像、目标文本)的形式。我们为源和目标分别预测三个嵌入:视觉嵌入、文本嵌入和多模态嵌入。全面匹配产生9种类型的对关系,每个关系可以通过对比学习来学习,总共模仿9个检索任务。通过这9个Omni-Retrieval任务,我们的预训练模型能够学习到更具区分性和更具泛化性的表示,用于任何对齐空间。

以下是你提供的段落的中文翻译:

图文匹配(ITM)

在图文匹配(ITM)中,输入是一个配对的句子和图像,输出是一个二元标签

y

∈

{

0

,

1

}

y \in \{0, 1\}

y∈{0,1},表示每个输入对是否匹配。我们提取多模态融合的最后一层

w

c

l

s

wcls

wcls 的隐藏输出,来表示两种模态的融合表示,然后将其输入到一个全连接(FC)层,并通过一个 sigmoid 函数预测一个介于 0 和 1 之间的单一得分。我们将输出得分记作

o

θ

(

w

,

v

)

o_{\theta}(w, v)

oθ(w,v)。在预训练过程中,我们在每一步从数据集

D

D

D 中采样一个正样本或负样本对

(

w

,

v

)

(w, v)

(w,v)。负样本对通过将配对样本中的图像或文本替换为从其他样本中随机选择的内容来生成。根据 [19] 的方法,当应用 ITC 时,我们可以从 ITC 计算的相似度矩阵

s

(

w

i

,

v

j

)

s(w_i, v_j)

s(wi,vj) 中采样困难负样本对。引入这些困难负样本使得 ITM 成为一个更具挑战性的任务,这对于预训练更为有益 [27]。我们使用二元交叉熵作为损失函数:

L

I

T

M

(

θ

)

=

−

E

(

w

,

v

)

∼

D

[

y

log

o

θ

(

w

,

v

)

+

(

1

−

y

)

log

(

1

−

o

θ

(

w

,

v

)

)

]

L_{ITM}(\theta) = - \mathbb{E}_{(w, v) \sim D} \left[ y \log o_{\theta}(w, v) + (1 - y) \log (1 - o_{\theta}(w, v)) \right]

LITM(θ)=−E(w,v)∼D[ylogoθ(w,v)+(1−y)log(1−oθ(w,v))]

这段文本详细描述了图文匹配任务中的模型架构和损失函数的计算方式,包括如何通过多模态融合生成表示、采样负样本对以及如何通过二元交叉熵来优化模型。

4.2 下游任务

通过对 CommerceMM 进行最小的修改,我们的模型可以适应预训练过程中未见过的新任务。我们引入了7个与电商相关的下游任务。每个下游微调任务都有自己的数据集和标注。

目录分类(CC)

我们为250万个多模态目录帖子标注了细粒度的类别标签。标签基于购物类别进行树形结构组织,例如:“家居/家居装饰/装饰性配件/海报、印刷品和画作”。总共有5,168个叶子标签。我们专注于对每个帖子进行叶子标签的分类。图1中的产品页面展示了一个目录帖子的示例,其中包含图像、标题和描述。我们将标题和描述拼接成完整的句子。每个帖子的平均词数为99.6个。我们在多模态融合编码器的[CLS]层上添加了一个5,168分类器,并在微调时应用交叉熵损失。总体准确率作为评估指标。

Marketplace 分类(MPC)

与目录分类类似,我们也为200万个Marketplace帖子标注了细粒度的类别标签。共为收集到的Marketplace帖子标注了1,387个叶子标签。每个帖子由一张图片、一个标题和一个描述组成。我们按照相同的流程将标题和描述拼接在一起。每个文本平均包含37.3个词。我们在多模态融合编码器的[CLS]标记上添加了一个1,387分类器,用于微调和推理。总体准确率作为评估指标。

图像-文本检索

我们收集了100万个目录帖子,用于文本到图像检索(T2I)和图像到文本检索(I2T)任务。我们将其中的10K子集用于评估,剩余的用于模型训练。进行图像-文本检索有两种方式。一种是使用ITM头预测输入图像-文本对之间的匹配得分,并对所有对的得分进行排序 [5, 11, 51]。另一种是计算图像编码器和文本编码器之间的相似度,并选出最佳匹配,而不进行更深层次的模态融合,如 [15, 19, 30] 所述。尽管第一种方法可能会取得更好的性能 [27],但其计算成本巨大(相对于检索池的大小,计算量呈二次增长),在实践中不可行。因此,我们采用第二种方法,简单地使用 CommerceMM 的图像和文本编码器来进行检索任务。我们在微调过程中应用了对比学习损失。使用 Recall@1 来衡量检索性能。

889

889

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?