论文标题:Network-Enhanced On-Device AI: a Recipe for Interoperable and Cooperative AI Applications 中文标题:网络增强型在设备人工智能:打造可互操作和协作的人工智能应用的配方

作者信息:

- Paulius Daubaris,赫尔辛基大学,芬兰赫尔辛基,paulius.daubaris@helsinki.fi

- Sasu Tarkoma,赫尔辛基大学,芬兰赫尔辛基,sasu.tarkoma@helsinki.fi

- Roberto Morabito,EURECOM,法国比奥特,roberto.morabito@eurecom.fr

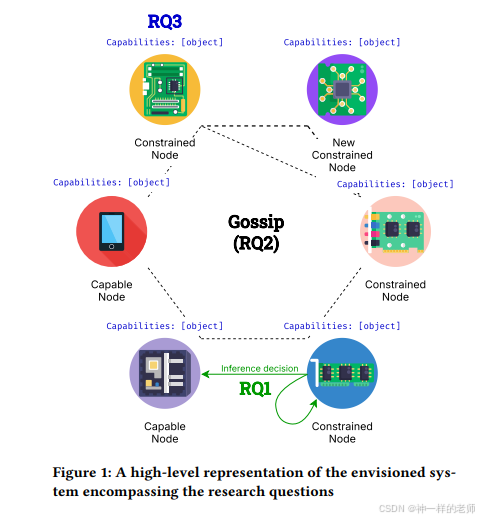

摘要: TinyML技术使得在资源受限的设备上执行机器学习模型成为可能,这在隐私保护和能源消耗方面带来了好处。然而,当前的研究通常将TinyML限制在单一设备、单一任务的场景中,阻碍了协作边缘计算的潜力。本文认为,TinyML设备之间直接协作的系统尚未被充分探索,这为协作边缘计算提供了重要的创新机会。本博士研究调查了由高度受限设备(例如,<1000 KB RAM,<2000 KB闪存存储)组成的协作TinyML系统,目标包括:开发智能计算卸载方法、创建轻量级网络系统以实现节点通信,以及研究增强互操作性的协议。

研究概述: TinyML作为边缘计算的一个新范式,使得在资源受限的设备上缩小并执行机器学习模型成为可能。这为数据处理和边缘感知提供了新的可能性。尽管TinyML在隐私和能源消耗方面具有优势,但通常被视为单一设备、单一任务的范式。这种设置阻碍了TinyML设备与异构边缘节点的协作,限制了边缘计算的潜力。相关工作通常遵循三种主要模式:1)边缘设备通常属于通用设备组,这些设备足够强大,可以在软件支持下执行ML模型;2)考虑的边缘设备属于微控制器设备组,仅在设备上执行推理,不考虑利用附近边缘节点的知识和能力;3)不同的设备组节点用于联合学习任务。这些常见方法没有弥合两个设备组之间的差距,限制了边缘环境的有效利用。本研究旨在调查由实际受限节点组成的边缘系统,这些系统可以互操作、共享本地知识,并在边缘环境的范围内利用附近的节点。

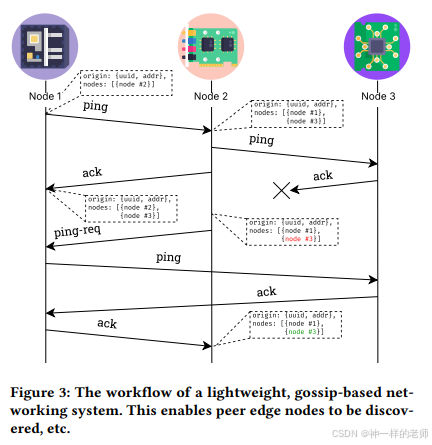

研究方法和方法论: 研究的初始阶段是调查受限设备智能卸载计算的潜力,使用分层推理(HI)和早期退出(EE)模型的组合。这种方法使得TinyML设备在服务质量(QoS)指标未被设备上的推理满足时,能够将任务转移到更有能力的节点,从而提高系统的准确性、效率和可持续性。为了深入了解这种方法的效果,我们对在设备上、HI、EE、EEHI模型在准确性、延迟和能源消耗方面进行了基准测试和比较。此外,我们探索了构建轻量级、基于八卦的网络系统的可能性,该系统将使节点能够通信、传播本地知识,从而发现对等节点、验证成员资格,并使用众所周知和建立的算法传输计算任务。最后,我们将研究轻量级应用层协议,并扩展它们以标准化方式表示设备能力,以增强互操作性。

初步结果: 初步结果显示,在某些情况下,提前退出神经网络并卸载计算是有利的。这种策略与仅在设备上执行推理或将数据卸载到更有能力的设备进行远程推理相比,可以节省能源并减少延迟。我们对5种不同的受限设备进行了实验,以图像分类任务为例,利用CIFAR-10和ImageNet数据集的模型。实验结果表明,EE-HI方法可以实现比HI更好的性能,将延迟和能源消耗降低高达60%。

挑战和反馈需求: 在博士研究层面进行研究时遇到的一些技术和非技术挑战包括:实施工作可能非常具有挑战性和耗时;新想法的涌现可能会分散注意力;时间管理和如何接近优先级相似的任务。讨论这些问题将有助于研究的进一步发展。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?