一、前言

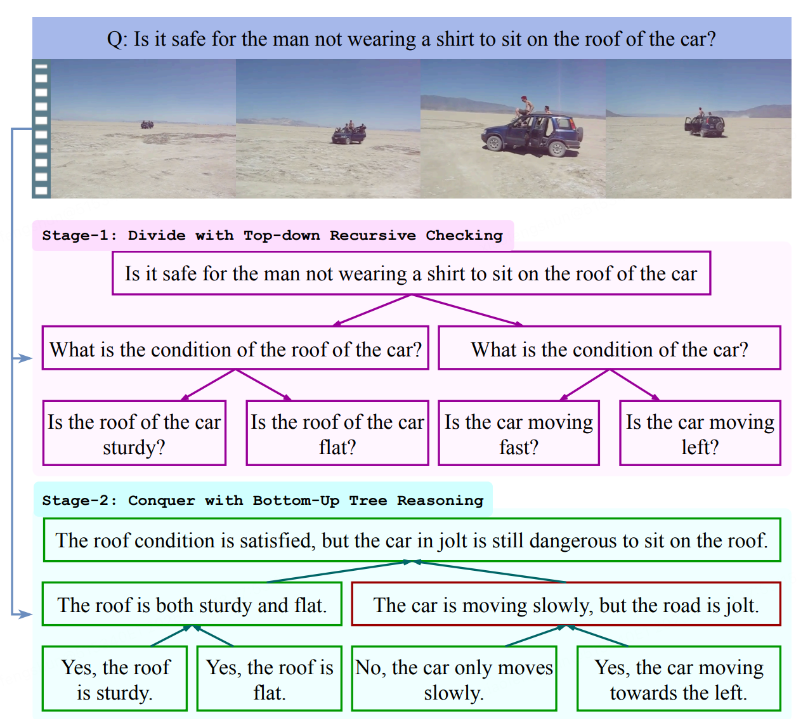

由于现有的多模态大语言模型(MLLM)在推理过程中存在无法控制和不透明的问题,视频问答(VideoQA)在实现高级认知推理方面仍然具有挑战性。为了解决这一问题,哔哩哔哩Index团队联合上海交通大学提出了一种新颖的以语言为中心的树状推理(LTR)框架,旨在增强模型的推理能力,该论文已经被 ICML2025 收录,是继 ICLR2025 的工作(ICLR25 重新思考长尾识别中的分类器再训练:标签过平滑可以实现平衡)之后Index团队在AI三大顶会(ICLR/ICML/NeurIPS)的第二项收录。该框架通过递归地将原始问题划分为逻辑上可处理的子问题,并逐步解决这些子问题,从而提升现有MLLM的推理能力和可解释性。首先,在第一阶段,LTR递归地生成一个以语言为中心的逻辑树,逐步将复杂的认知问题分解为简单的感知性问题,并通过基于检索增强生成(RAG)的少样本方法规划推理路径。接着,在第二阶段,在视频内容的辅助下,LTR在该逻辑树中自下而上地进行逻辑推理,以推导出最终答案,并附带可追溯的推理路径。针对11个VideoQA基准数据集进行的实验表明,与最先进的MLLM相比,我们的LTR框架在准确性和可解释性方面都有显著提升。据我们所知,这是首个在VideoQA中引入以语言为中心的逻辑树来指导MLLM推理的工作,为从感知到认知的以语言为中心的视频理解开辟了新路径。

二、动机

视频问答(VideoQA)已成为一个重要的研究领域,并在多模态理解、交互式人工智能和认知科学中具有广泛应用。其核心挑战在于如何推动以语言为中心的视频理解,从感知层面迈向认知层面。具体而言,低层次的感知涉及对视频的时空特征进行理解,例如识别对象、动作和场景;而高层次的认知则要求系统理解视频内容及提问背后的逻辑结构,能够沿着逻辑链条进行推理并给出准确答案。为应对这些挑战,近期研究通过将大型语言模型(LLM)扩展为多模态版本(MLLM),例如 Video-LLaMA [1,2]和 Video-LLaVA [3],将视觉信息与文本信息相结合。然而,尽管这些模型在回答问题时可以提供一定的解释,但如何实现 System-2 推理尚未得到充分探索。其主要局限在于,这类模型的推理过程往往难以控制且透明度不足。这种不透明性使得分析其推理步骤变得困难,从而降低了结果的可信度。例如,在处理涉及多个时序视觉线索的复杂问题时,模型可能会给出错误答案,却无法展示导致该结论的推理路径。因此,用户无法追溯到推理出错的环节,也就无法信任这些结果。

图1 人类使用System-2思考进行复杂视频问答的过程

一些先前的工作也探索了解释性的视频问答方法,例如 VoT [4] 和 DSTN [5]。V

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1254

1254

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?