在大数据时代,Python 成为了数据科学家和工程师们处理大规模数据集的首选语言之一。Python 不仅有强大的库支持,还有丰富的开源工具可以帮助你高效地处理大数据。今天,我们就来聊聊 6 个常用的 Python 大数据处理工具,并通过实际的代码示例来展示它们的强大功能。

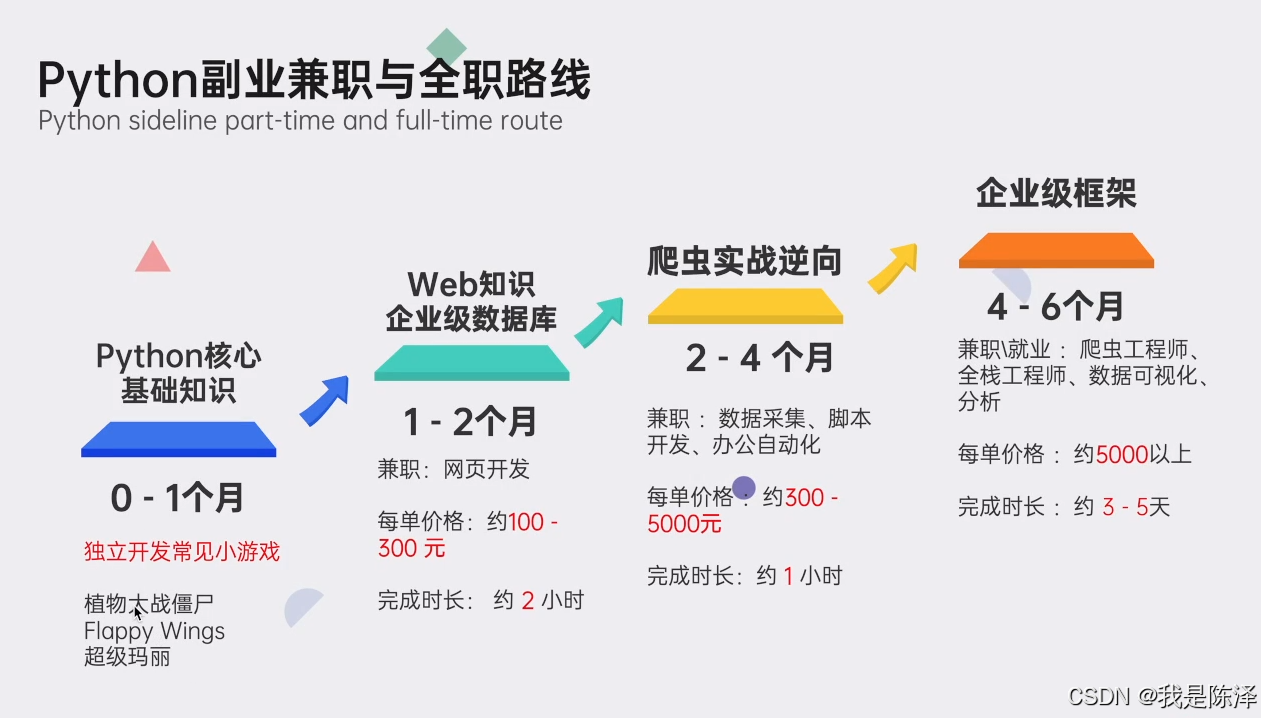

这里插播一条粉丝福利,如果你正在学习Python或者有计划学习Python,想要突破自我,对未来十分迷茫的,可以点击这里获取最新的Python学习资料和学习路线规划(免费分享,记得关注)

1. Pandas

Pandas 是一个强大的数据处理和分析库,特别适合处理结构化数据。虽然它主要用于中等规模的数据集,但通过一些优化技巧,也可以处理较大的数据集。

示例:读取和处理 CSV 文件

import pandas as pd

# 读取 CSV 文件

df = pd.read_csv('large_dataset.csv')

# 查看前 5 行数据

print(df.head())

# 计算某一列的平均值

mean_value = df['column_name'].mean()

print(f"Mean value: {mean_value}")

# 过滤数据

filtered_df = df[df['column_name'] > 100]

print(filtered_df.head())

2. Dask

Dask 是一个并行计算库,可以扩展 Pandas 的功能,处理大规模数据集。Dask 可以在单机或多机上运行,非常适合处理超过内存限制的数据集。

示例:使用 Dask 处理大型 CSV 文件

import dask.dataframe as dd

# 读取 CSV 文件

ddf = dd.read_csv('large_dataset.csv')

# 计算某一列的平均值

mean_value = ddf['column_name'].mean().compute()

print(f"Mean value: {mean_value}")

# 过滤数据

filtered_ddf = ddf[ddf['column_name'] > 100]

print(filtered_ddf.head().compute())

3. PySpark

PySpark 是 Apache Spark 的 Python API,可以用于分布式数据处理。PySpark 支持大规模数据集的处理,并且提供了丰富的数据处理和机器学习库。

示例:使用 PySpark 处理数据

from pyspark.sql import SparkSession

# 创建 SparkSession

spark = SparkSession.builder.appName("BigDataExample").getOrCreate()

# 读取 CSV 文件

df = spark.read.csv('large_dataset.csv', header=True, inferSchema=True)

# 计算某一列的平均值

mean_value = df.selectExpr("avg(column_name)").collect()[0][0]

print(f"Mean value: {mean_value}")

# 过滤数据

filtered_df = df.filter(df['column_name'] > 100)

filtered_df.show()

4. Vaex

Vaex 是一个用于处理大规模数据集的库,特别适合处理数十亿行的数据。Vaex 使用延迟计算和内存映射技术,可以在不消耗大量内存的情况下处理大数据。

示例:使用 Vaex 处理数据

import vaex

# 读取 CSV 文件

df = vaex.from_csv('large_dataset.csv', convert=True, chunk_size=5_000_000)

# 计算某一列的平均值

mean_value = df['column_name'].mean()

print(f"Mean value: {mean_value}")

# 过滤数据

filtered_df = df[df['column_name'] > 100]

print(filtered_df.head())

5. Modin

Modin 是一个用于加速 Pandas 操作的库,它通过并行计算来提高性能。Modin 可以无缝替换 Pandas,让你在不改变代码的情况下提升数据处理速度。

示例:使用 Modin 处理数据

import modin.pandas as pd

# 读取 CSV 文件

df = pd.read_csv('large_dataset.csv')

# 计算某一列的平均值

mean_value = df['column_name'].mean()

print(f"Mean value: {mean_value}")

# 过滤数据

filtered_df = df[df['column_name'] > 100]

print(filtered_df.head())

6. Ray

Ray 是一个用于构建分布式应用程序的框架,可以用于处理大规模数据集。Ray 提供了丰富的 API 和库,支持并行和分布式计算。

示例:使用 Ray 处理数据

import ray

import pandas as pd

# 初始化 Ray

ray.init()

# 定义一个远程函数

@ray.remote

def process_data(df):

mean_value = df['column_name'].mean()

return mean_value

# 读取 CSV 文件

df = pd.read_csv('large_dataset.csv')

# 分割数据

dfs = [df[i:i+10000] for i in range(0, len(df), 10000)]

# 并行处理数据

results = ray.get([process_data.remote(d) for d in dfs])

# 计算总体平均值

mean_value = sum(results) / len(results)

print(f"Mean value: {mean_value}")

实战案例:处理百万行日志文件

假设你有一个包含百万行的日志文件,每行记录了一个用户的访问信息。你需要计算每个用户的访问次数,并找出访问次数最多的用户。

日志文件格式:

user_id,timestamp,page

1,2023-01-01 12:00:00,home

2,2023-01-01 12:01:00,about

1,2023-01-01 12:02:00,contact

...

使用 Dask 处理日志文件

import dask.dataframe as dd

# 读取日志文件

log_df = dd.read_csv('log_file.csv')

# 按 user_id 分组,计算访问次数

visit_counts = log_df.groupby('user_id').size().compute()

# 找出访问次数最多的用户

most_visited_user = visit_counts.idxmax()

most_visited_count = visit_counts.max()

print(f"Most visited user: {most_visited_user} with {most_visited_count} visits")最后,我精心筹备了一份全面的Python学习大礼包,完全免费分享给每一位渴望成长、希望突破自我现状却略感迷茫的朋友。无论您是编程新手还是希望深化技能的开发者,都欢迎加入我们的学习之旅,共同交流进步!

🌟 学习大礼包包含内容:

Python全领域学习路线图:一目了然,指引您从基础到进阶,再到专业领域的每一步学习路径,明确各方向的核心知识点。

超百节Python精品视频课程:涵盖Python编程的必备基础知识、高效爬虫技术、以及深入的数据分析技能,让您技能全面升级。

实战案例集锦:精选超过100个实战项目案例,从理论到实践,让您在解决实际问题的过程中,深化理解,提升编程能力。

华为独家Python漫画教程:创新学习方式,以轻松幽默的漫画形式,让您随时随地,利用碎片时间也能高效学习Python。

互联网企业Python面试真题集:精选历年知名互联网企业面试真题,助您提前备战,面试准备更充分,职场晋升更顺利。

👉 立即领取方式:只需【点击这里】,即刻解锁您的Python学习新篇章!让我们携手并进,在编程的海洋里探索无限可能

6个Python大数据处理工具及实战案例

6个Python大数据处理工具及实战案例

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?